Nutanix Cloud バイブル

Copyright (c) 2025: The Nutanix Cloud Bible and NutanixBible.com, 2025. 本サイトの著者または所有者から書面による許可を受けることなしに、本著作物を無断で使用すること、またはコピーすることを固く禁じます。 本著作物を引用、または本著作物に対するリンクを設定することは許可されますが、 NutanixおよびNutanixBible.comの著作であることを明記し、かつ原著の内容を適切かつ明確に示すよう、該当箇所を提示することを前提とします。

日本語版に関して、誤植や不自然な翻訳など、お気づきの点がございましたら こちらのフォームよりお知らせください。

- 他言語版はこちらからご覧ください。

- For other languages, click the flag icon.

- 다른 언어는 국기 아이콘을 클릭하십시오.

- Для других языков щелкните значок флага.

- 对于其他语言,请单击标记图标。

翻訳版について: Nutanix Cloud バイブルの原著(英語版)は頻繁に更新されるため、日本語版を含む各言語の翻訳版では最新の更新を反映しているとは限りません。 あらかじめご了承ください。 また、同じ理由によりPDFバージョンを提供していません。 ハードコピーを印刷したい場合には、「PDFに変換」などの手段をご利用ください。

The Basics: Compute, Storage and Networking

The Basics

一般的に「Webスケール」の説明に用いられる原則を、Nutanixはスタック全体で活用しています。このセクションでは、これらの基本と、核となるアーキテクチャーの概念について説明します。

Webスケール - ウェブスケール - 名詞 - コンピューターアーキテクチャー

インフラストラクチャーおよびコンピューティングのための

新しいアーキテクチャー

Nutanix は、ソフトウェアスタックを通して「Webスケール」の原則を活用しています。 Webスケールだからといって、GoogleやFacebook、Microsoftのような「超大規模なスケール」になる必要はないということを明言しておきます。 Webスケールな構成はどんな規模でも(3ノードでも、数千ノードでも)適用可能であり、その恩恵を受けることができます。

Webスケールなインフラストラクチャーについて説明するために、いくつか重要な要素があります:

- ハイパーコンバージェンス

- ソフトウェア デファインド インテリジェンス

- 自律分散システム

- インクリメンタルかつリニアな拡張性

その他の要素:

- APIベースの自動化と豊富な分析機能

- セキュリティをコアに据えている

- 自己修復機能

本書では、これらの基礎とアーキテクチャーコンセプト説明します。

Where We Started

Nutanixは、ある一つの目標に焦点を当てて考案されました:

あらゆる場所のインフラストラクチャーコンピューティングを、存在を意識しなくていいくらい簡単(インビジブル)にする。

このシンプルさは、次の3つのコア領域に焦点を当てることで達成されました。

- 選択とポータビリティを可能にする。 (HCI/Cloud/Hypervisor)

- コンバージェンス、抽象化、インテリジェント ソフトウェア(AOS)による「スタック」のシンプル化。

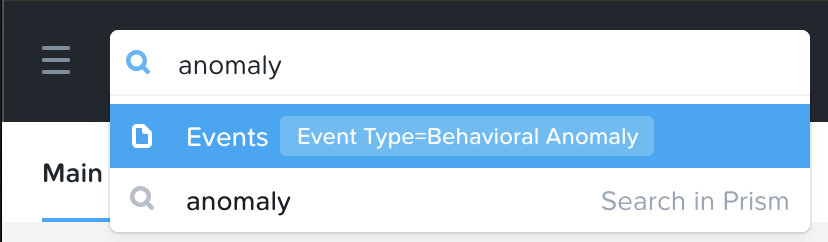

- ユーザーエクスペリエンス(UX)とデザイン(Prism)を重視した、直感的なユーザーインターフェイス(UI)の提供。

HCI/クラウド/ハイパーバイザー:「選択」

私達は、単一のハイパーバイザー(ESXi)をサポートする単一のハードウェア プラットフォーム(NX)からスタートしましたが、常に単一のハイパーバイザー/プラットフォーム/クラウド企業以上の存在であることを認識していました。 これが、vCenter でプラグインではなく独自の UI をゼロから構築したり、カーネル内のネイティブなものではなくVM として実行したり、といった選択をした理由の1つです(他にも多くの理由があります)。 なぜでしょうか? と聞かれるかもしれません。

1つのハイパーバイザー、プラットフォーム、またはクラウドがすべてのお客様のニーズに適合するわけではありません。 同じプラットフォームで複数のハイパーバイザーをサポートすることによって、お客様に選択と活用の自由を与えます。 また、それらの間で移動できるようにすることで、お客様に柔軟性を与えます。 すべてがNutanixプラットフォームの一部であるため、同じ操作体験が提供されます。

現在、12種類以上のハードウェアプラットフォーム(Direct/OEM/サードパーティ)、複数のハイパーバイザー(AHV、ESXi、Hyper-Vなど)をサポートし、主要なクラウドベンダーすべて(AWS、Azure、GCP)とのインテグレーションを拡充しています。 これによりお客様は自分にとって最適なものを選択でき、ベンダーとの交渉目的としても利用できます。

注:プラットフォームとは、このセクション全体、そして一般的に使われている一つのキーワードです。 私たちはワンオフの製品を作ろうとしているのではなく、プラットフォームを構築しているのです。

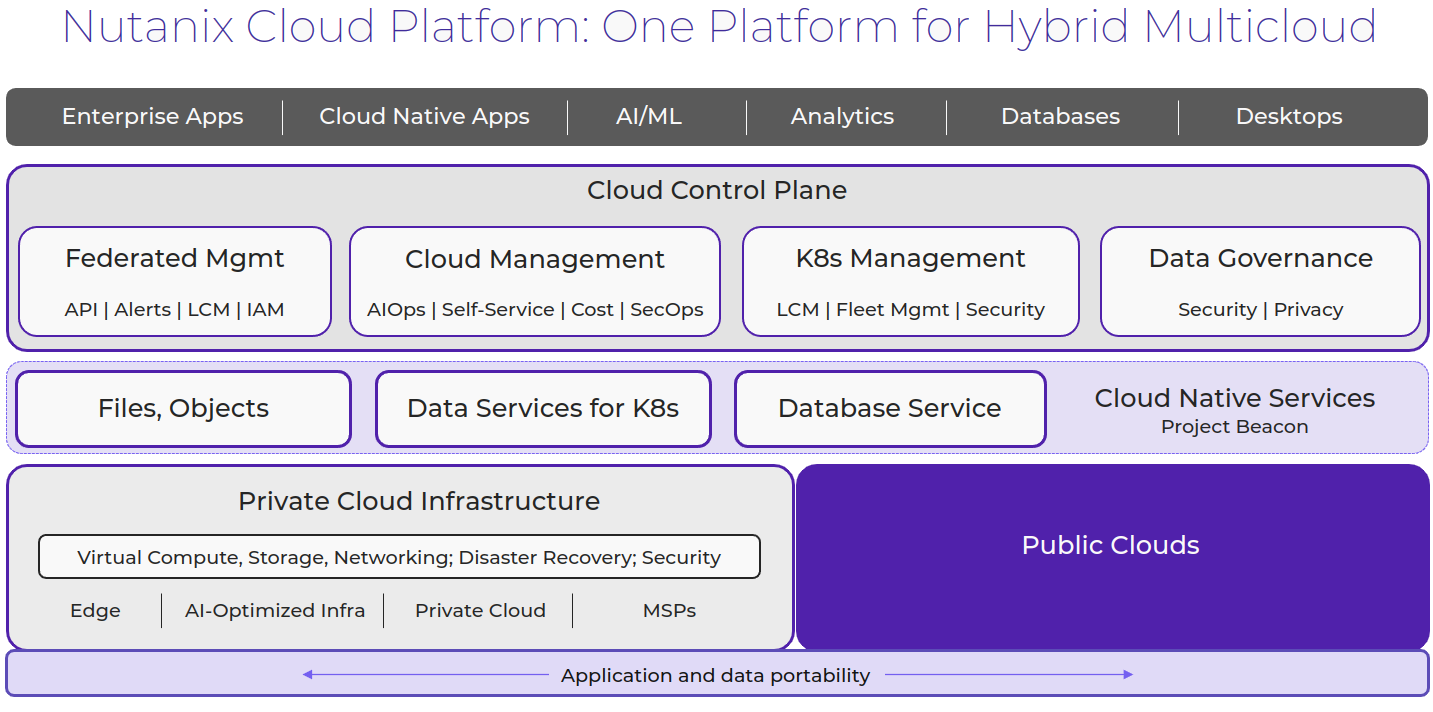

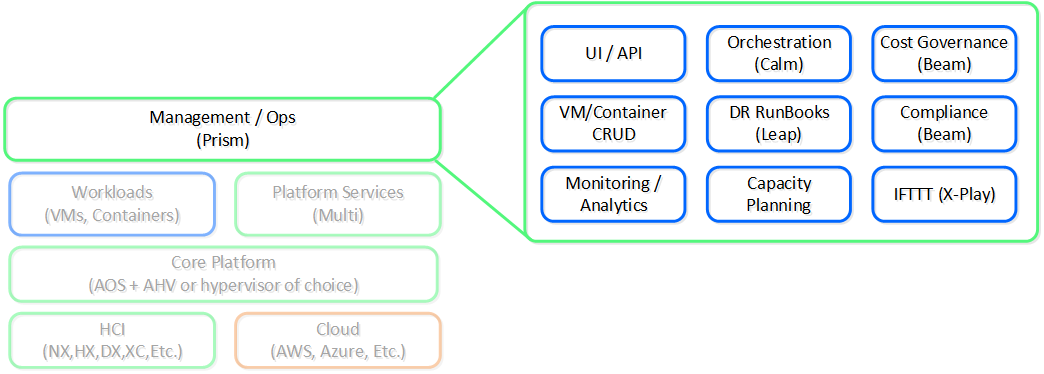

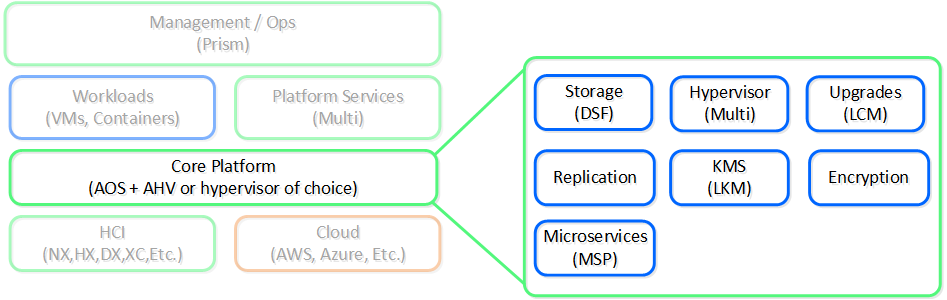

以下に、Nutanixプラットフォームのアーキテクチャー概要を示します。

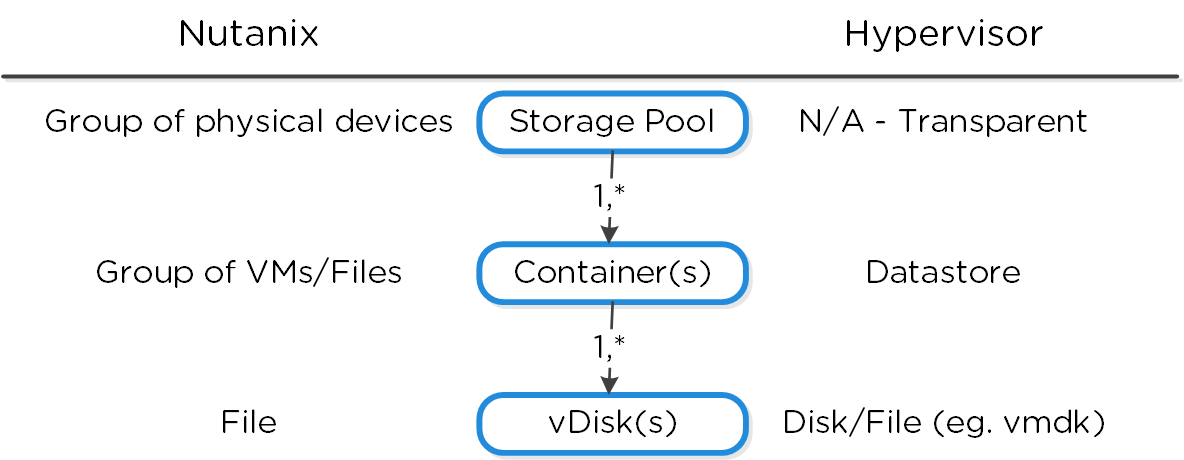

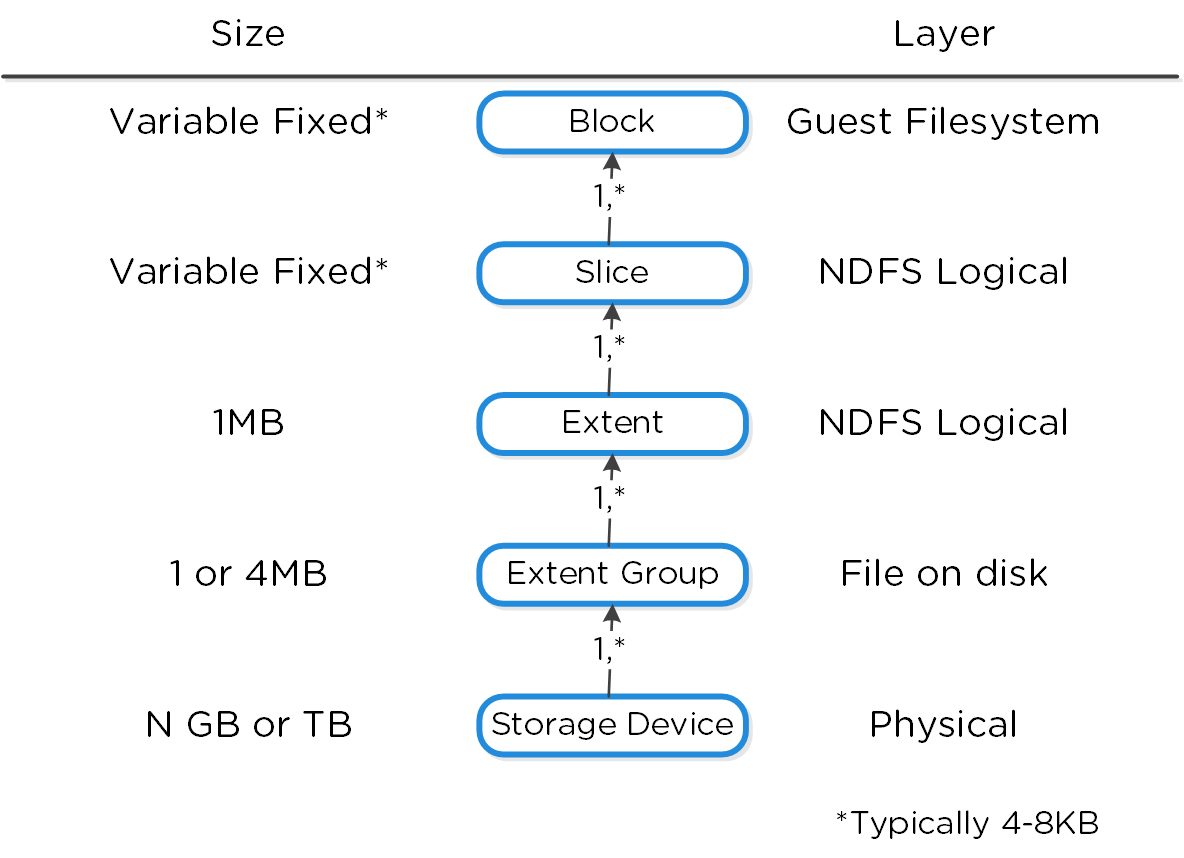

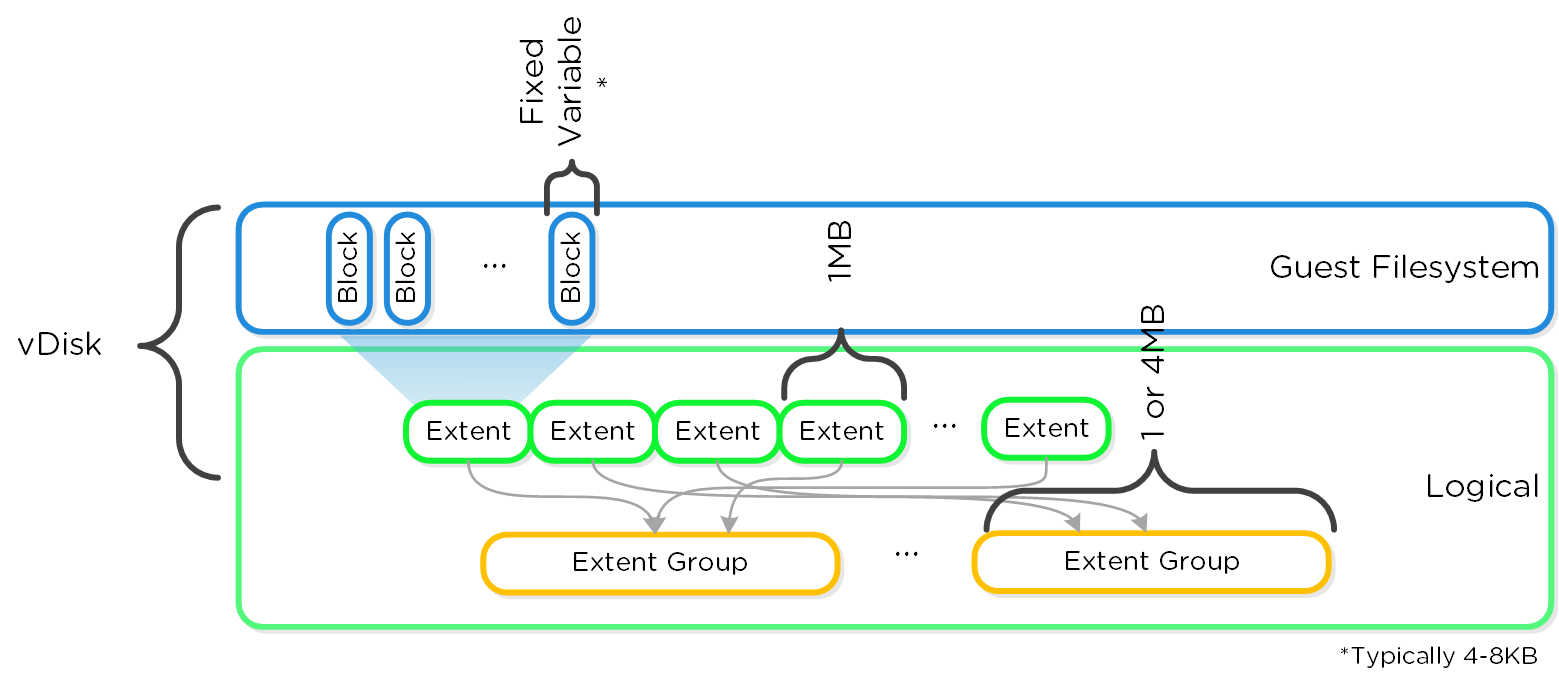

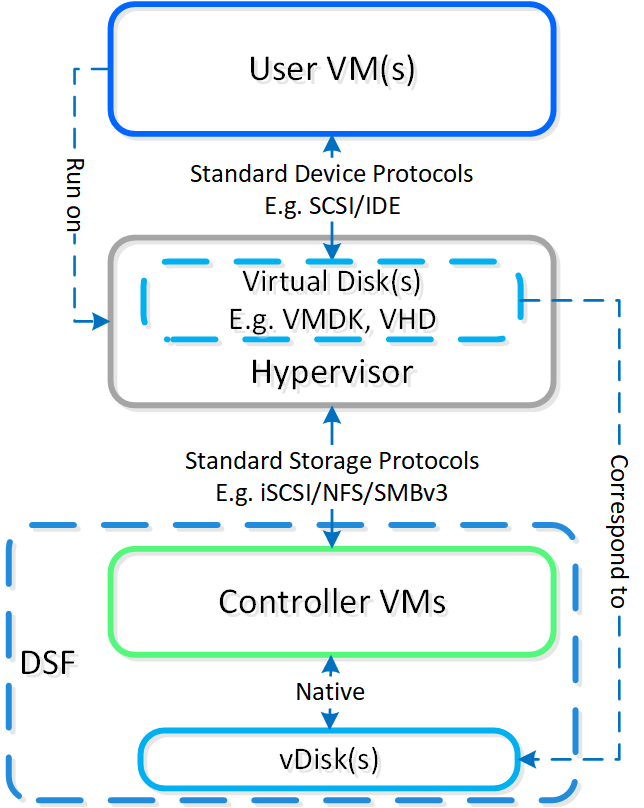

AOS + AHV/ハイパーバイザー:「ランタイム」

私たちは、分散ストレージ ファブリック(DSF。当時はNutanix Distributed Filesystem、別名NDFSとして知られていました)と呼ばれる機能でストレージをシンプル化することからこの旅をはじめて、 それは、ローカルストレージリソースとインテリジェントソフトウェアを組み合わせて「集中型ストレージ」のような機能を提供するものでした。

長年にわたり、私たちは多くの機能を追加してきました。 物事をシンプル化するために、これらは 2 つのコア領域に分割されています:

- コア サービス

- 基礎的なサービス群

- プラットフォーム サービス

- コア サービスをもとにしたサービス群であり、付加的な機能およびサービスを提供する

コア サービスは、ワークロード(VM/コンテナ)や他のよりハイレベルのNutanixサービスの実行を容易にする、基礎的なサービスとコンポーネントを提供します。 当初は単なるDSF製品でしたが、スタックのシンプル化と抽象化を支援するために、プラットフォームの機能を拡張し続けています。

以下に、AOSコア プラットフォームの概観を示します:

何年にもわたって、これは独自のハイパーバイザー(AHV)の導入による仮想化の抽象化(私達は、これは透過的なもので、システムの一部であるべきだと信じています)、アップグレードのシンプル化、セキュリティや暗号化のような他の重要なサービスの提供などにまで拡張してきました。

これらの機能により、私達は多くのインフラストラクチャーレベルの問題を解決しましたが、そこで止まりませんでした。 人々はまだ、ファイル共有、オブジェクトストレージ、コンテナのような追加サービスを必要としました。

いくつかのサービスについて、他ベンダーの製品を使用するようにお客様に要求するのではなく、どのサービスでパートナーと提携し、どのサービスを自社で構築するかを考えました。 バックアップについてはVeeamやHYCUなどのベンダーと提携し、ファイルやオブジェクトサービスのような他のサービスについてはプラットフォームサービスとして構築しました。

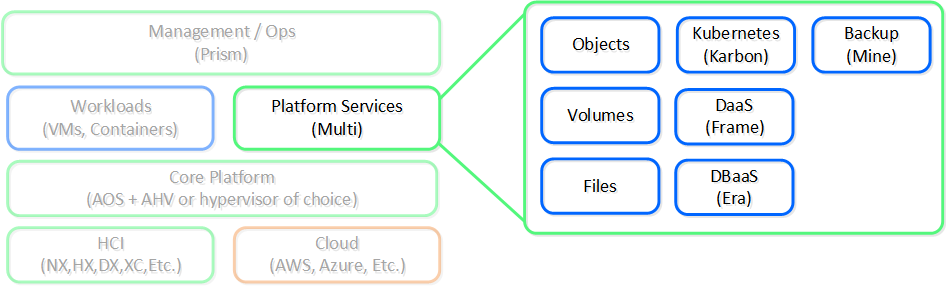

以下に、Nutanixプラットフォームサービスの概観を示します:

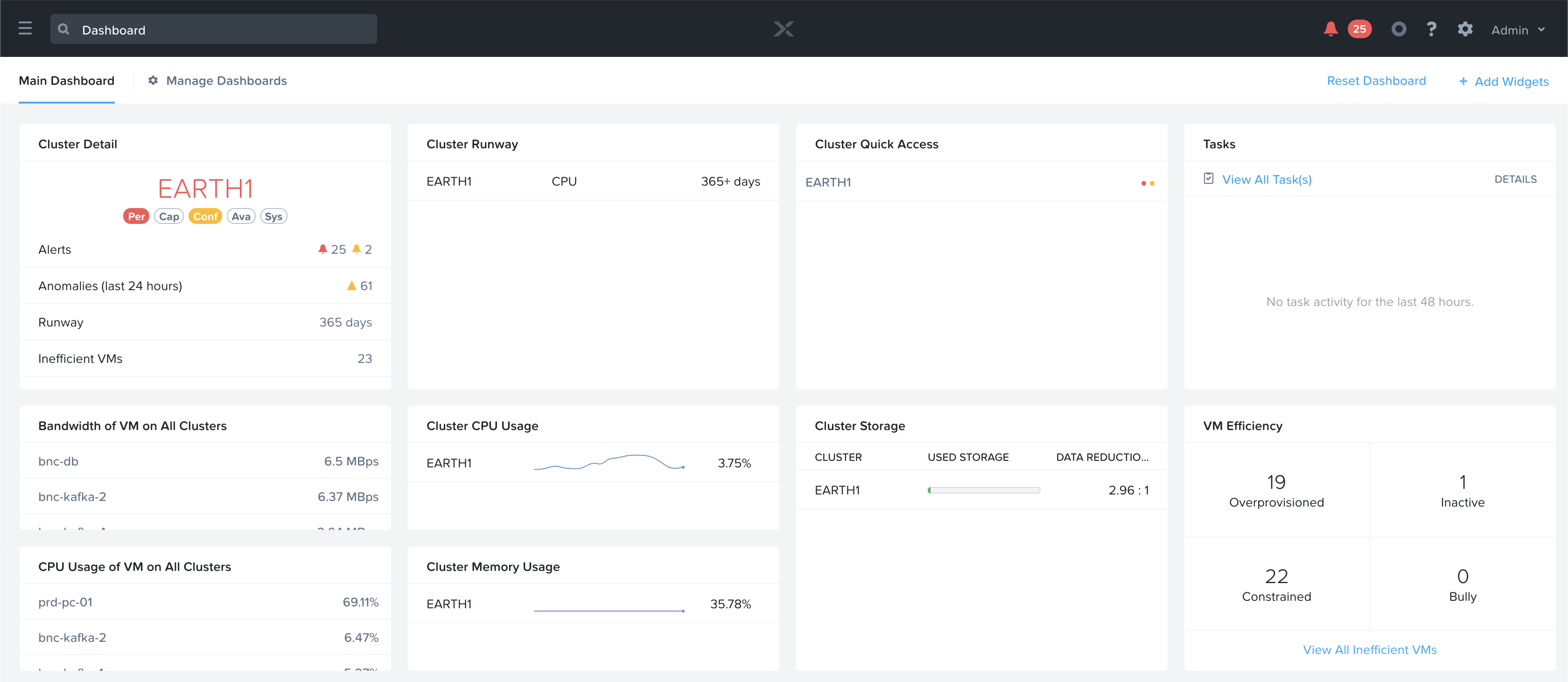

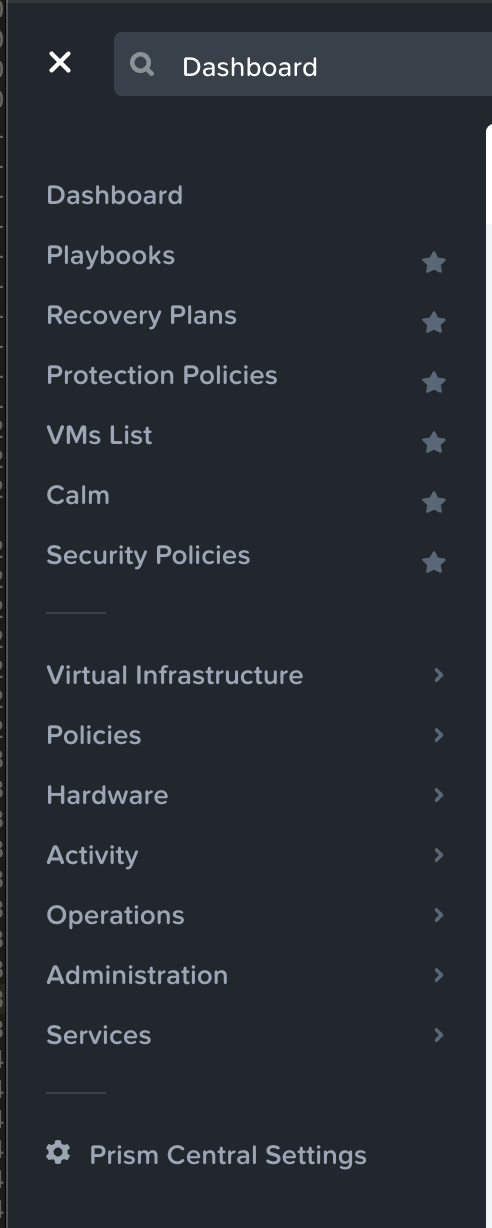

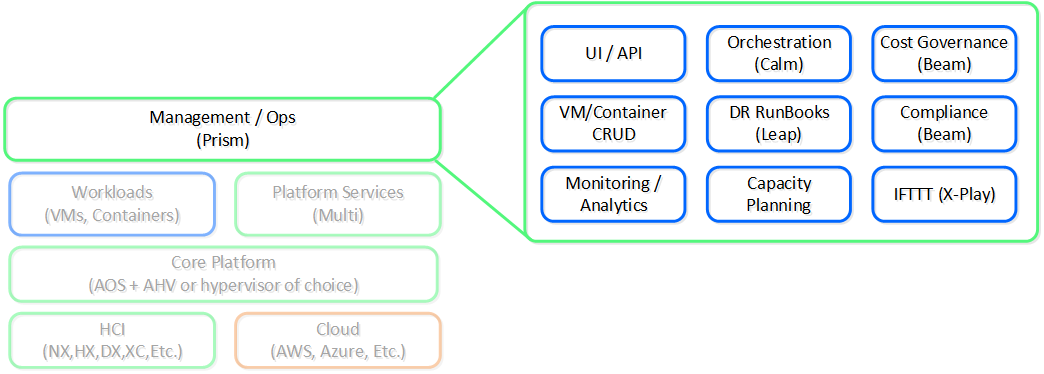

Prism:「インターフェイス」

端的にいうと、Appleのような企業が培ってきた、シンプルさ、一貫性、直観性にフォーカスを当てたデザイン原則を適用することです。 当初から、私達はNutanix製品の「フロントエンド」に多大な時間と労力を費やしてきました。 後回しにせず、UI/UXとデザインのチームは、常に限界に挑戦してきました。 例えば、私達は(SaaSプレイヤーを除けば)企業向けソフトウェア企業の中では、管理用UIをHTML5で作成した最初の企業の1つでした。

ここでのもう一つの核となる項目は、プラットフォームに単一のインターフェイスを提供し、その中で一貫した操作体験を維持することに重点を置いていることです。 私達の目標は、インフラストラクチャーを統合したようにUIを統合することです。 私達はPrismを、データセンターでの仮想化の管理、クラウドでのDesktop-as-a-Serviceの管理、または支出の可視性の提供など、 Nutanixプラットフォームの管理と利用ができる単一のインターフェイスとして提供したいと考えています。

これは、機能やサービスの創造と買収を通してプラットフォームを拡張し続ける上で重要なことです。 新しい機能をただ追加するのではなく、それらをプラットフォームにネイティブに統合するために時間を費やしたいと考えています。 その方が時間はかかりますが、長期的には一貫した操作体験を維持し、リスクを軽減することができます。

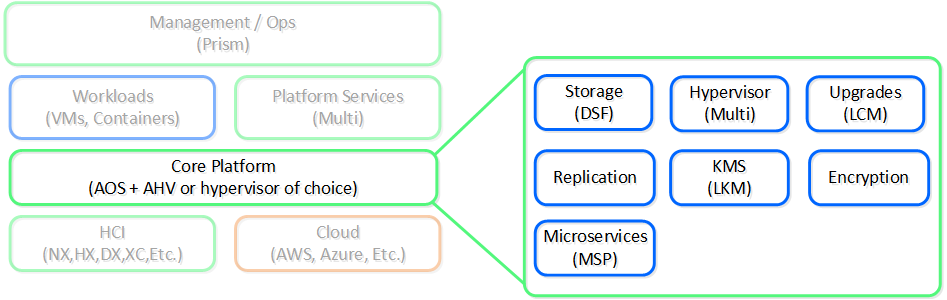

Nutanix:「プラットフォーム」

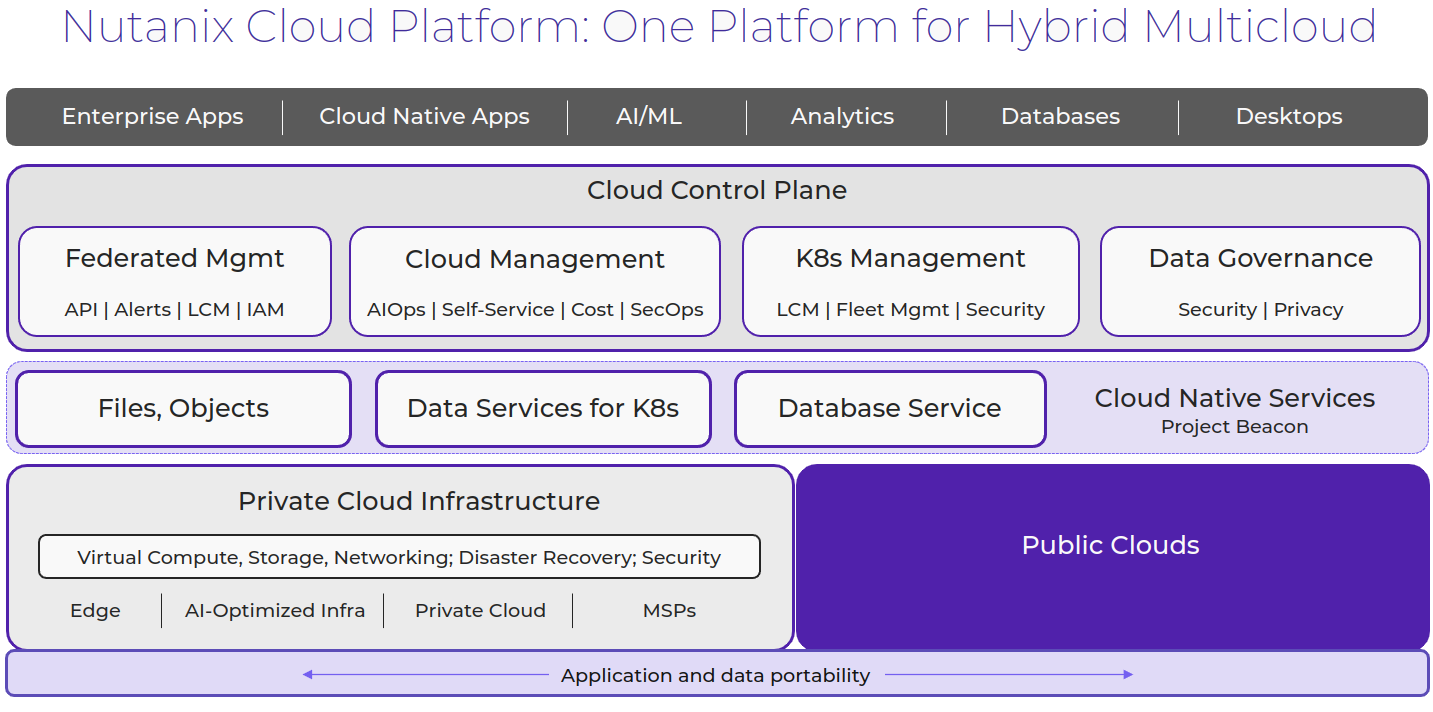

要約すると私達のビジョンはシンプルであり、「単一のプラットフォームでアプリとデータを場所を問わず実行可能に」です。

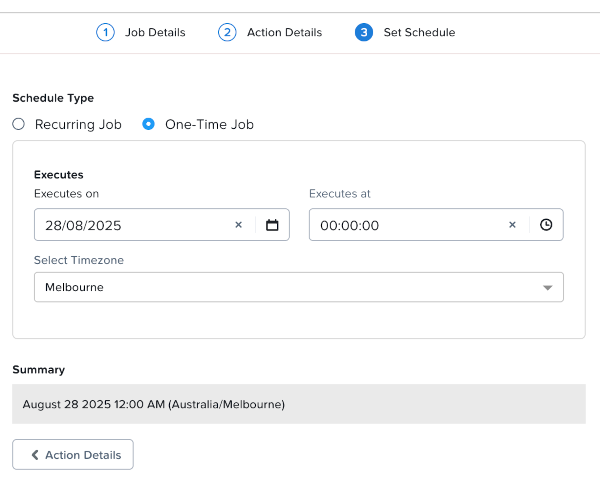

これは当初から私達の目標でした。 その証明として、以下にあるものが2014年頃に作成されたNutanixプラットフォーム アーキテクチャーについて説明するためのイメージ図です。 ご覧のように多くは変わっていませんが、私たちはただ拡大を続け、この目標に向かって努力を続けています。

製品とプラットフォーム

製品

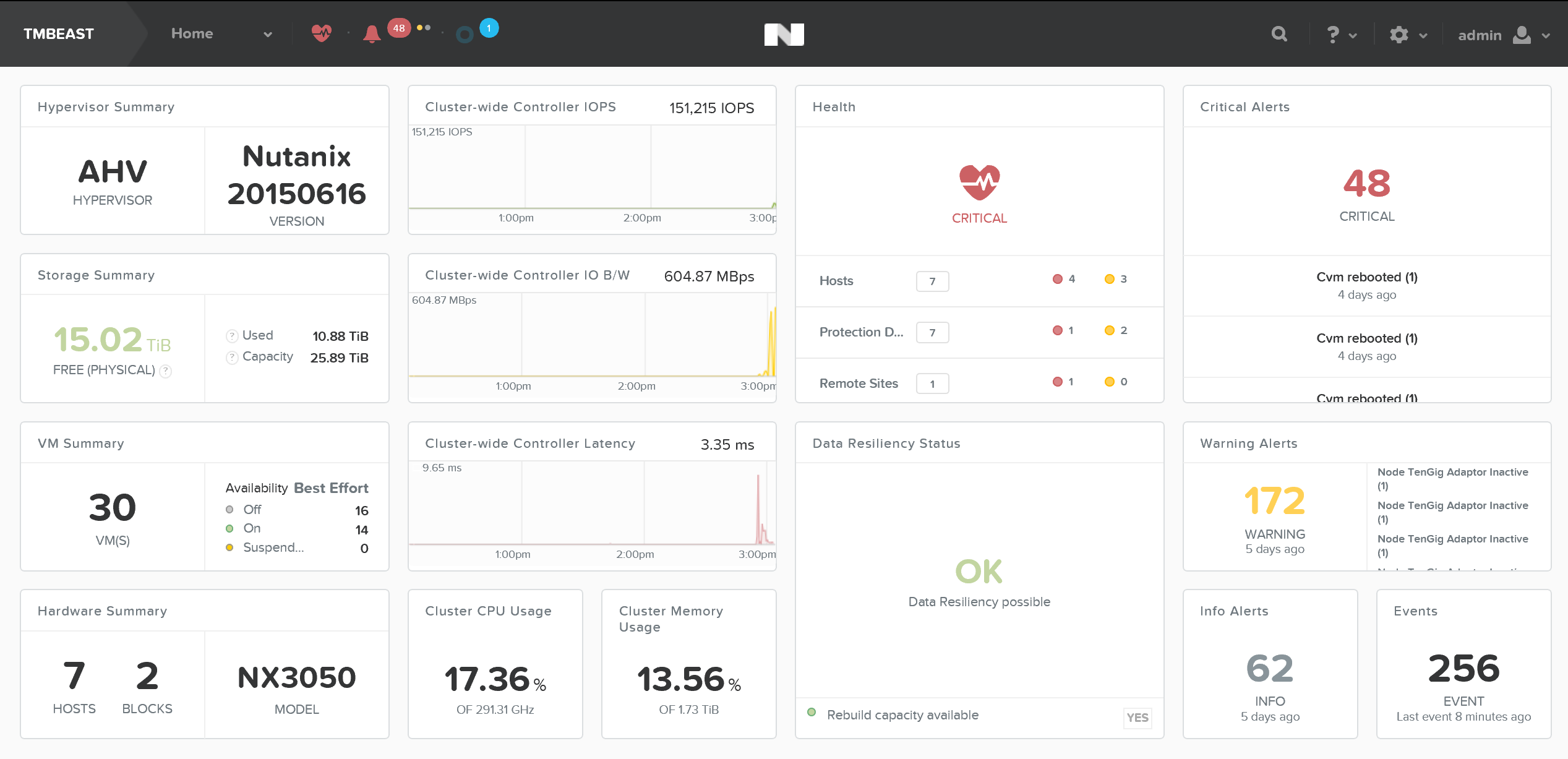

Nutanixは、ハイパーコンバージド インフラストラクチャー(HCI)の先駆者として、コンピューティング、ストレージ、ネットワーキングを単一の使いやすいデータセンター プラットフォームに統合することで従来のサイロを解消しました。 現在、クラウドがITインフラストラクチャーの重要な要素として登場し、Nutanixは再びサイロ(今度はオンプレミス、クラウド、エッジ間の)を打ち破り、ハイブリッド マルチクラウド プラットフォームを提供しています。

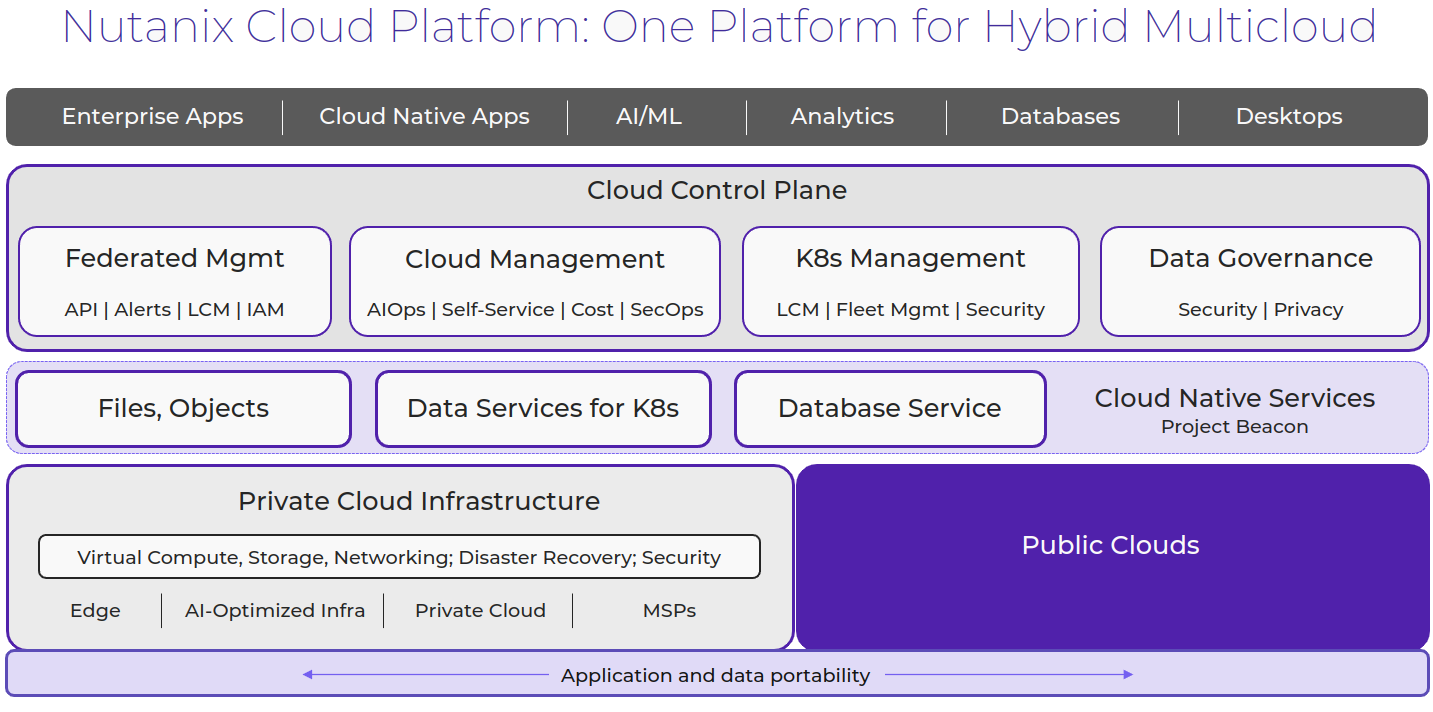

Nutanix Cloud Platform

Nutanix Cloud Platformは、ハイブリッドマルチクラウドインフラストラクチャーを構築するための、安全性、弾力性、自己修復を備えているプラットフォームです。 さまざまなコンピュート、ストレージ、ネットワークの要件のあるパブリックおよびプライベートクラウド、複数のハイパーバイザーとコンテナを横断してあらゆる種類のワークロードとユースケースをサポートします。

Nutanixクラウドプラットフォームの構成要素は、NutanixクラウドインフラストラクチャーとNutanixクラウドマネージャーです。 これらはそれぞれの下に位置する製品で、完全なソリューションを形成しています。

Nutanixクラウドインフラストラクチャー(NCI)

- AOSスケールアウトストレージ

- これはNutanix Cloud Platformのコアであり、線形にスケーリングする、分散、高パフォーマンス、回復力のあるストレージプラットフォームを提供します。

- AHVハイパーバイザー

- ネイティブなエンタープライズクラスの仮想化、管理、そして監視の機能は、AHVによって提供されます。 Nutanix Cloud PlatformはESXiとHyper-Vもサポートします。

- 仮想ネットワーキング

- AHVには、標準的なVLANベースの仮想ネットワーキングが搭載されています。 また、Flow Virtual Networkingを有効にすることで、仮想プライベートクラウド(VPC)やその他の高度なネットワーク構成をAHVで提供し、分離、自動化、マルチテナンシーを強化できます。

- ディザスタリカバリ

- シンプルに展開でき管理が容易な、統合されたディザスタリカバリであり、オンプレミスおよびクラウドで柔軟なRPOとRTOの選択肢を提供します。

- コンテナサービス

- Nutanix Cloud Platformは、OpenShiftなどのコンテナサービスにコンピュートとデータを提供し、そしてエンタープライズKubernetesマネージメントソリューション(Nutanix Kubernetes Engine)を提供して、エンドツーエンドの本番利用に対応しているKubernetes環境を提供および管理します。

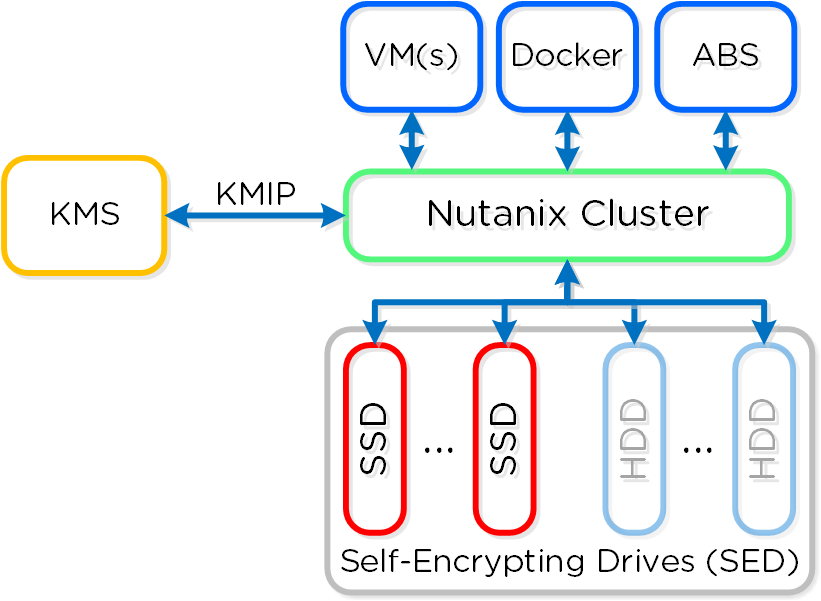

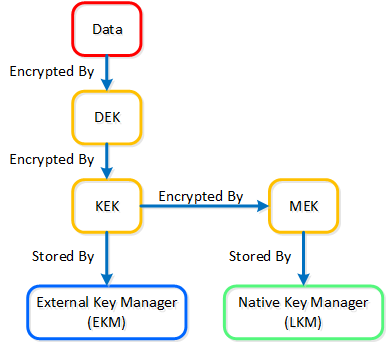

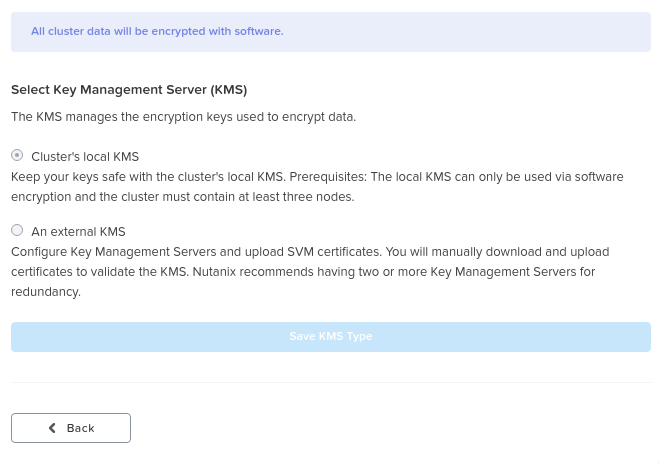

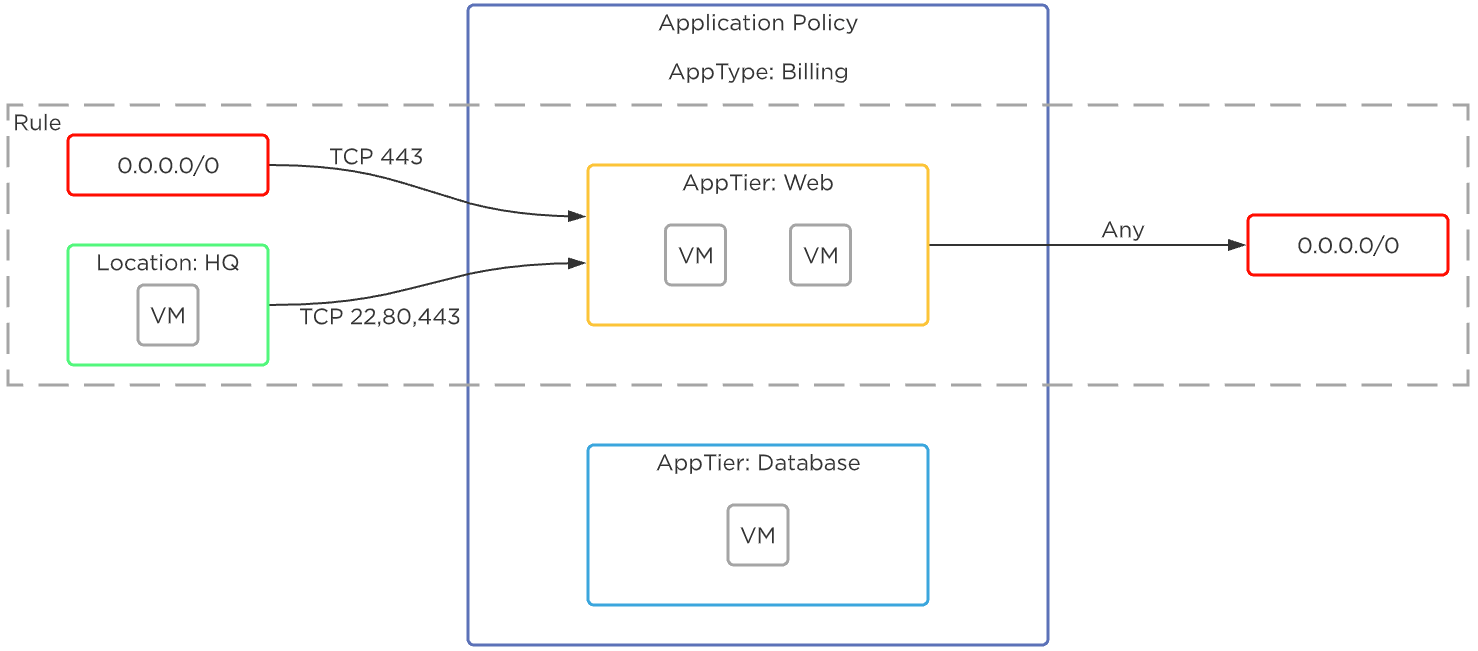

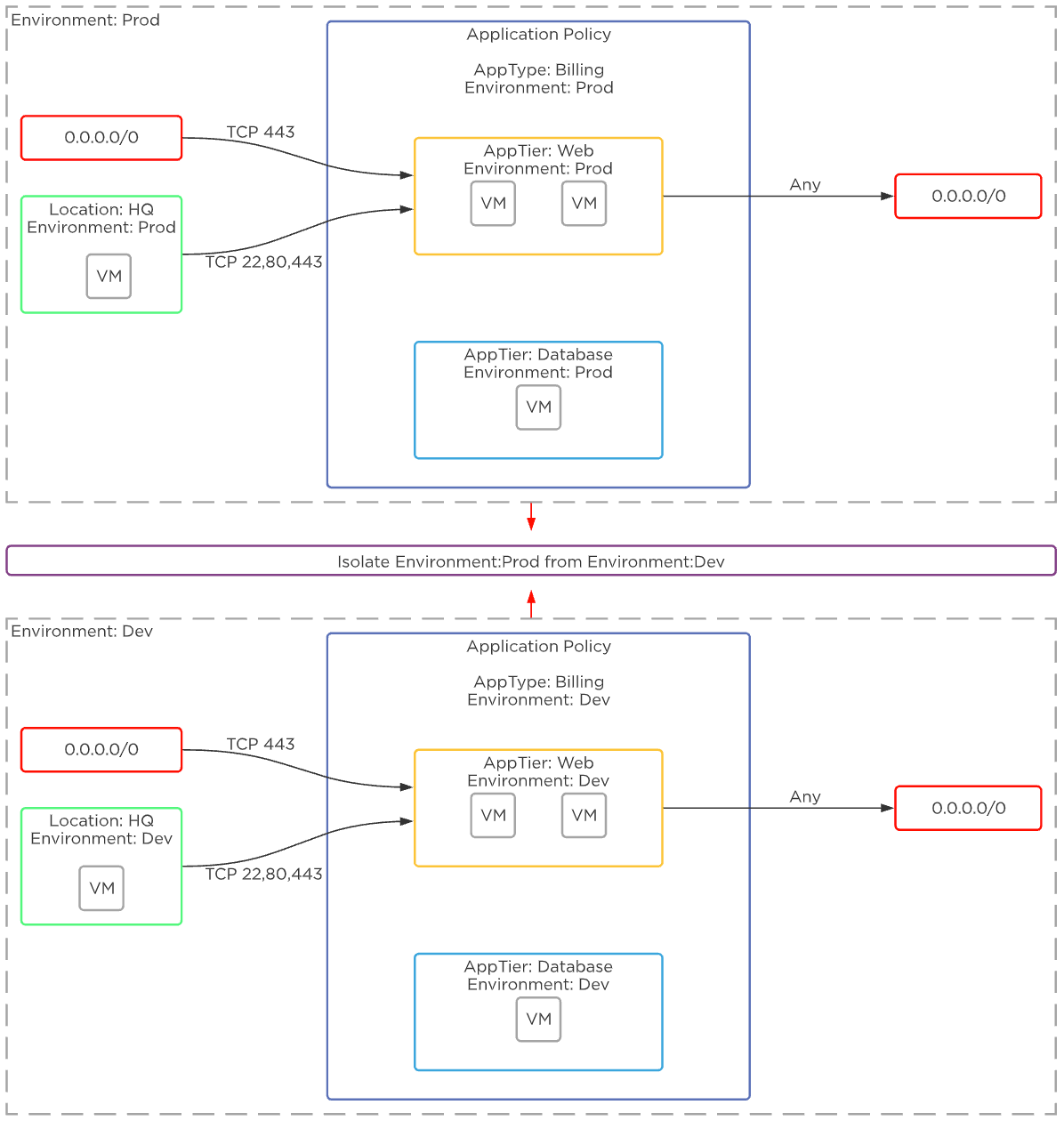

- データとネットワークのセキュリティ

- 内蔵のローカルキーマネージャーでの暗号化を使用したデータの包括的なセキュリティと、Flow Network Securityでのネットワークとアプリケーションのためのソフトウェアベースのファイアウォールがあります。

Nutanixクラウドマネージャー(NCM)

- AI Operations(NCM インテリジェントオペレーション)

- キャパシティの最適化、プロアクティブなパフォーマンス異常検出、そしてインフラストラクチャー管理を合理化できる運用タスク自動化機能を提供します。

- セルフサービスによるインフラストラクチャーとアプリのライフサイクル管理(NCM Self-Service)

- セルフサービス、自動化、そして集中化されたロールベースのガバナンスによる、ハイブリッドクラウド全体でアプリケーションを管理、展開、および拡張する機能を備えたオーケストレーションです。

- コストガバナンス

- インテリジェントなリソースサイジングと、クラウドメータリングおよびチャージバックへの正確な可視性により、財務説明責任を推進します。

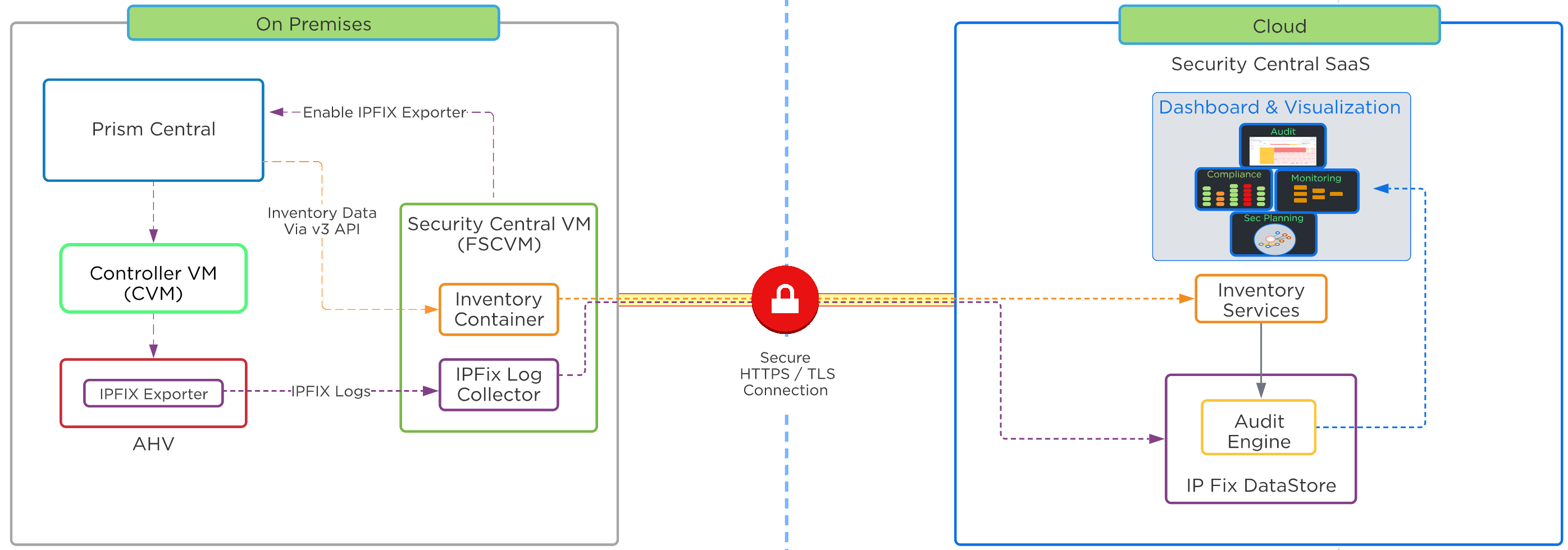

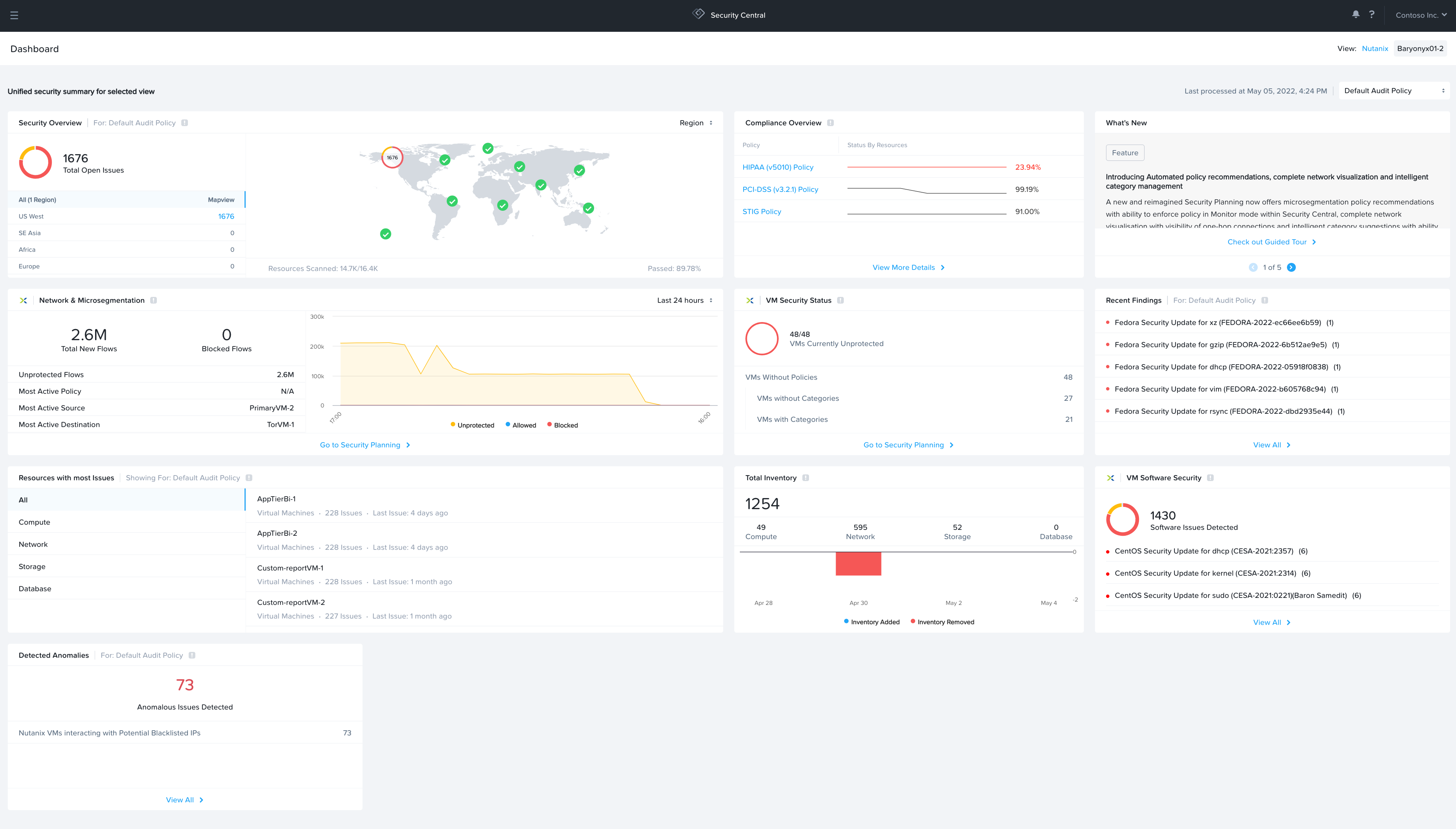

- Security Central

- クラウドセキュリティオペレーションの統合、ワークロード脆弱性の特定、マイクロセグメンテーション管理、ゼロトラストなどの戦略的イニシアチブにおける規制コンプライアンス要件順守のためのセキュリティダッシュボードです。

NCIとNCMに加えて、Nutanix Cloud Platformは次のサービスも提供しています。

Nutanix ユニファイドストレージサービス

- Filesストレージ

- シンプルで安全なソフトウェア定義スケールアウトファイルストレージとその管理

- Objectsストレージ

- シンプルで安全、そしてスケールアウトするS3と互換性のある大規模なオブジェクトストレージ

- Volumesブロックストレージ

- ストレージリソースを仮想化されたゲストOSまたは物理ホストに直接公開できる、エンタープライズクラスのスケールアウトブロックストレージ

Nutanixデータベースサービス

シンプルで自動化された、ハイブリッドクラウド全体でのデータベースライフサイクル管理

デスクトップサービス

あらゆるクラウド上で仮想デスクトップとアプリケーションを大規模に提供します。

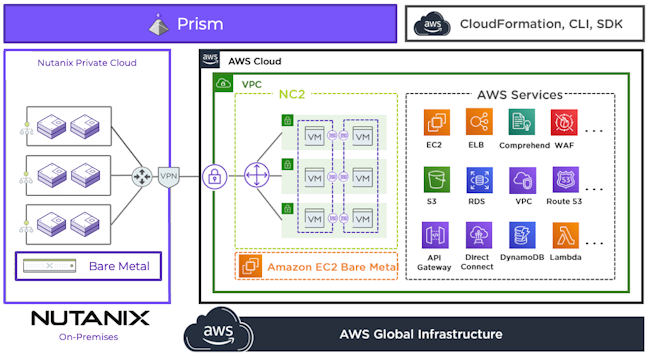

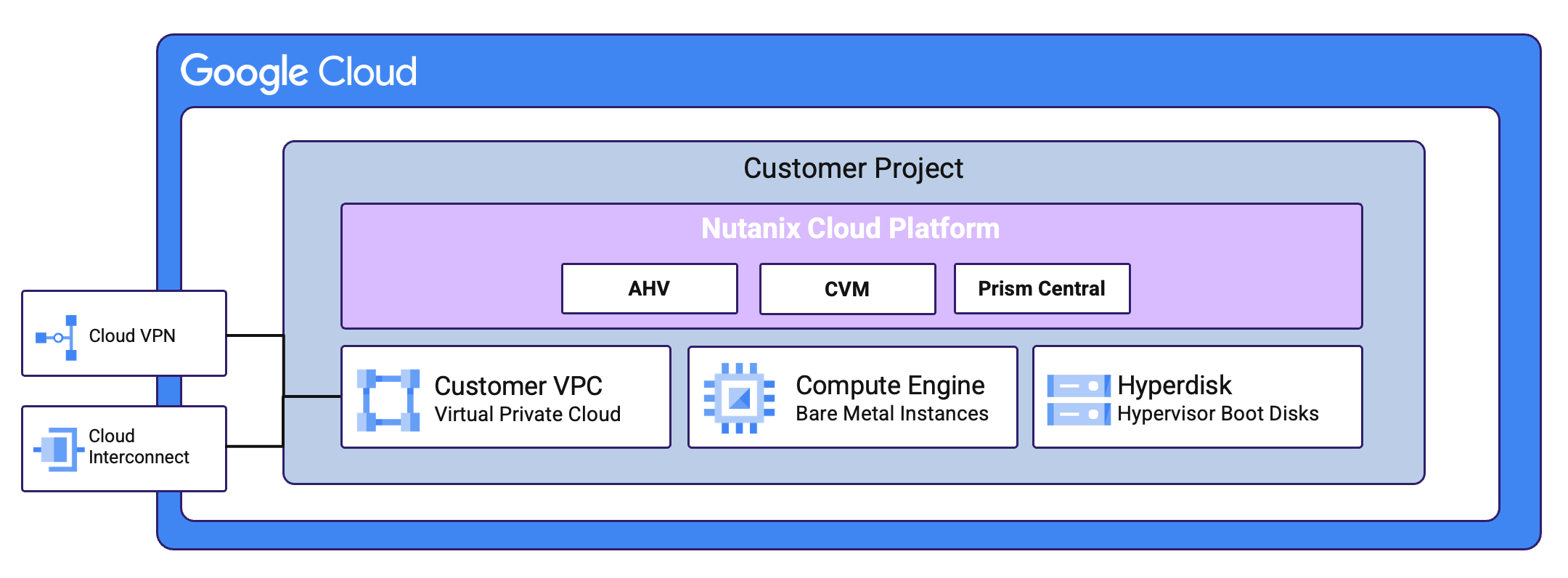

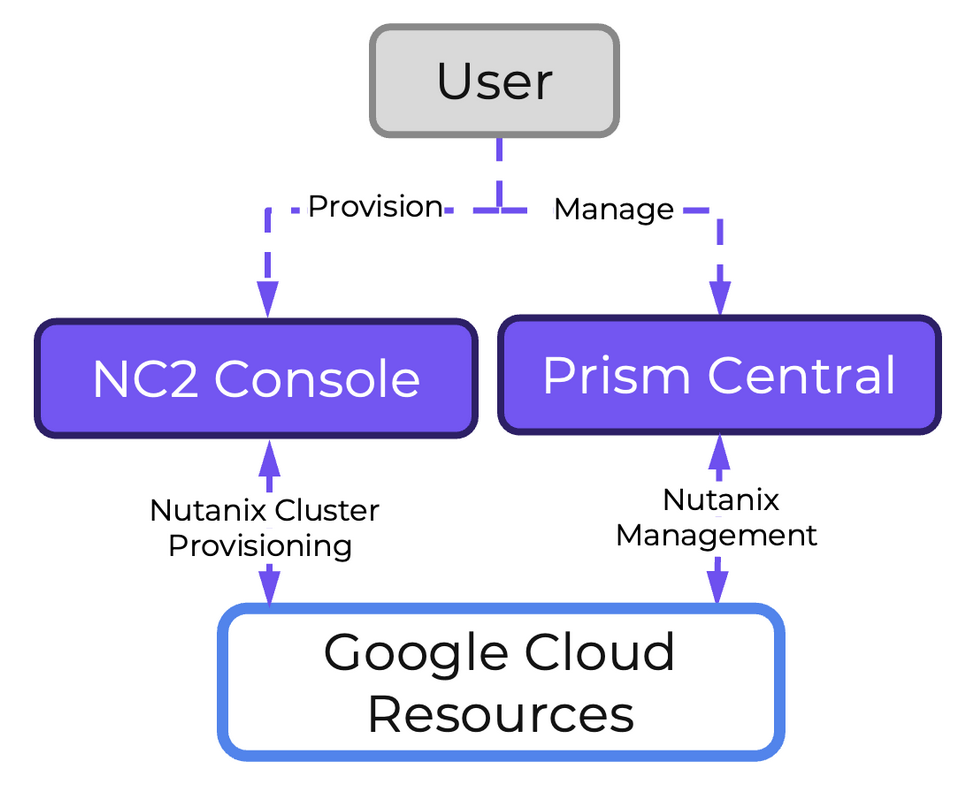

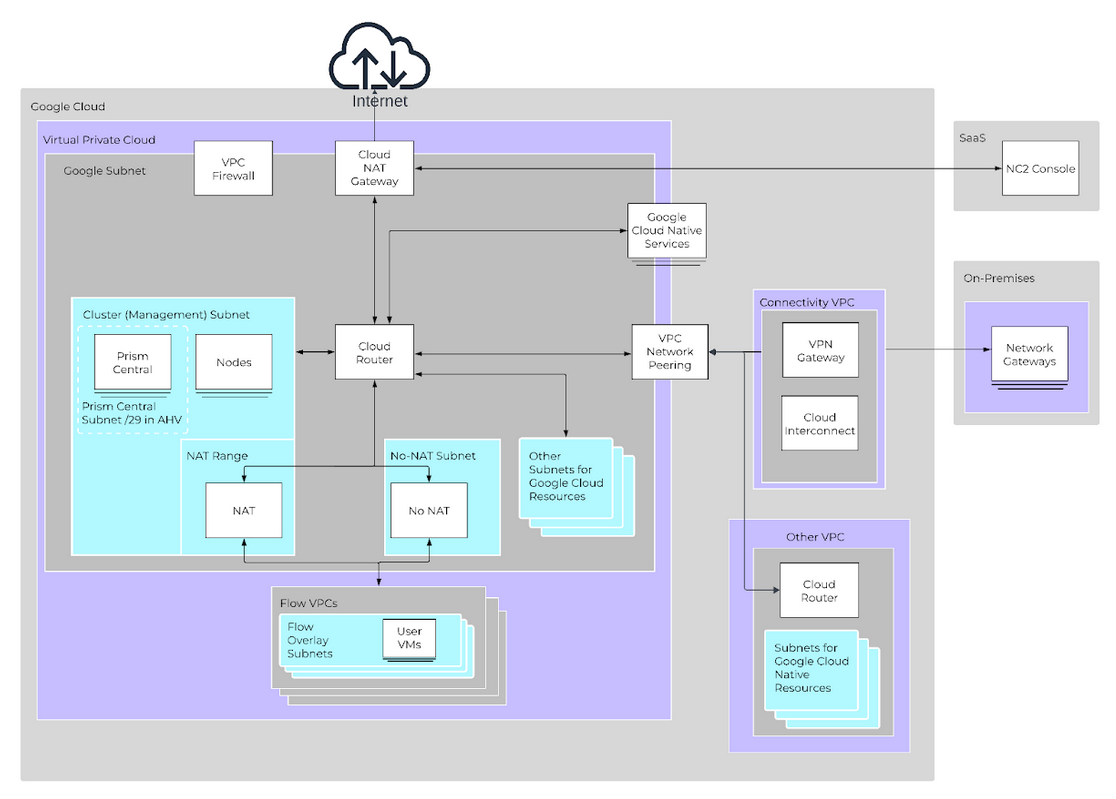

Nutanix Cloud Platformは、オンプレミス、Nutanix Cloud Clusters(NC2)を使用したパブリッククラウド、コロケーション、または必要に応じてエッジに展開できます。 ライセンスおよびソフトウェアオプションについては Nutanix.comのNutanix クラウドプラットフォームソフトウェアオプションページ をご確認ください。

プラットフォーム

Nutanixは、さまざまなベンダーのプラットフォームと構成をサポートしています。 プラットフォームは、Nutanixアプライアンス、OEMプラットフォーム、そしてオンプレミスプラットフォーム用のサードパーティサーバーベンダーによるものです。 さらに、NutanixソフトウェアはNC2を備えたパブリッククラウドプラットフォームとサービスプロバイダークラウドでも実行されています。 完全なリストについては Nutanix.comのハードウェアプラットフォームページ をご確認ください。

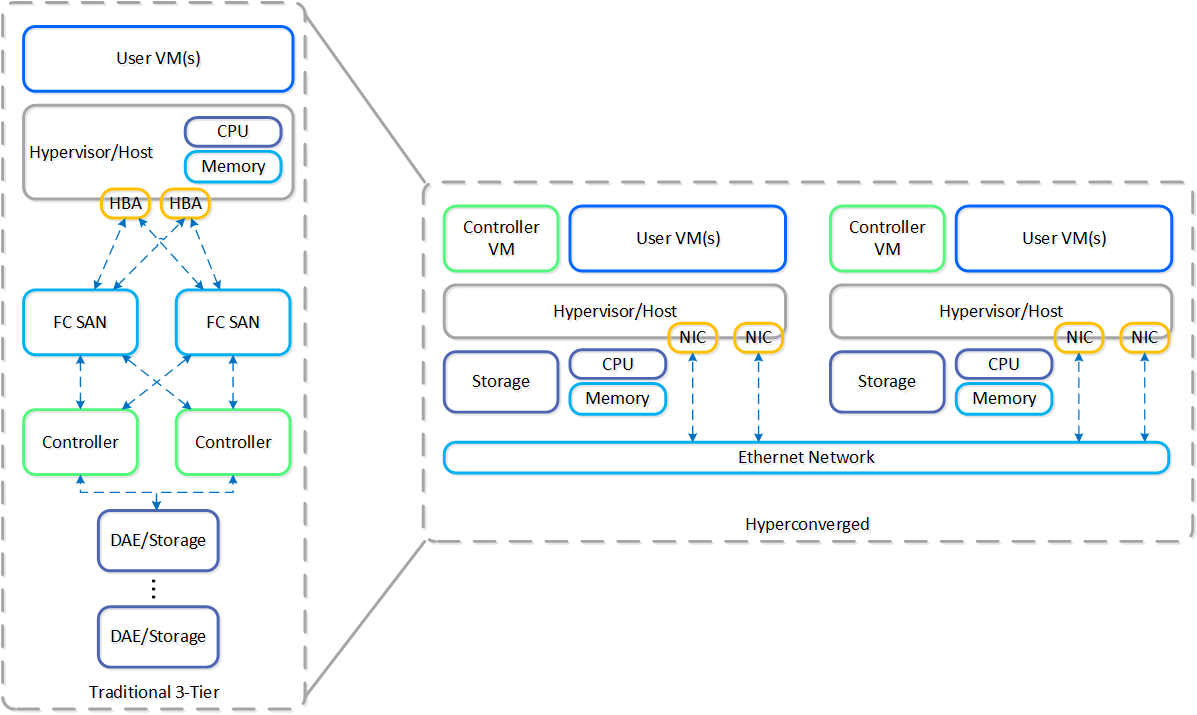

ハイパーコンバージド プラットフォーム

ビデオによる解説は、こちらからご覧いただけます: LINK

ハイパーコンバージドシステムには、いくつかの核となる構造があります:

- コンピューティングスタックの収束と崩壊が必要(例:コンピュート+ストレージ)

- システム内のノード間でデータとサービスのシャード(分散)が必要

- 集中型ストレージと同等の機能を備えていることが必要(例:HA、ライブマイグレーションなど)

- データを可能な限り実行処理(コンピュート)に近づける必要 (Importance of Latency)

- ハイパーバイザーに依存しない

- ハードウェアに依存しない

以下の図は、典型的な3層スタック対ハイパーコンバージドの例を示しています:

ご覧のように、ハイパーコンバージドシステムは以下のことを行います:

- コントローラーを仮想化してホストに移動する

- コアサービスとロジックをソフトウェアによって提供する

- システム内のすべてのノードにデータを分散(シャード)する

- ストレージをコンピュートのローカルに移動する

Nutanixソリューションは、ローカルコンポーネントを活用してワークロードを実行するための分散プラットフォームを作成する、統合ストレージ+コンピューティングのソリューションです。

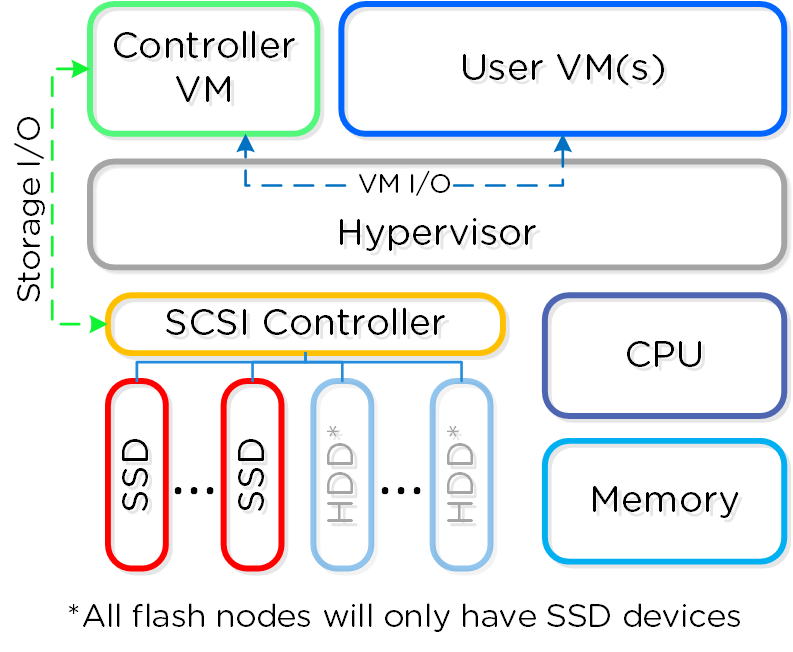

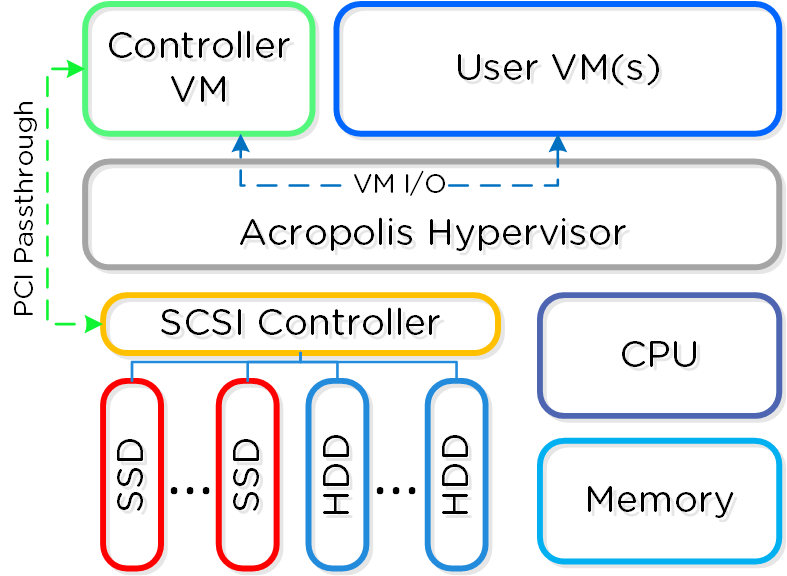

それぞれのノードで、業界の標準的なハイパーバイザー(現在はESXi、AHV、Hyper-V)およびNutanixコントローラーVM(CVM)を稼動させることができます。 Nutanix CVMは、Nutanixソフトウェアを稼動させ、ハイパーバイザーおよびその上で稼動する全てのVMに対するI/O処理の全てを受け持ちます。

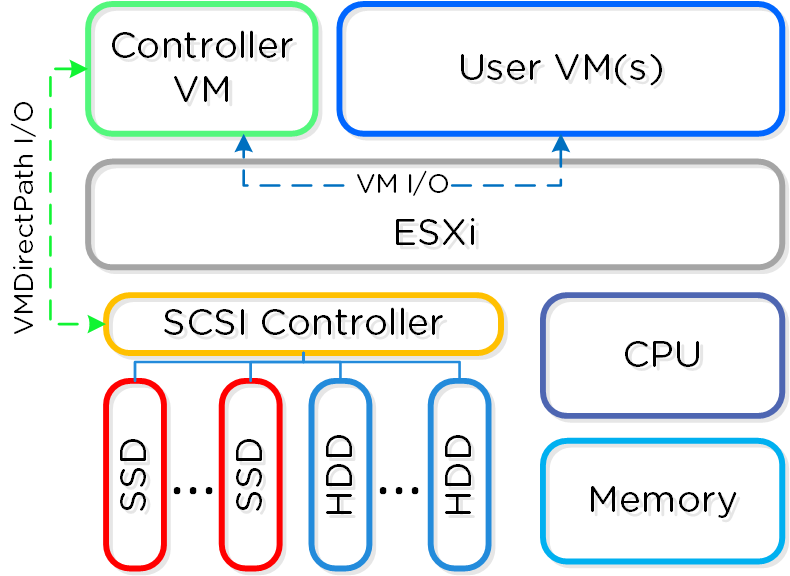

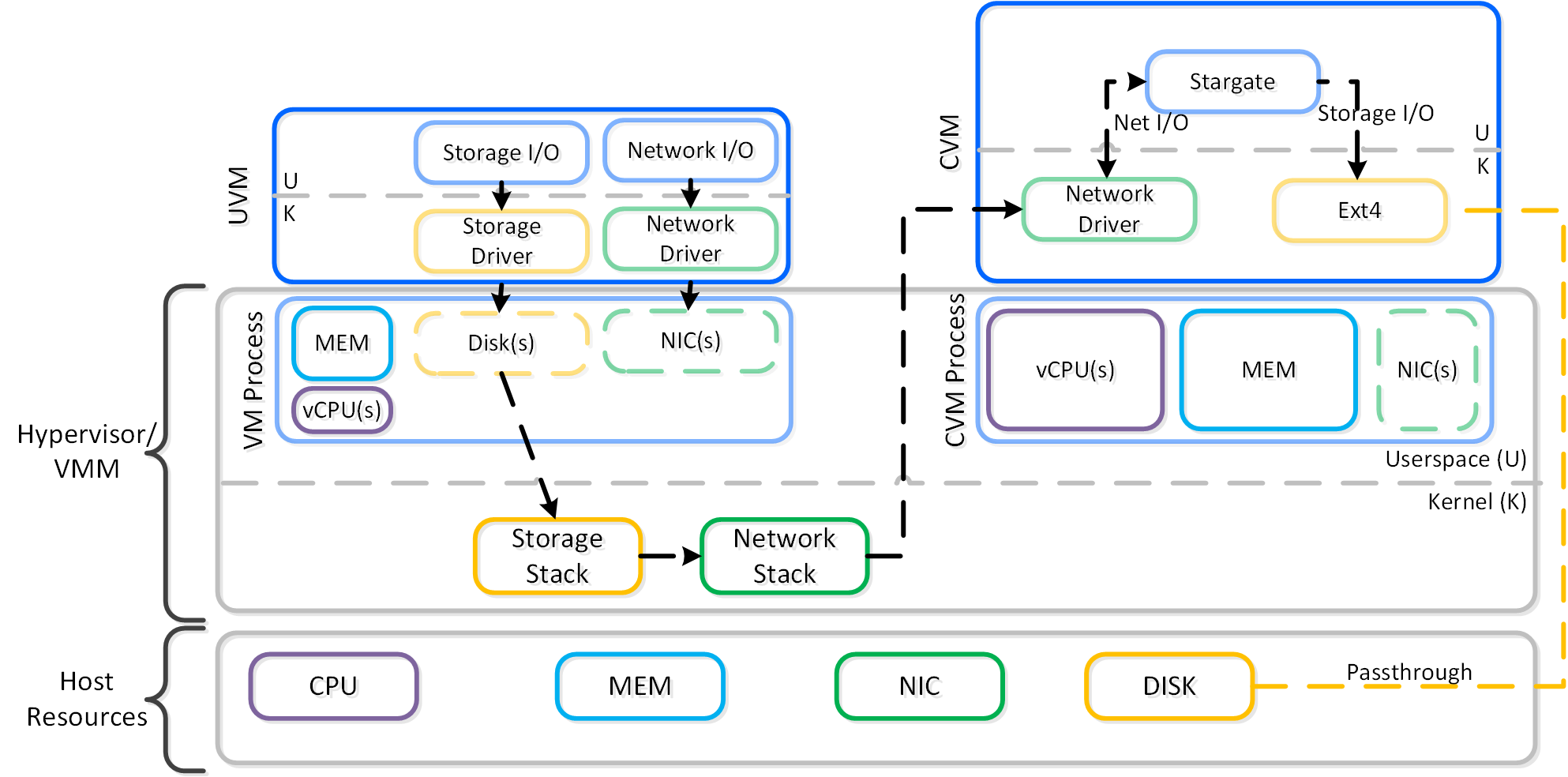

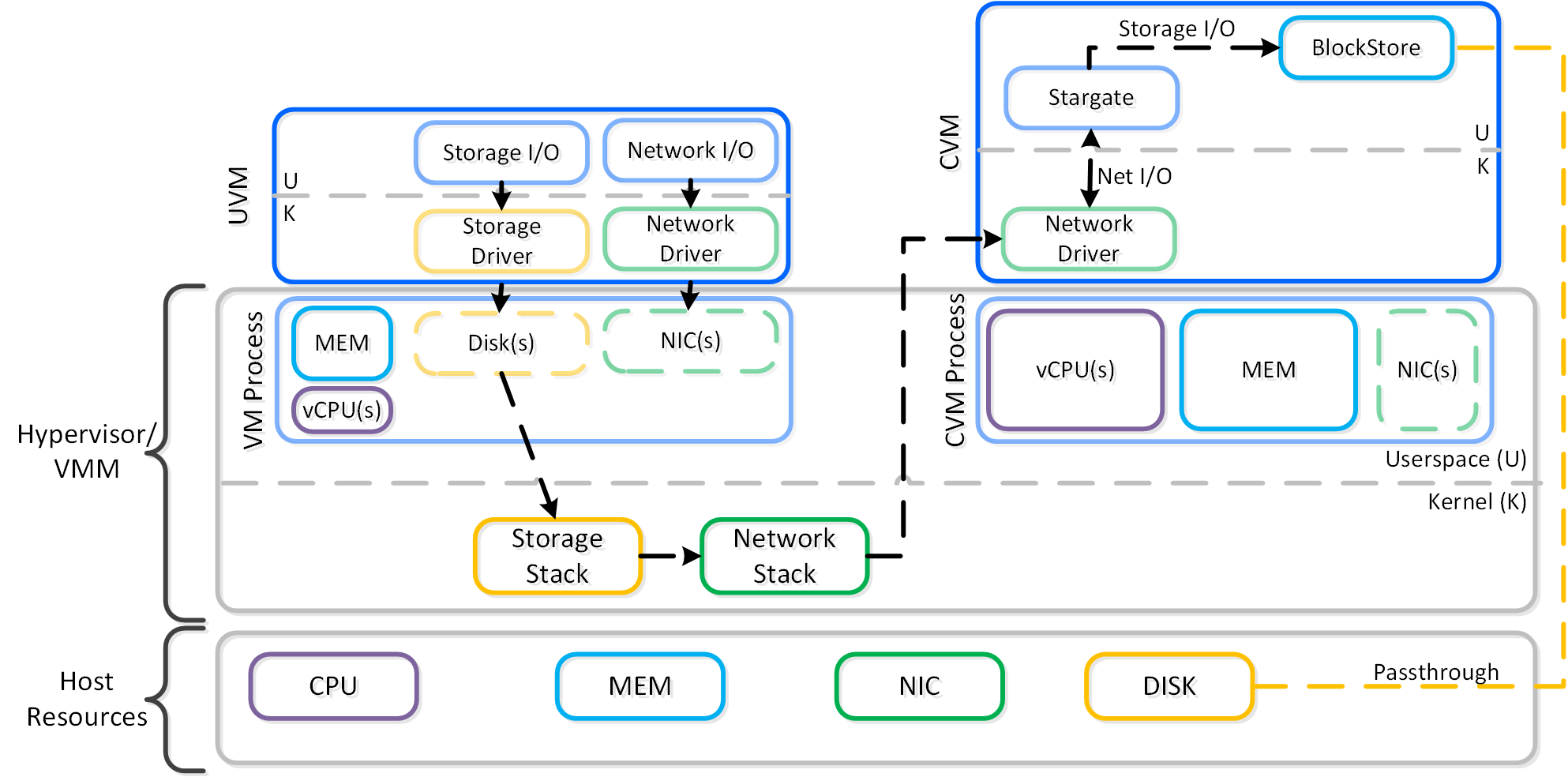

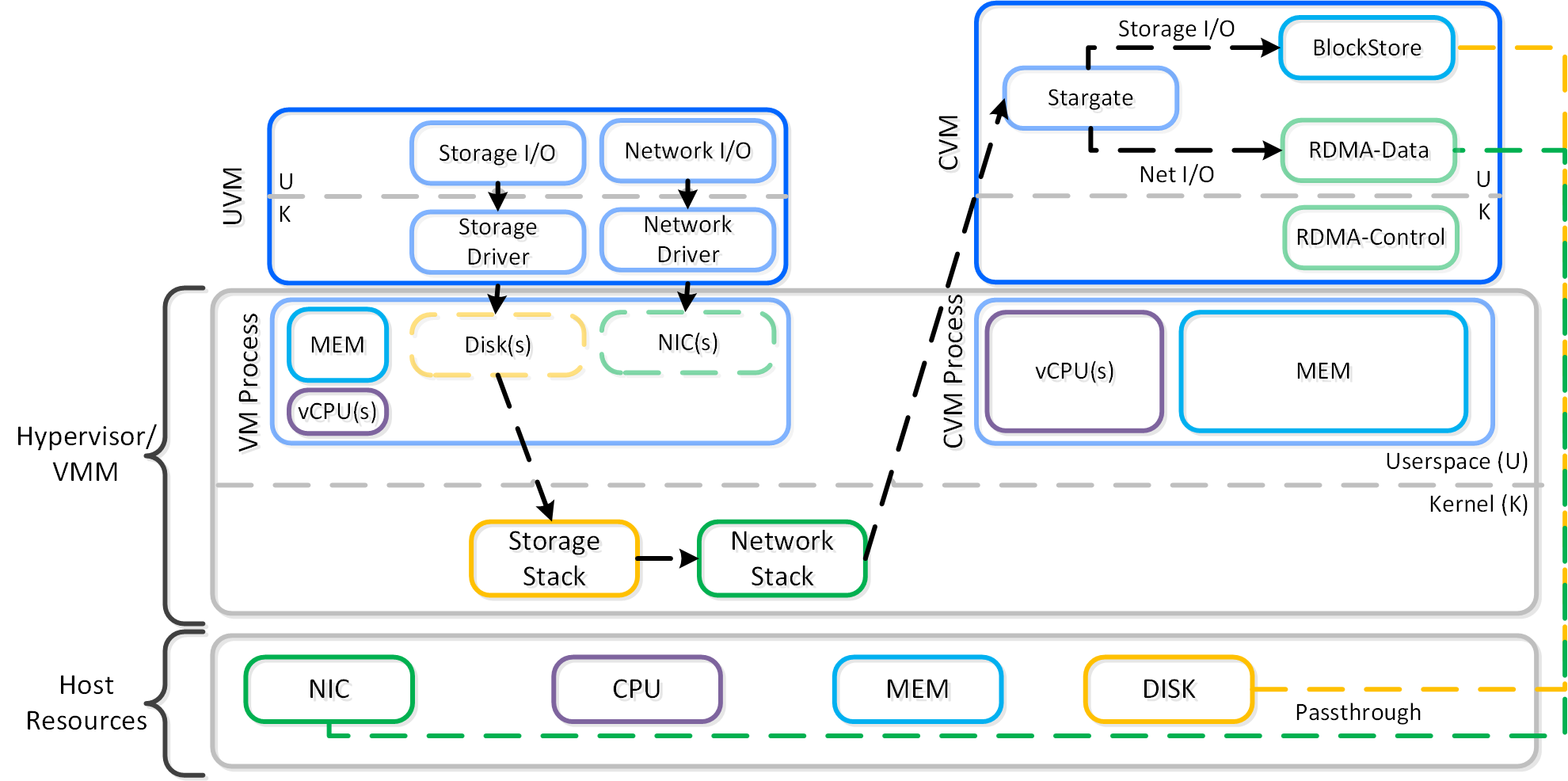

以下は、典型的なノードの論理構成例を図示したものです:

Nutanix CVMは、コアとなるNutanixプラットフォームロジックを担当し、以下のようなサービスを処理します:

- ストレージI/Oと変換(重複排除、圧縮、EC)

- UI / API

- アップグレード

- DR / レプリケーション

- その他

注: 一部のサービスや機能は、追加のヘルパーVMを作成したり、マイクロサービスプラットフォーム(MSP)を使用したりします。 例えば、Nutanix Filesは追加のVMをデプロイしますが、Nutanix ObjectsはMSPのためのVMをデプロイし、それらを活用します。

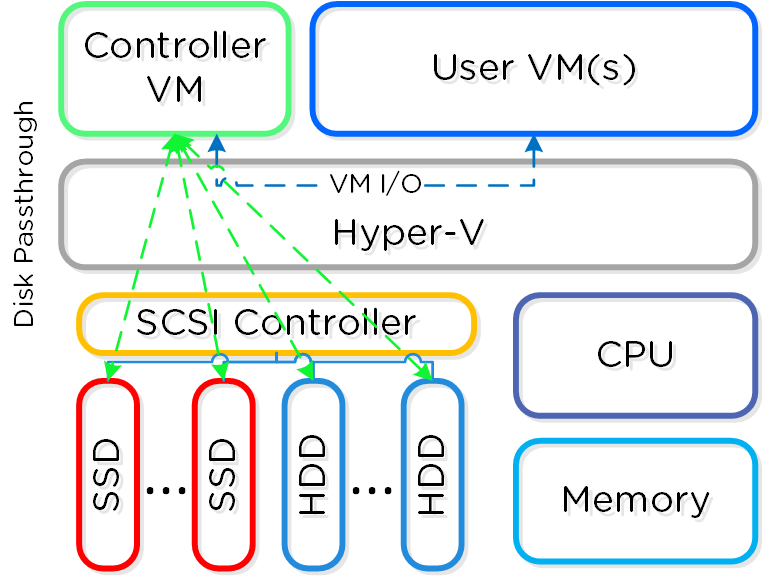

VMware vSphereが動作するNutanixユニットの場合、SSDやHDDデバイスを管理するSCSIコントローラーが、VM-Direct Path(Intel VT-d)を利用して直接CVMに接続されます。 Hyper-Vの場合は、ストレージデバイスがCVMにパススルー接続されます。

コントローラーの仮想化

Nutanixコントローラーをユーザー空間でのVMとして実行する主な理由は、以下の4領域に分類されます:

- 移動性

- 回復性

- 保守とアップグレード

- パフォーマンス(はい、本当ですよ)

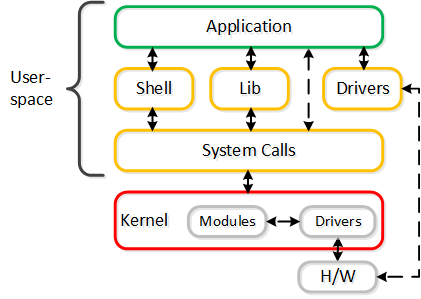

はじめから、私達は単一のプラットフォーム企業ではないことを知っていました。 それ故に、ハードウェア、クラウド、ハイパーバイザーベンダーのいずれであっても、選択肢を持つことは常に私たちにとって重要でした。

ユーザー空間でVMとして実行することで、Nutanixソフトウェアをアンダーレイとなるハイパーバイザーおよびハードウェアプラットフォームから切り離します。 これにより、コアのコードベースをすべての運用環境(オンプレミスおよびクラウド)で同じに保ちながら、他のハイパーバイザーのサポートを迅速に追加できました。 そのうえ、ベンダー固有のリリースサイクルに縛られない柔軟性を提供しました。

ユーザー空間でVMとして実行する性質上、ハイパーバイザーの外部にあるため、アップグレードやCVMの「障害」といったものをエレガントに処理できます。 例えば、CVMがダウンするという破滅的な問題が発生した場合でも、ノード全体が、クラスタ内の他のCVMからのストレージI/Oとサービスで引き続き稼働します。 AOS(NutanixのCoreソフトウェア)のアップグレード中でも、そのホストで実行されているワークロードに影響を与えることなくCVMを再起動できます。

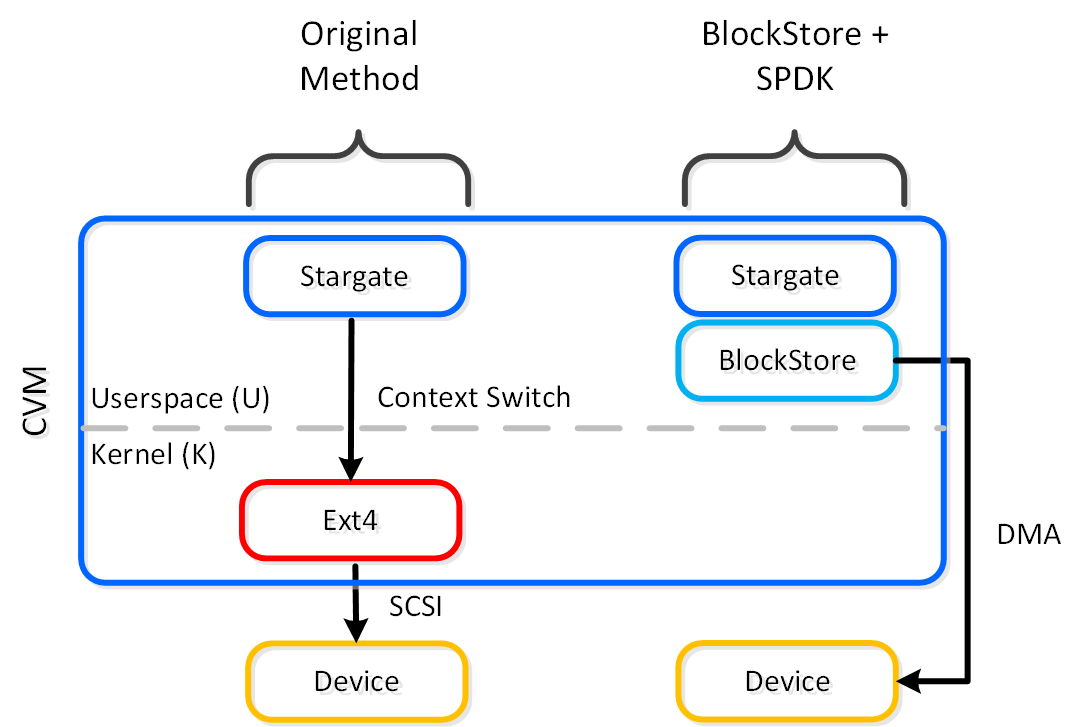

しかし、カーネル内にあるほうがより高速ではないでしょうか? 簡潔に答えると、NOです。

よく議論に上がるのは、カーネル内とユーザー空間のどちらにあるかについてです。 これについては、実際の内容とそれぞれの長所と短所を説明する「ユーザー空間とカーネル空間」のセクションを一読することをお勧めします。

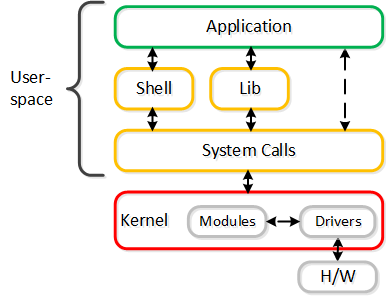

要約すると、オペレーティングシステム(OS)には2つの実行空間があり、それは カーネル(特権のあるOSのコアでドライバーが常駐するような場所)とユーザー空間(アプリケーションやプロセスが常駐する場所)です。 慣例上、ユーザー空間とカーネルの間を移動すること(コンテキストスイッチとして知られる)は、CPUと時間(コンテキストスイッチあたり~1,000ns)の面でコストがかかる可能性があります。

その議論では、カーネルにいることは常にベターで速いということですが、これは誤りです。 何があっても、ゲストVMのOSには常にコンテキストスイッチがあります。

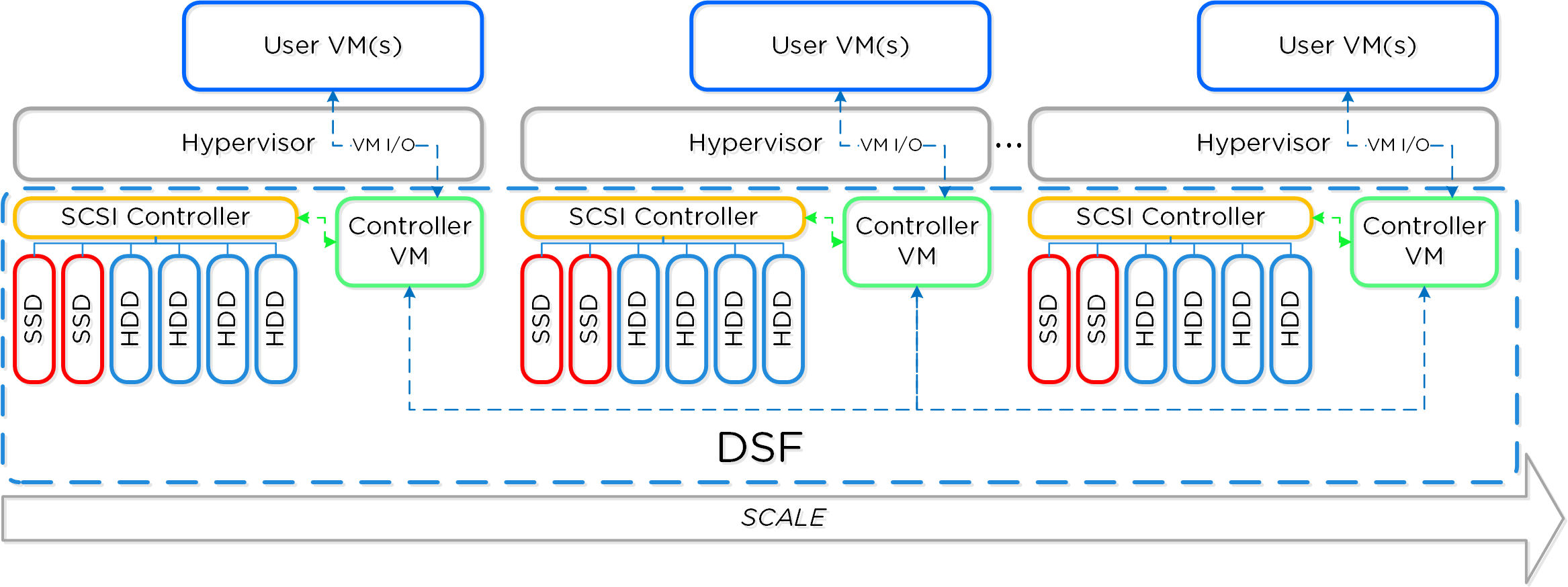

分散システム

分散システムとして不可欠な要素が3つあります:

- 単一障害点 (SPOF) を持たないこと

- 規模に関わりなくボトルネックが発生しないこと(リニアな拡張が可能であること)

- 並列処理を利用していること (MapReduce)

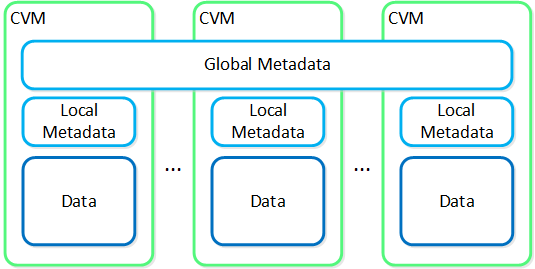

Nutanixの複数のノードから成るグループが、分散システム(Nutanixクラスタ)を形成し、PrismやAOSの機能を提供します。全てのサービスやコンポーネントは、クラスタ内の全てのCVMに分散され、高い可用性やリニアなパフォーマンスの拡張性能を提供します。

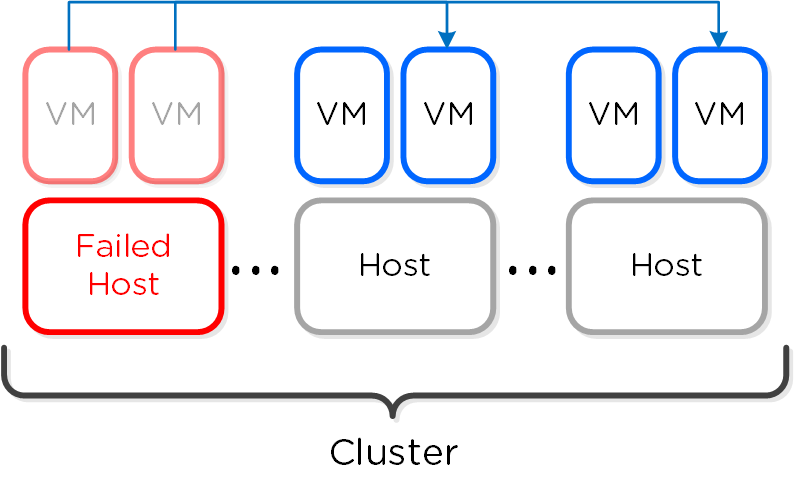

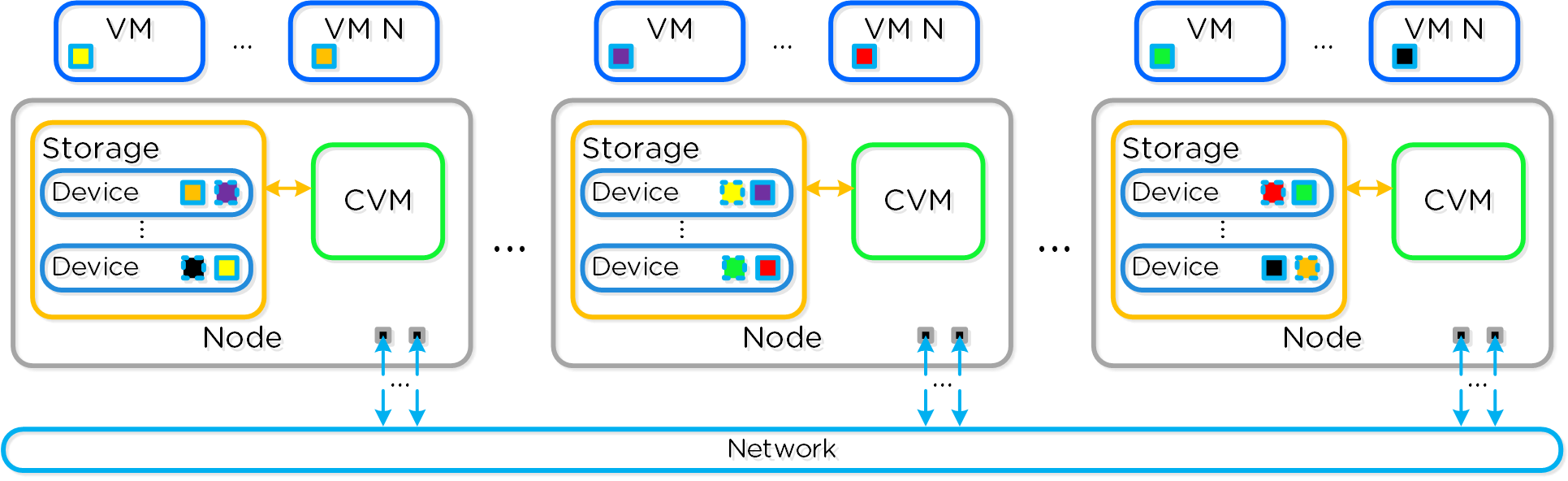

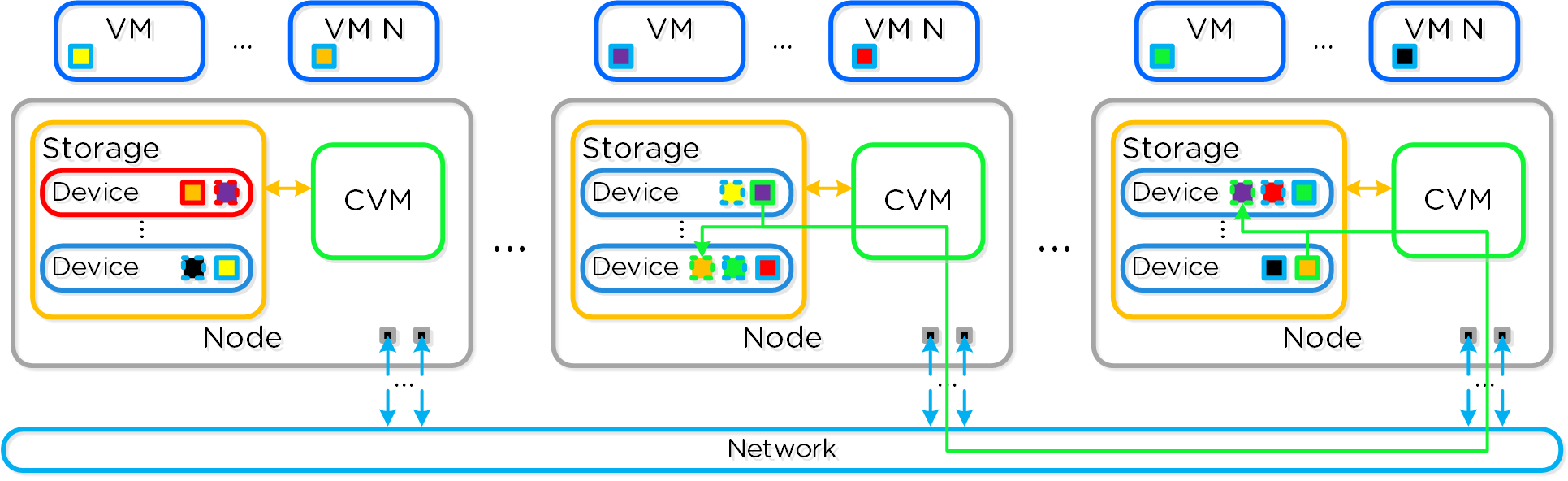

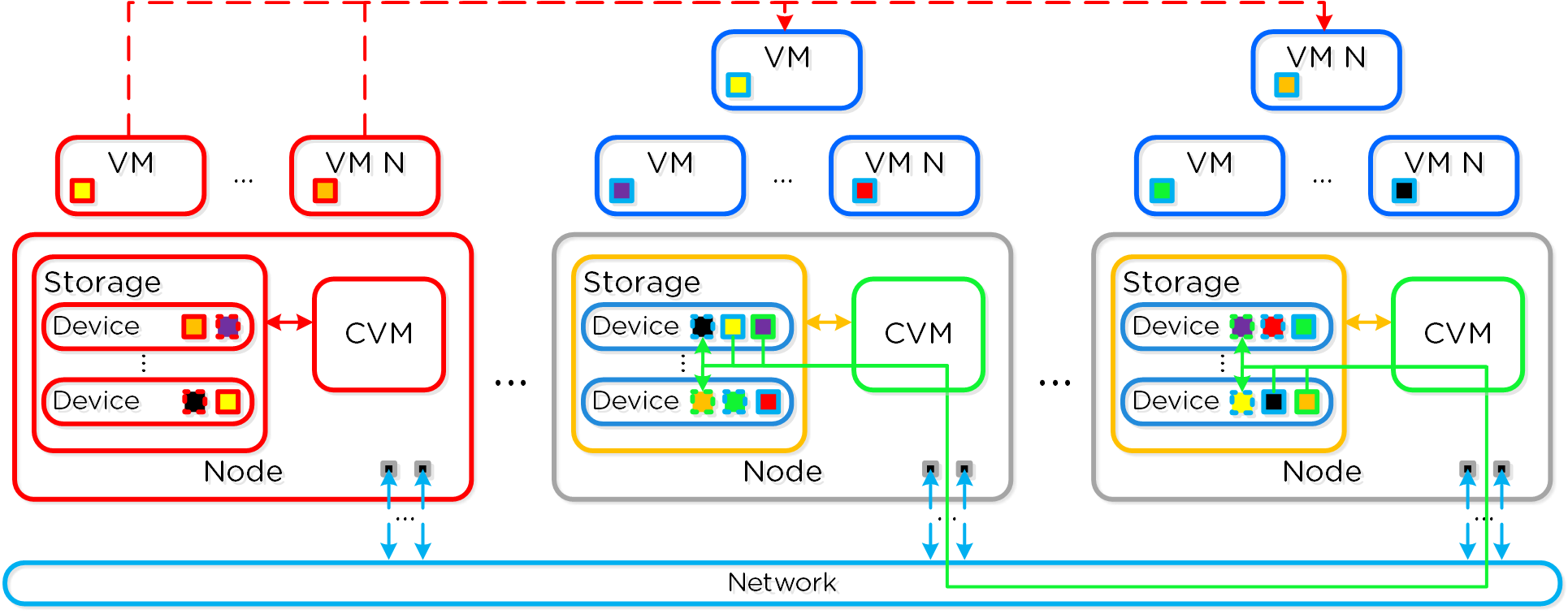

以下の図は、NutanixノードがどのようにNutanixクラスタを形成するのかを例示したものです:

これらのテクニックは、メタデータやデータにも同様に適用されています。全てのノードやディスクデバイスにメタデータやデータを分散することで、通常のデータ投入や再保護を行う際、最大のパフォーマンスが発揮されるようになっています。

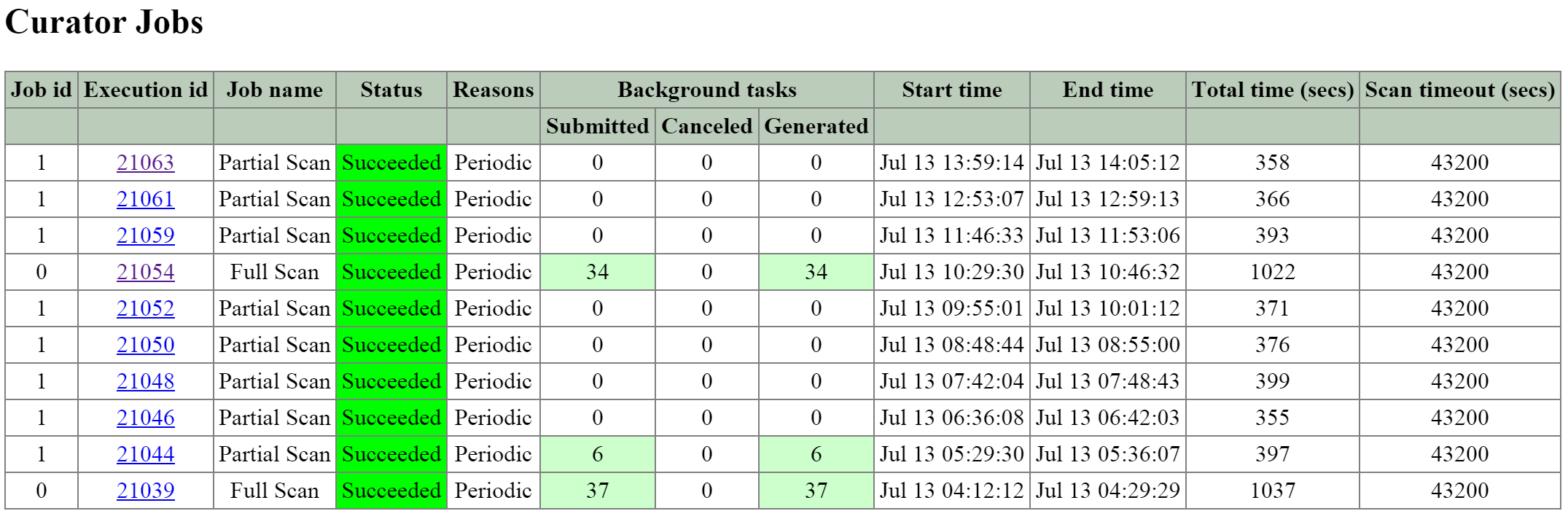

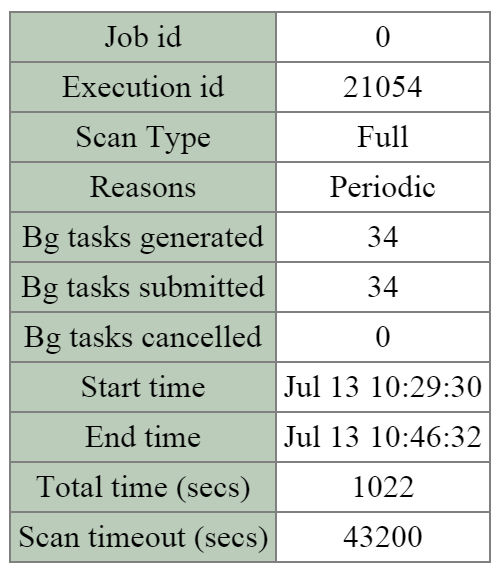

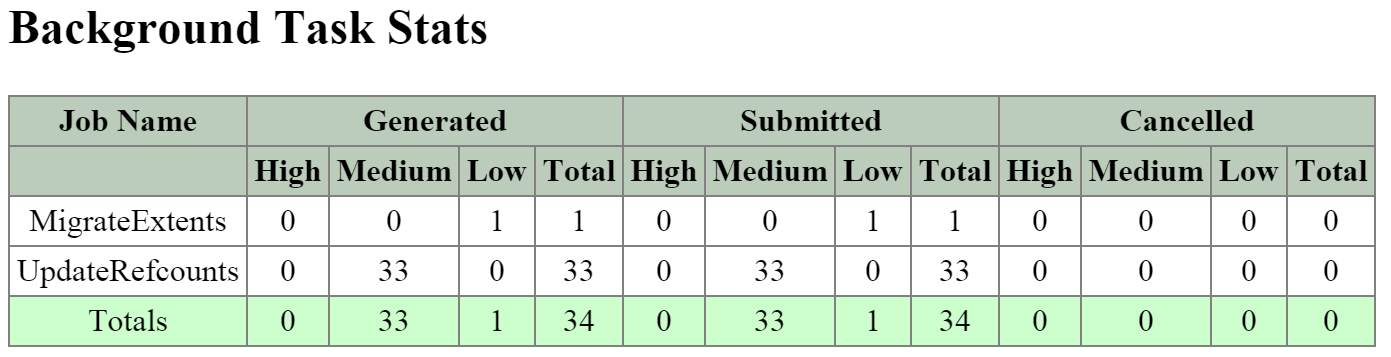

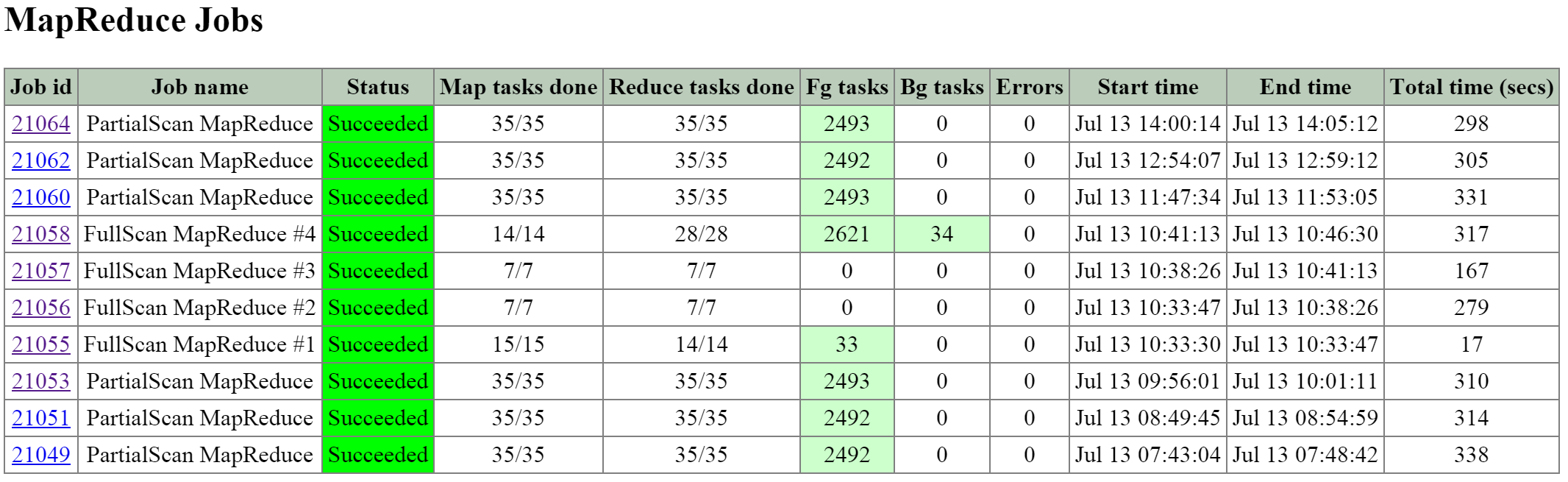

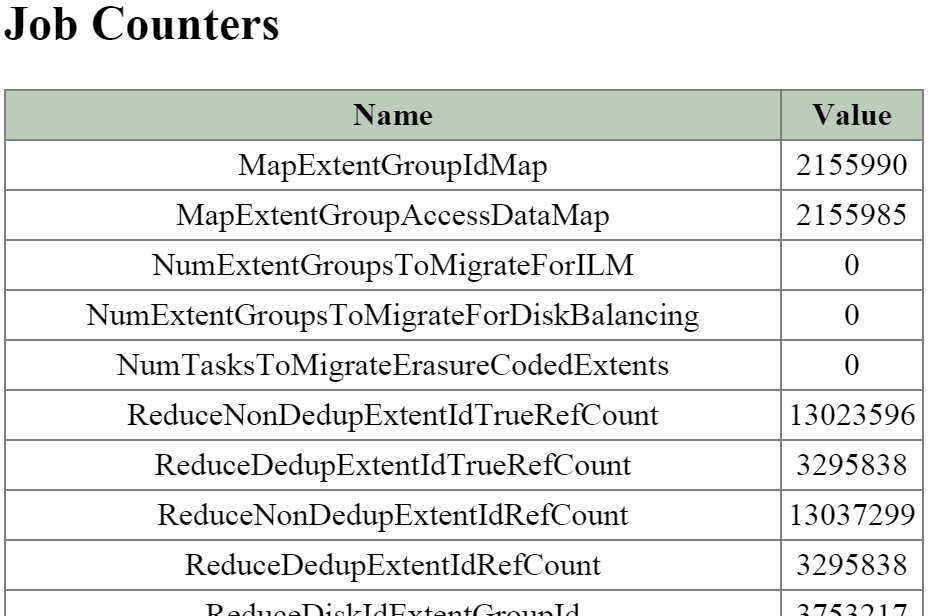

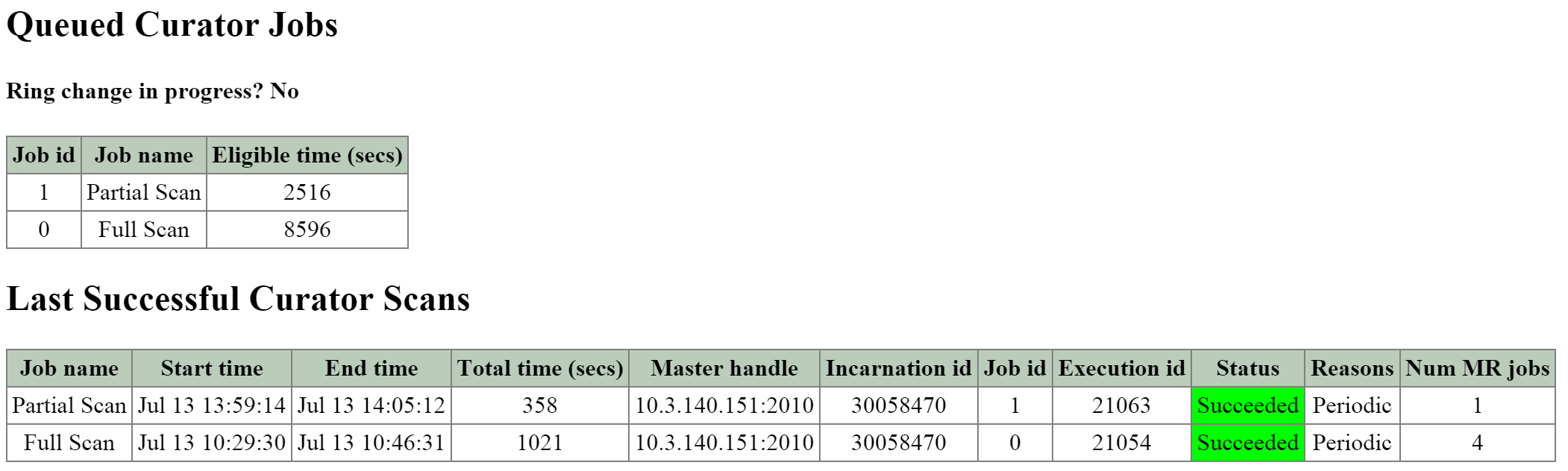

これによって、クラスタの能力を最大限に引き出しながら、Nutanixが使用するMapReduceフレームワーク(Curator)が並列処理を行えるようになります。例えば、データの再保護や圧縮、消失訂正号、重複排除といった処理がこれに該当します。

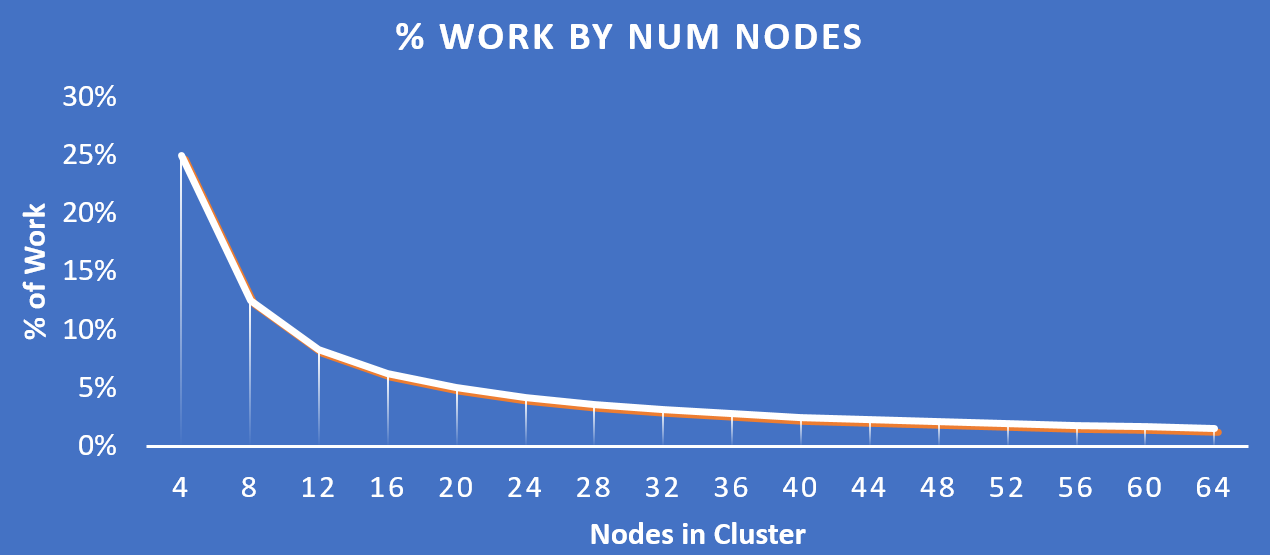

以下の図は、それぞれのノードがどの程度の割合で処理を分担しているのかを示したもので、クラスタの規模が拡大するにつれ、分担割合が劇的に低下していることが分かります:

重要な点: クラスタのノード数が増加(クラスタが拡大)すると、各ノードが負担すべき処理の割合が低下し、処理全体としての効率も向上します。

ソフトウェア デファインド

ソフトウェア デファインド システムには、4つの不可欠な要素があります:

- プラットフォーム(ハードウェア、ハードウェア)間のモビリティ(可搬性)を提供できること

- カスタムなハードウェアに依存しないこと

- 迅速な開発(機能開発、バグ修正、セキュリティパッチ)を可能にすること

- ムーアの法則の恩恵を活かせること

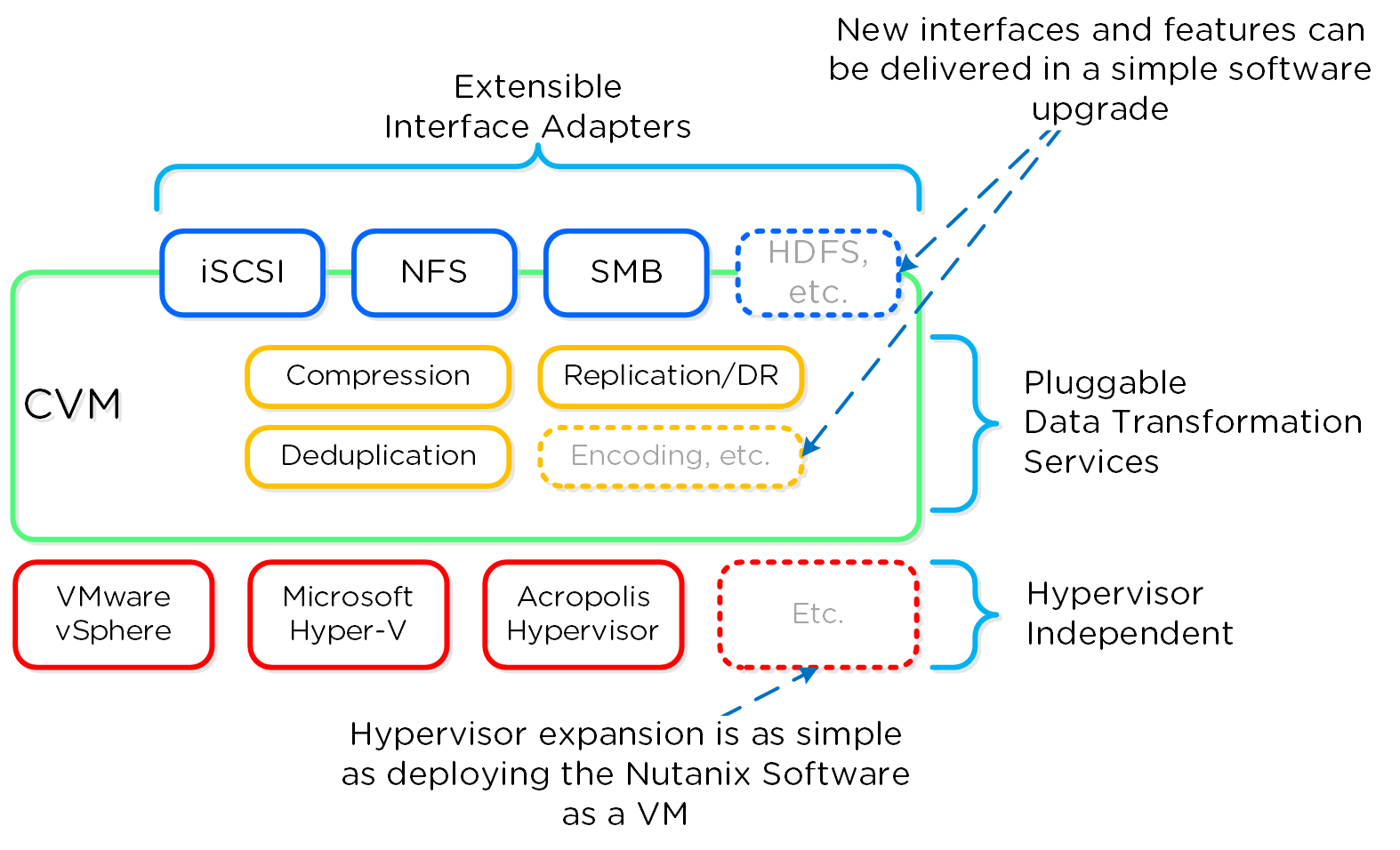

既に何度か説明した通り、Nutanixプラットフォームは、ソフトウェアベースのソリューションであり、ソフトウェアとハードウェアをバンドルしたアプライアンスとして出荷されます。 コントローラーVMには、Nutanixソフトウェアとロジックの大半が組み込まれており、当初から拡張性を持つプラガブルなアーキテクチャーとして設計されたものです。ソフトウェア デファインドとしてハードウェアの構成に依存しないメリットは、その拡張性にあります。製品を既に使用中の場合でも、拡張機能や新機能をいつでも取り入れることができます。

Nutanixは、カスタム仕様のASICやFPGA、またはハードウェア機能に依存しないことで、単にソフトウェア アップデートのみで新しい機能を開発・展開することができます。 これは、データ重複排除などの新機能をNutanixソフトウェアのバージョンをアップグレードすることにより展開できることを意味します。 また、レガシーなハードウェア モデルに対しても、新しい機能の導入を可能にします。 例えば、Nutanixソフトウェアの古いバージョンと、前世代のハードウェア プラットフォーム(例えば2400)でワークロードを稼動させていたと仮定します。 稼動中のソフトウェアバージョンでは、データ重複排除機能を提供しないため、ワークロードはその恩恵にあずかることができません。 このデータ重複排除機能は、ワークロードが稼動中であっても、Nutanixソフトウェアのバージョンをローリング アップグレードすることで利用可能です。 これは非常に簡単な作業です。

このような機能と同様に、新しい「アダプター」あるいはインターフェイスをDSFに向け作成できることも、非常に重要な性能です。 製品が出荷された当初、サポートはハイパーバイザーからのI/Oに対するiSCSIに限定されていましたが、現在では、NFSとSMBもその対象になっています。 将来的には、新しいアダプターを様々なワークロードやハイパーバイザー(HDFSなど)に向けて作成できるようになるでしょう。 繰り返しますが、これらの対応は全てソフトウェアのアップデートで完了します。 「最新の機能」を入手するために、ハードウェアを更改したりソフトウェアを購入したりする必要がある多くのレガシーなインフラストラクチャーとは対照的に、Nutanixではその必要がありません。 全ての機能がソフトウェアで実装されているため、ハードウェア プラットフォームやハイパーバイザーを問わずに稼動させることが可能で、ソフトウェア アップグレードによって新たな機能を実装することができます。

以下は、ソフトウェア デファインド コントローラー フレームワークの論理的な構成を図示したものです:

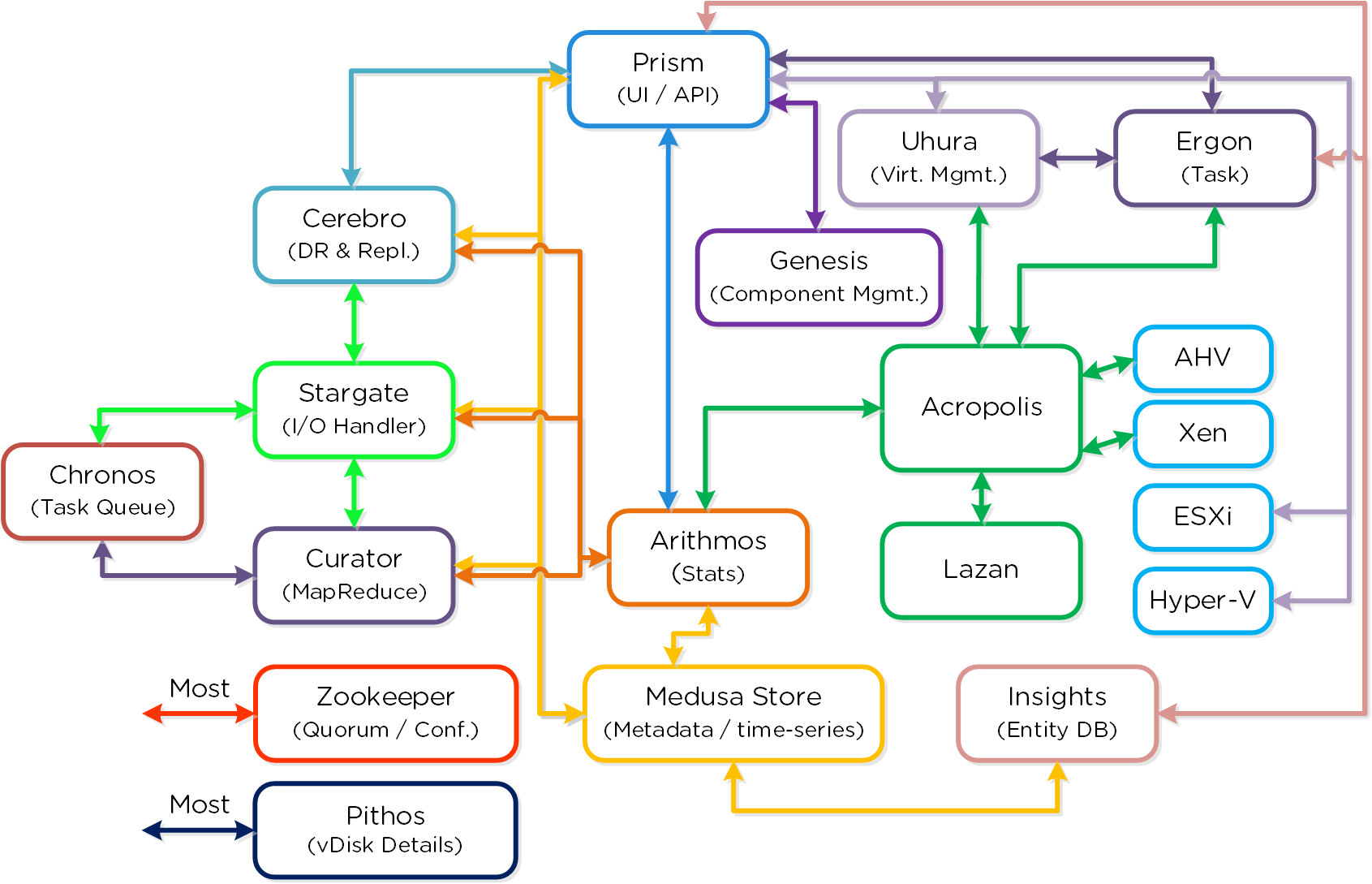

クラスタ コンポーネント

常にユーザーを主眼に置くNutanix製品は、その導入や使用が極めて容易です。 これは基本的に、抽象化や様々な自動化、さらにソフトウェアの連携機能によって実現されています。

以下にNutanix Clusterの主要コンポーネントを示します。(心配は無用です。全部記憶したり、個々の役割を全て理解したりする必要はありません)

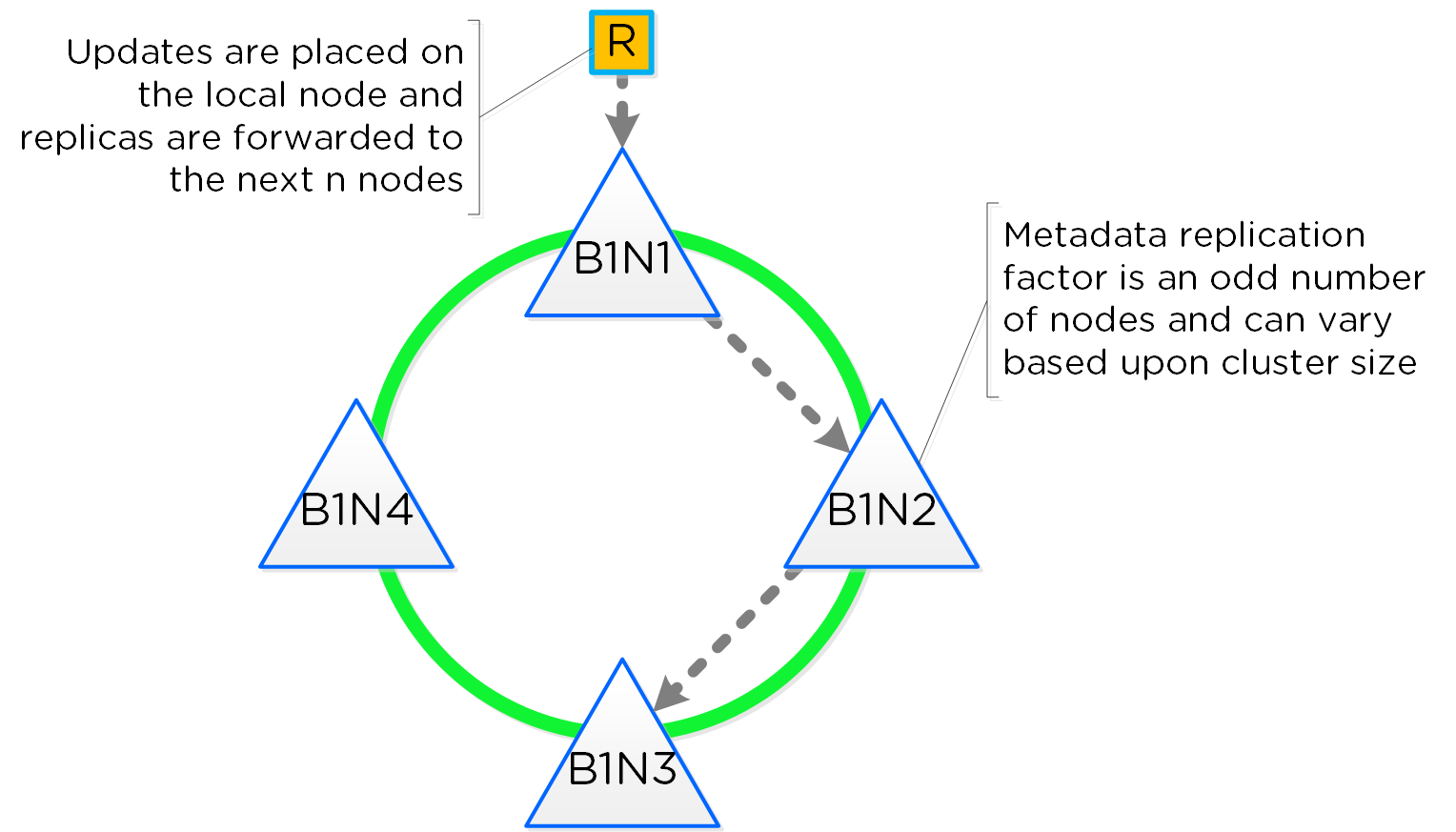

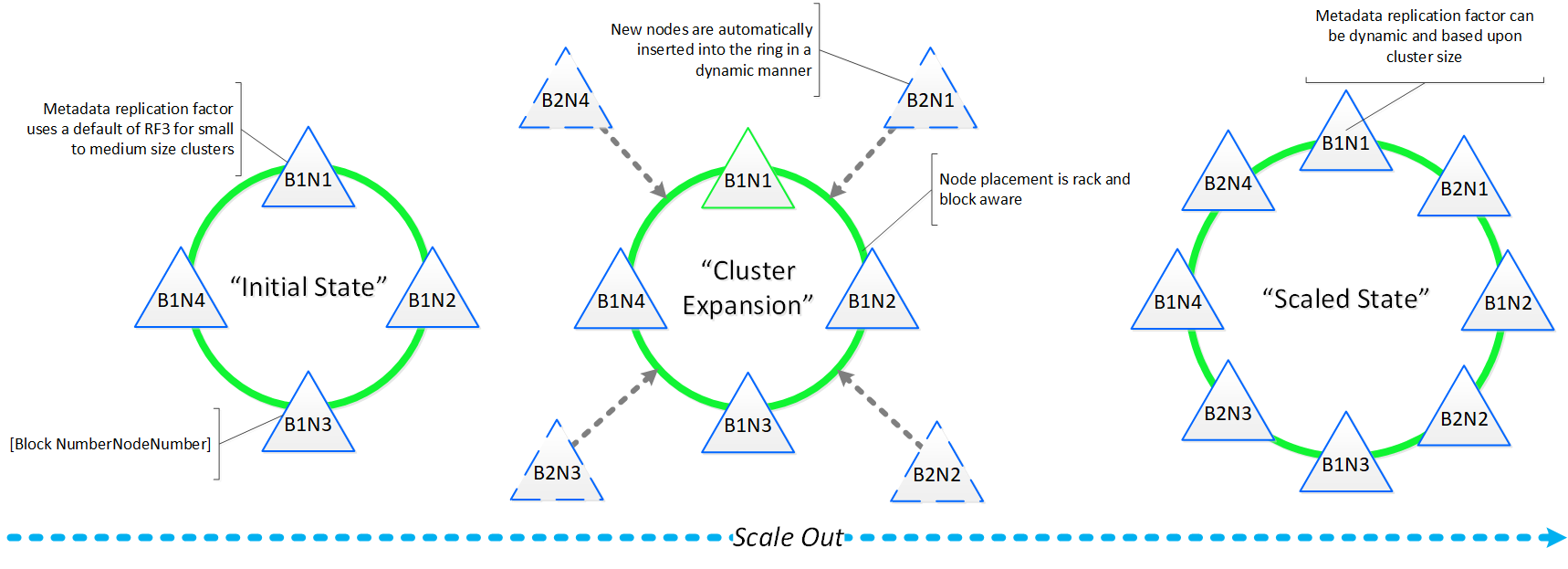

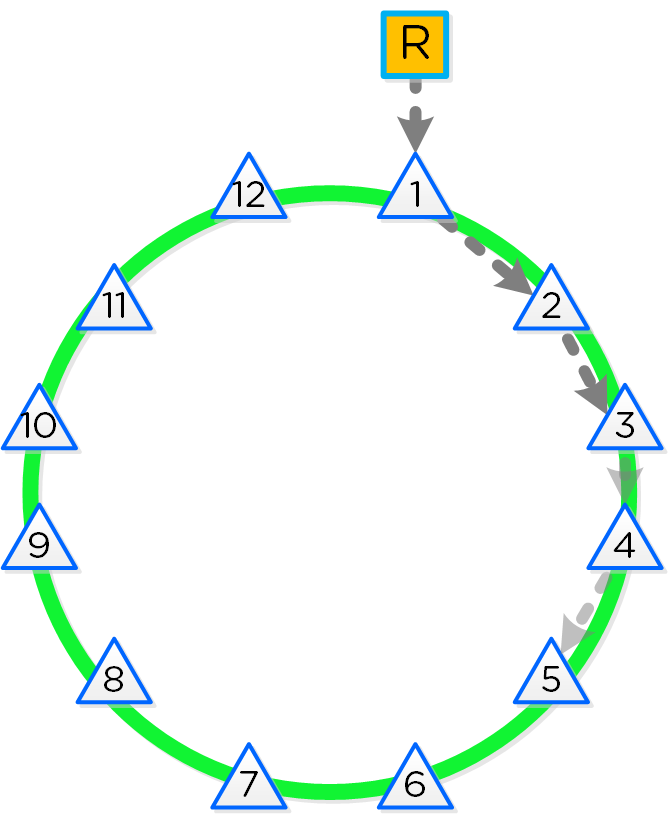

Cassandra

- 主な役割: 分散メタデータ ストア

- 説明: Cassandraは、Apache Cassandraを大幅に改修した分散リング上に全てのクラスタ メタデータをストアして管理を行います。 一貫性を厳格に保つため、Paxosアルゴリズムが使用されています。 そして本サービスは、クラスタ内の全てのノードで稼動します。 Cassandraは、Medusaと呼ばれるインターフェイスを介してアクセスされます。

Zookeeper

- 主な役割: クラスタ構成マネージャー

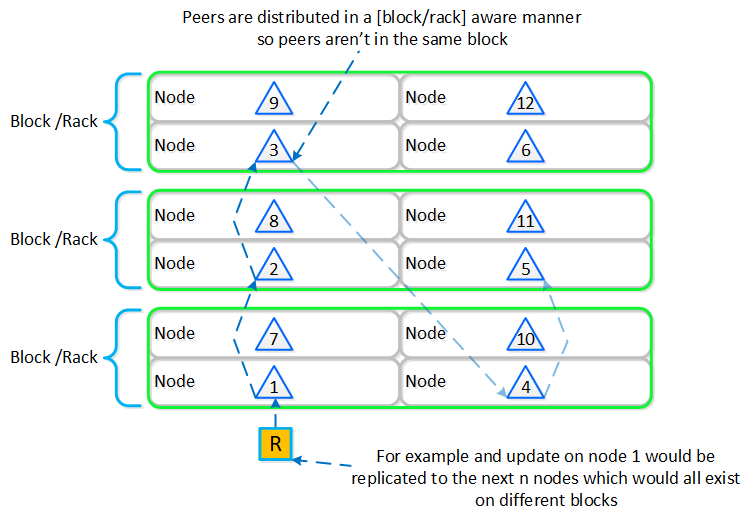

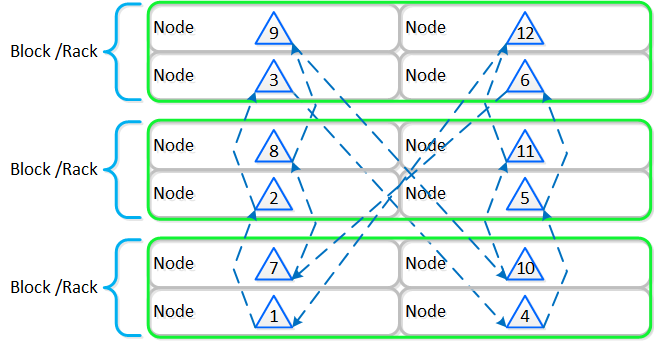

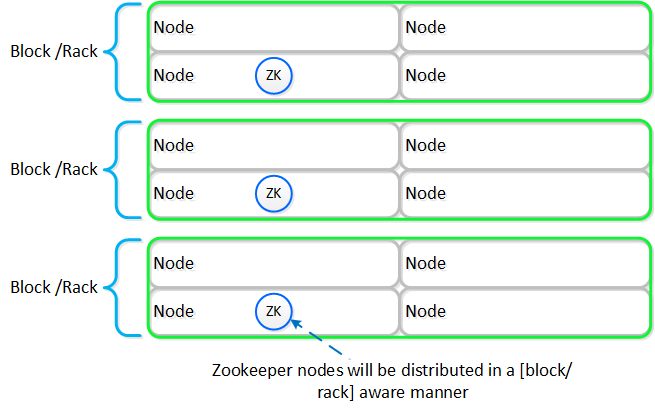

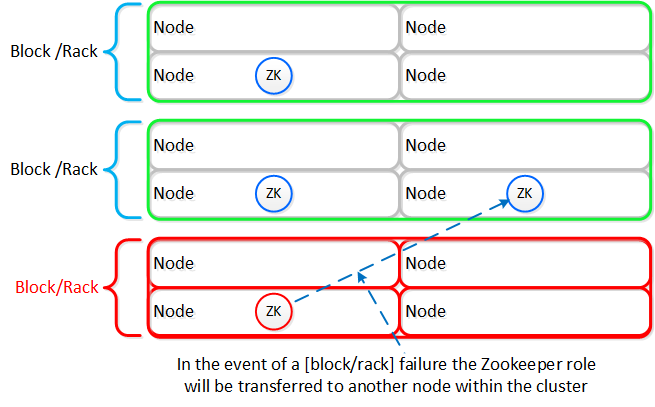

- 説明: Apache ZookeeperをベースにしたZookeeperは、ホスト、IP、状態など全てのクラスタ構成をストアします。 本サービスは、クラスタ内の3つのノードで稼動し、その内の1つがリーダーとして選出されます。 リーダーが全てのリクエストを受信し残りのサービスに転送します。 リーダーからのレスポンスが無い場合、新しいリーダーが自動的に選択されます。 Zookeeperは、Zeusと呼ばれるインターフェイスを介してアクセスされます。

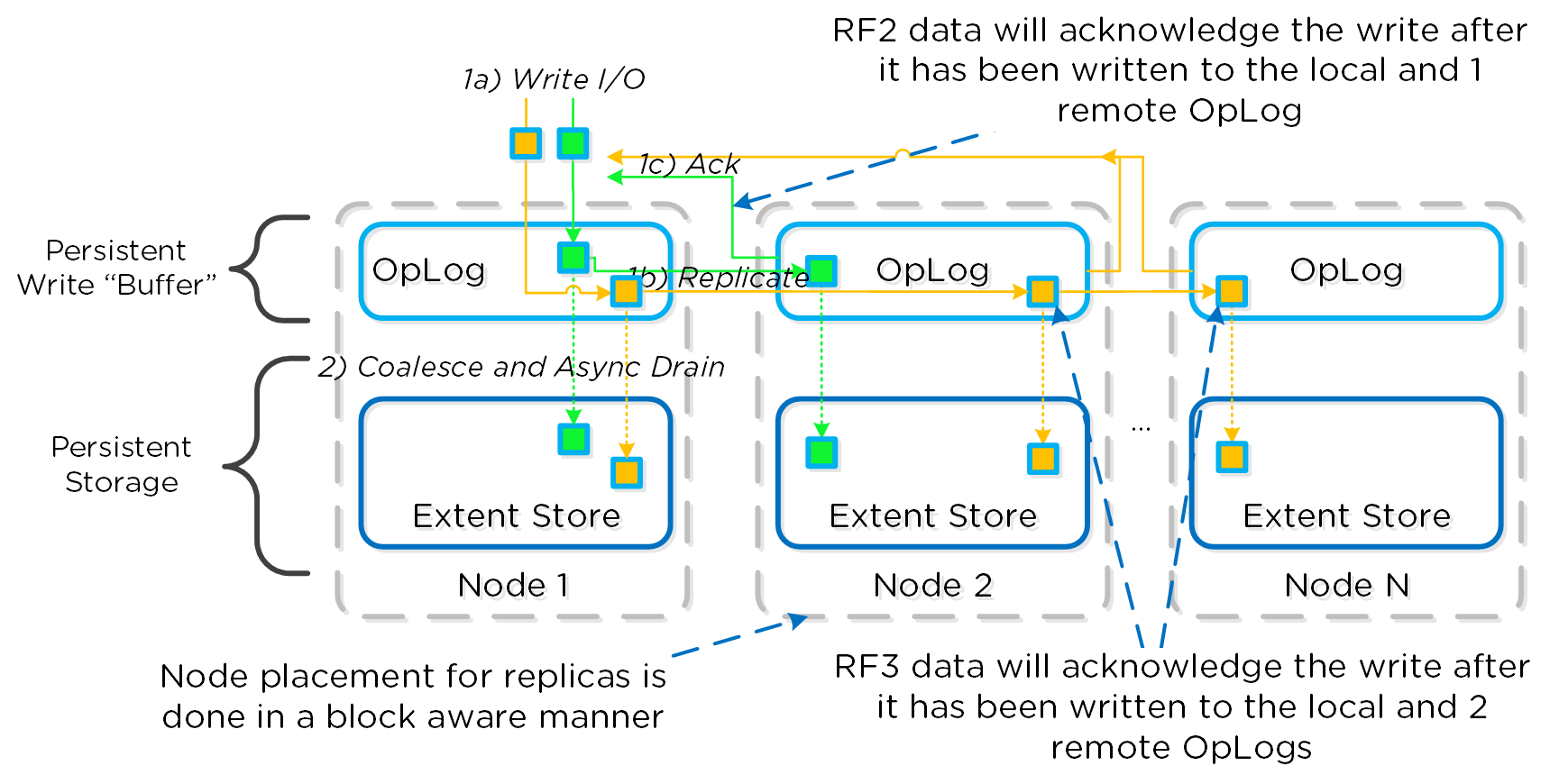

Stargate

- 主な役割: データI/Oマネージャー

- 説明: Stargateは、全てのデータ管理とI/O処理に対応し、ハイパーバイザーからの主なインターフェイス(NFS、iSCSIまたはSMB経由)となります。 該当サービスはクラスタ内の全てのノードで稼動し、ローカルI/Oを処理します。

Curator

- 主な役割: MapReduceクラスタの管理とクリーンアップ

- 説明: Curatorは、クラスタ全体のディスクのバランシング、事前スクラブといった多くのタスクの管理と分散を行います。 Curatorは全てのノードで稼動し、タスクとジョブの委任を行う選択されたCuratorリーダーによってコントロールされます。 Curatorには、6時間毎に行うフルスキャンと、1時間毎に行う部分スキャンという2つのスキャンタイプがあります。

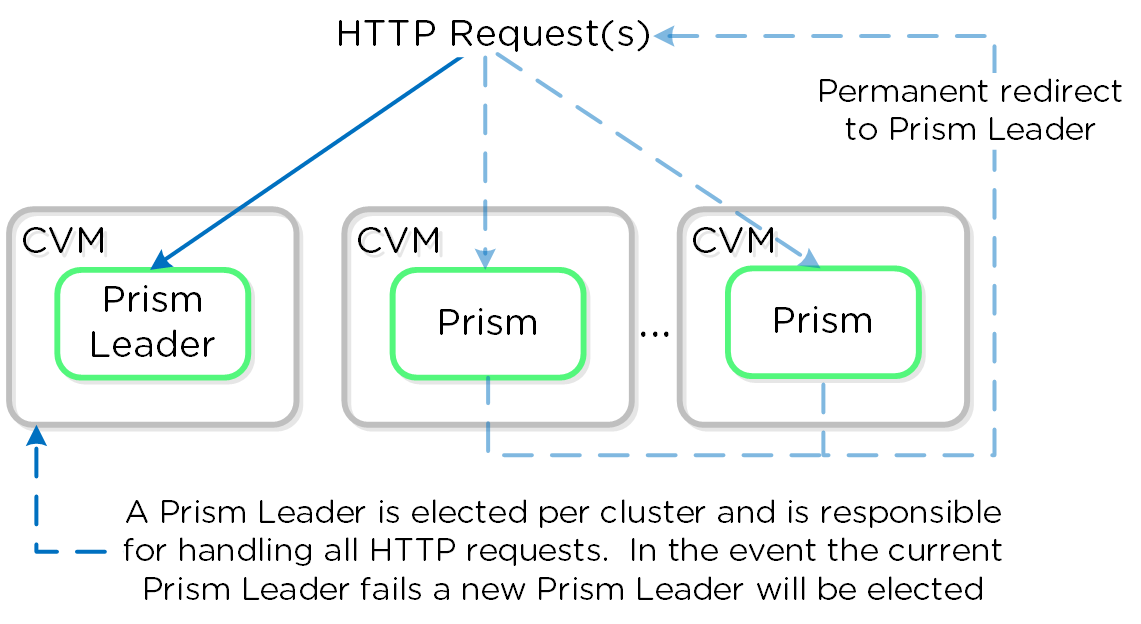

Prism

- 主な役割: UIおよびAPI

- 説明: Prismは、コンポーネントや管理者が、Nutanixクラスタを構成およびモニターするための管理ゲートウェイとしての役割を果たします。 これにはHTML5 UI, nCLI, REST APIが含まれます。 Prismは、全てのノードで稼動し、クラスタ内の全てのコンポーネントと同様に選出されたリーダーを使用します。

Genesis

- 主な役割: クラスタのコンポーネントおよびサービス マネージャー

- 説明: Genesisは全てのノードで稼動するプロセスで、サービスの初期設定と制御(開始、停止など)を行います。 Genesisは、クラスタから独立して稼動するプロセスで、クラスタの構成や稼動を必要としません。 Zookeeperが稼動していることがGenesisの動作要件になります。 cluster_initおよびcluster_statusページは、Genesisプロセスによって表示されます。

Chronos

- 主な役割: ジョブとタスクのスケジューラー

- 説明: Chronosは、Curatorスキャンされたジョブやタスクをノード間で実行するためのスケジューリングや調整を行います。 Chronosは、全てのノードで稼動し、選出されたChronosリーダーによってコントロールされます。 Chronosリーダーはタスクやジョブを委任し、Curatorリーダーと同じノード上で稼働します。

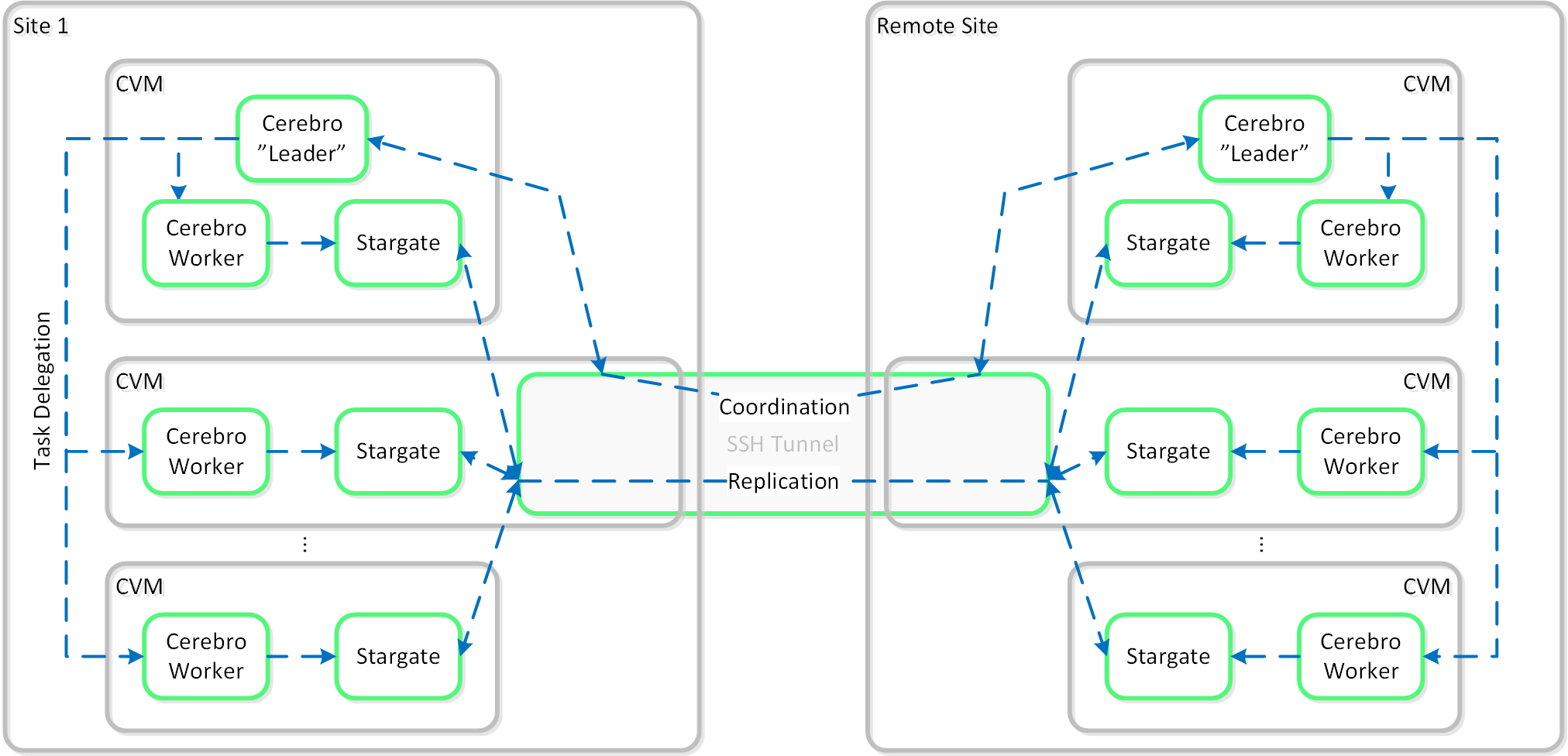

Cerebro

- 主な役割: レプリケーション/DRマネージャー

- 説明: Cerebroは、DSFのレプリケーションとDR機能を担っています。 これには、スナップショットのスケジューリング、リモートサイトへのレプリケーション、サイトの移行、そしてフェイルオーバー機能が含まれています。 CerebroはNutanixクラスタ内の全てのノードとリモート クラスタ/サイトへのレプリケーションに加わる全てのノードで稼動します。

Pithos

- 主な役割: vDisk構成マネージャー

- 説明: Pithosは、vDisk(DSFファイル)の構成データを担っています。Pithosは全てのノードで稼動し、Cassandraの上に構築されます。

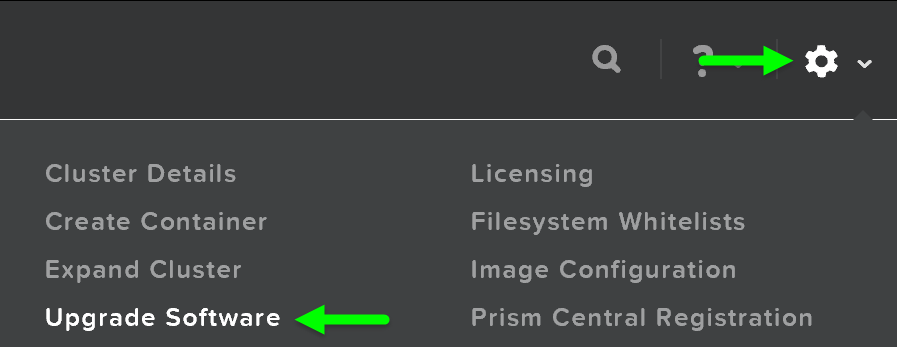

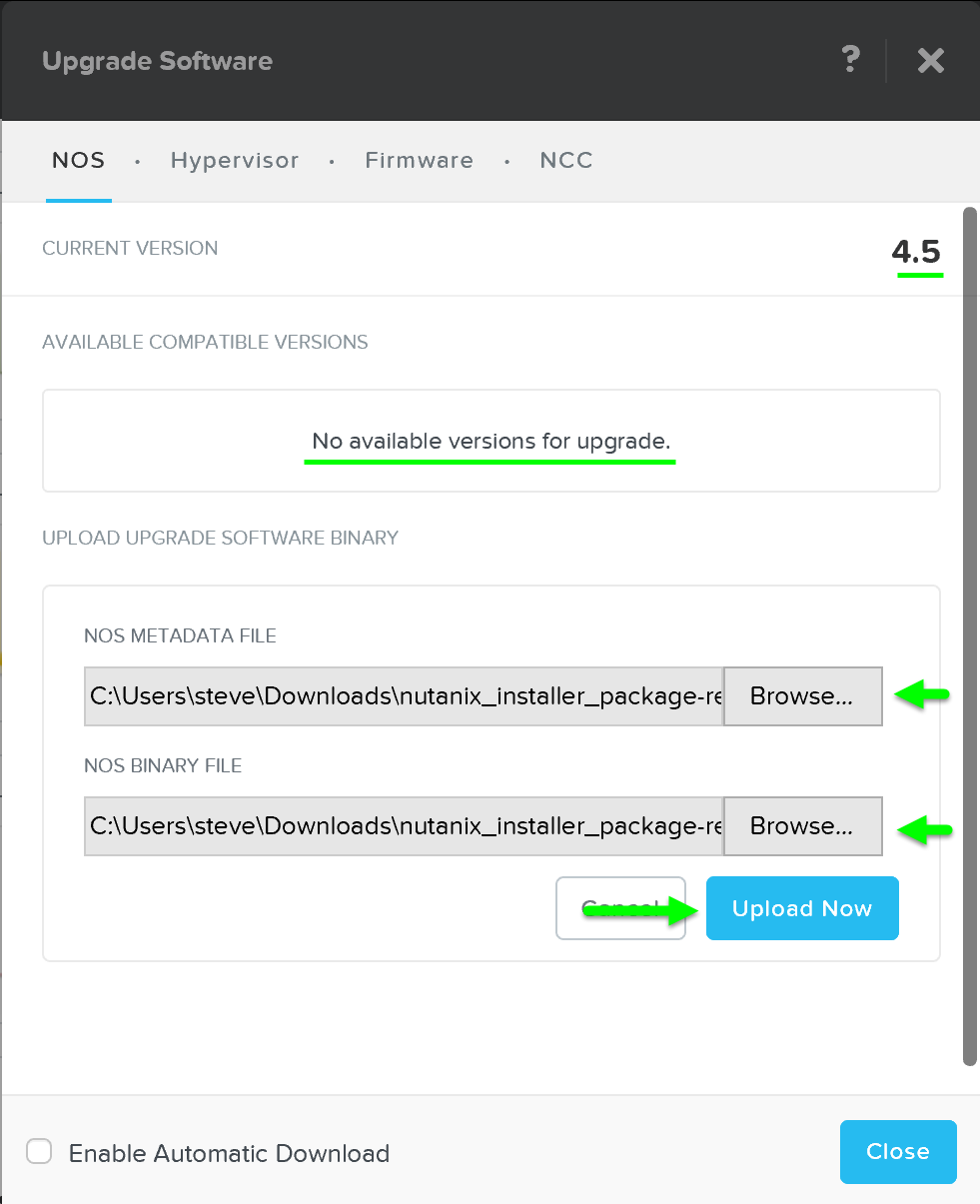

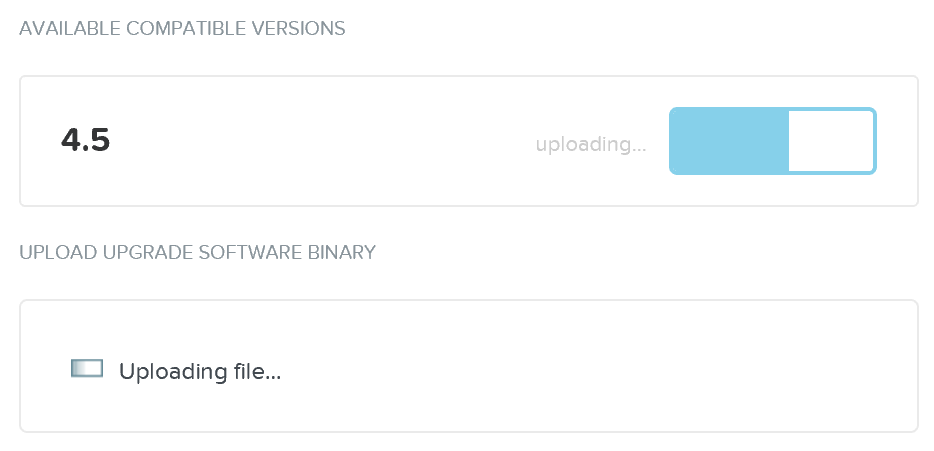

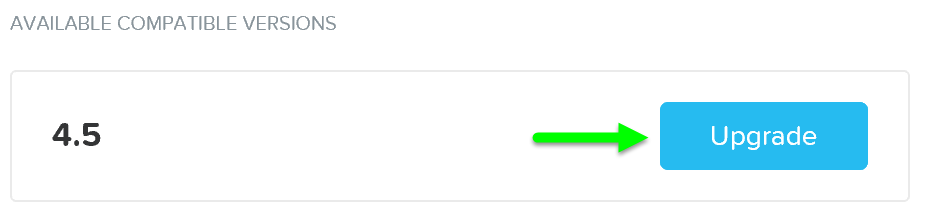

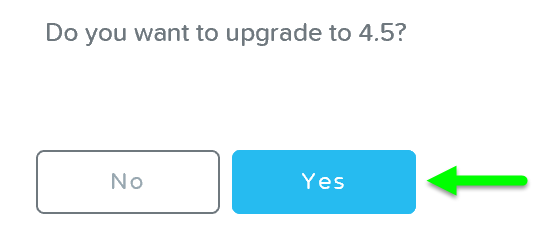

無停止アップグレード

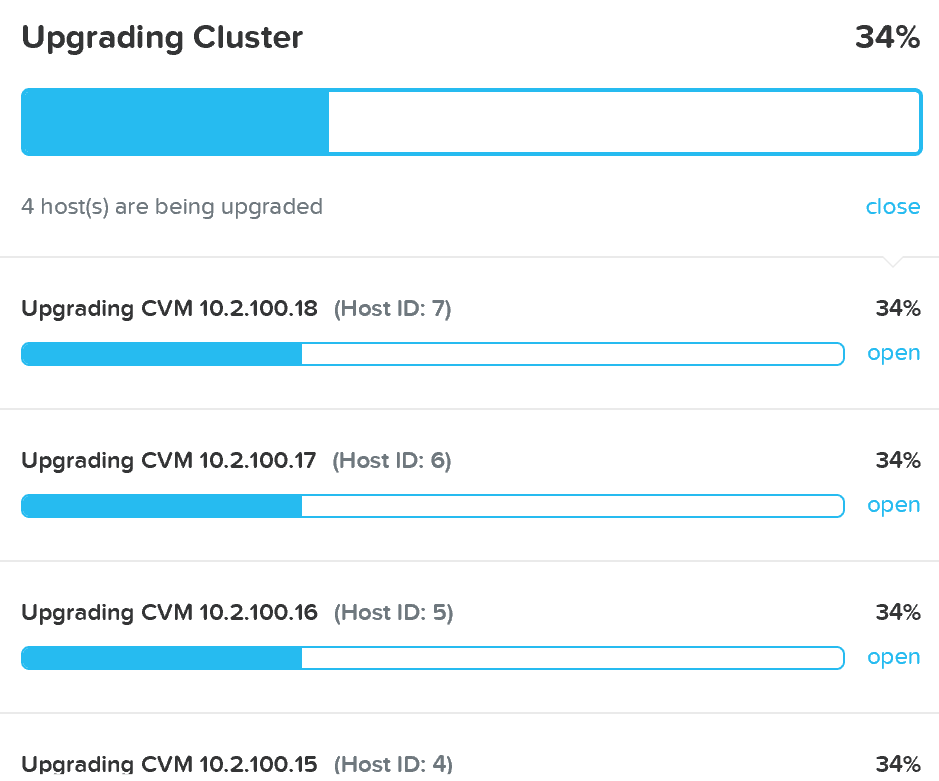

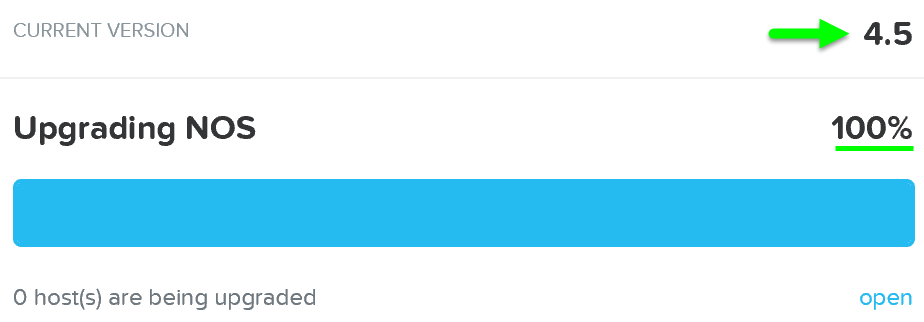

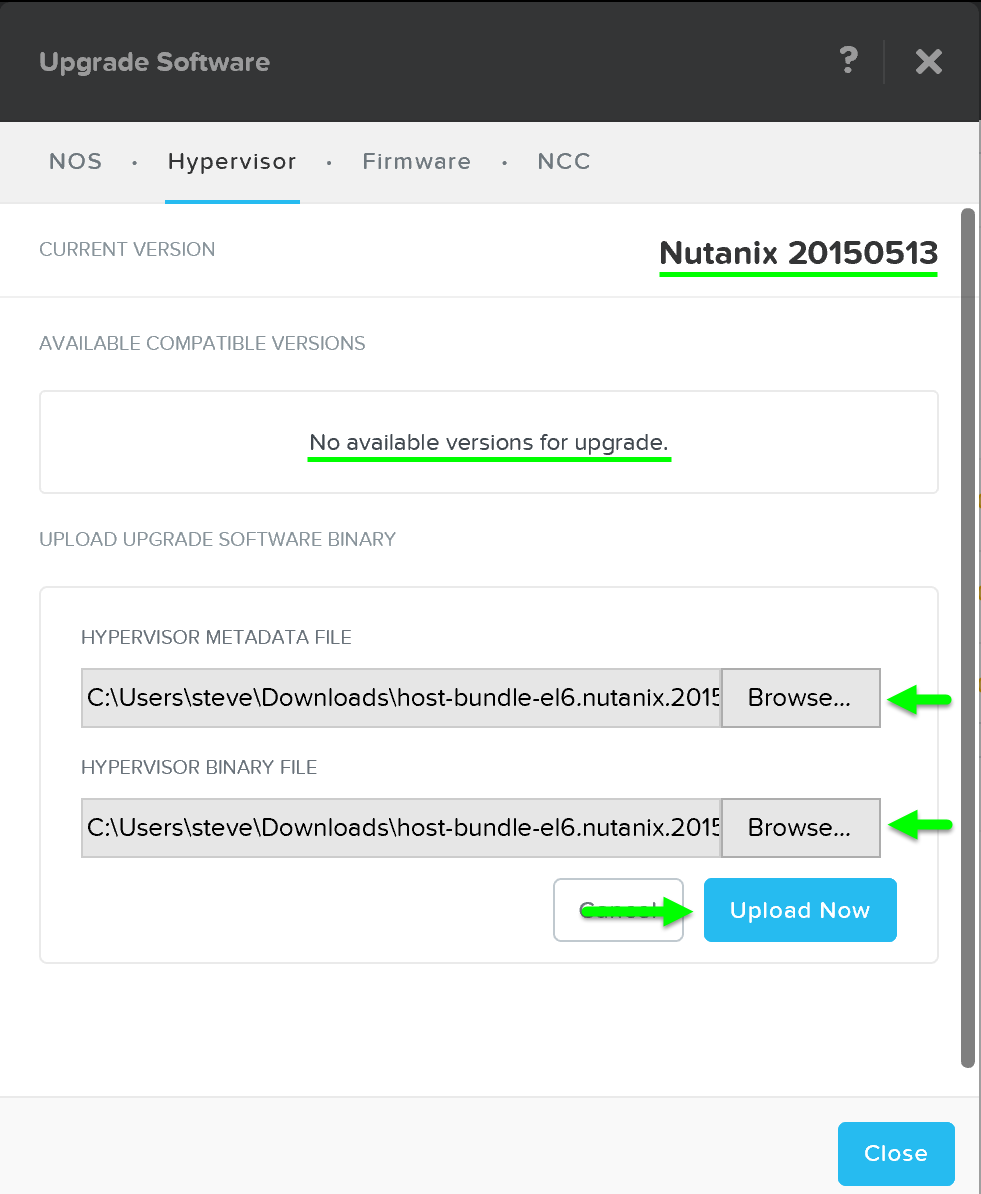

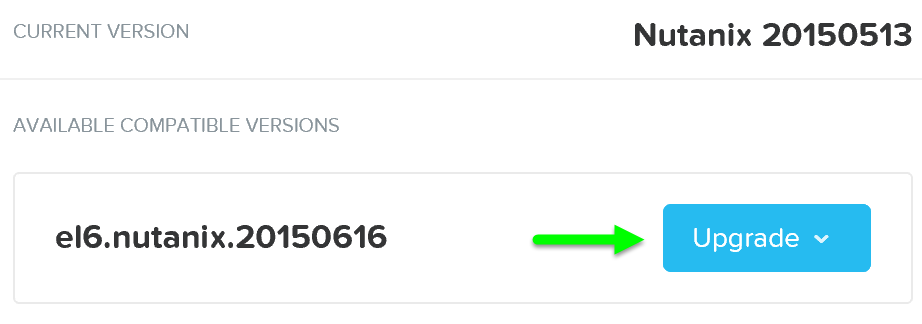

Prismの「Nutanixソフトウェアのアップグレード」および「ハイパーバイザーのアップグレード」セクションで、AOSおよびハイパーバイザーバージョンのアップグレードを実行するために使用される手順を説明しました。 このセクションでは、さまざまなタイプのアップグレードを無停止で実行できるようにする方法について説明します。

AOSのアップグレード

AOSのアップグレードでは、いくつかの核となる手順が実行されます:

1 - アップグレード前のチェック

アップグレード前のチェックでは、以下の項目が確認されます。 注: アップグレードを続行するには、これが正常に完了する必要があります。

- AOSとハイパーバイザーのバージョン互換性を確認する

- クラスタの状態を確認する(クラスタのステータス、空き容量、Medusa、Stargate、Zookeeperなどコンポーネントのチェック)

- すべてのCVMとハイパーバイザー間のネットワーク接続を確認する

2 - アップグレードソフトウェアの2ノードへのアップロード

アップグレード前のチェックが完了すると、システムはアップグレードソフトウェアバイナリをクラスタ内の2ノードにアップロードします。 これは、耐障害性のためであり、1つのCVMが再起動している場合に、他方のCVMからソフトウェアを取得できるようにします。

3 - アップグレードソフトウェアのステージング

ソフトウェアが2つのCVMにアップロードされると、すべてのCVMが並行してアップグレードソフトウェアをステージングします。

CVMには、AOSバージョンのための2つのパーティションがあります:

- アクティブパーティション(現在実行中のバージョン)

- パッシブパーティション(アップグレードがステージングされる場所)

AOSアップグレードは、非アクティブパーティションでアップグレードが実行されます。 アップグレードトークンを受信すると、アップグレードされたパーティションをアクティブパーティションとしてマークし、CVMを再起動してアップグレードされたバージョンにします。 これは、bootbankとaltbootbankに似ています。

注: アップグレードトークンはノード間で反復的に渡されます。 これにより、一度に1つのCVMのみが再起動します。 CVMが再起動して安定すると(サービスの状態と通信を確認して)、すべてのCVMがアップグレードされるまでトークンが次のCVMに渡されます。

アップグレードのエラー処理

よくある質問として、アップグレードが失敗した場合や、プロセスの途中で問題が発生した場合はどうなるか、というものがあります。

アップグレードの問題が発生した場合は、アップグレードを停止して進行しません。 注: アップグレードが実際に開始される前に、アップグレード前のチェックでほとんどの問題が検出されるため、これは非常にまれです。 ただし、アップグレード前のチェックが成功して実際のアップグレード中に問題が発生した場合、クラスタで実行されているワークロードとユーザーのI/Oへの影響はありません。

Nutanixソフトウェアは、サポートされているアップグレードバージョン間の混在モードで無期限に動作するように設計されています。 例えば、クラスタがx.y.fooを実行していて、それをx.y.barにアップグレードしている場合、システムは両方のバージョンのCVMで無期限に実行できます。 これは、実際にアップグレードプロセス中に発生します。

例えば、x.y.fooの4ノードクラスタがあり、x.y.barにアップグレードを開始した場合、最初のノードをアップグレード開始すると、他のノードがx.y.fooである間にx.y.barが実行されます。 このプロセスは続行され、アップグレードトークンを受け取るとCVMはx.y.barで再起動します。

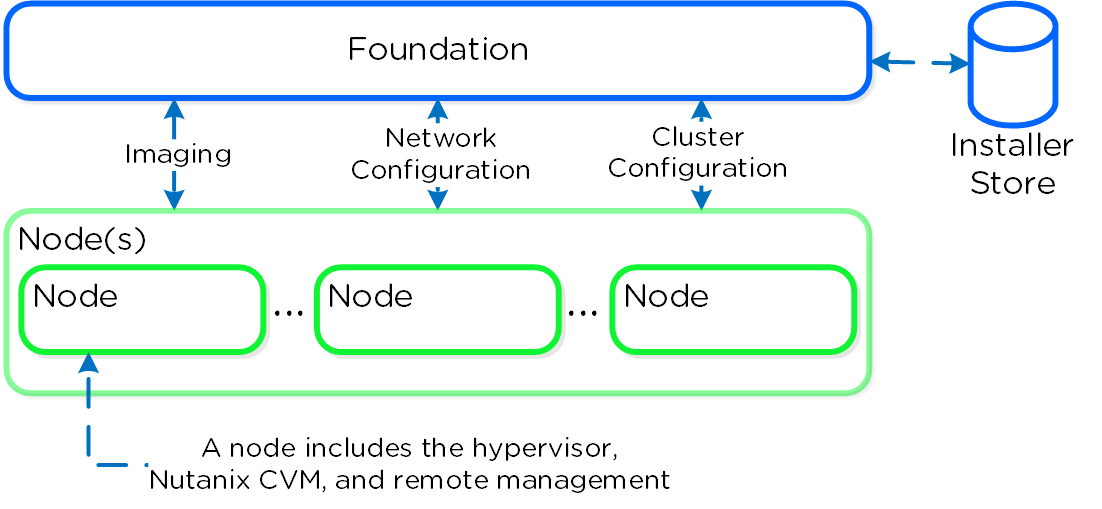

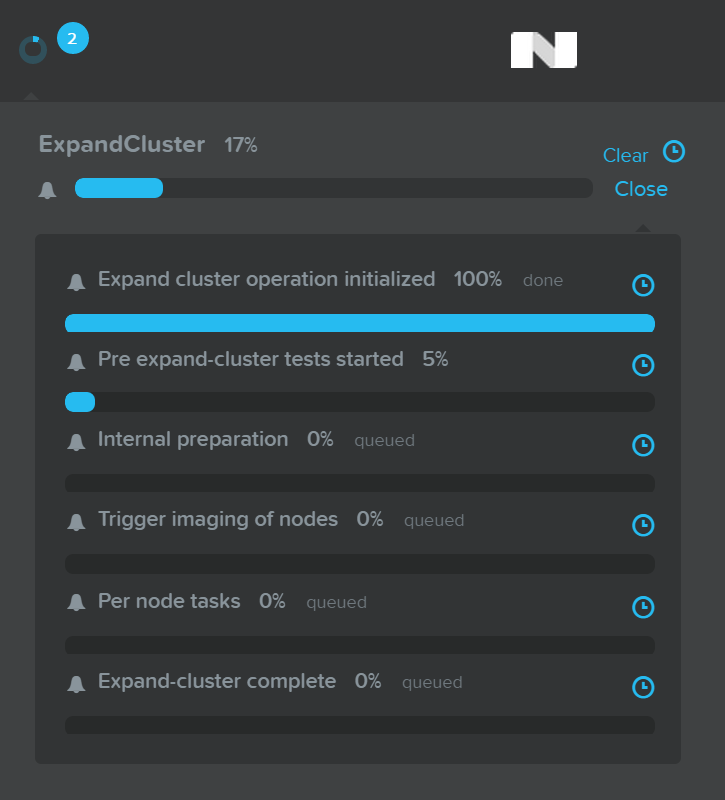

Foundation (イメージング)

Foundationイメージングのアーキテクチャー

Foundation(ファンデーション)は、Nutanixクラスタのブートストラップ、イメージング及び導入のためにNutanixが提供しているツールです。 イメージングプロセスにより、目的とするバージョンに対応するAOSソフトウェアやハイパーバイザーをインストールされます。

Nutanixノードには、デフォルトでAHVがプリインストールされており、異なるハイパーバイザーをインストールするためには、Foundationを使用して、該当ノード上に必要とされるハイパーバイザーを再イメージングする必要があります。

注意: 一部のOEMでは、事前に希望するハイパーバイザーがインストールされた形で出荷を行っています。

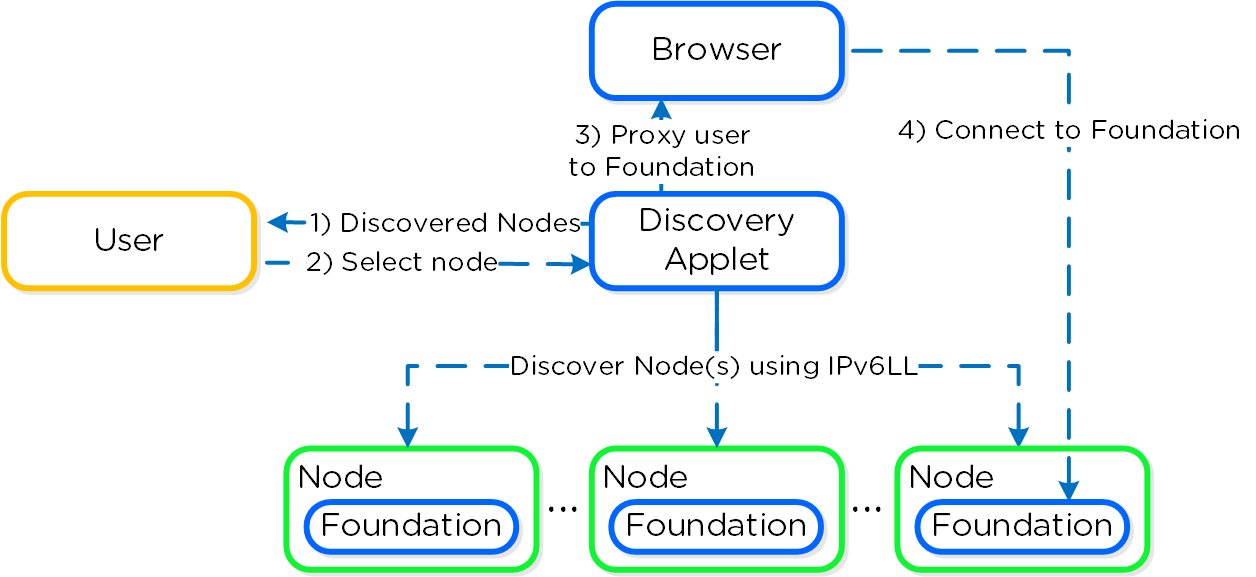

以下に、Foundationのアーキテクチャー概要を示します:

Foundationは、設定を容易にする目的でAOS 4.5からCVMに組み込まれました。 インストーラーの保存領域は、アップロードイメージを格納するためのディレクトリであり、初期のイメージングに加え、イメージングが必要になるクラスタ拡張でも使用されます。

Foundationディスカバリ アプレット(こちらからダウンロードできます)は、ノードをディスカバリしてユーザーが接続するノードを選択できるようにします。 ユーザーが接続ノードを選択すると、アプレットは localhost:9442のIPv4アクセスを、CVMのIPv6リンクローカルアドレスのポート8000にプロキシします。

以下にアプレットアーキテクチャーの概要を示します:

注意: ディスカバリアプレットは、ディスカバリやノード上で稼動するFoundationサービスにプロキシする1つの手段に過ぎません。 実際のイメージングやコンフィグレーションは、Foundationサービスが行うもので、アプレットではありません。

プロからのヒント

ターゲットとなるNutanixノードとは異なる(L2)ネットワークを使用している(WAN経由など)場合はディスカバリアプレットが使用できません。 しかしCVMにIPv4アドレスが割り当てられていれば、(ディスカバリアプレットを使わずに)直接Foundationサービスに接続することができます。

直接接続する際には、 <CVM_IP>:8000/gui/index.htmlをブラウズします

インプット

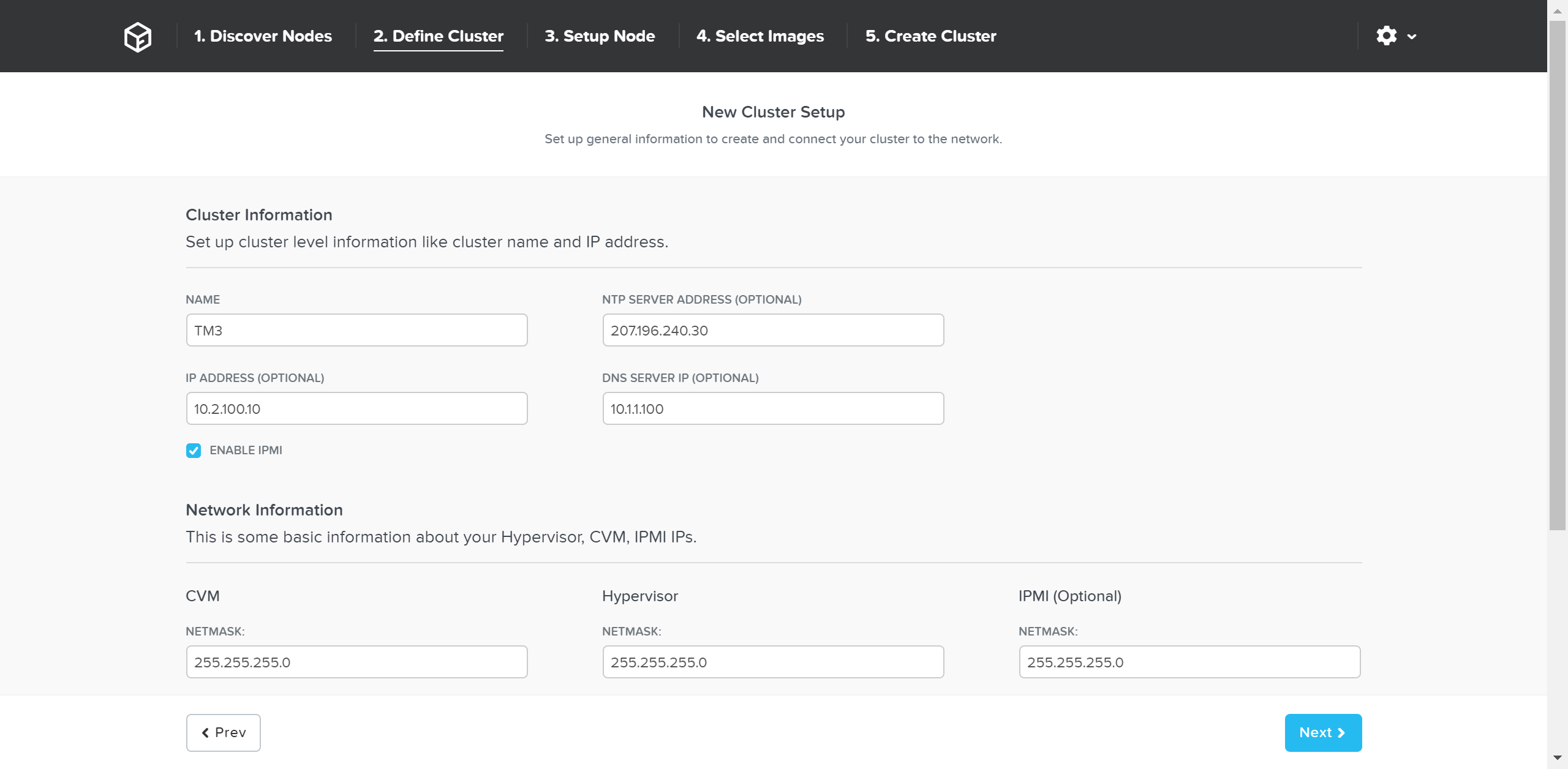

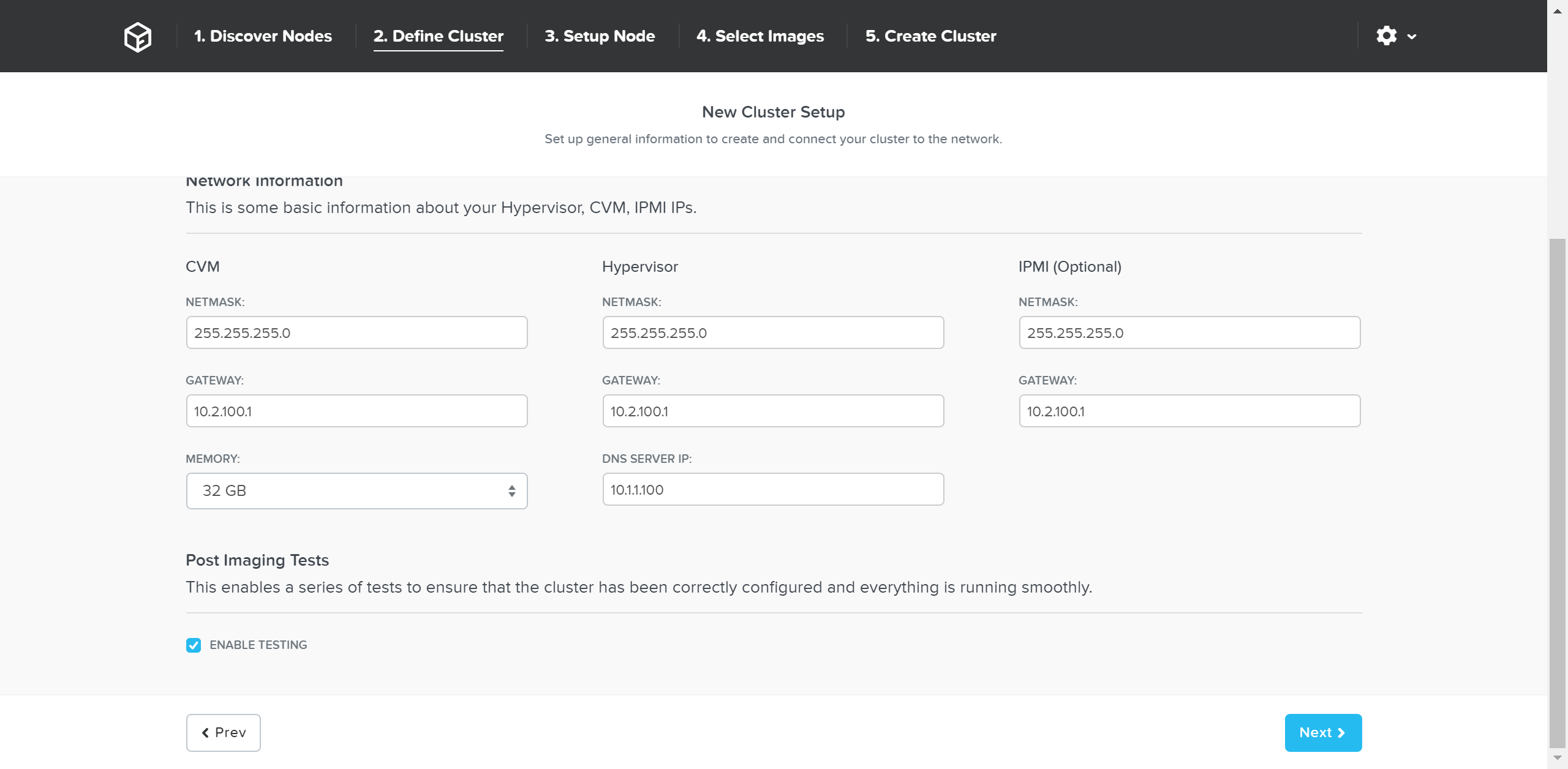

Foundationには、以下の入力設定があります。 典型的な導入例では、1ノードあたり3つのIP(ハイパーバイザー、CVM、リモート管理(IPMI、iDRACなど))が必要となります。 さらに、各ノードに対し、クラスタとデータサービスIPアドレスを設定することを推奨します。

- クラスタ

- クラスタ名

- IP*

- NTP*

- DNS*

- CVM

- CVM毎のIP

- Netmask

- Gateway

- メモリ

- ハイパーバイザー

- ハイパーバイザーホスト毎のIP

- Netmask

- Gateway

- DNS*

- ホスト名のプリフィックス

- IPMI*

- ノード毎のIP

- Netmask

- Gateway

注意: (*) が付いた項目はオプションですが、設定することを強く推奨します

システムのイメージングと導入

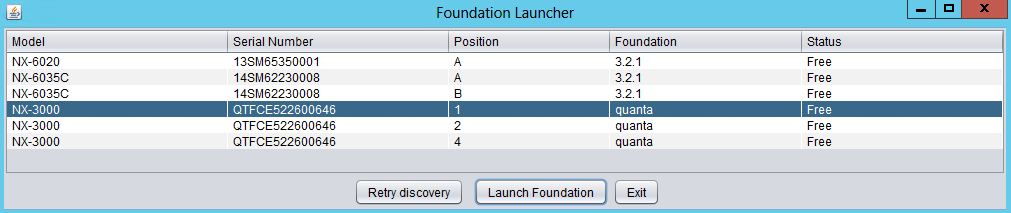

最初に、ディスカバリアプレット経由で、FoundationUIに接続します。(同じL2にあればノードIPの入力などは不要です)

目的とするノードが見つからない場合は、同じL2ネットワーク上に存在するかどうかを確認してください。

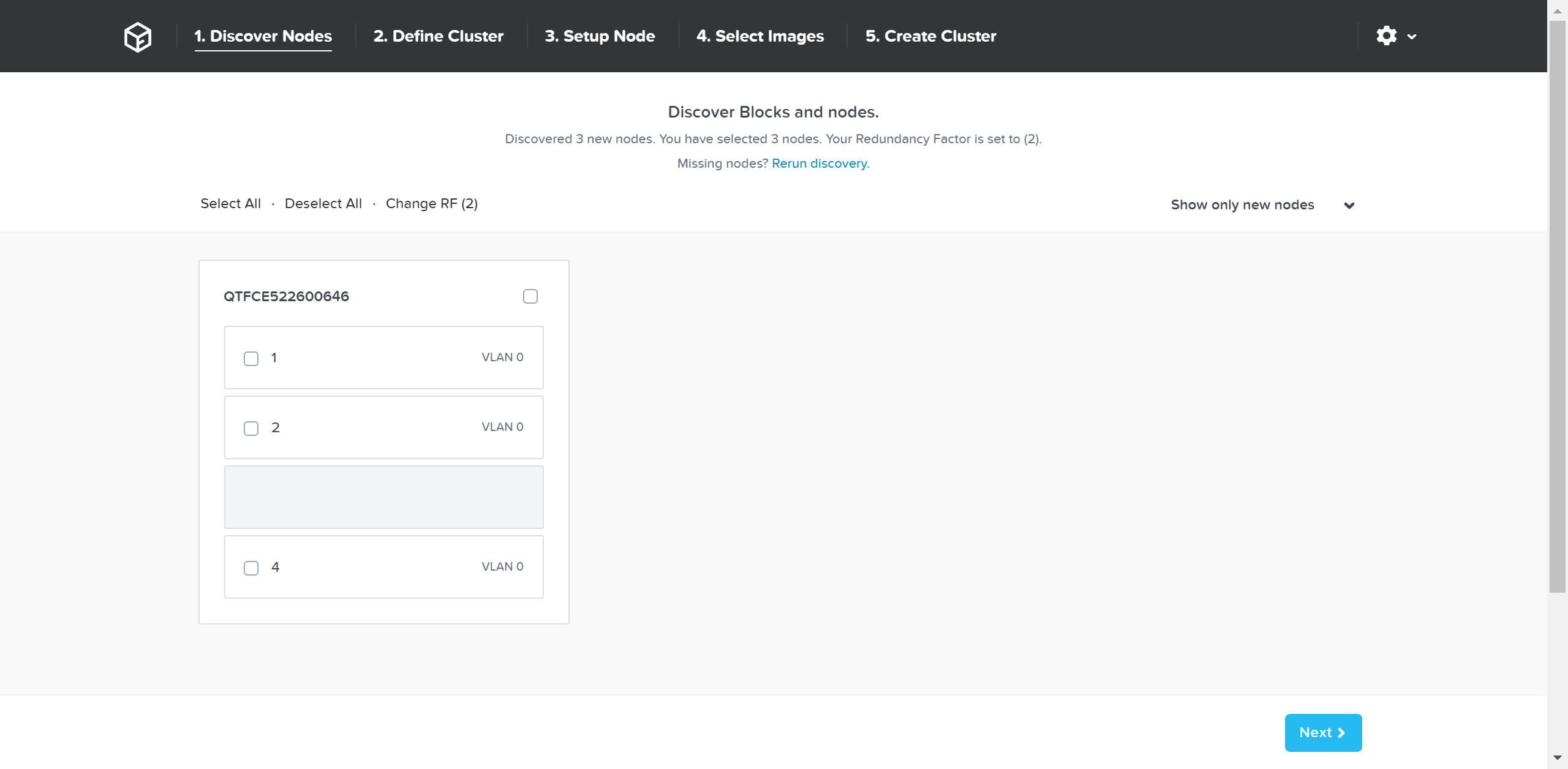

選択したノードのFoundationインスタンスに接続すると、FoundationUIが表示されます:

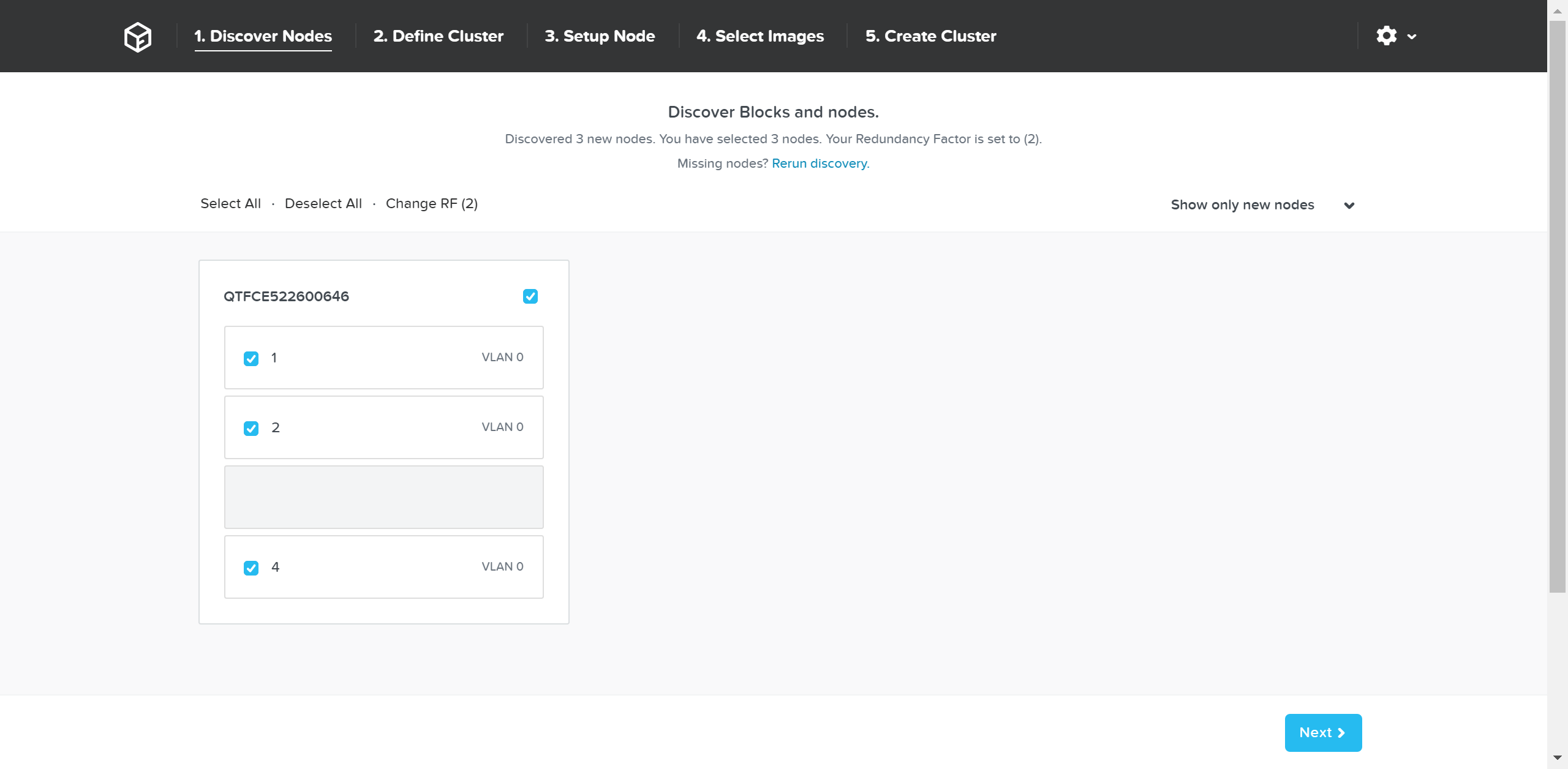

ここでは、検出した全てのノードとシャーシが表示されます。 必要なノードをクラスタから選択し「Next(次へ)」をクリックします。

次のページで、クラスタとネットワーク情報を入力します:

詳細の入力が完了したら「Next(次へ)」をクリックします。

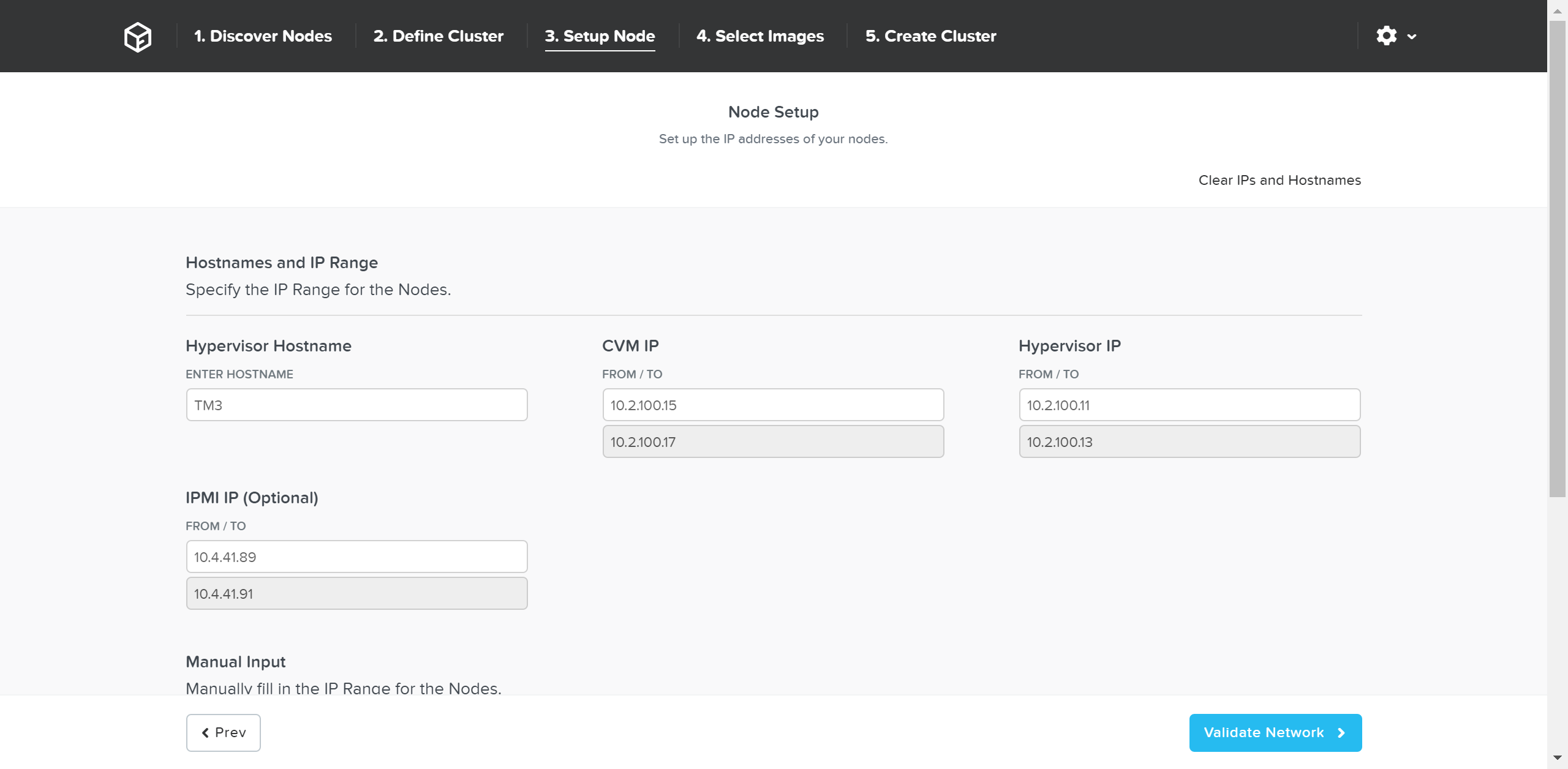

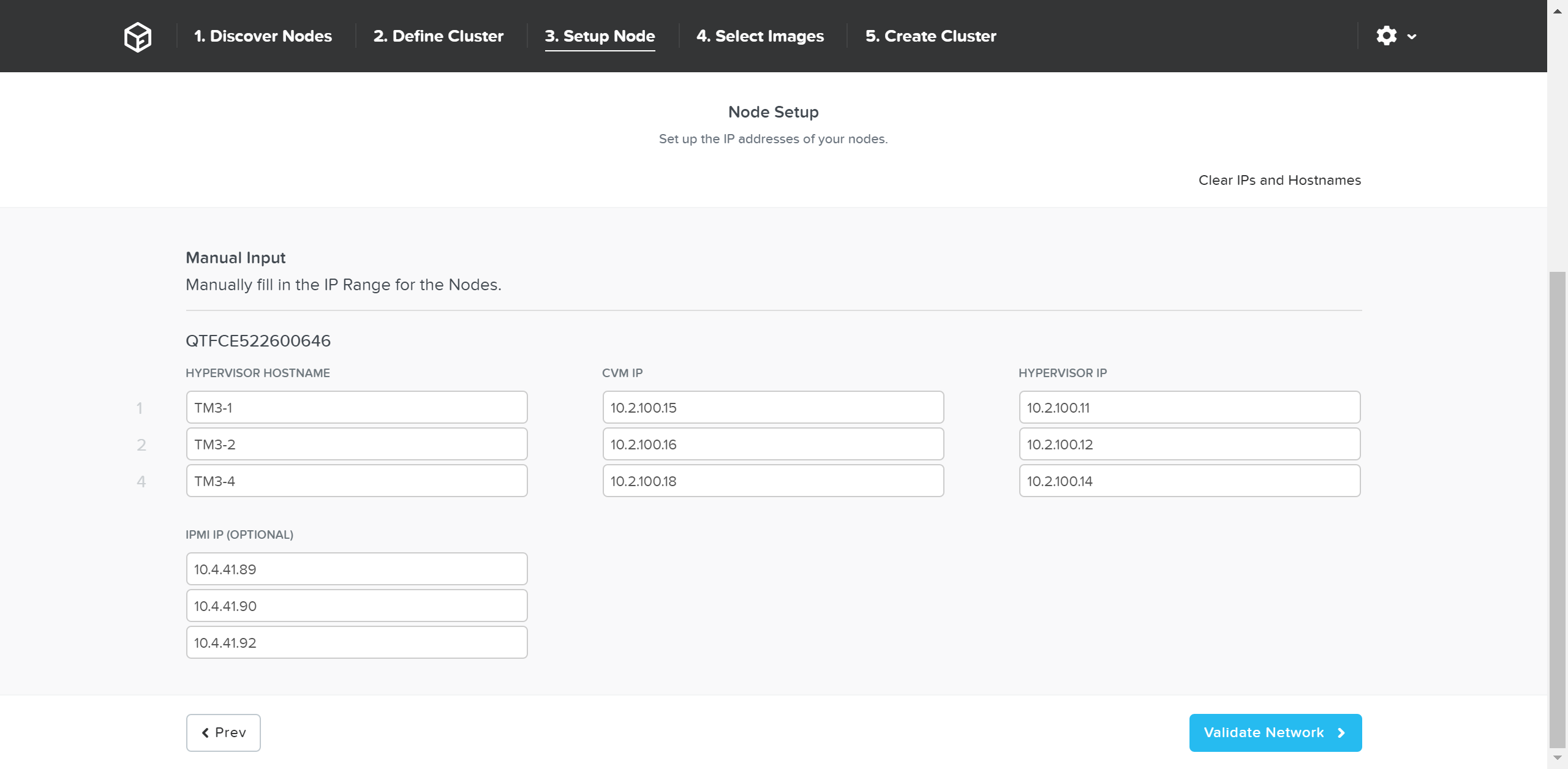

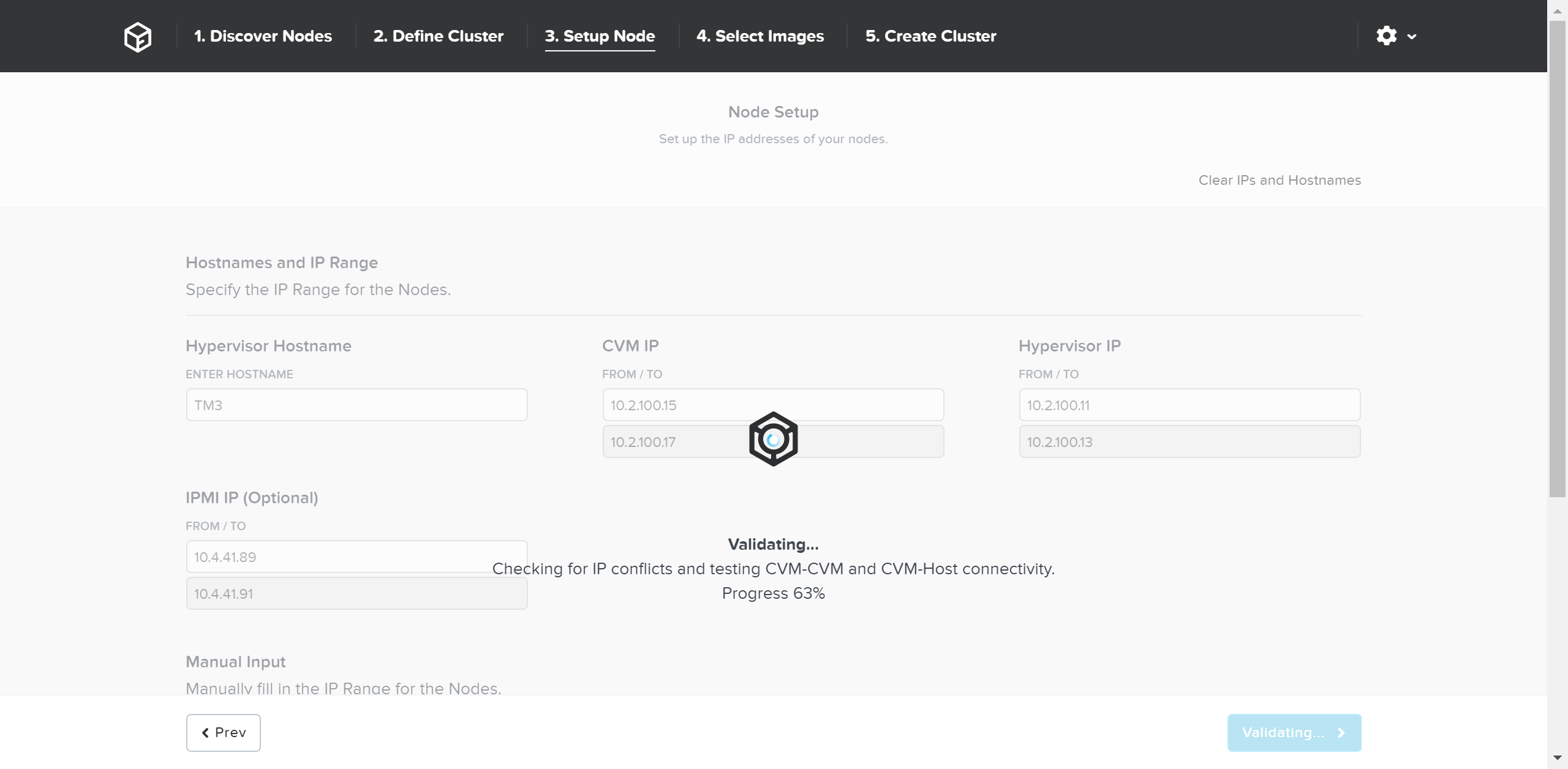

次のページで、ノードの詳細とIPアドレスを入力します:

必要に応じてホスト名とIPアドレスを上書きします:

「Validate Network(ネットワークの検証)」をクリックし、ネットワーク設定を確認して次に進みます。 ここでは、IPアドレスに重複がないかを検証し、接続性を確認します。

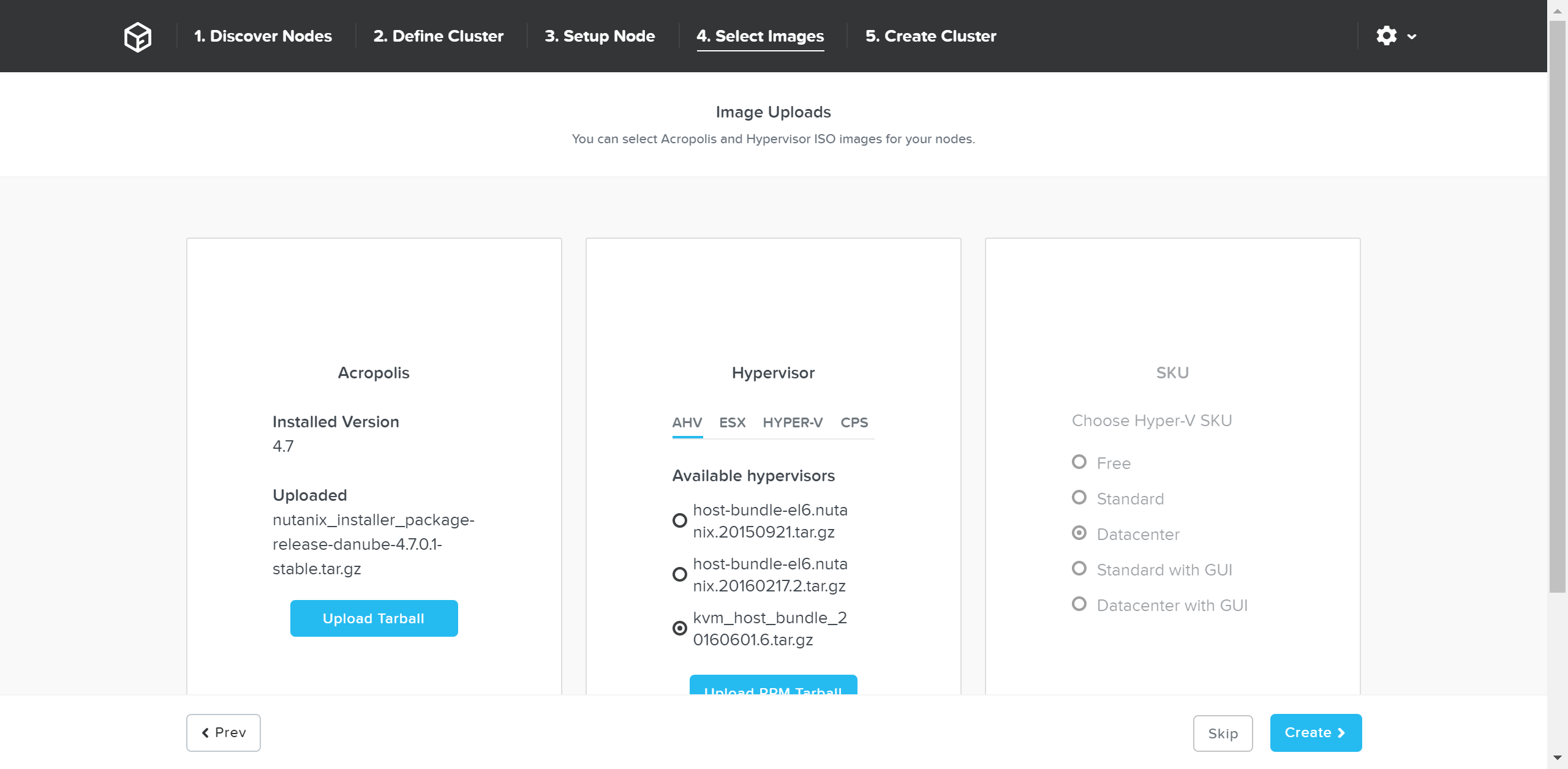

ネットワークの検証が正常に終了したら、次に必要なインストーラーイメージを選択します。

CVM上の現状のAOSを新しいバージョンにアップグレードするためには、ポータルからダウンロードし、tarball(.tar.gz ファイル)をアップロードします。 必要なAOSイメージを入手したらハイパーバイザーを選択します。

AHVの場合、そのイメージはAOSイメージに含まれています。 その他のハイパーバイザーの場合には、必要なハイパーバイザーのインストーラーイメージをアップロードする必要があります。

注意: AOSとハイパーバイザーのバージョンの組み合わせが、互換表 (リンク) に掲載されたものであることを確認してください。

必要なイメージが揃ったら、「Create(作成)」をクリックします:

イメージングが不要な場合、「Skip(スキップ)」をクリックすれば、イメージング工程を省略することができます。これによってハイパーバイザーあるいはNutanixクラスタが再イメージされることはありませんが、クラスタの設定(IPアドレスなど)は必要です。

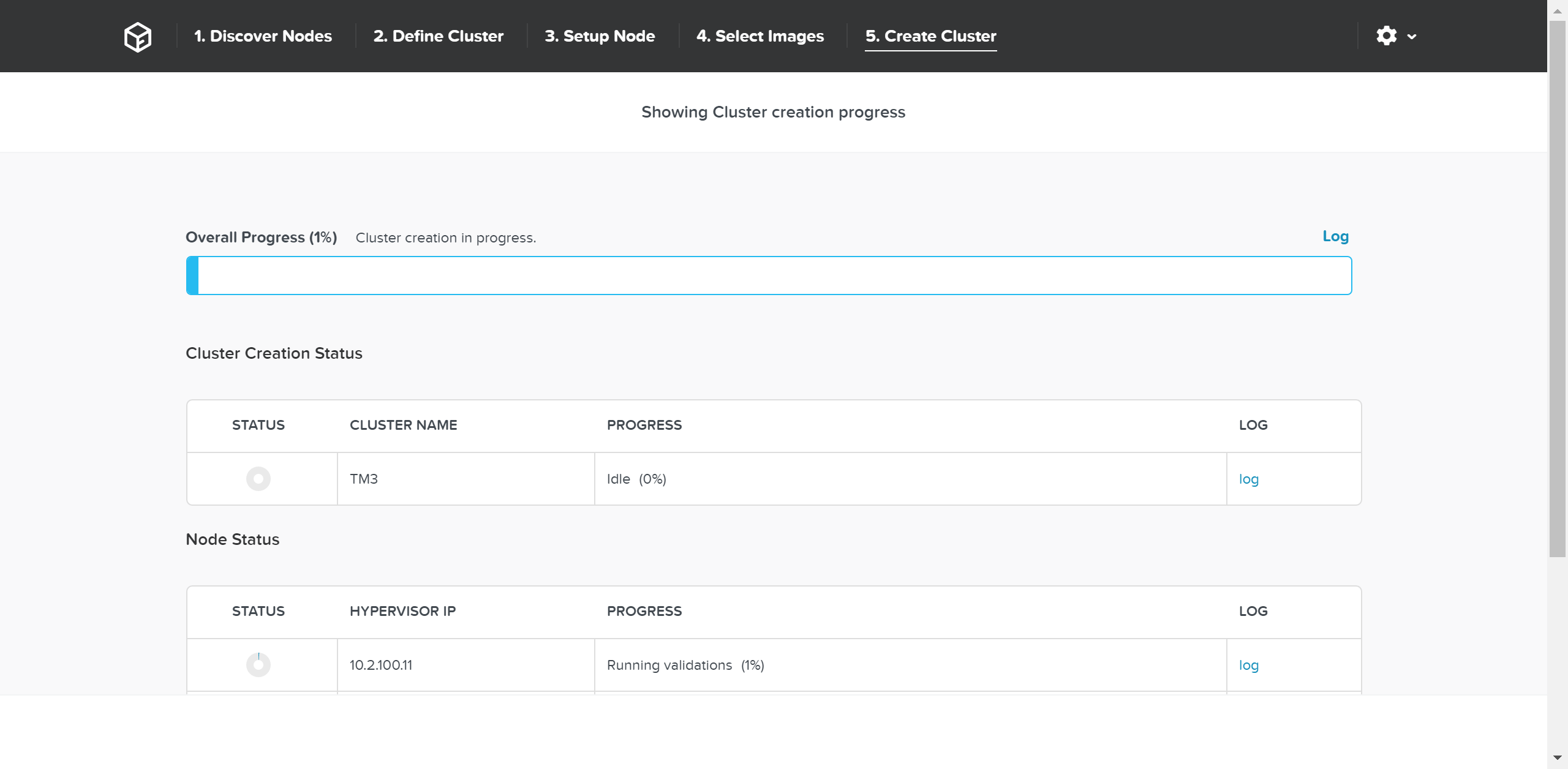

次にFoundationは(必要に応じて)イメージングを行い、クラスタ作成プロセスに進みます。

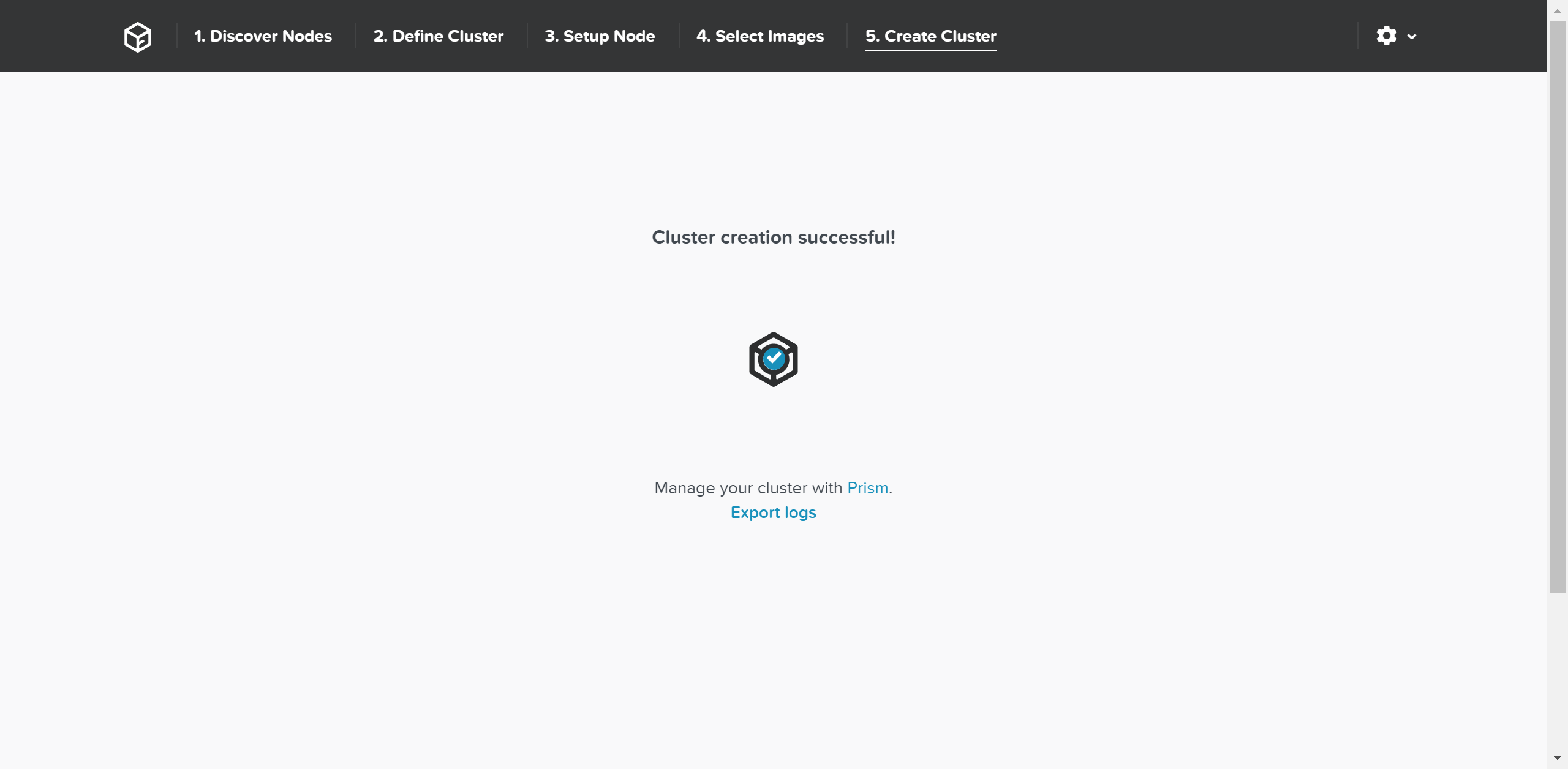

作成が成功すると、完了スクリーンが表示されます:

これでCVMまたはクラスタIPにログインし、Nutanixプラットフォームを利用できるようになりました!

ドライブの分割

本セクションでは、様々なストレージデバイス(パフォーマンス - NVMe/SSD、キャパシティ - SSD/HDD)がどのように分割および、パーティショニングされ、Nutanixプラットフォームで利用されるかを説明します。

注意: 説明で使用されているキャパシティは、10進法のギガバイト (GB) ではなく、すべて2進法のギガバイト (GiB) を使って表現されています。 また、ファイルシステムのためのドライブのフォーマッティングや、関連するオーバーヘッドも考慮に入れた値になっています。

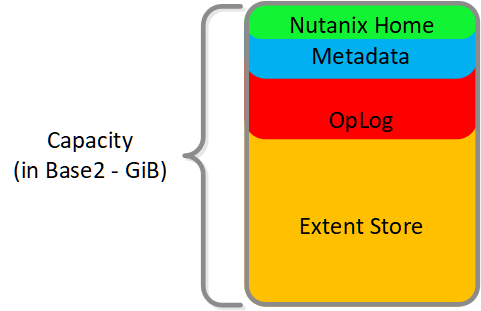

パフォーマンス ディスク デバイス

パフォーマンス ディスク デバイスは、ノードで最もパフォーマンスの高いデバイスです。 これらは、NVMe、またはNVMeとSSDデバイスの混合で構成できます。 重要なものは、以下のように格納されます:

- Nutanix Home(CVMコア)

- メタデータ(Cassandra / AESストレージ)

- OpLog(永続的書き込みバッファ)

- エクステントストア(永続的ストレージ)

以下に示す図は、Nutanixノードのパフォーマンスデバイスの分割例です:

図の大きさは、実際の値の大きさと一致しているわけではありません。 残りの(Remaining)GiBキャパシティは、上から下方向に数値を計算していった残りで見積ります。 例えば、OpLogで使用可能な残りのGiBを計算する場合は、フォーマット済みSSDのキャパシティから、Nutanix HomeとCassandraのキャパシティを差し引いた値になります。

Nutanix Homeは可用性確保のため最初の2つのSSDにミラーされ、そして2つのデバイスに60GiBを予約します。

AOS 5.0の場合、Cassandraは、各ノードのSSD間(現在、最大4つまで)で、1つのSSDあたり15GiBの初期予約領域(メタデータの容量が増加した場合、一部のStargate SSDを使用可能)と一緒に共有されます。 デュアルSSDシステムの場合、メタデータはSSD間でミラーされます。 SSDあたりのメタデータ予約領域は15GiBとなります(デュアルSSDは30GiB、4つ以上のSSDの場合は60GiB)。

AOS 5.0より前は、Cassandraはデフォルトで最初のSSDにあり、そのSSDに障害発生した場合はCVMが再起動されてCassandraストレージは2番目にあるものになります。 この場合のSSDあたりのメタデータ予約は、最初の2つのデバイスでは30 GiBです。

OpLogはすべてのSSDデバイスに分散され、1ノードあたり最大12までとなります (Gflag: max_ssds_for_oplog)。 NVMe デバイスが使用可能な場合、OpLogはSATA SSDではなくそちら(NVMe デバイス)に配置されます。

ディスクあたりのOpLog予約は、次の式を使用して計算できます:

- MIN(((Max cluster RF/2)*400 GiB)/ numDevForOplog), ((Max cluster RF/2)*25%) x Remaining GiB)

注意: リリース 4.0.1から、OpLogのサイズが動的に決定されるようになり、エクステントストアも動的に拡張されるようになりました。 ここで示す値は、OpLogが完全に使用されている状況を前提としています。

例えば、1TBのSSDデバイスが8つあるRF2(FT1)クラスタの結果は次のようになります:

- MIN(((2/2)*400 GiB)/ 8), ((2/2)*25%) x ~900GiB) == MIN(50, 225) == デバイスごとにOplogのために50GiB予約

RF3(FT2)クラスタでは下記のようになります:

- MIN(((3/2)*400 GiB)/ 8), ((3/2)*25%) x ~900GiB) == MIN(75, 337) == デバイスごとにOplogのために75GiB予約

1TBの4つのNVMeデバイスと8つのSSDデバイスによるRF2(FT1)クラスタの場合、結果は下記のようになります:

- MIN(((2/2)*400 GiB)/ 4), ((2/2)*25%) x ~900GiB) == MIN(100, 225) == デバイスごとにOplogのために100GiB予約

エクステントストアの容量は、他のすべての予約が計算された後の残り容量になります。

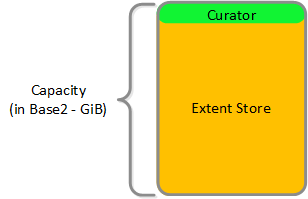

HDDデバイス

HDDデバイスは、基本的に大容量ストレージとして利用されるため、その分割はよりシンプルになります:

- Curator予約領域(Curatorストレージ)

- エクステントストア(永続的ストレージ)

Compute

AHV

AHVはNutanixのネイティブハイパーバイザーであり、CentOS KVMを基盤としています。 その基本機能を拡張し、HA、ライブマイグレーション、IPアドレス管理などの機能を追加しています。

AHVはMicrosoft Server Virtualization Validation Programの一環として認証されており、MicrosoftのOSやアプリケーションの実行が認証されています。

本書では、AHVのアーキテクチャーと機能について説明します。

チャプター

- AHVのアーキテクチャー

- Nutanix AHVの動作の仕組み

- AHVのアドミニストレーション

AHVのアーキテクチャー

AHVのノード アーキテクチャー

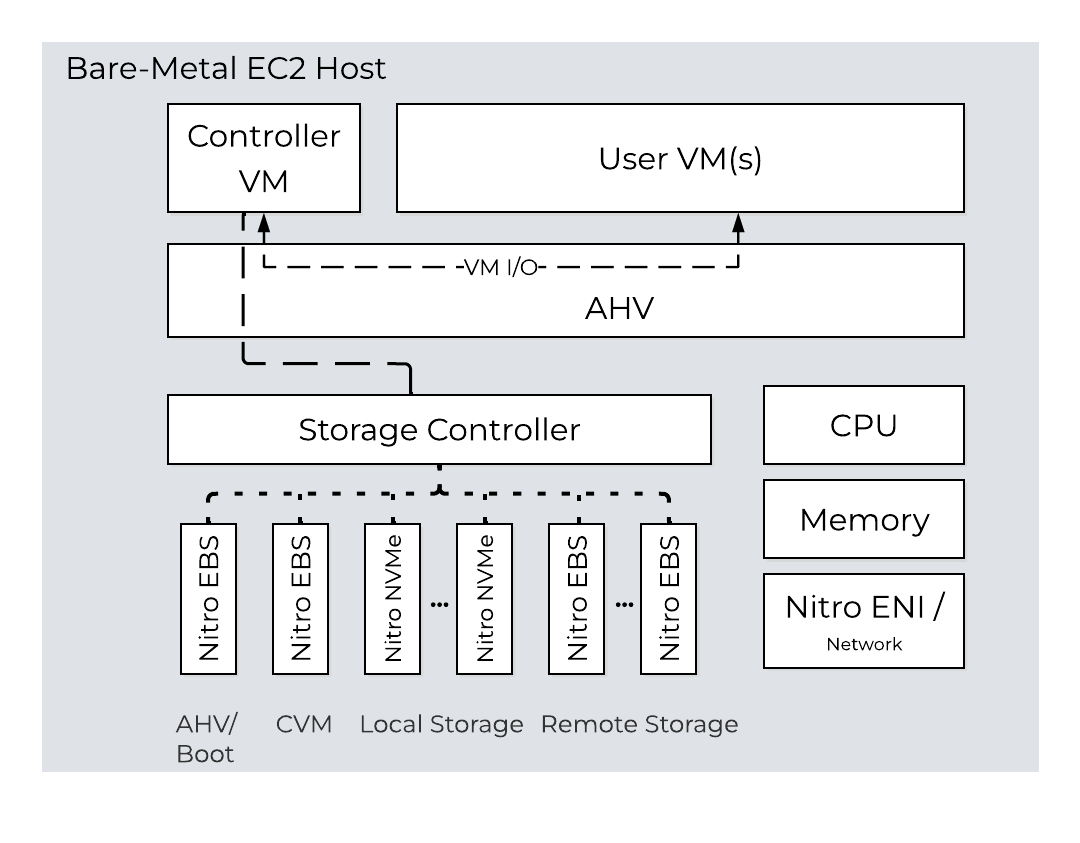

AHVを導入した場合、コントローラーVM(CVM)はひとつのVMとして稼動し、ディスクはPCIパススルーを使用するようになります。 これにより、PCIコントローラー(および付属デバイス)のパススルーが完全に実現され、ハイパーバイザーを迂回してCVMに直接繋がるようになります。 AHVは、CentOS KVMをベースに構築されています。 ゲストVM (HVM) に対しては、完全なハードウェアの仮想化を使用します。

AHVは、CentOS KVMをベースに基本機能を拡張し、HAやライブ マイグレーションなどの機能を組み込んだものです。

AHVは、Microsoft Server Virtualization Validation Programの認定を受け、またMicrosoft OS やアプリケーションの稼動検証を受けています。

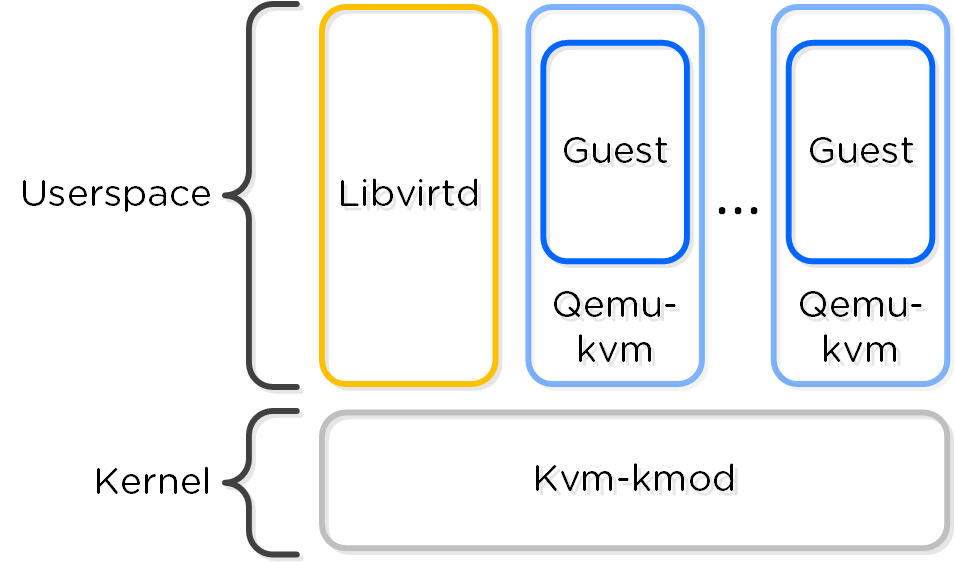

KVMアーキテクチャー

KVMの主要なコンポーネントは、以下に示す通りです:

- KVM-kmod

- KVMのカーネルモジュール

- Libvirtd

- KVMとQEMUを管理するためのAPI、デーモン、管理ツールです。AOSとKVM/QEMUはlibvirtdを経由して通信します

- Qemu-kvm

- 全ての仮想マシン(ドメイン)上で稼動するマシンエミュレータおよびバーチャライザです。AHV内で本コンポーネントは、ハードウェア アシステッドな仮想化に利用され、VMはHVMとして稼動します

以下に各コンポーネントの関連を示します:

AOSとKVM/QEMUは、libvirtdを経由して通信します。

プロセッサ世代間の互換性

異なるプロセッサ世代間でVMを移動できるVMwareのEnhanced vMotion Capability (EVC) と同様に、AHVでは、クラスタ内の最も古いプロセッサの世代を特定し、全てのQEMUドメインをそのレベルで取扱います。これによって、AHVクラスタ内に異なる世代のプロセッサが混在している場合でも、ホスト間のライブマイグレーションが可能となります。

AHVの最大構成と拡張性

以下の最大構成と拡張制限が適用されます:

- 最大クラスタサイズ: 32

- VMあたりの最大vCPU数: 関連するAHVバージョンの Configuration Maximums ページを確認してください。

- VMあたりの最大メモリ: 4.5TBまたは使用可能な物理ノードメモリ

- 最大仮想ディスクサイズ: 64TB

- ホストあたりの最大VM数: 関連するAHVバージョンの Configuration Maximums ページを確認してください。

- クラスタあたりの最大VM数: 関連するAHVバージョンの Configuration Maximums ページを確認してください。

※64TBの最大仮想ディスクサイズは、Nutanixエンジニアリングによって内部的にテストされているサイズです。

上記はAHV 20230302.100173とAOS 6.8のものです。 他のバージョンについてはConfiguration Maximumsを参照してください。

コンピュート

ここからのセクションでは、ワークロード管理のためのNutanix AHVコンピューティングにおける主要機能の概要を説明します。

仮想マシンテンプレート

AHVには、簡単にクローンできるように単一vDiskのデータキャプチャにフォーカスしたイメージライブラリを常に持っていましたが、CPU、メモリ、そしてネットワークの詳細を設定するプロセスを完了するには、管理者からの入力が必要でした。 仮想マシンテンプレートは、この概念を次のレベルのシンプルなものにして、他のハイパーバイザーでテンプレートを利用したことがある管理者に馴染みのある仕組みを提供します。

AHVの仮想マシンテンプレートは既存の仮想マシンから作成され、CPU、メモリ、vDisk、そしてネットワークの詳細など、定義する仮想マシンの属性を受け継ぎます。 テンプレートは、展開時にゲストOSをカスタマイズするように構成でき、オプションとしてWindowsライセンスキーを提供できます。 テンプレートでは複数のバージョンを維持できるため、新しいテンプレートを作成する必要なく、オペレーティングシステムやアプリケーションパッチなどの更新を簡単に適用できます。 管理者はどのテンプレートのバージョンがアクティブか選択できるため、更新を事前にステージングしたり、必要に応じて以前のバージョンに戻すことができます。

メモリオーバーコミット

仮想化の主な利点の1つは、コンピューティングリソースをオーバーコミットできることであり、これにより、サーバーホスト上に物理的に存在するよりも多くのCPUを仮想マシンにプロビジョニングできます。 ほとんどのワークロードは、割り当てられたすべてのCPUを100%必要とはしないため、ハイパーバイザーは、CPUサイクルを必要とするワークロードに各時点で動的に割り当てることができます。

CPUまたはネットワークリソースと同様に、メモリもオーバーコミットできます。 どの時点でも、ホスト上の仮想マシンでは、割り当てられたすべてのメモリを使用している場合も使用していない場合もあり、ハイパーバイザーは未使用のメモリを他のワークロードと共有できます。 メモリのオーバーコミットによって、未使用のメモリを組み合わせて必要とする仮想マシンに割り当てることで、管理者は各ホストにより多くの仮想マシンをプロビジョニングできるようになります。

AOS 6.1では、追加のメモリと仮想マシン密度が必要なテストや開発のような環境で、管理者が柔軟に対応できるようにするオプションとしてメモリオーバーコミットをAHVにもたらします。 オーバーコミットはデフォルトで無効になっており、仮想マシン単位で定義できるため、クラスタ上の仮想マシンのすべてまたはサブセットのみで共有できます。

VMアフィニティポリシー

異なる種類のアプリケーションには、仮想マシンを同じホストで実行する必要があるか、または別のホストで実行する必要があるかを指示する要件があります。 これは通常、パフォーマンスもしくは可用性の利点のために行われます。 アフィニティ制御により、仮想マシンがどこで実行されるかを管理できるようになります。 AHVには、2種類のアフィニティ制御があります:

- 仮想マシン-ホスト アフィニティ

- 仮想マシンをホストまたはホストのグループに厳密に結び付けると、仮想マシンはそのホストまたはグループでのみで実行されます。 アフィニティは、ソフトウェアライセンスまたは仮想マシンアプライアンスが関係するユースケースで特に適用できます。 このようなケースでは、多くの場合でアプリケーションを実行できるホスト台数を制限したり、仮想アプライアンスを単一のホストに縛り付けしたりする必要があります。

- アンチアフィニティ

- AHVでは、与えられたリストの仮想マシンを同じホスト上で実行しないように宣言できます。 アンチアフィニティは、クラスタ化された仮想マシンまたは分散アプリケーションを実行している仮想マシンを異なるホスト上で実行するメカニズムを提供し、アプリケーションの可用性と復元力を向上させます。 仮想マシンの分離配置よりも仮想マシンの可用性を優先するため、クラスタが制約された際には、システムはこのタイプのルールを無効化します。

仮想Trusted Platform Module(vTPM)

TPMテクノロジーは、暗号化処理を扱う際のセキュリティとプライバシーを強化するように設計されています。 TPMの目的は、情報ストレージを不正アクセスから確実に保護することです。 主な用途はシークレットの保存であり、適切な承認なしにシークレットにアクセスすることを困難にします。

Trusted Computing Groupでは、TPMをコンピューターのマザーボードに半田付けされた専用ハードウェアチップとして概説しており、これはベアメタル デプロイメントで効果的に機能します。 AHVやESXiなどのハイパーバイザーを使用する仮想化環境では、物理TPMチップのアプローチは、次の制限により、単一のハードウェア構成で実行される複数のゲストOSをサポートするように拡張できません。

- キー ストレージ - 物理TPMチップで利用可能なストレージには、おおよそ3つの一時キーを保存できます。

- TPMでの隔離 - TPMチップは、同一物理デバイス上で実行される複数のゲストOS間の分離や、隔離を提供しません。

仮想化環境でのスケーリングの問題に対処するために、ハイパーバイザー ベンダーは仮想TPM(vTPM)と呼ばれるハイパーバイザー レベルのソフトウェアを実装しており、これはTrusted Computing GroupのTPM仕様に準拠しています。 vTPMは、ハイパーバイザー上の仮想マシン ゲストごとにプライベートTPMインスタンスを作成して、物理TPMチップと同様の機能でこれらのTPM仕様をエミュレートします。 vTPMを使用すると、それぞれの仮想マシン ゲストが独自のキー ストレージを持つことができ、同じ物理サーバー上で実行されている他のゲストから隔離されます。 この隔離を維持するために、vTPMはサーバー上のハードウェア物理TPMチップを使用しません。

各ハイパーバイザー ベンダーは、vTPMインスタンスを外部アクセスから保護する責任を負います。 たとえばNutanix AHVでは、仮想マシン間の隔離を確保し、Mantleと呼ばれる安全な分散シークレット サービスを使用してvTPMデータを暗号化し、不正アクセスや改ざんを防ぎます。

ライブ マイグレーション

ライブ マイグレーションを使用すると、管理者が手動で、または自動プロセスによって移動が開始されたかに関わらず、仮想マシンが稼働中のままワークロードを中断することなく、システムが仮想マシンをあるホストから別のホストへ移動できます。 ライブ マイグレーションは、メンテナンス操作、ADSのワークロード バランシング、ノード拡張、または管理者によるリクエストによってトリガーされ、クラスタ ノードで定期的に発生します。

また、ライブ マイグレーションを使用して仮想マシンを同じ場所、または別の場所にある別の物理クラスタに移行して、ワークロードのリバランス、メンテナンス作業の実施、または計画停止の回避ができます。 クラスタ間でのライブ マイグレーションの場合は、5ミリ秒の遅延を持つネットワークを推奨しますが、クラスタ間で最大40ミリ秒の遅延までサポートしています。

仮想マシンのライブ マイグレーションには、いくつかの段階があります:

- 宛先ホスト上に、仮想マシンのプレースホルダーを作成する

- 移動元の仮想マシンのメモリを、宛先の仮想マシンのプレースホルダーに繰り返しコピーする

- 移動元のホストで、仮想マシンを一時停止する

- 移動元の仮想マシンから宛先仮想マシンのプレースホルダーに、最終的な仮想マシンの状態をコピーする

- 継続的な接続を確保するために、ネットワーク スイッチを更新する

- 宛先ホストで、仮想マシンを再開する

- 一時停止した仮想マシンを移動元から削除する

ステップ2の、仮想マシンのメモリのコピー は、特定の反復回数(執筆時点では50回)まで繰り返しできます。 仮想マシンはまだ起動中であるため、AHVは各反復のコピー プロセスの間、アクティブに変更されている仮想マシンのメモリを追跡します。 反復が完了すると、AHVは、まだ宛先にコピーする必要がある変更されたメモリの量と、ネットワーク経由でのメモリ転送の実際の速度を分析して、別の反復が必要か、もしくは移行を次のステップに進めるかを決定します。 移行を成功させるには、仮想マシン内のメモリ量よりもメモリを変更する速度の方が重要であるため、AHVは仮想マシンのスピードを積極的に管理して、次の反復で送信する必要があるメモリ量を削減します。

ステップ3の、移行元ホスト上の仮想マシンの一時停止は、残りのメモリを300ミリ秒以内に転送できることをAHVが検出した場合にのみ発生し、非常に短い期間の後に仮想マシンが宛先ホスト上で応答することが保証されます。 これは最大のスタン時間です。 最後の反復後に残りのメモリをこのウィンドウ内で転送できない場合、移行は「収束失敗」のエラーで中止される可能性があります。 移行は、ADS、ホストの退避、または管理者が別の移行を手動でトリガーすることによって、自動的に再試行される場合があります。

ステップ5の、ネットワーク スイッチの更新は、仮想マシンの起動中にサブネット上のすべてのデバイスにRARPブロードキャスト ネットワーク パケットを送信することによって実行されます。 これにより外部ネットワーク スイッチが、仮想マシンが現在実行されている場所を認識し、パケットを適切にルーティングできるようになり、たとえば移行中にTCP接続が失われないようにします。

Generation ID(VM-GenerationID)

Generation IDを使用して仮想マシンの識別子にアクセスし、ライセンスまたは機能の検証のために仮想マシンがクローンまたは複製されたかどうかを検証するさまざまなアプリケーションがあります。

AOS 6.7以降のAHVでは、作成された仮想マシンごとにGeneration IDを作成しており、これには、その仮想マシン内で実行されているアプリケーションがアクセスできます。 アプリケーションは、正しいGeneration IDが存在するかどうかに基づいて、どのように動作するかを決定できます。

これが重要となる注目すべき例の1つはWindowsドメイン コントローラーの場合で、適切な保護策なしで誤ってクローンやロールバックをすると問題が発生する可能性があります。 Generation IDはこの情報を仮想マシンに提供するメカニズムであり、アプリケーションによるこれらの制限の確認と強制を可能にします。

Advanced Processor Compatibility

Advanced Processor Compatibility(APC)は、アップグレードを効率化し、クラスタを最新世代のCPUに移行することを支援します。 クラスタはもはや、最低限の共通基準CPUに制限されることはありません。 仮想マシンが利用可能なCPU機能を正確に識別し利用できるようになり、移行が改善されます。

APCは、いくつかの異なる方法で柔軟性を提供します。 まず、クラスタは、一貫したCPUプレゼンテーションをゲスト仮想マシンに提供してレベルを合わせることができ、これはデフォルトの動作です。 また、ハードウェアの異なる世代へのオンデマンドでのクロスクラスタ ライブ マイグレーションを実行するために、仮想マシンごとにベースラインとなるCPUモデルの設定もできます。

自動クラスタ選択(Automatic Cluster Selection)

自動クラスタ選択により、Nutanix管理者は最小限の管理オーバーヘッドでクラウドのような体験を提供することが容易になります。 多くの組織は、単一のPrism Centralインスタンスで管理される複数のクラスタを持つ汎用環境を有していますが、異なるクラスタの利用状況は、これまで管理者によって手動で管理する必要がありました。

自動クラスタ選択は、仮想マシンが作成される際に、リソースの可用性、ホストのアフィニティ、プロジェクトの仕様、およびイメージ配布ポリシーに基づいて、最適なクラスタをインテリジェントに決定します。 この機能により、新しい仮想マシンが展開される際に、リソースがクラスタ間で自動的にバランスされることが保証されます。 自動クラスタ選択は、貴重な時間を節約し、インフラストラクチャー全体で最大のパフォーマンスと利用効率を確保するために、ワークロードを均等に分散させることにも役立ちます。

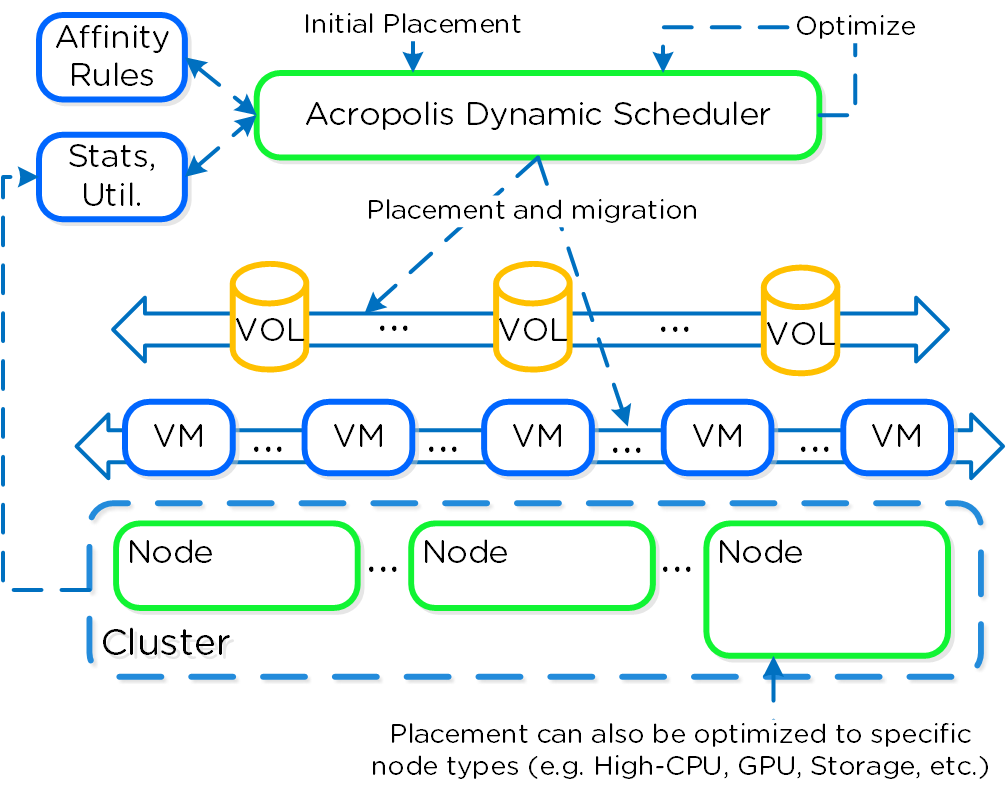

Acropolis Dynamic Scheduler(ADS)

Acropolis Dynamic Scheduler(ADS)は、AHVスタックの主要なコンポーネントです。 ADSは、ホストのホットスポット(CPUとストレージの使用率が高いホスト)の解決、高可用性の保証の維持、リソースを解放するための仮想マシン配置の最適化、管理者が定義したポリシーの適用など、多くの操作での仮想マシンの移行と配置を担当します。 ADSは常にバックグラウンドで実行され、インフラストラクチャーを継続的に監視して最適化します。

ADSに含まれる主要機能:

- 最初の仮想マシン配置 - 仮想マシンのAHVホストを選択し、必要に応じてクラスタをデフラグメントして、新しい仮想マシンで十分なリソースが利用できるようにする

- 動的ホットスポットの緩和 - 各ホストを監視し、ホットスポットが検出された場合に、そのホットスポットを解決します

- バックグラウンド ポリシーの適用 - たとえば、仮想マシン-ホスト アフィニティ ポリシーや、仮想マシン-仮想マシン アンチアフィニティ ポリシーを遵守するために仮想マシンを移動する

- 高可用性(HA)保証の強制 - HAの保証が有効になっている場合、ADSは実行中のシステム内で仮想マシンを移動し、個々のホストの障害後に、各ホスト上のすべての仮想マシンを確実に復元できるようにする

- 動的なGPU管理 - NVIDIA GPUをサポートし、システム内で稼働している仮想マシンに基づいて、特定のvGPUプロファイルを提供する

- 上記のケースに対処するために、移動コストに基づいて修復プランを作成する

ADS はホットスポットの緩和に重点を置き、コストを最小限に抑える修復プランを立てるため、積極的な負荷分散シナリオで必要になる仮想マシンの移動量よりも少ない結果になります。

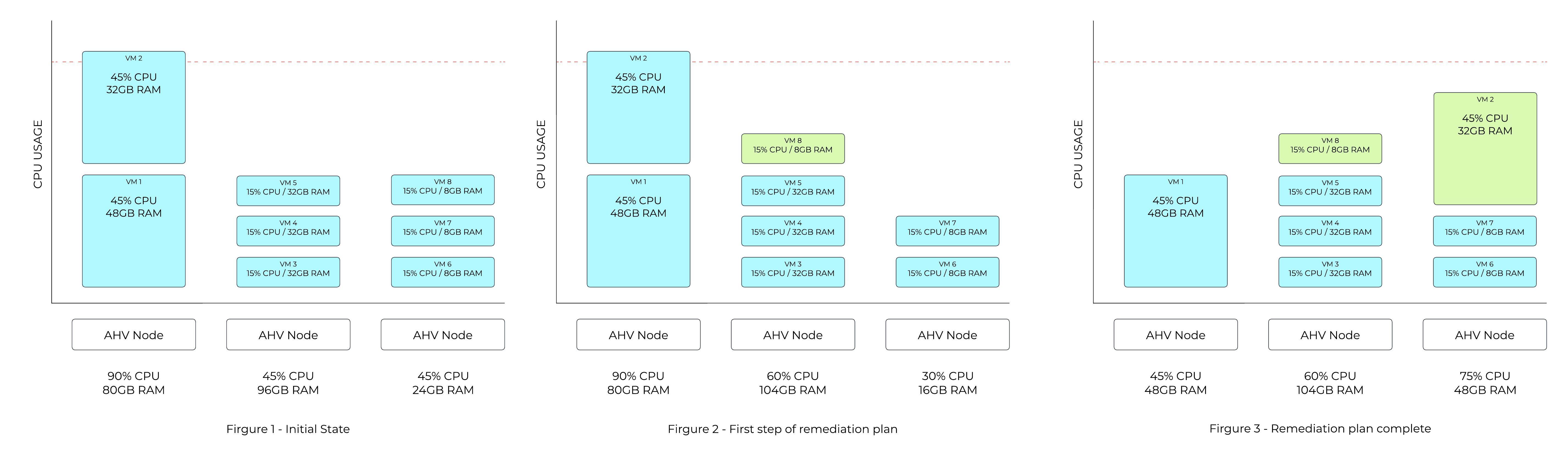

ホットスポット緩和の例 - サンプル プラン

次の例のFigure 1は、ホストが利用可能なCPU容量の90%を使用していることを示しています。 CPUホットスポットのしきい値は85%であるため、ADSは仮想マシンの移動が必要であると認識します。

Figure 2では、ADSは8GBの仮想マシンのうち1つを、3番目のホストから2番目のホストに移動し、最初のホスト上にある仮想マシンの1つが移動するのに十分なスペースを確保するプランを算出します。

どの仮想マシンをより簡単に移動できるかを決定するために、最初のホスト上にある仮想マシンのメモリ量が考慮されます。 Figure 3の最終状態では、最も低コストの移動として、最初のホスト上にある2つの仮想マシンのうち、小さい方の仮想マシンが3番目のホストに移動することが示されています。

ホットスポットの検出と修復プランのコスト最小化の両方には複数の側面が考慮されるため、ADSのプランは通常これより複雑になります。

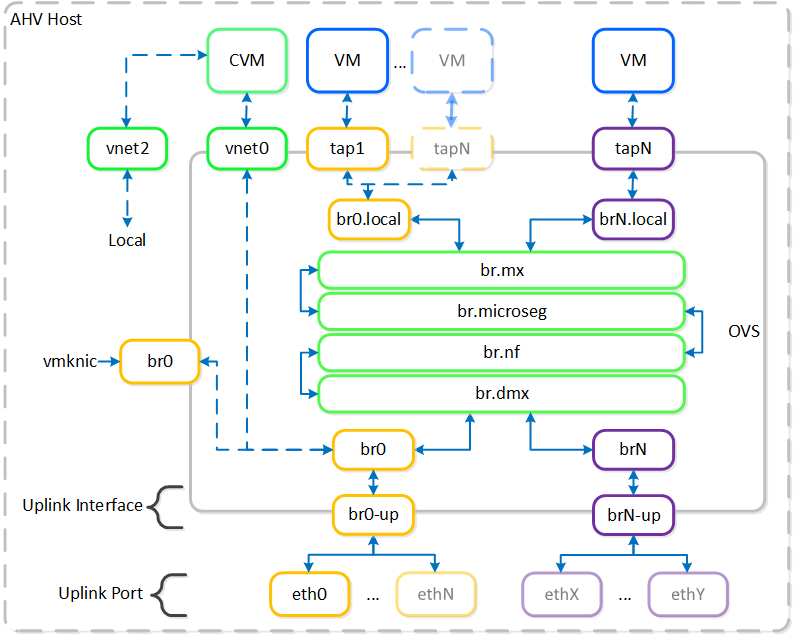

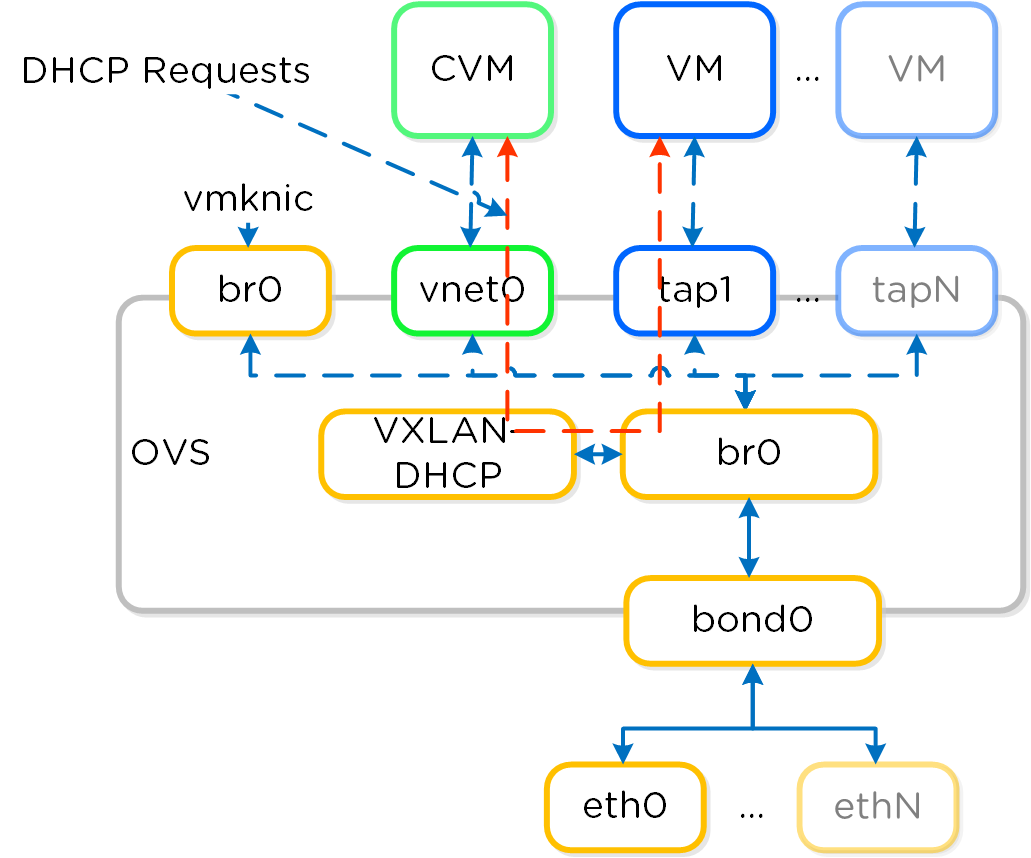

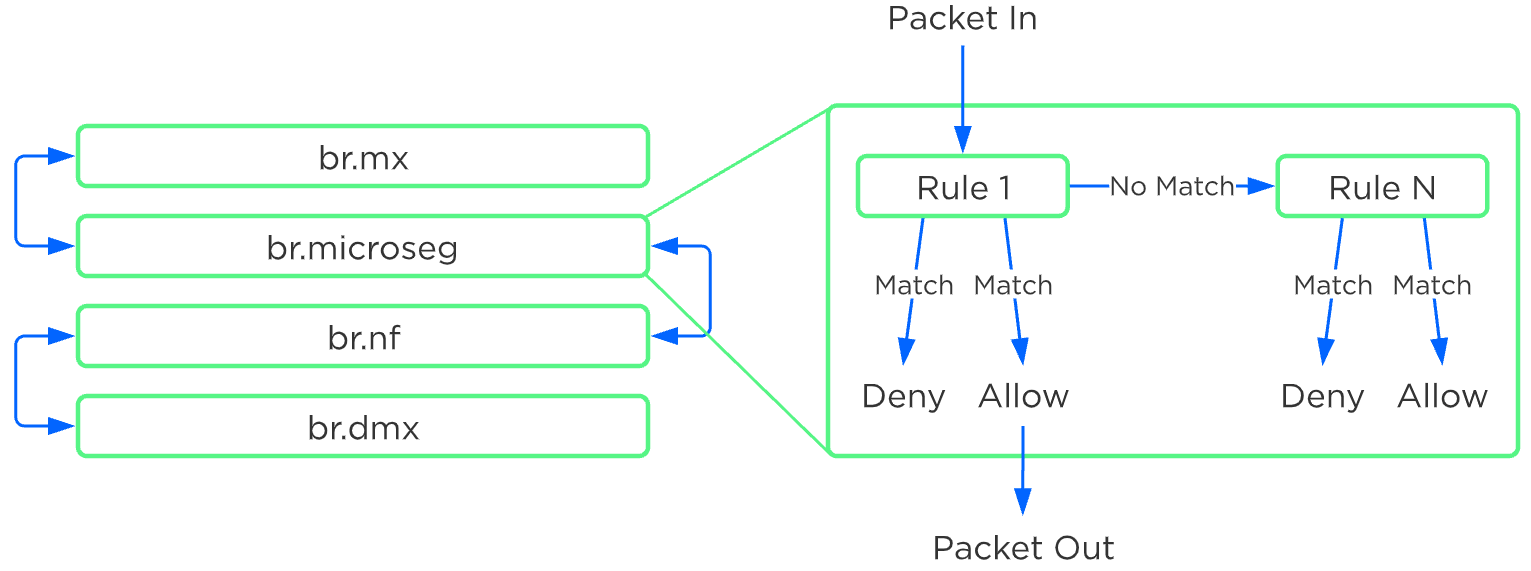

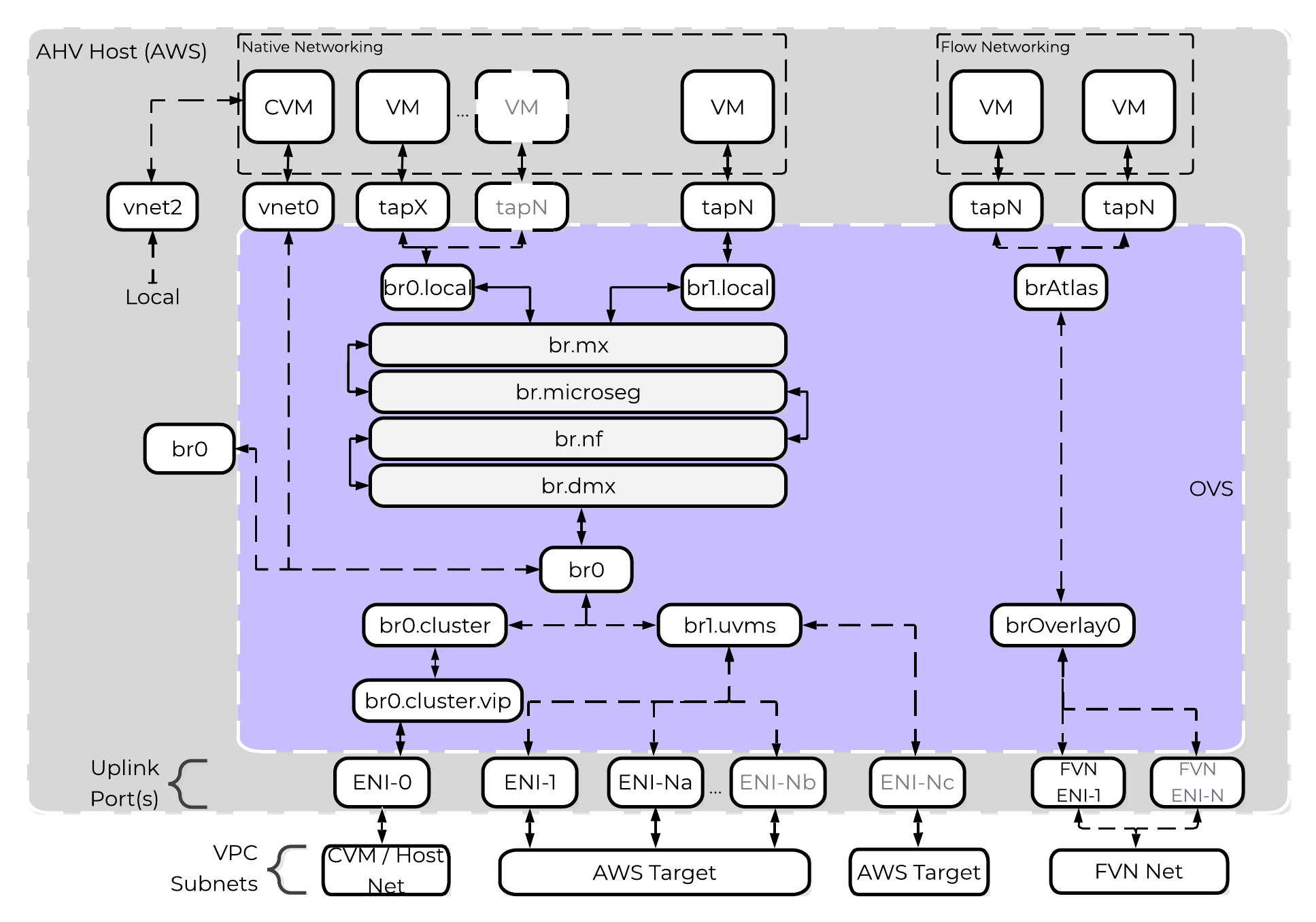

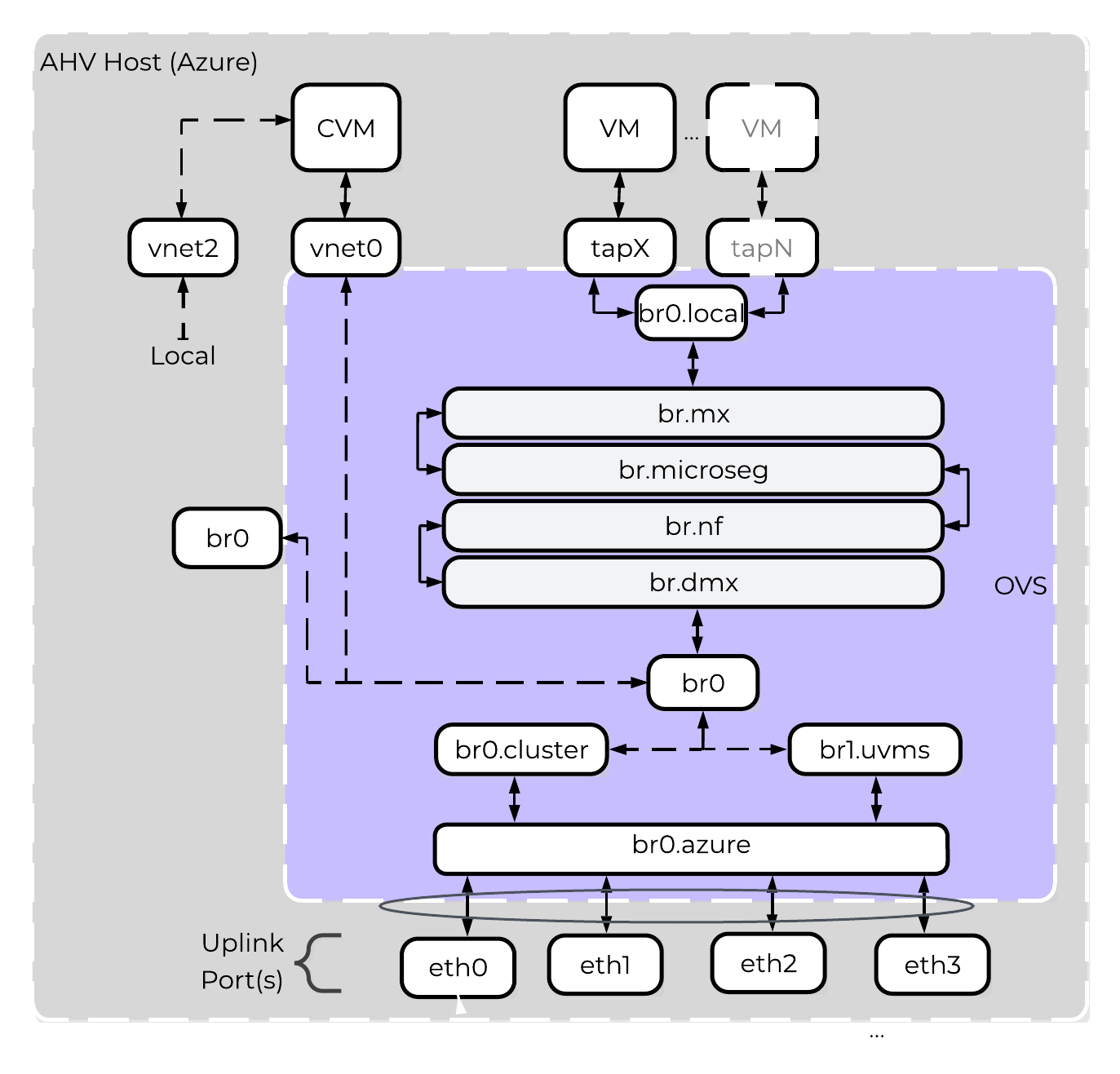

AHVのネットワーク

AHVは、全てのVMネットワークに対してOpen vSwitch (OVS) を活用しています。VMネットワークは、PrismやaCLIから設定することが可能で、各VM NICは、Tapインターフェイスに接続されます。

以下に、OVSアーキテクチャーの概念構成を示します:

上記の画像には、いくつかの種類のコンポーネントが表示されています。

Open vSwitch(OVS)

OVSとは、Linuxカーネルに実装され、複数台のサーバー仮想化環境で動作するように設計されたオープンソースのソフトウェアスイッチです。 デフォルトでは、OVSはMACアドレステーブルを維持するレイヤー2ラーニングスイッチのように動作します。 ハイパーバイザーホストとVMはスイッチの仮想ポートに接続します。

OVSは、VLANタグ、Link Aggregation Control Protocol(LACP)、ポートミラーリング、Quality of Service(QoS)など、多くの一般的なスイッチの機能をサポートしています。 各AHVサーバーはOVSインスタンスを持ち、すべてのOVSインスタンスが結合して単一の論理スイッチを形成します。 ブリッジと呼ばれる構造は、AHVホストにあるスイッチのインスタンスを管理します。

ブリッジ

ブリッジとは、物理と仮想ネットワークインターフェイス間のネットワークトラフィックを管理する仮想スイッチとして機能します。 デフォルトのAHV構成には、br0と呼ばれるOVSブリッジとvirbr0と呼ばれるネイティブLinuxブリッジが含まれています。 virbr0 Linuxブリッジは、CVMとAHVホスト間の管理およびストレージ通信を運送します。 他のすべてのストレージ、ホスト、およびVMネットワークのトラフィックはbr0 OVSブリッジを通過します。 AHVホスト、VM、および物理インターフェイスは、ブリッジへの接続に「ポート」を使用します。

ポート

ポートとは、仮想スイッチへの接続を表す、ブリッジに作成された論理構造です。 Nutanixでは、internal、tap、VXLAN、ボンドを含む、いくつかのポートタイプを使用します。

- internalポート(デフォルトブリッジであるbr0と同じ名前のもの)は、AHVホストへのアクセスを提供します。

- tapポートは、VMに提供される仮想NICのブリッジ接続として機能します。

- VXLANポートは、Acropolisが提供するIPアドレス管理機能で使用されます。

- ボンドポートは、AHVホストの物理インターフェイスにNICチーミングを提供します。

ボンド(bond)

ボンドポートは、AHVホスト上の物理インターフェイスを束ねます。 デフォルトでは、br0-upという名前のボンドがbr0ブリッジに作成されます。 ノードをイメージングすると、すべてのインターフェイスは単一のボンド内に配置されます。これは、Foundationでのイメージング処理の要件によるものです。 デフォルトのボンド(AHVホストではbr0-up)に対して、(一般的なLinuxでは)bond0という名前がしばしば用いられますが、 Nutanixは、インターフェイスをブリッジbr0のアップリンクとして迅速に識別できるように、名前はbr0-upのまま使用することを推奨します。

OVSのボンドでは、active-backup、balance-slb、balance-tcpといった、いくつかの負荷分散モードが設定できます。 ボンドに対してLACPも有効化できます。 「bond_mode」の設定はインストール中に指定されないためデフォルトはactive-backupであり、これは推奨構成です。

アップリンクのロードバランシング

前のセクションで簡単に説明したように、ボンドアップリンク間でトラフィックを分散できます。

以下のボンドモードが使用できます:

- active-backup

- デフォルトの構成で、単一のアクティブなアダプターを経由してすべてのトラフィックを送信します。 アクティブなアダプターが使用できなくなると、ボンド内の別のアダプターがアクティブになります。 スループットは単一のNICの帯域幅に制限されます。 (推奨構成)

- balance-slb

- ボンド内のアダプター間で、VM NICごとに分散します(例えば、VM Aの持つnic1がeth0、nic2がeth1)。 VMのNICあたりのスループットは単一のNICの帯域幅に制限されますが、n個のNICを持つVMは「n * アダプター帯域幅」を活用できます(ボンド内のVMのNICと物理アップリンクアダプターの数が同じであると想定すると)。 注:マルチキャストトラフィックに関して注意事項があります。

- balance-tcp / LACP

- ボンド内のアダプター間で、VM NICのTCPセッションごとで分散します。 NICごとのスループットは、ボンドの最大帯域幅(物理アップリンクアダプター数 * 速度)に制限されます。 Link Aggregationが必要で、そしてLACPが必要な場合に使用されます。

ボンドの詳細については、(Nutanix AHV Networking Best Practices を参照してください。

VM NICの種類

AHVは、以下のVMネットワークインターフェイスの種類をサポートします:

- Access(デフォルト)

- Trunk(AOS 4.6以上)

デフォルトで、VMのNICはAccessインターフェイスとして生成されますが、(ポートグループ上のVMのNIC同様に)VMのOSにTrunkインターフェイスとして提示することも可能です。 Trunk設定されたNICはプライマリVLANをタグなしで送信し、追加のすべてのVLANをタグ付けしてVM上の同じvNICで送信します。 これは、VMにvNICを追加せずに複数のネットワークを接続する場合に役立ちます。

Trunkインターフェイスは、以下のコマンドで追加することができます:

vm.nic_create <VM_NAME> vlan_mode=kTrunked trunked_networks=<ALLOWED_VLANS> network=<NATIVE_VLAN>

例:

vm.nic_create fooVM vlan_mode=kTrunked trunked_networks=10,20,30 network=vlan.10

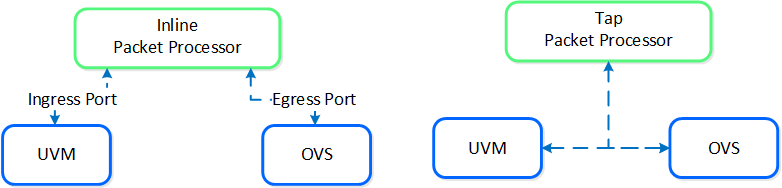

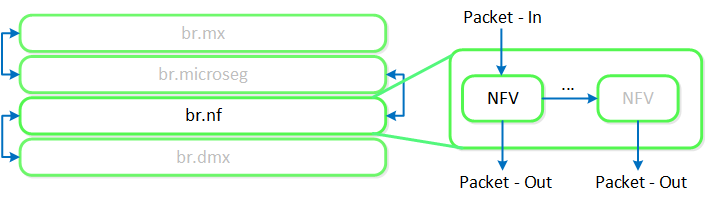

サービスチェーン

AHVサービスチェーン(service chaining)によって、全てのトラフィックをインターセプトし、パケット処理機能(NFV、アプライアンス、仮想アプライアンスなど)に対してネットワークパスの延長として透過的に渡すことができます。

サービスチェーンの一般的な使用例:

- ファイアウォール(例えば、Palo Altoなど)

- IDS/IPS/ネットワークモニター(例えば、パケットキャプチャー)

サービスチェーンには、2つの方式があります:

- インライン (Inline) パケット処理

- OVSを流れるパケットをインラインでインターセプト

- パケットの変更、許可/拒否が可能

- 一般的な適用例: ファイアウォール

-

タップ (Tap) パケットプロセッサ

- パケットフローにタップして読み込みを行い、パケットを検査

- 一般的な適用例: IDS、IPS、ネットワーク監視

全てのサービスチェーン処理は、Flowのマイクロセグメンテーション ルールが適用された後、かつパケットがローカルOVSから出る前に完了します:

説明: 複数のパケットプロセッサを、1つのチェーンに繋ぎ合わせることも可能です。 サービス チェーンは、Acropolisがネットワーク スタックを制御する場合のみ適用されます。 サービス チェーンは現在、Network ControllerベースのVLANまたはVPCではサポートされていません。

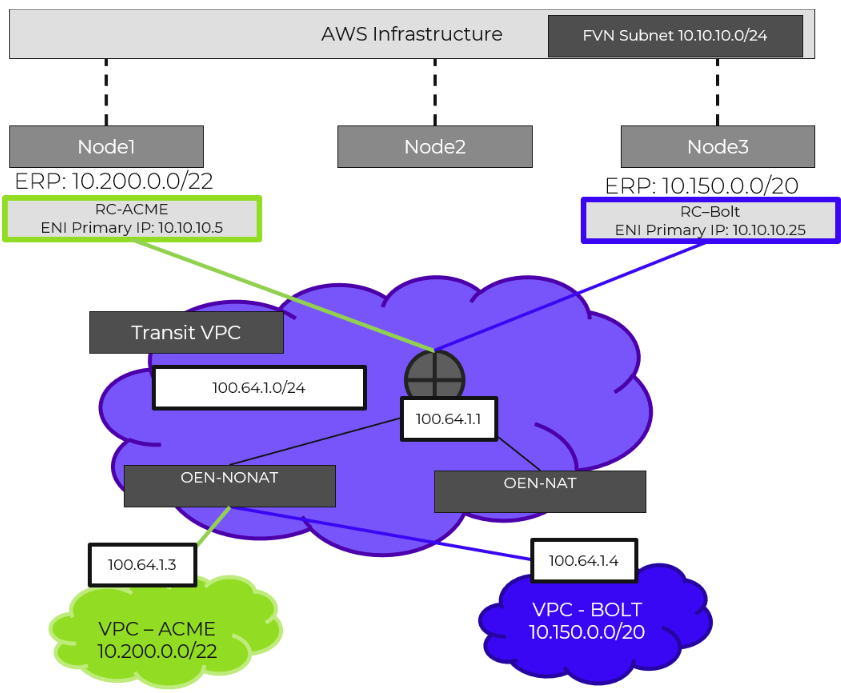

Network Controller

Network Controllerは、Flow Virtual NetworkingとVPCのオーバーレイ サブネットを有効化するために、AOS 6.0でリリースされました。 AOS 6.7で、NutanixはNetwork Controllerを強化し、ゲスト仮想マシンを接続するVLAN-backedサブネットのサポートを追加しました。 Network Controllerが有効になると、Acropolisリーダーによって管理される既存のVLANを説明するために、新しいサブネット ラベルとしてVLAN Basicが作成されます。 Network Controllerによって管理されるサブネットにはラベルがなく、シンプルにVLANと呼ばれます。

サポートされる構成

主要ユースケース:

- Network ControllerベースVLANサブネットの追加機能を備えたAHVネットワーキング

- Flow Virtual NetworkingのVPCオーバーレイ サブネット

- Network Controllerが有効なVLANベース サブネットのマイクロセグメンテーション

- VPCオーバーレイ サブネットでのマイクロセグメンテーション

管理インターフェイス:

- Prism Central(PC)

サポートされている環境:

- オンプレミス:

- AHV

- Nutanix Cloud Clusters(NC2)

- NC2 on Azure

Network Controllerが有効化されたVLANの前提条件:

- Prism Central 2023.3

- AOS 6.7

- AHV 9

- MSPの有効化

アップグレード:

- LCMに含まれる

プロからのヒント

Network Controllerのスケーラビリティを最大にするには、Prism CentralをExtra large(X-Large)サイズで展開します。

実装の構造

Network Controller(以前のAtlas Network Controller)は、Flow Virtual Networking VPCと、AHV内のNetwork Controllerが有効なVLAN-Backedサブネットによって使用される仮想ネットワーク スタックを制御します。 Network Controllerにより大規模な構成が可能になり、複数のPrism Elementクラスタに存在するサブネットなどの新機能が利用できるようになります。 このネットワーク スタックにより、将来的なネットワークとネットワーク セキュリティの機能が使用できるようになります。 拡張された機能により、OVSベースのアーキテクチャーで使用されていたものとは異なるいくつかの構造があります。

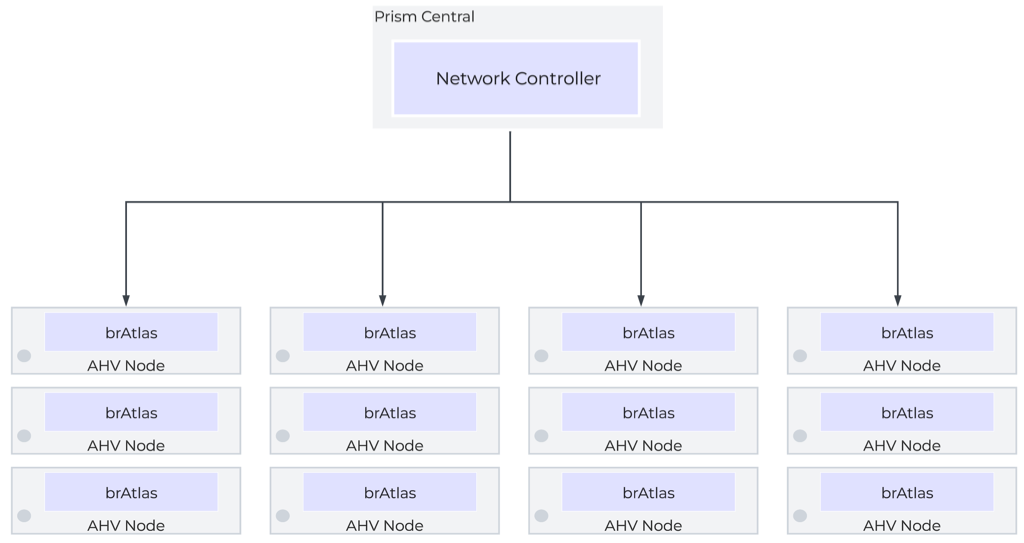

Network Controllerは、Prism Centralから、VLAN、オーバーレイ サブネット、IPアドレス プール、そしてセキュリティ ポリシーを集中管理するために使用されます。 Network Controllerは Prism Central 上で実行されます。

Network Control Plane

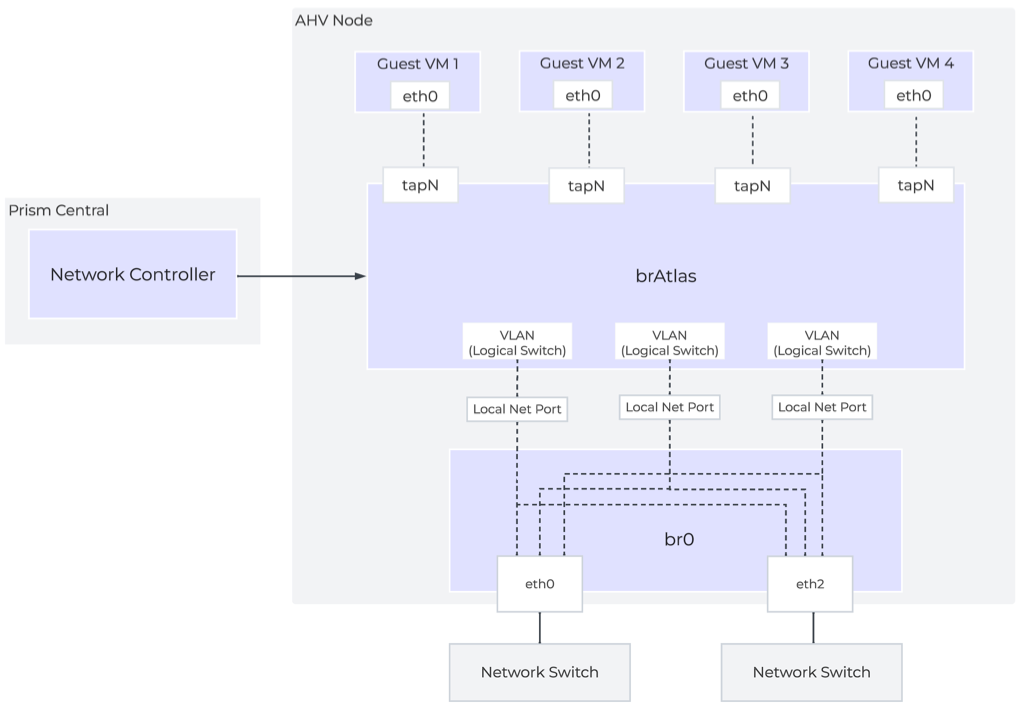

Network Controllerは、Network Control Planeをプログラムしてパケットの処理方法を決定します。 Control Planeには、Open Virtual Network(https://www.ovn.org/en/architecture/)を使用しています。 brAtlasという名前の新しい仮想スイッチが、すべてのAHVホストに作成されます。

ネットワーク ブリッジ

Network Controllerで使用されるブリッジの種類は2つあり、それはbrAtlasとbr0です。

brAtlas

brAtlasブリッジは、すべてのAHVホストに作成される仮想スイッチで、Network Controllerによって管理されます。 VPCおよびNetwork ControllerによるVLANに接続されたゲスト仮想マシンは、tapインターフェイスを介してbrAtlasに接続します。

br0

br0ブリッジは、brAtlasのレイヤー2スイッチとして機能し、物理ネットワークと接続するアップリンク ブリッジです。 必要に応じて、複数のアップリンク ブリッジを使用できます。 これらの追加のアップリンク ブリッジは、同じ命名規則に従い、br0、br1、br2といった名前になります。

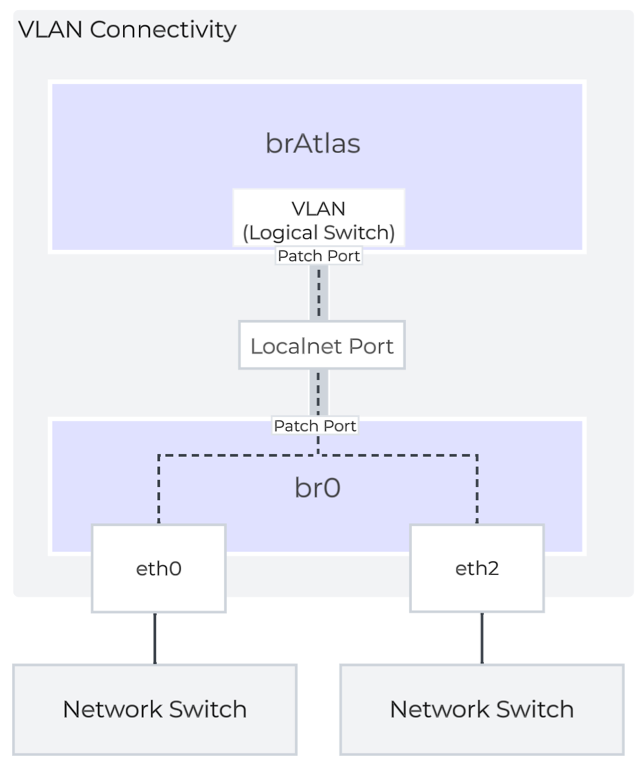

VLANと論理スイッチ(Logical Switch)

ゲスト仮想マシンのVLANタグ付けのために、すべてのVLANがbrAtlas内のLogical Switchにマッピングされます。 それぞれのLogical Switchには、br0などのアップリンク仮想スイッチに接続するLocal Net Portが関連付けられます。 Local Net Portは、Logical Switchと物理ネットワーク間の接続ポイントです。

Local Net Portは、brAtlasとbr0間のPatch Portペアで構成されます。 Network Controllerが有効なVLAN-backedサブネットは、brAtlasのLogical Switchにマッピングされます。

Nutanix AHVの動作の仕組み

ストレージI/Oパス

AHVは、ESXiやHyper-Vのような従来のストレージ スタックを使用してはいません。 全てのディスクは、ロー(raw)SCSIブロックデバイスとしてVMに渡されます。 これによってI/Oパスを軽量化および最適化することができます。

注意

AOSは、エンドユーザーに対してkvm、virsh、qemu、libvirtおよびiSCSIを抽象化する形で、全てのバックエンド構成を処理します。 これによってユーザーは、PrismやaCLIを使って、そのスタックより上のみを意識すればよくなります。 なお以下は、情報提供を目的とした説明であるため、マニュアル操作でvirshやlibvirtに触らないことを推奨します。

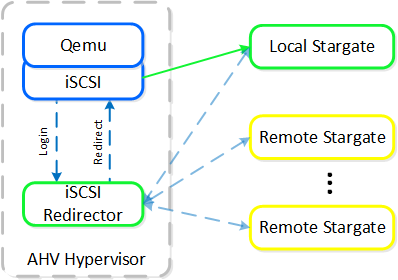

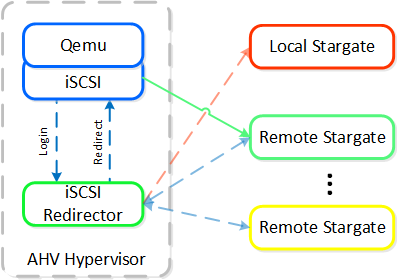

各AHVホストには、iSCSIリダイレクター デーモンが常駐し、NOP OUTコマンドを使用してクラスタのStargateに関するステータスチェックを行います。

iscsi_redirectorログ(AHVホストの/var/log/に存在)によって、各Stargateの稼動状態を確認することができます:

2017-08-18 19:25:21,733 - INFO - Portal 192.168.5.254:3261 is up

...

2017-08-18 19:25:25,735 - INFO - Portal 10.3.140.158:3261 is up

2017-08-18 19:25:26,737 - INFO - Portal 10.3.140.153:3261 is up

注意: ローカルのStargateは、内部アドレス192.168.5.254で確認できます。

以下の内容を見ると、iscsi_redirectorが127.0.0.1:3261でリスニングしていることが分かります:

[root@NTNX-BEAST-1 ~]# netstat -tnlp | egrep tcp.*3261 Proto ... Local Address Foreign Address State PID/Program name ... tcp ... 127.0.0.1:3261 0.0.0.0:* LISTEN 8044/python ...

QEMUは、iSCSIリダイレクターがiSCSIターゲットポータルとなるよう設定されます。ログインリクエストがあるとリダイレクターが起動され、iSCSIログインは、正常なStargate(通常はローカルにある)にリダイレクトされます。

XMLのドメインを確認すると、その構成が分かります:

<devices> ... <disk type='network' device='lun'> <driver name='qemu' type='raw' cache='none' error_policy='report' io='native'/> <source protocol='iscsi' name='iqn.2010-06.com.nutanix:vmdisk-16a5../0'> <host name='127.0.0.1' port='3261'/> </source> <backingStore/> <target dev='sda' bus='scsi'/> <boot order='1'/> <alias name='scsi0-0-0-0'/> <address type='drive' controller='0' bus='0' target='0' unit='0'/> </disk> ... </devices>

推奨するコントローラータイプは、virtio-scsi(SCSIデバイスのデフォルト)です。 IDEも使用できますが、ほとんどの場合、お薦めできません。Windowsでvirtioを使用する場合には、virtioドライバー、Nutanixモビリティドライバー、またはNutanix Guest Toolsがインストールされている必要があります。 最新のLinuxディストリビューターは、virtioをプリインストールして出荷しています。

... <controller type='scsi' index='0' model='virtio-scsi'> <driver max_sectors='2048'/> <alias name='scsi0'/> <address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/> </controller> ...

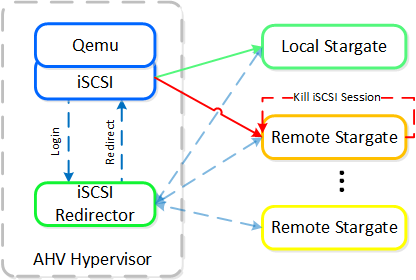

稼動中のStargateが停止した(NOP OUTコマンドにレスポンスできない)場合、iSCSIリダイレクターは、ローカルのStargateを障害として判断します。そして、QEMUがiSCSIログインを再試行した時に、リダイレクターは、ログインオペレーションを他の正常なStargateにリダイレクトします。

ローカルのStargateが復旧(かつNOP OUTコマンドにレスポンスを開始)した場合、iSCSIリダイレクターは、リモートStargateへのiSCSIセッションを終了します。 QEMUは、iSCSIログインを再度試み、同ログインはローカルのStargateにリダイレクトされます。

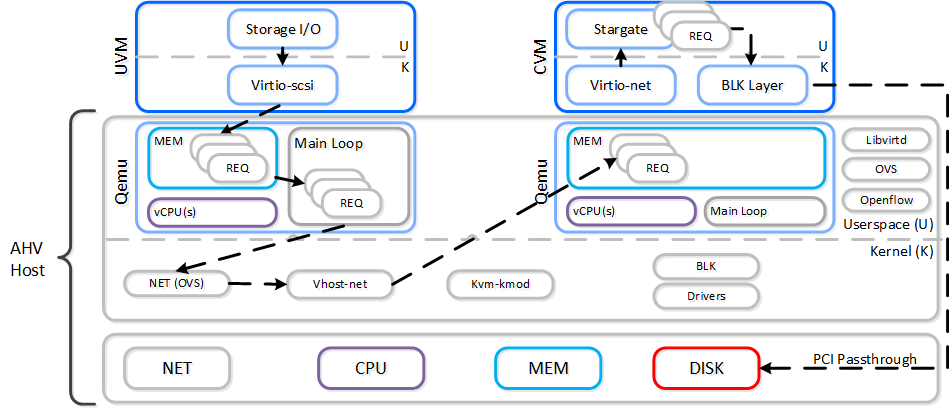

従来のI/Oパス

全てのハイパーバイザーやOSと同様、ユーザー空間とカーネル空間のコンポーネントが相互にやり取りを行って、1つの処理を実行しています。 以下を読む前に「ユーザー空間とカーネル空間」のセクションを参照し、お互いがどういった関係でやり取りをしているかを理解することをお勧めします。

VMがI/Oを実行する場合、以下の処理が行われます(理解しやすくするため、一部の手順は省略してあります):

- VMのOSが仮想デバイスに対してSCSIコマンドを実行

- Virtio-SCSIがリクエストを受け取り、ゲストのメモリに保存

- QEMUメインループがリクエストを処理

- Libiscsiが各リクエストを検査して転送

- ネットワーク層がリクエストをローカルCVMに転送(ローカルCVMが利用できない場合は外部のCVM)

- Stargateがリクエストを処理

以下に、このフローの例を示します:

ドメインのXMLに着目すると、qemu-kvmエミュレータが使用されていることが分かります。

... <devices> <emulator>/usr/libexec/qemu-kvm</emulator> ...

またAHVホストを見ると、ローカルブリッジとIPを使用している正常なStargateを使って、qemu-kvmがセッションを確立しています。 外部との通信のため、外部ホストとStargate IPが使用されています。 注意: 1ディスクあたりのセッション数は、1つとなります(PID 24845をご覧ください)。

[root@NTNX-BEAST-1 log]# netstat -np | egrep tcp.*qemu Proto ... Local Address Foreign Address State PID/Program name tcp ... 192.168.5.1:50410 192.168.5.254:3261 ESTABLISHED 25293/qemu-kvm tcp ... 192.168.5.1:50434 192.168.5.254:3261 ESTABLISHED 23198/qemu-kvm tcp ... 192.168.5.1:50464 192.168.5.254:3261 ESTABLISHED 24845/qemu-kvm tcp ... 192.168.5.1:50465 192.168.5.254:3261 ESTABLISHED 24845/qemu-kvm ...

メインループがシングルスレッドになっていたり、libiscsiがすべてのSCSIコマンドを検査したりするなど、このパスには幾つか非効率な部分が存在します。

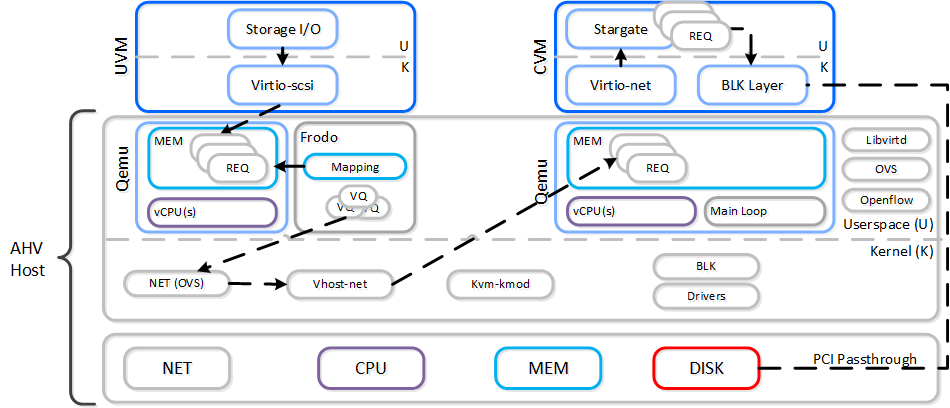

Frodo I/Oパス(別名AHV Turbo Mode)

ストレージテクノロジーは、Nutanixと同様に進化を続け、その効率性をさらに高めています。 Nutanix自身の手でAHVやスタックを完全にコントロールできるようになった今こそ、絶好の機会です。

手短に言えば、Frodoはより優れたスループットや低レイテンシーの実現、さらにCPUのオーバーヘッドを減らすため、AHV向けに特別に最適化されたI/Oパスなのです。

プロからのヒント

FrodoはAOS 5.5.X以降でパワーオンされたVMにおいてデフォルトで有効になります。

VMがI/Oを実行する場合、以下の処理が行われます(理解し易くするため、一部の手順は省略してあります):

- VMのOSが仮想デバイスに対してSCSIコマンドを実行

- Virtio-scsiがリクエストを受け取り、ゲストのメモリに保存

- Frodoがリクエストを処理

- カスタムlibiscsiがiscsiヘッダーを付加して転送

- ネットワーク層がリクエストをローカルCVMに転送(ローカルCVMが利用できない場合は外部のCVM)

- Stargateがリクエストを処理

以下に、このフローの例を示します:

以下のパスは、いくつかの重要な点を除いて、従来のI/Oと変わりが無いように見えます:

- Qemuのメインループを、Frodo(vhost-user-scsi)に置き換える

- Frodoは複数の仮想キュー (VQ) をゲスト(vCPUあたり1つ)に提供

- マルチスレッドを使用して、複数のvCPU VMに対応

- LibiscsiをNutanix独自のより軽いバージョンに置き換える

パフォーマンスが向上するのみでなく、ゲストからはディスクデバイスに複数のキューが存在しているように見えます。 I/O処理のCPUオーバーヘッドが25%も低下したり、Qemuに比べパフォーマンスが3倍になったりした例もあります! 他のハイパーバイザーに比べても、I/O処理のCPUオーバーヘッドを最大3倍減らすことができます。

AHVホストを見ると、それぞれのVM(qemu-kvmプロセス)に対してfrodoプロセスが存在することが判ります。

[root@drt-itppc03-1 ~]# ps aux | egrep frodo ... /usr/libexec/qemu-kvm ... -chardev socket,id=frodo0,fd=3 \ -device vhost-user-scsi-pci,chardev=frodo0,num_queues=16... ... /usr/libexec/frodo ... 127.0.0.1:3261 -t iqn.2010-06.com.nutanix:vmdisk... ...

またドメインのXMLがfrodoを使用していることも判ります:

... <devices> <emulator>/usr/libexec/frodo</emulator> ...

プロからのヒント

Frodoのマルチスレッド / マルチコネクションの利点を活かすためには、VMが立ち上がった際に、1つのVMにつき2つ以上のvCPUを割り当てることが必要となります。

これは、以下のように特徴付けられます:

-

1 vCPU UVM:

- 1ディスクデバイスあたり1 Frodoスレッド / セッション

- 2以上の vCPU UVM:

- 1ディスクデバイスあたり2 Frodoスレッド / セッション

以下では、ローカルブリッジとIPを使用している正常なStargateを使って、Frodoがセッションを確立しています。外部との通信のため、外部ホストとStargate IPが使用されています。

[root@NTNX-BEAST-1 log]# netstat -np | egrep tcp.*frodo Proto ... Local Address Foreign Address State PID/Program name tcp ... 192.168.5.1:39568 192.168.5.254:3261 ESTABLISHED 42957/frodo tcp ... 192.168.5.1:39538 192.168.5.254:3261 ESTABLISHED 42957/frodo tcp ... 192.168.5.1:39580 192.168.5.254:3261 ESTABLISHED 42957/frodo tcp ... 192.168.5.1:39592 192.168.5.254:3261 ESTABLISHED 42957/frodo ...

IPアドレスの管理

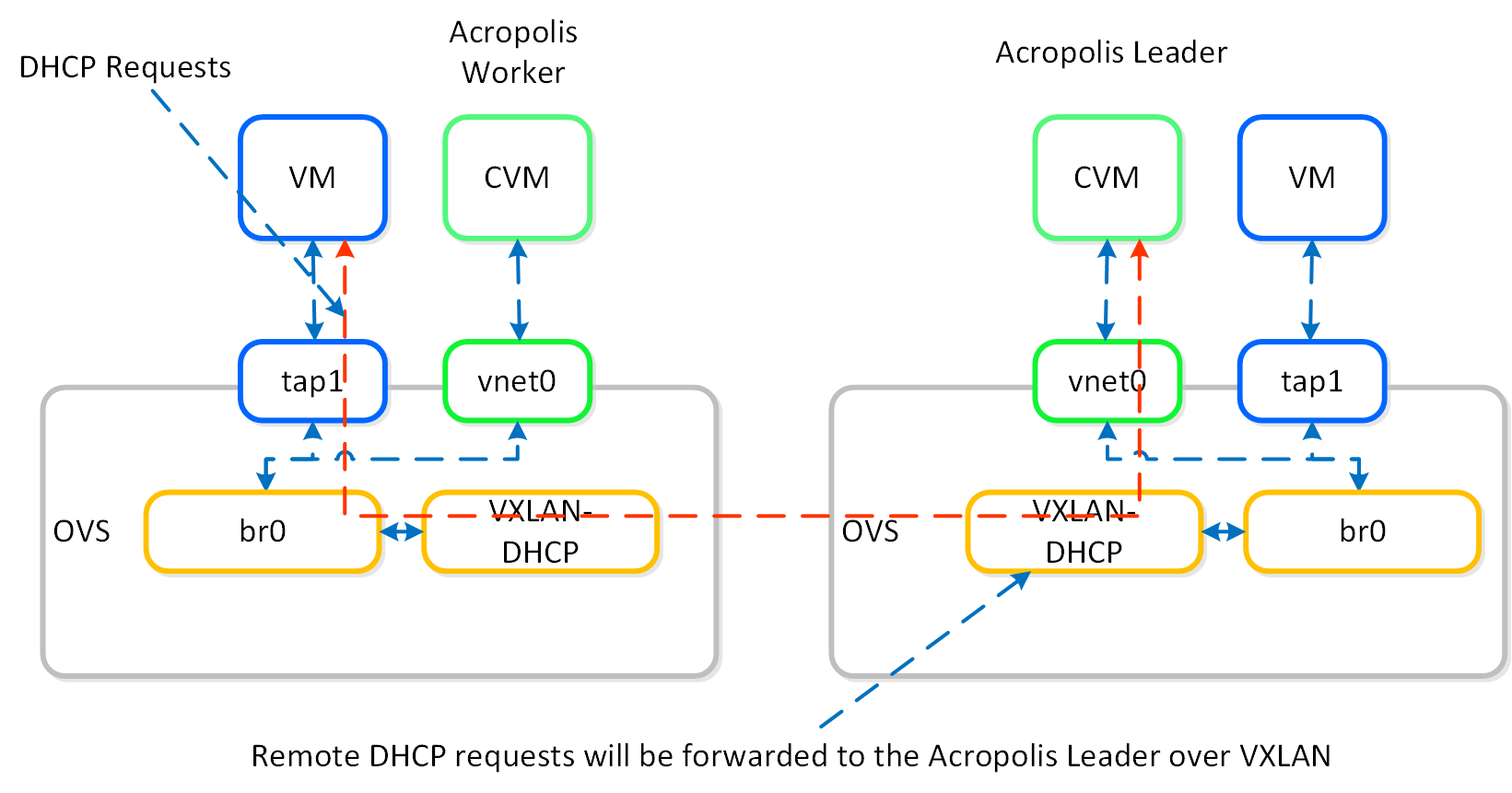

Acropolis IPアドレス管理 (IPAM) により、DHCPスコープを構成し、VMに自動的にIPアドレスを割り当てることができます。この機能は、VXLANとOpenFlowルールを使用してDHCPリクエストに割り込みを行い、DHCPレスポンスによりレスポンスを返します。

以下は、Acropolisリーダーがローカルで稼動している場合の、Nutanix IPAMを使用したDHCPリクエストのオペレーション例です:

Acropolisリーダーがリモートで稼動している場合には、ネットワークを超えたリクエストを処理するために、同じVXLANトンネルが使用されます。

既存のDHCP / IPAM ソリューションも使用することが可能です。

VMの高可用性 (HA)

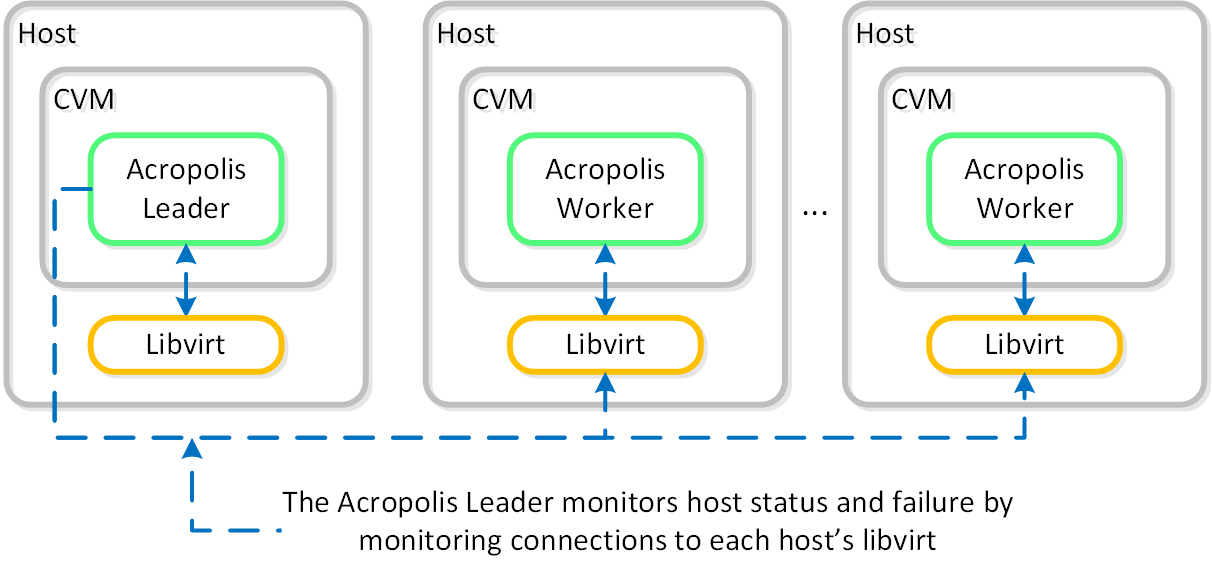

AHV VM HAは、ホストやブロックに障害が発生した場合に、VMの可用性を確保するための機能です。 ホストに障害が発生した場合、そのホストで稼動していたVMは、クラスタ内の他の正常なノードに移動し再起動されます。 Acropolisリーダーがこの役割を担っています。

Acropolisリーダーは、クラスタ内全てのホスト上のlibvirtへの接続状況をモニターし、ホストのヘルスチェックを行っています:

libvirtの接続がダウンすると、HAによる再起動へのカウントダウンが開始されます。 libvirtの接続がタイムアウト期間内での再確立に失敗すると、Acropolisは切断されたホストで起動されていたVMを再起動します。 この場合、VMは120秒以内に再起動されるはずです。

Acropolisリーダーが分割された場合、またはネットワーク隔離された場合、さらに、障害が発生した場合には、クラスタ内の正常のノードが新しいAcropolisリーダーとして選定されます。 クラスタが分割された場合(例えば、Xノードが他のYノードに通信不能)には、クォーラムを持った方が動作を継続し、VMはそのノードで再起動されます。

VM HAには主に2つのモードがあります:

-

デフォルト (Default)

- AHVベースのNutanixクラスタをインストールした際に、デフォルトで含まれる設定不要のモードです。 AHVホストが使用できなくなった場合、障害の発生したAHVホストで稼動していたVMは、利用可能なリソースに応じて、残りのホストで再起動されます。 残りのホストに十分なリソースが存在しない場合には、停止したすべてのVMが再起動されるとは限りません。

-

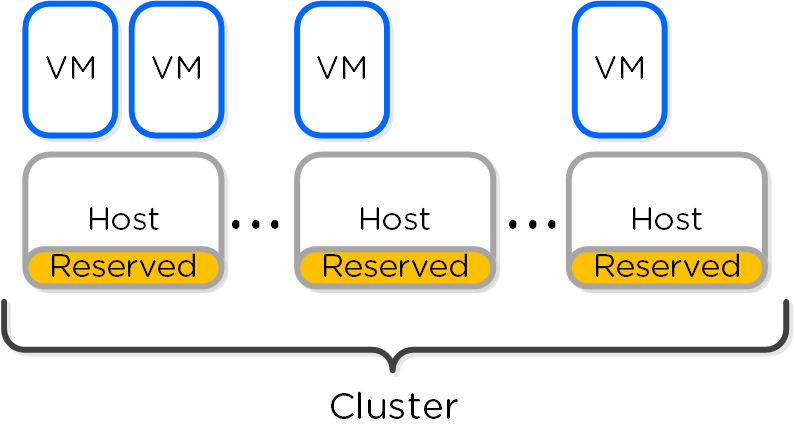

保証 (Guarantee)

- このモードは、クラスタ全体のAHVホストでスペースを予約しておき、ホストに障害が発生した場合にAHVクラスタの他のノードで、すべての停止したVMを再起動できるようにするものです。 保証モードを有効化する際には「Enable HA(HAを有効化)」チェックボックスを選択します。 予約されたメモリ量と、障害に絶えられるAHVホストの数がメッセージ表示されます。

リソース予約

VM HAを保証 (Guarantee) モードにすると、システムはVMのためにホストのリソースを予約します。 予約されるリソースの量は、以下のように要約することができます:

- 全てのコンテナがRF2 (FT1) の場合

- 1つの「ホスト」に相当するリソース

- RF3 (FT2) のコンテナが存在する場合

- 2つの「ホスト」に相当するリソース

ホストのメモリ容量に差がある場合、システムは最大のメモリ容量をもつホストを基準に、ホストあたりの予約量を決定します。

5.0以降のリソース予約

リリース5.0より前には、ホストとセグメントベース両方の予約をサポートしていました。 リリース5.0以降は、セグメントベースの予約のみとなり、これは保証HAモードが選択されると自動的に設定されます。

予約セグメントは、クラスタの全てのホスト全体にリソースを分散させます。 この場合それぞれのホストは、HAのために予約されたメモリを共有することになります。 これによって、ホストに障害が発生した場合でも、VMを再起動するための十分なフェイルオーバー容量をクラスタ全体で確保することができます。

以下の図は、予約セグメントの状態を示したものです:

ホストに障害が発生すると、VMはクラスタに残った正常なホストを使って再起動されます。

予約セグメントの計算

予約セグメントの総数と1ホストあたりの予約量は、システムが自動的に計算します。

必要な予約量の算出は、良く知られた「ナップサック問題」の解法に集約します。 最適な解は、NP困難 (NP-hard、指数関数的)ですが、実用的には発見的解法でも最適解に近いものを得ることができます。 Nutanixは、こうしたアルゴリズムの1つであるMTHMを採用しています。 Nutanixは、今後も配置アルゴリズムの改善に努めて参ります。

AHVのアドミニストレーション

AHV コマンドリファレンス

OVSアップリンクの表示

説明: ローカルホストのOVSアップリンクを表示

manage_ovs show_uplinks

説明: クラスタ全体のOVSアップリンクを表示

allssh "manage_ovs show_uplinks"

OVSインターフェイスの表示

説明: ローカルホストのOVSインターフェイスを表示

manage_ovs show_interfaces

説明: クラスタ全体のインターフェイスを表示

allssh "manage_ovs show_interfaces"

OVSスイッチ情報を表示

説明: スイッチ情報を表示

ovs-vsctl show

OVSブリッジ一覧

説明: ブリッジ一覧を表示

ovs-vsctl list br

OVSブリッジ情報の表示

説明: OVSポート情報を表示

ovs-vsctl list port br0

ovs-vsctl list port <bond>

OVSインターフェイス情報の表示

説明: インターフェイス情報を表示

ovs-vsctl list interface br0

ブリッジのポート/インターフェイスを表示

説明: ブリッジのポートを表示

ovs-vsctl list-ports br0

説明: ブリッジのインターフェイスを表示

ovs-vsctl list-ifaces br0

ブリッジにポートを追加

説明: ブリッジにポートを追加

ovs-vsctl add-port <bridge> <port>

説明: ブリッジにボンドポートを追加

ovs-vsctl add-bond <bridge> <port> <iface>

OVSのボンド詳細を表示

説明: ボンド詳細を表示

ovs-appctl bond/show <bond>

例:

ovs-appctl bond/show bond0

ボンドモードを設定してボンドにLACPを構成

説明: ポートのLACPを有効化

ovs-vsctl set port <bond> lacp=<active/passive>

説明: 全ホストのbond0を有効化

for i in `hostips`;do echo $i; ssh $i source /etc/profile > /dev/null 2>&1; ovs-vsctl set port bond0 lacp=active;done

ボンドのLACP詳細を表示

説明: LACPの詳細を表示

ovs-appctl lacp/show <bond>

ボンドモードを設定

説明: ポートにボンドモードを設定

ovs-vsctl set port <bond> bond_mode=<active-backup, balance-slb, balance-tcp>

OpenFlow情報を表示

説明: OVS openflowの詳細を表示

ovs-ofctl show br0

説明: OpenFlowのルールを表示

ovs-ofctl dump-flows br0

QEMU PIDと上位情報を取得

説明: QEMU PIDを取得

ps aux | grep qemu | awk '{print $2}'

説明: 指定したPIDの上位指標値を取得

top -p <PID>

QEMUプロセスに対してアクティブなStargateを取得

説明: 各QEMUプロセスのストレージI/Oに対するアクティブなStargateを獲得

netstat -np | egrep tcp.*qemu

AHVの指標値としきい値

近日公開!

AHVのトラブルシューティングと高度な管理

iSCSIリダイレクターログの確認

説明: 全ホストのiSCSIリダイレクターログを確認

for i in `hostips`; do echo $i; ssh root@$i cat /var/log/iscsi_redirector;done

単独ホストの例

ssh root@<HOST IP>

cat /var/log/iscsi_redirector

Stolen (Steal) CPUのモニター

説明: CPUのSteal時間(Stolen CPU)をモニター

topを起動して %st(以下ではボールド表示)を探す

Cpu(s): 0.0%us, 0.0%sy, 0.0%ni, 96.4%id, 0.0%wa, 0.0%hi, 0.1%si, 0.0%st

VMネットワークリソースのステータスをモニター

説明: VMリソースのステータスをモニター

virt-topを起動

virt-top

vSphere

NutanixはVMware ESXiをサポートしており、vSphere上で仮想環境を実行しながら、Nutanixの分散ストレージ ファブリックを活用できます。 また、NutanixはESXi仮想マシンの作成および管理をPrismから直接行うこともサポートしており、これによりVMware仮想インフラストラクチャーを管理するための単一の管理画面を提供します。

本書では、VMware ESXi上で動作するNutanixについて技術的な詳細を掘り下げていきます。

チャプター

- VMware vSphereのアーキテクチャー

- NutanixにおけるvSphereの動作の仕組み

- VMware ESXiのアドミニストレーション

VMware vSphereのアーキテクチャー

ESXiのノード アーキテクチャー

ESXiを導入した場合、コントローラーVM (CVM) はVMとして稼動し、ディスクはVMダイレクトパスI/Oを使用するようになります。これによって、PCIコントローラー(および付属デバイス)のパススルーが完全に可能となり、ハイパーバイザーを迂回してCVMに直接繋がるようになります。

ESXiの最大構成と拡張性

以下の最大構成と拡張制限が適用されます:

- 最大クラスタサイズ:48

- VMあたりの最大vCPU数: 256

- VMあたりの最大メモリ: 6TB

- 最大仮想ディスクサイズ: 62TB

- ホストあたりの最大VM数: 1,024

- クラスタあたりの最大VM数: 8,000(HAが有効な場合、データストアあたり2,048)

注意: vSphere 7.0とAOS 6.8時点の情報です。 他のバージョンについてはAOSのConfiguration MaximumsとESXのConfiguration Maximumsを参照してください。

プロからのヒント

ESXiホストでベンチマークを行う場合、常にESXiホストのパワーポリシーを「ハイパフォーマンス(High performance)」に設定してテストを行います。 これで P-States および C-States を無効化し、テスト結果を人為的に制限しないようにします。

ESXiのネットワーク

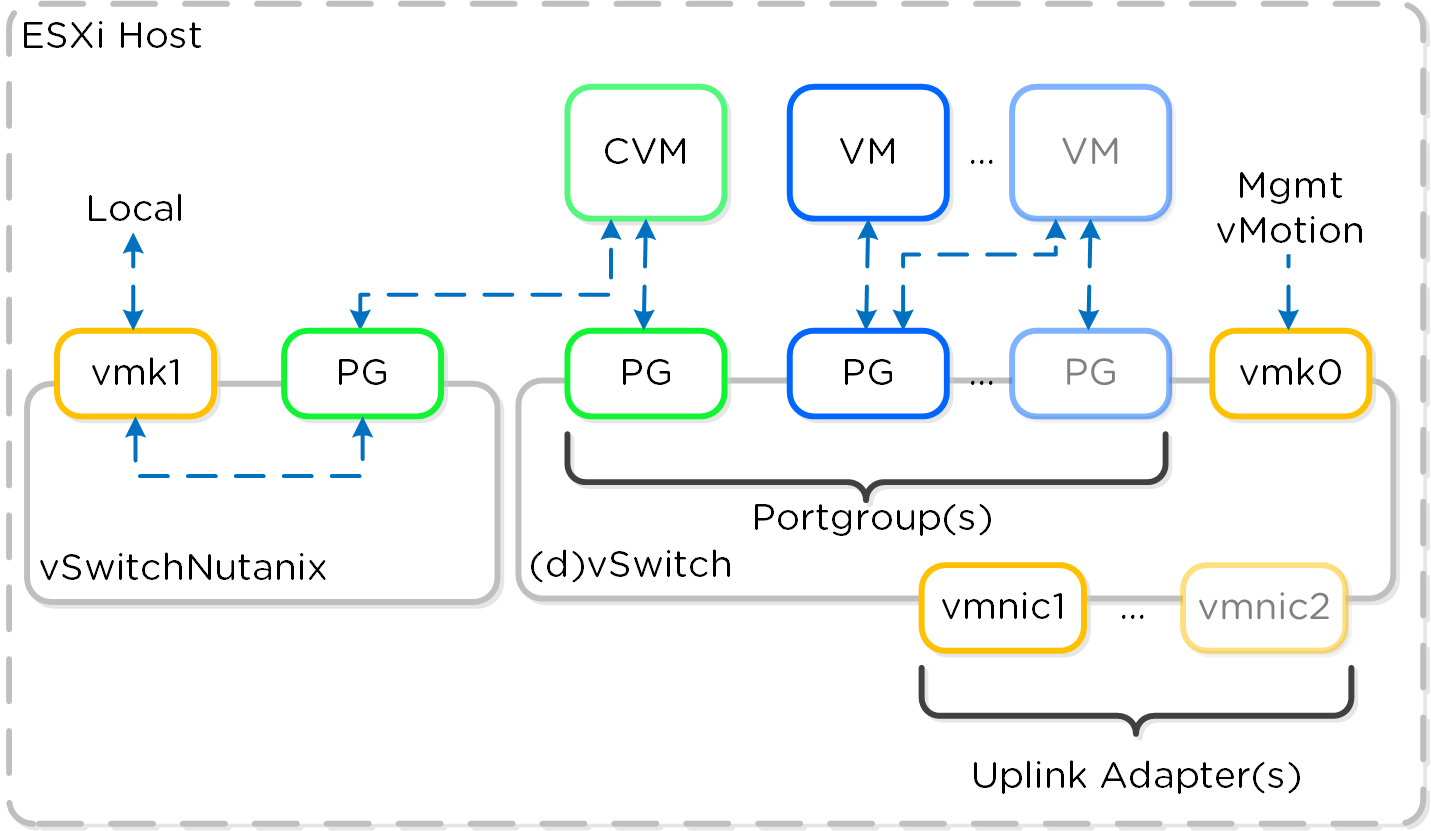

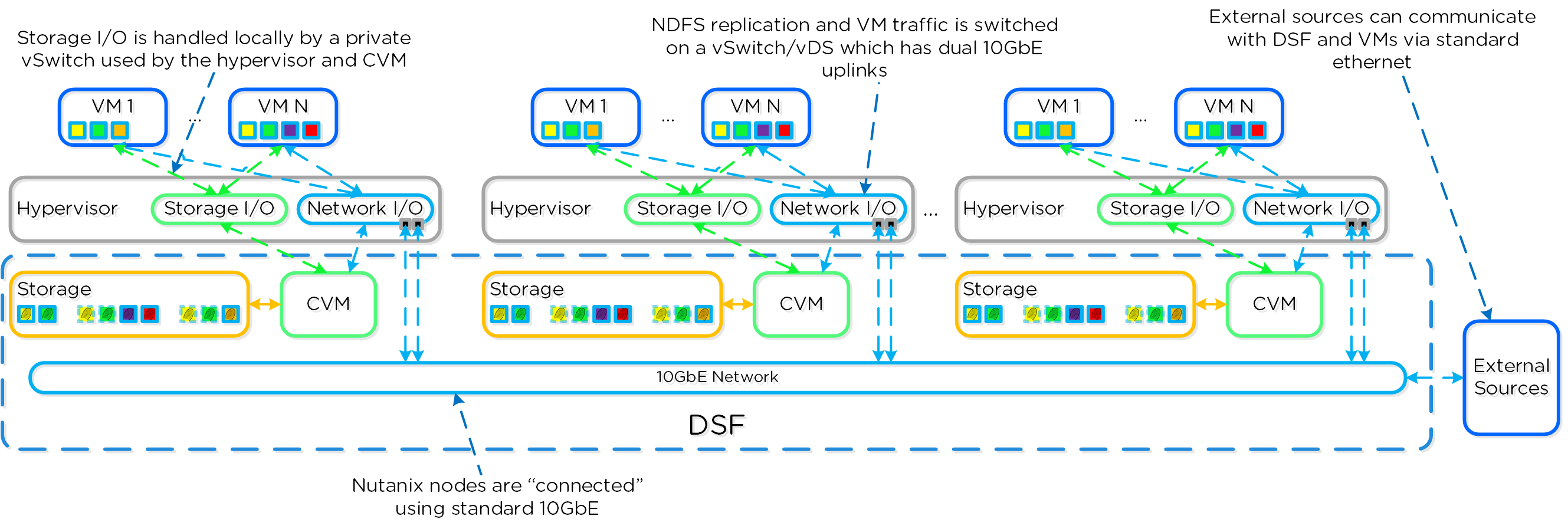

各ESXiホストにはローカルvSwitchがあり、Nutanix CVMとホストの、ホスト内部通信に使用されます。 外部やVMとの通信には、標準のvSwitch(デフォルト)またはdvSwitchが使用されます。

ローカルvSwtich(vSWitchNutanix)は、Nutanix CVMとESXiホスト間の通信のためのものです。 ホスト上のこのvSwitchにはVMkernelインターフェイス(vmk1-192.168.5.1)があり、CVMにはこの内部スイッチのポートグループにバインドされるインターフェイス(svm-iscsi-pg - 192.168.5.2)があります。 これが基本的なストレージの通信パスになります。

外部接続するvSwitchは、標準のvSwitch(標準仮想スイッチ)またはdvSwitch(分散仮想スイッチ)です。 これはESXiホストとCVMの外部インターフェイスをホストすると同時に、ホスト上のVMに使用されるポートグループもホストします。 外部のvmkernelインターフェイスは、ホスト管理やvMotionなどに使用されます。 外部CVMインターフェイスは、他のNutanix CVMとの通信に利用されます。 トランク上でVLANが有効になっていれば、必要に応じてポートグループが作成できます。

以下は、vSwitchアーキテクチャーの概念的な構造を図示したものです:

アップリンクとチーミングポリシー

デュアルToRスイッチを使用して、スイッチHAのために、両スイッチをクロスしたアップリンク構成をとることを推奨します。システムは、デフォルトでアップリンクインターフェイスをアクティブ/パッシブモードで使用します。アップストリームのスイッチアーキテクチャーが、アクティブ/アクティブなアップリンクインターフェイス(例えば、vPCやMLAGなど)に対応していれば、より高いネットワークスループットを得るためにこれを使用することができます。

NutanixにおけるvSphereの動作の仕組み

アレイオフロード - VAAI

Nutanixプラットフォームは、VMware API for Array Integration(VAAI)をサポートし、ハイパーバイザーのタスクをアレイにオフロードすることができます。 ハイパーバイザーが「仲介役」を果たす必要がなくなるため、より効率的になります。 現在Nutanixでは、「フルファイルクローン(full file clone)」、「ファストファイルクローン(fast file clone)」および「リザーブスペース(reserve space)」プリミティブを含む、NAS向けVAAIプリミティブをサポートしています。 各種プリミティブの優れた説明がこちらにあります: http://cormachogan.com/2012/11/08/vaai-comparison-block-versus-nas/

フルクローンとファストファイルクローンの場合、DSFの「ファストクローン」が完了すると、 (re-direct on writeを使って)各クローンに対する書き込み可能なスナップショットが生成されます。 各クローンは自身のブロックマップを持っているので、チェーンの深さを気にする必要はありません。 VAAIを使用するか否かは、以下の要素で決まります。

- スナップショットありのVMのクローン → VAAIは使用しない

- スナップショットなしの未稼動のVMのクローン → VAAIを使用

- 異なるデータストア/コンテナに対するVMのクローン → VAAIは使用しない

- 稼動中のVMのクローン → VAAIは使用しない

VMware Viewの場合、次の方針になります:

- View Full Clone(スナップショットありのテンプレート) → VAAIは使用しない

- View Full Clone(スナップショットなしのテンプレート) → VAAIを使用

- View Linked Clone (VCAI) → VAAIを使用

VAAIの動作は、Activity Traceページの「NFS Adapter」を使って確認できます。

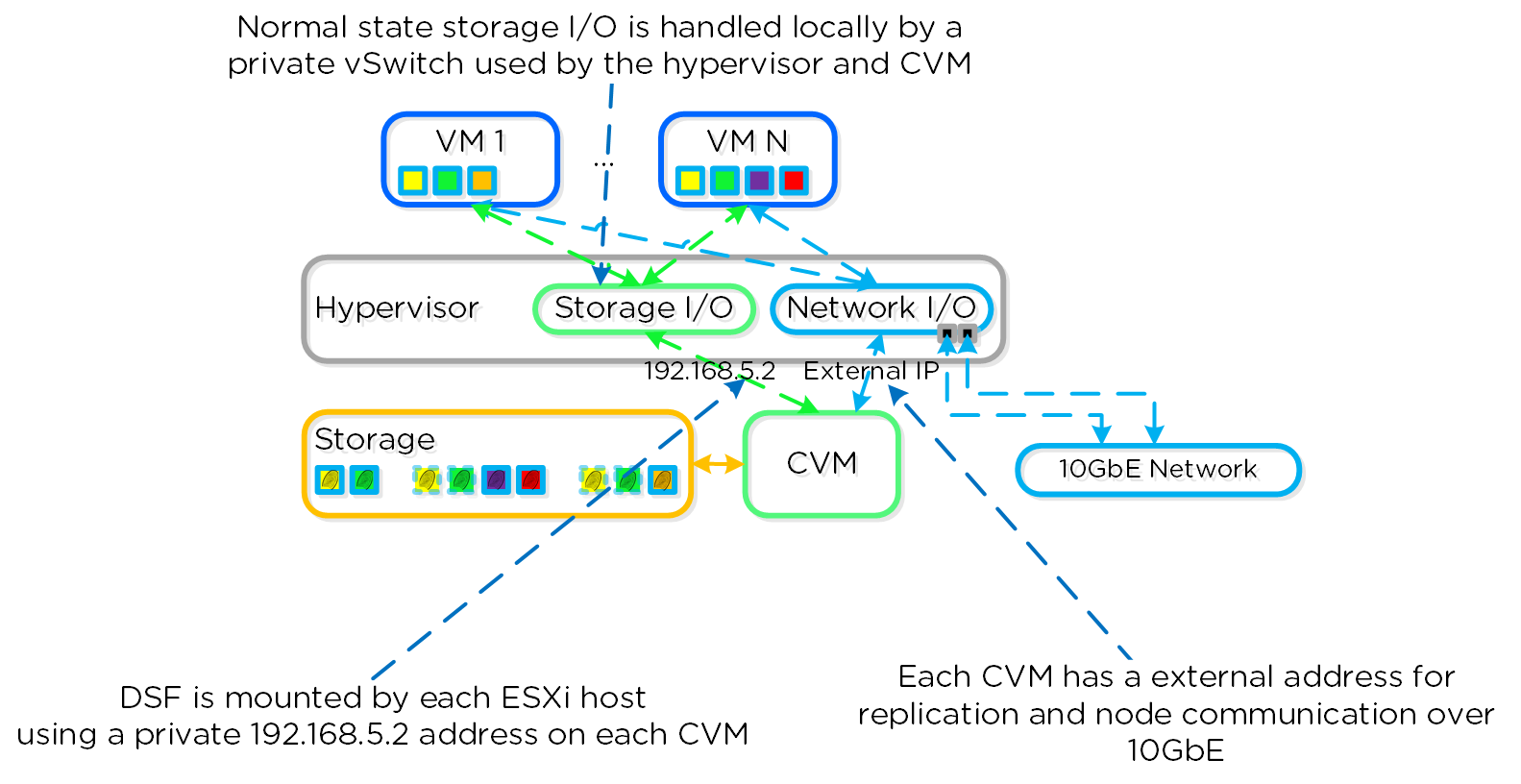

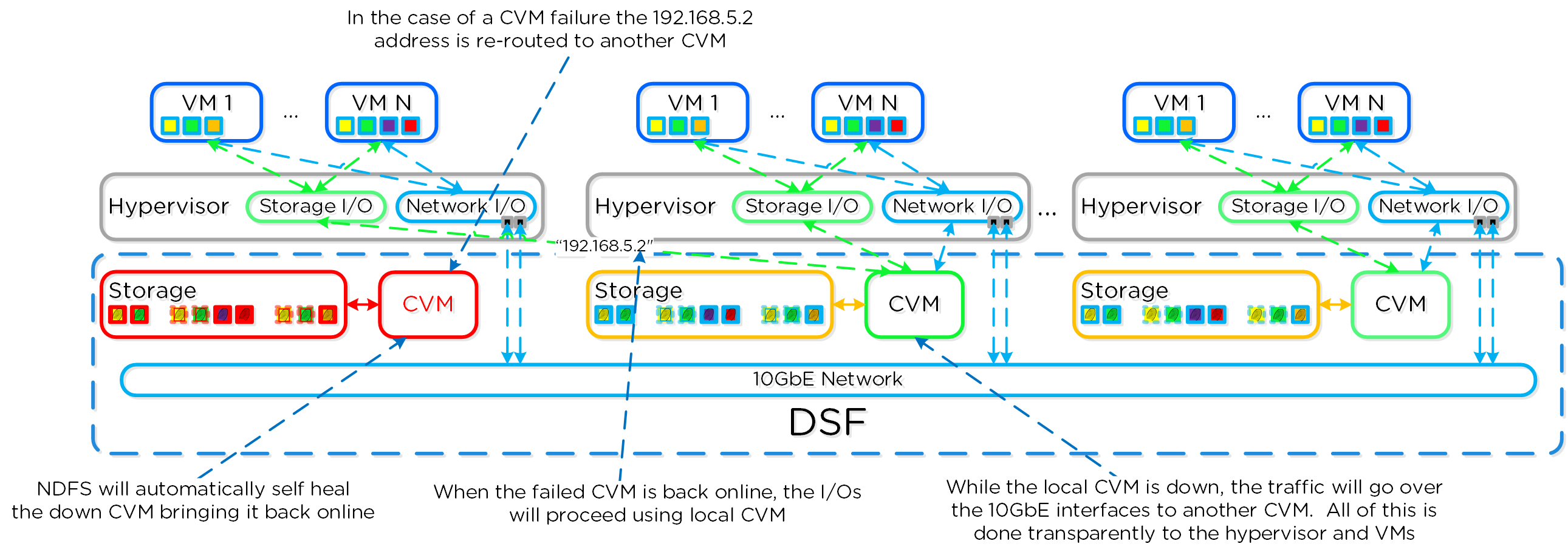

CVM Autopathing(Ha.pyとしても知られる)

本セクションでは、CVMの「障害」がどのように処理されるかについて説明します(コンポーネントの障害対応については、後日説明を追加します)。 ここではCVMの「障害」とは、ユーザーによるCVMの停止、CVMのローリングアップグレードなど、CVMを停止させる全てのイベントを含みます。 DSFには自動パス切りかえ(autopathing)と呼ばれる機能があり、ローカルCVMが利用不可になった場合、I/Oはクラスタ上の異なるCVMによって透過的に処理されます。 ハイパーバイザーとCVMは、専用のvSwitch(詳細は前述参照)上のプライベートの192.168.5.0ネットワークを使って通信します。 つまり、全てのストレージI/Oは、CVMの内部IPアドレス(192.168.5.2)を使って行われるということです。 CVMの外部IPアドレスは、リモートレプリケーションやCVMの通信に使用されます。

以下にこの状態を図示しました:

ローカルCVMで障害が発生した場合、それまでローカルCVMにホストされていたローカルの192.168.5.2アドレスは使用不可能になります。DSFは自動的にこの障害を検知し、10GbE経由でI/Oをクラスタ内の異なるCVMにリダイレクトします。この経路変更は、そのホストで稼動するハイパーバイザーやVMに対して透過的に行われます。つまり、CVMが停止しても、VMは引き続きDSFにI/Oが可能だということです。ローカルCVMが復旧して利用可能になると、経路は透過的に元にもどされ、トラフィックはローカルCVMから提供されるようになります。

以下は、CVM障害時にどういった動きをするか図示したものです:

VMware ESXiのアドミニストレーション

仮想マシンの管理

基本的な仮想マシン管理操作は、ハイパーバイザーの管理インターフェイスを使用せずに、Prismから直接実行できます。 NutanixノードをvCenterインスタンスに追加し、vCenterをNutanixクラスタに登録(Settings → vCenter Registration)すると、Prismからダイレクトに次の操作が実行できるようになります:

- 仮想マシンの作成、クローン、設定の編集、削除

- NICの作成、削除

- ディスクの接続、削除

- 仮想マシンの電源操作(パワーオン/パワーオフ、リセット、ゲストシャットダウン、ゲスト再起動、サスペンド)

- 仮想マシン コンソールの開始

- 仮想マシンゲストツールの管理(VMware ToolsまたはNutanix Guest Tools)

ESXi コマンドリファレンス

ESXiクラスタ アップグレード

説明: CLIとカスタム オフライン バンドルを使用した、ESXiホストの自動アップグレードを実行

- Nutanix CVMに、アップグレード オフライン バンドルをアップロード

- Nutanix CVMにログイン

- アップグレードを実行

cluster --md5sum=bundle_checksum --bundle=/path/to/<offline_bundle> host_upgrade

例:

cluster --md5sum=bff0b5558ad226ad395f6a4dc2b28597 --bundle=/tmp/VMware-ESXi-5.5.0-1331820-depot.zip host_upgrade

ESXiホストサービスの再起動

説明: 各ESXiホストサービスを順次再起動

for i in `hostips`;do ssh root@$i "services.sh restart";done

ESXiホストの「Up」状態にあるNICを表示

説明: ESXiホストの「Up」状態にあるNICを表示

for i in `hostips`;do echo $i && ssh root@$i esxcfg-nics -l | grep Up;done

ESXiホストの10GbE NICとそのステータスを表示

説明: ESXiホストの10GbE NICとそのステータスを表示

for i in `hostips`;do echo $i && ssh root@$i esxcfg-nics -l | grep ixgbe;done

ESXiホストのアクティブなアダプターを表示

説明: ESXiホストのアクティブ、スタンドバイ、未使用状態にあるアダプターを表示

for i in `hostips`;do echo $i && ssh root@$i "esxcli network vswitch standard policy failover get --vswitch-name vSwitch0";done

ESXiホストのルーティングテーブルを表示

説明: ESXiホストのルーティングテーブルを表示

for i in `hostips`;do ssh root@$i 'esxcfg-route -l';done

データストアでVAAIが有効化されているかを確認

説明: データストアでVAAIが有効化されているか、サポートされているかを確認

vmkfstools -Ph /vmfs/volumes/<Datastore Name>

VIBの許容レベル(Acceptance Level)をコミュニティサポートに設定

説明: VIBのアクセプタンスレベルをCommunitySupportedに設定し、サードパーティのVIBをインストール可能にする

esxcli software acceptance set --level CommunitySupported

VIBのインストール

説明: 署名確認なしでVIBをインストール

esxcli software vib install --viburl=/<VIB directory>/<VIB name> --no-sig-check

# または

esxcli software vib install --depoturl=/<VIB directory>/<VIB name> --no-sig-check

ESXiのramdiskスペースを確認

説明: ESXi ramdiskの空きスペースを確認

for i in `hostips`;do echo $i; ssh root@$i 'vdf -h';done

pynfsログのクリア

説明: 各ESXiホストのpynfsログをクリア

for i in `hostips`;do echo $i; ssh root@$i '> /pynfs/pynfs.log';done

Hyper-V

NutanixはMicrosoft Hyper-Vをサポートしており、Hyper-V上で仮想環境を実行しながら、Nutanixの分散ストレージ ファブリックを活用することができます。

本書では、Hyper-V上で動作するNutanixについて技術的な詳細を掘り下げていきます。

チャプター

- Microsoft Hyper-Vのアーキテクチャー

- NutanixにおけるHyper-Vの動作の仕組み

- Microsoft Hyper-Vのアドミニストレーション

Microsoft Hyper-Vのアーキテクチャー

Nutanix Hyper-Vクラスタが生成されると、Hyper-Vホストは、指定されたWindows Active Directoryドメインに自動的に参加する形になります。 これらのホストは、VM HAのためフェイルオーバークラスタに組み入れられます。 以上が完了すると、それぞれのHyper-VホストとフェイルオーバークラスタにADオブジェクトが作られます。

Hyper-Vのノード アーキテクチャー

Hyper-Vを導入した場合、コントローラーVM (CVM) は、VMとして稼動しディスクはディスクパススルーを使用して提供されます。

Hyper-Vの最大構成と拡張性

以下の最大構成と拡張制限が適用されます:

- 最大クラスタサイズ: 16

- VMあたりの最大vCPU数: 64

- VMあたりの最大メモリ: 1TB

- 最大仮想ディスクサイズ: 64TB

- ホストあたりの最大VM数: 1,024

- クラスタあたりの最大VM数: 8,000

注意: Hyper-V 2012 R2とAOS 6.6時点の情報です。 他のバージョンについてはConfiguration Maximumsを参照してください。

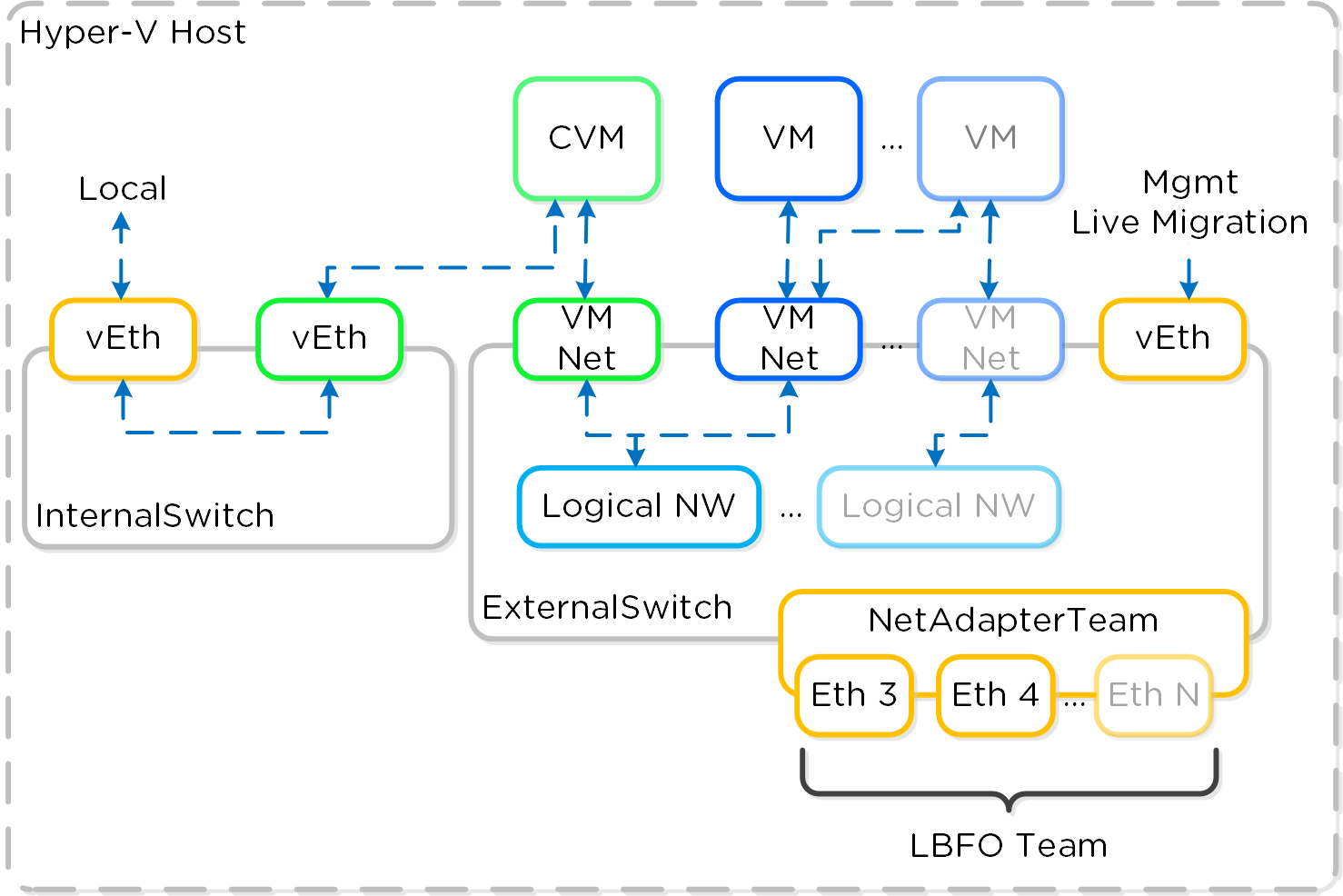

Hyper-Vのネットワーク

各Hyper-Vホストには、内部限定の仮想スイッチがあり、Nutanix CVMとホスト間の通信に使用されます。外部やVMとの通信には、外部仮想スイッチ(デフォルト)または論理スイッチが使用されます。

内部スイッチ (InternalSwitch) は、CVMとHyper-Vホスト間のローカル通信のためのものです。ホストは、内部スイッチ (192.168.5.1) 上に仮想イーサネットインターフェイス (vEth) を持ち、CVMは内部スイッチ (192.168.5.2) 上にvEthを持っています。これが基本的な通信パスとなります。

外部vSwitchは、標準的な仮想スイッチまたは論理スイッチでかまいません。外部vSwitchは、Hyper-VホストとCVMに加え、ホスト上のVMに使用される論理およびVMネットワークのためのインターフェイスをホストします。外部vEthインターフェイスはホスト管理、ライブマイグレーションなどに用いられます。外部CVMインターフェイスは、他のNutanix CVMとの通信に使用されます。トランク上でVLANが有効になっていれば、論理およびVMネットワークはいくつでも作成することができます。

以下は、仮想スイッチアーキテクチャーの概念的な構造を図示したものです:

アップリンクとチーミングポリシー

デュアルToRスイッチを使用し、スイッチHAのために両スイッチをクロスしたアップリンク構成をとることを推奨します。システムは、デフォルトで特別な構成を必要としないスイッチ非依存モードでLBFOチームを形成します。

NutanixにおけるHyper-Vの動作の仕組み

アレイオフロード - ODX

Nutanixプラットフォームは、Microsoft Offloaded Data Transfers(ODX)をサポートし、ハイパーバイザーのタスクをアレイにオフロードすることができます。 ハイパーバイザーが「仲介役」を果たす必要がなくなるため、より効率的になります。 現在Nutanixは、フルコピー(full copy)やゼロイング(zeroing)とSMBのためのプリミティブをサポートしています。 しかし、「ファストファイル (fast file)」クローン処理(書き込み可能なスナップショットを使用)が可能なVAAIとは異なり、ODXにはフルコピーを行うための同等なプリミティブが存在しません。 このため、現在nCLI、RESTまたはPowerShellコマンドレットから起動できるDSFクローン機能を利用する方がより効果的です。 現在のところ、ODXは以下の処理に使用されます。:

- DSF SMBシェア上でのVM内のまたはVMからVMへのファイルコピー

- SMBシェアファイルコピー

SCVMMライブラリ(DSF SMBシェア)からテンプレート導入

注意: シェアは、ショートネーム(つまりFQDNではない)を使用して、SCVMMクラスタに追加する必要があります。 これを簡単に行うには、クラスタのhostsファイル(つまり10.10.10.10 nutanix-130)にエントリーを追加します。

ODXは以下の処理には使用できません:

- SCVMMによるVMのクローン

- SCVMMライブラリ(非DSF SMBシェア)からテンプレート導入

- XenDesktopクローンの導入

ODXの稼動状態は、Activity Traceページの「NFS Adapter」を使って確認できます(SMB経由で実行されますが、NFSです)。 vDiskのコピー状態は「NfsWorkerVaaiCopyDataOp」、ディスクのゼロイング(zeroing)状態は「NfsWorkerVaaiWriteZerosOp」で表示されます。

Microsoft Hyper-Vのアドミニストレーション

Hyper-Vの重要なページ

近日公開!

Hyper-V コマンドリファレンス

複数のリモートホストでコマンドを実行

説明: 特定のまたは複数のリモートホストで PowerShellを実行

$targetServers = "Host1","Host2","Etc"

Invoke-Command -ComputerName $targetServers {

<COMMAND or SCRIPT BLOCK>

}

使用可能なVMQオフロードを確認

説明: 指定したホストで使用可能なVMQオフロードの数を表示

gwmi -Namespace "root\virtualization\v2" -Class Msvm_VirtualEthernetSwitch | select elementname, MaxVMQOffloads

特定のプリフィックスに一致するVMのVMQを無効化

説明: 特定のVMに対するVMQを無効化

$vmPrefix = "myVMs"

Get-VM | Where {$_.Name -match $vmPrefix} | Get-VMNetworkAdapter | Set-VMNetworkAdapter -VmqWeight 0

特定のプリフィックスに一致するVMのVMQを有効化

説明: 特定のVMに対するVMQを有効化

$vmPrefix = "myVMs"

Get-VM | Where {$_.Name -match $vmPrefix} | Get-VMNetworkAdapter | Set-VMNetworkAdapter -VmqWeight 1

特定のプリフィックスに一致するVMを起動

説明: 特定のプリフィックスに一致するVMを起動

$vmPrefix = "myVMs"

Get-VM | Where {$_.Name -match $vmPrefix -and $_.StatusString -eq "Stopped"} | Start-VM

特定のプリフィックスに一致するVMをシャットダウン

特定のプリフィックスに一致するVMをシャットダウン

$vmPrefix = "myVMs"

Get-VM | Where {$_.Name -match $vmPrefix -and $_.StatusString -eq "Running"}} | Shutdown-VM -RunAsynchronously

特定のプリフィックスに一致するVMを停止

特定のプリフィックスに一致するVMを停止

$vmPrefix = "myVMs"

Get-VM | Where {$_.Name -match $vmPrefix} | Stop-VM

Hyper-VホストRSSの設定の確認

説明: Hyper-VホストRSS (Receive Side Scaling) の設定の確認

Get-NetAdapterRss

WinshとWinRMのコネクティビティの確認

説明: WinshとWinRMのコネクティビティおよびステータスを、サンプルクエリを発行して確認。コンピューターシステムオブジェクトを返さない場合はエラーと判断。

allssh 'winsh "get-wmiobject win32_computersystem"'

Hyper-Vの指標値としきい値

近日公開!

Hyper-Vのトラブルシューティングと高度な管理

近日公開!

Backup / DR Services

確実なバックアップ戦略を持つことは、インフラストラクチャー設計において不可欠です。 本書では、ポリシー駆動型のバックアップ、DR、およびランブックによる自動化を提供するNutanix Disaster Recoveryの詳細について説明します。

チャプター

- Nutanix Disaster Recovery (ポリシー駆動型DR / ランブック)

Nutanix Disaster Recovery (ポリシー駆動型DR / ランブック)

Nutanix Disaster Recoveryの機能では、Prism Central(PC)に構成された、ポリシー駆動型のバックアップとDR、およびランブックによる自動化サービスを提供します。 この機能は長年にわたりAOSで利用可能でありPEで設定される、ネイティブDRおよびレプリケーション機能を基盤としており、それを拡張するものです。 レプリケーションなどに活用されている実際のバックエンドメカニズムの詳細については、「AOS」の「バックアップと災害復旧」セクションを参照してください。

サポートされる構成

ソリューションは以下の構成に適用できます(リストは不完全な場合があります。サポートされているものの完全なリストについては、ドキュメントを参照してください):

主なユースケース:

- ポリシーベースのバックアップとレプリケーション

- ランブックによるDR自動化

- DRaaS(マネージド サービス プロバイダーによる)

管理インターフェイス:

- Prism Central (PC)

サポートされている環境:

-

オンプレミス:

- AHV

- ESXi

- クラウド:

- NC2(AWS と Azure)

- MST(パイロットライトまたはゼロコンピュート)

アップグレード:

- AOSの一部

互換性のある機能:

- AOSの事業継続およびDR機能

主な用語

このセクション全体で使用される主な用語、以下のように定義されています:

- 復旧時点目標(RPO:Recovery Point Objective)

- 障害が発生した場合の許容可能なデータ損失を指します。 例えば、1時間のRPOが必要な場合は、1時間ごとにスナップショットを作成します。 復旧では、最大1時間前のデータをリストアします。 同期レプリケーションの場合、通常はRPOが0になります。

- 目標復旧時間(RTO:Recovery Time Objective)

- 障害発生からサービスの復旧までの期間を指します。 例えば、障害が発生してから30分でバックアップを戻して稼働状態にする必要がある場合、RTOは30分になります。

- リカバリーポイント(Recovery Point)

- 復元のポイントであり、別名はスナップショット。

実装の構造

Nutanix Disaster Recoveryには、いくつかの重要な構成要素があります:

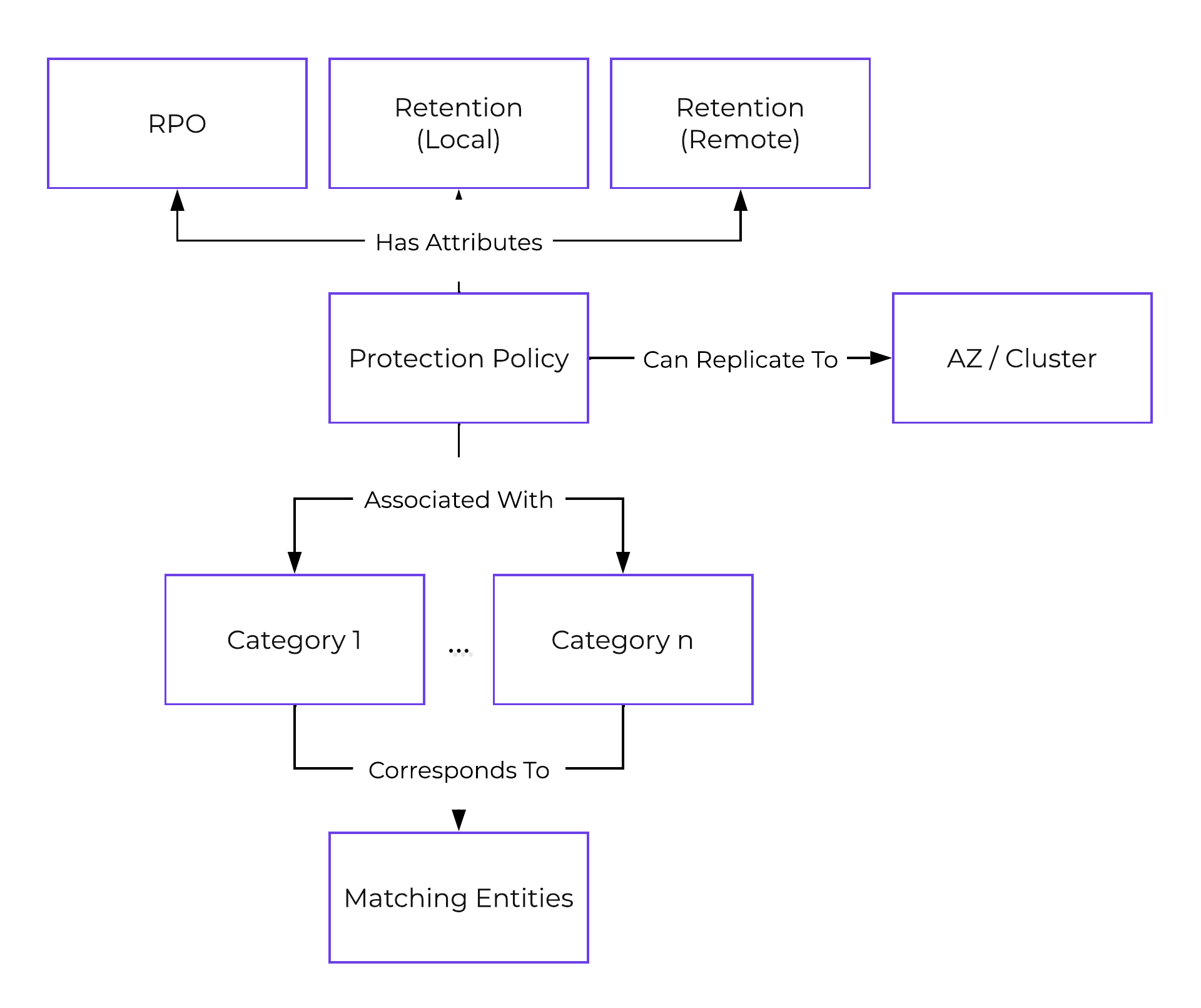

保護ポリシー(Protection Policy)

- 主な役割: カテゴリを割り当てる、バックアップとレプリケーションのポリシー

- 説明: 保護ポリシーは、RPO(スナップショット頻度)、リカバリー先の場所(リモートクラスタ)、スナップショット保持(ローカルクラスタ対リモートクラスタ)、そして割り当てるカテゴリを定義します。 保護ポリシーを使用すると、すべてがカテゴリレベルで適用されます(デフォルトでは、Any / Allに適用できます)。 これは、仮想マシンを選択する必要がある保護ドメイン(Protection Domain)とは異なります。

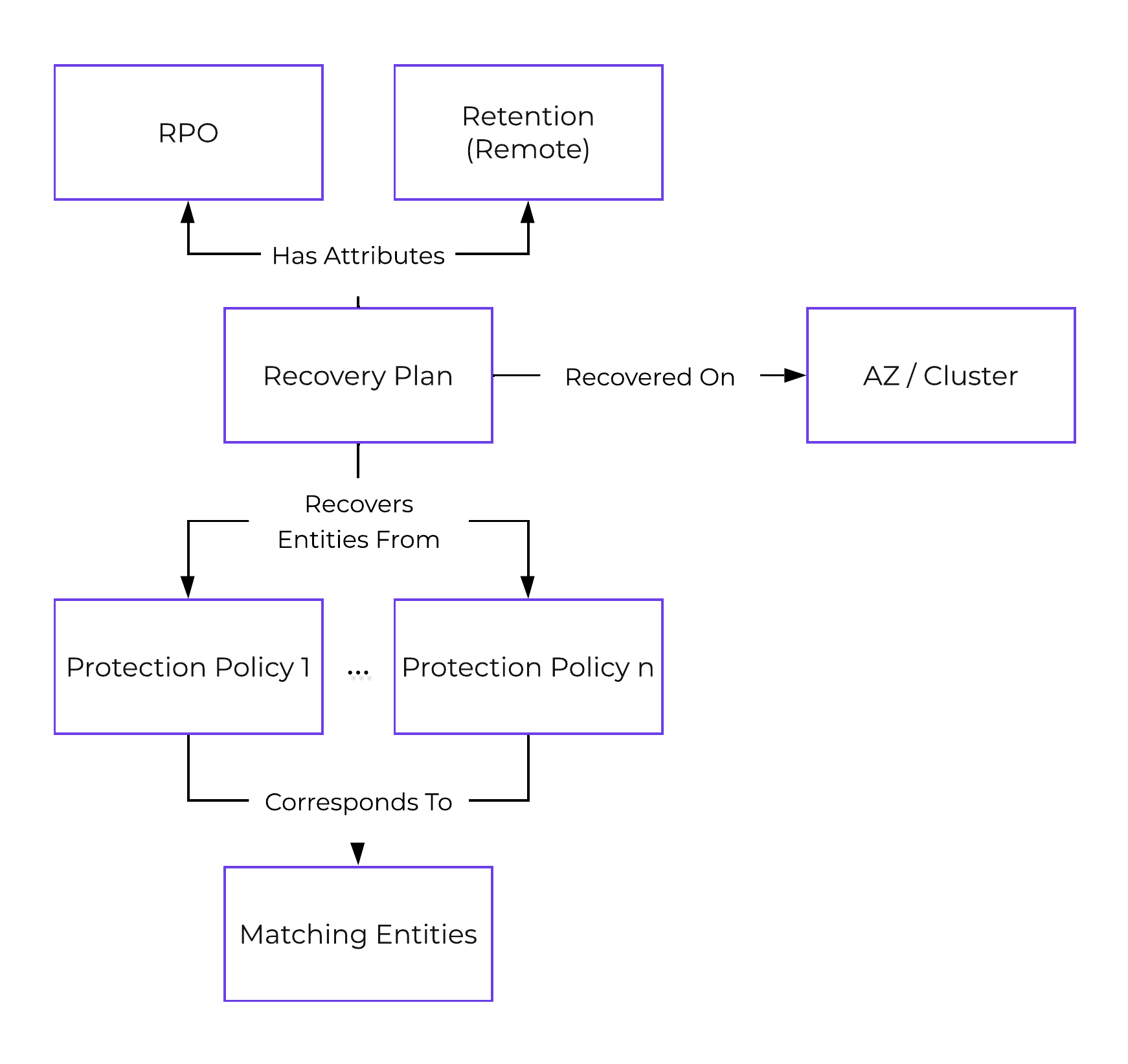

下記の図は、保護ポリシーの構造を示します:

リカバリープラン

- 主な役割: DR ランブック

- 説明: リカバリープランは、パワーオンの順序(カテゴリまたは仮想マシン/VGを指定可能)およびネットワークのマッピング(プライマリ、リカバリおよびテストサイトにおける、フェイルオーバーとフェイルバック)を定義するランブックです。 これはSRMを利用することと同義です。 注: リカバリープランを構成する前に、保護ポリシーを構成する必要があります。 これは、復旧のためには、データがリカバリサイトに存在する必要があるために必要です。

以下の図は、リカバリープランの構造を示します:

リニア保持ポリシー(Linear Retention Policy)

- 主な役割: リカバリーポイントの保持ポリシー

- 説明: リニア保存ポリシーは、保持するリカバリーポイントの数を指定します。 例えば、RPOが1時間で、保持が10に設定されている場合、10時間(10 x 1時間)のリカバリーポイント(スナップショット)を保持します。

ロールアップ保持ポリシー(Roll-up Retention Policy)

- 主な役割: リカバリーポイントの保持ポリシー

-

説明: ロールアップ保持ポリシーは、RPOと保存期間に応じて「ロールアップ」スナップショットを作成します。

例えば、RPOが1時間で保持期間が5日に設定されている場合、1日保持の1時間ごとの、そして5日間の最新の日次リカバリーポイントが保持されます。

ロジックは次のようになります:

- 保持期間がn日の場合、RPOは1日で、n日分の最新のリカバリーポイントを保持します。

- 保持期間がn週間の場合、RPOは1日で、1週間分の日次リカバリーポイント、n個の最新の週次リカバリーポイントを保持します。

- 保持期間がnか月の場合、RPOは1日で、1週間分の日次リカバリーポイント、1か月分の週次リカバリーポイント、nか月間の月次リカバリーポイントを保持します。

- 保持期間がn年の場合、RPOは1日で、1週間分の日次リカバリーポイント、1か月分の週次リカバリーポイント、1年間の月次リカバリーポイント、n個の最新の年次リカバリーポイントを保持します。

リニア保持ポリシー対ロールアップ保持ポリシー

保持期間が短い小さなRPOウィンドウや、常に特定のRPOウィンドウに復旧できるようにする必要がある場合には、リニア保持ポリシーを使用します。

保持期間が長いものにはロールアップ保持ポリシーを使用します。 柔軟性が高く、スナップショットのエージングやプルーニングを自動処理すると同時に、運用開始時むけの期間の細かいRPOを提供します。

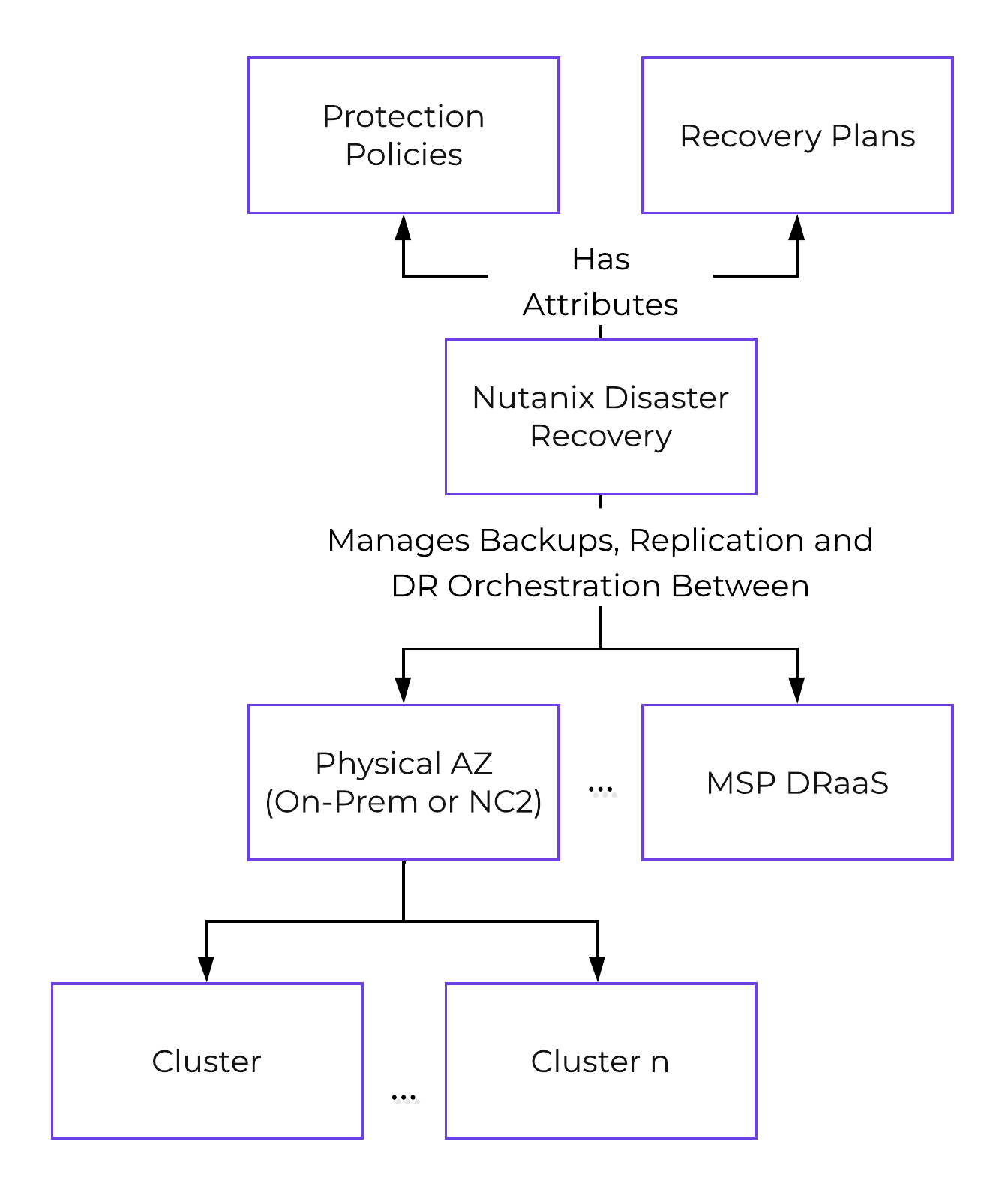

以下に、Nutanix Disaster Recoveryの構成の概要を示します:

使用方法と構成

このセクションでは、Nutanix Disaster Recoveryを構成して利用する方法について説明します。

おおまかなプロセスは、以下の手順となります:

- アベイラビリティ ゾーン(AZ)に接続する

- 保護ポリシーを構成する

- リカバリープランを構成する

- 実行またはテストとしての、フェイルオーバーとフェイルバック

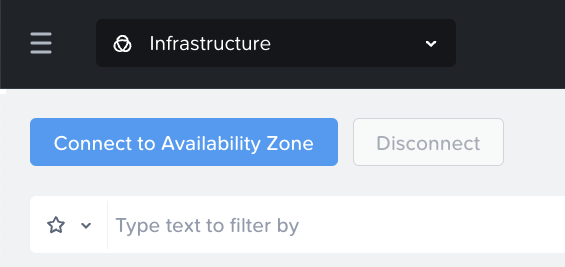

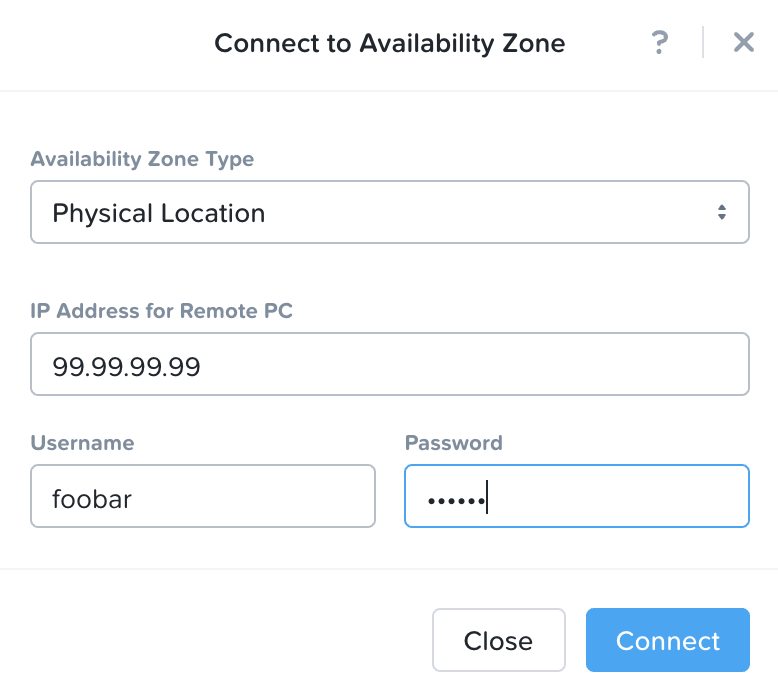

アベイラビリティ ゾーンへの接続

最初の手順は、別のAZに接続することで、これはオンプレミスのAZ、またはクラウドにあるNC2です。

PCで「Availability Zones」を検索するか、「管理」→「Availability Zones」に移動します:

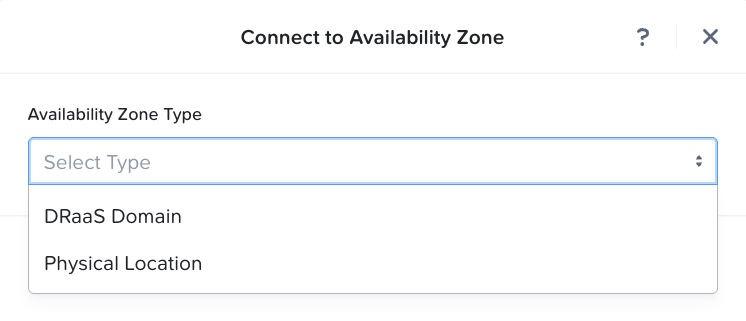

「アベイラビリティ ゾーンに接続」をクリックして、アベイラビリティ ゾーン タイプ(「DRaaS Domain」またはPCインスタンスである「Physical Location」)を選択します。

PCまたはDRaaS Domainの資格情報を入力し、「接続」をクリックします。

接続されたAZが表示され、使用できるようになります。

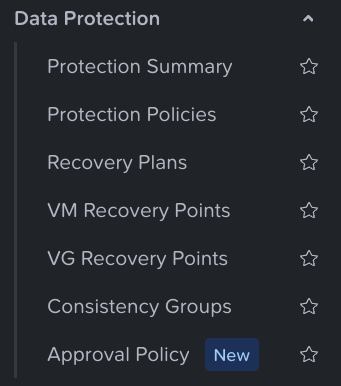

保護ポリシーの構成

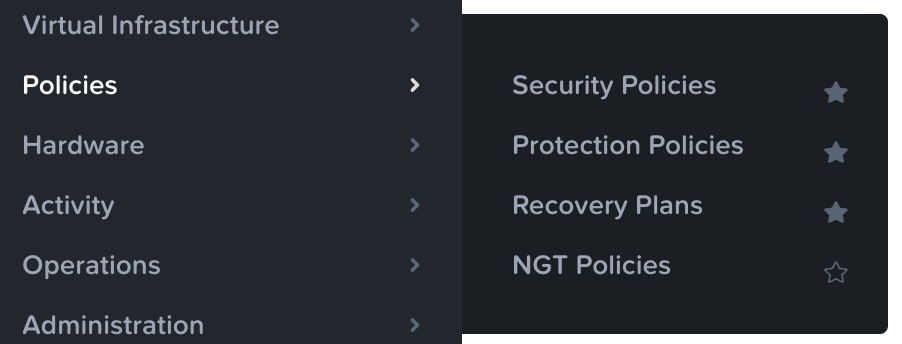

PCで「Protection Policies」を検索するか、「Data Protection」→「Protection Policies」に移動します。

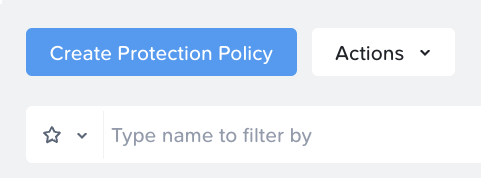

「Create Protection Policy」をクリックします。

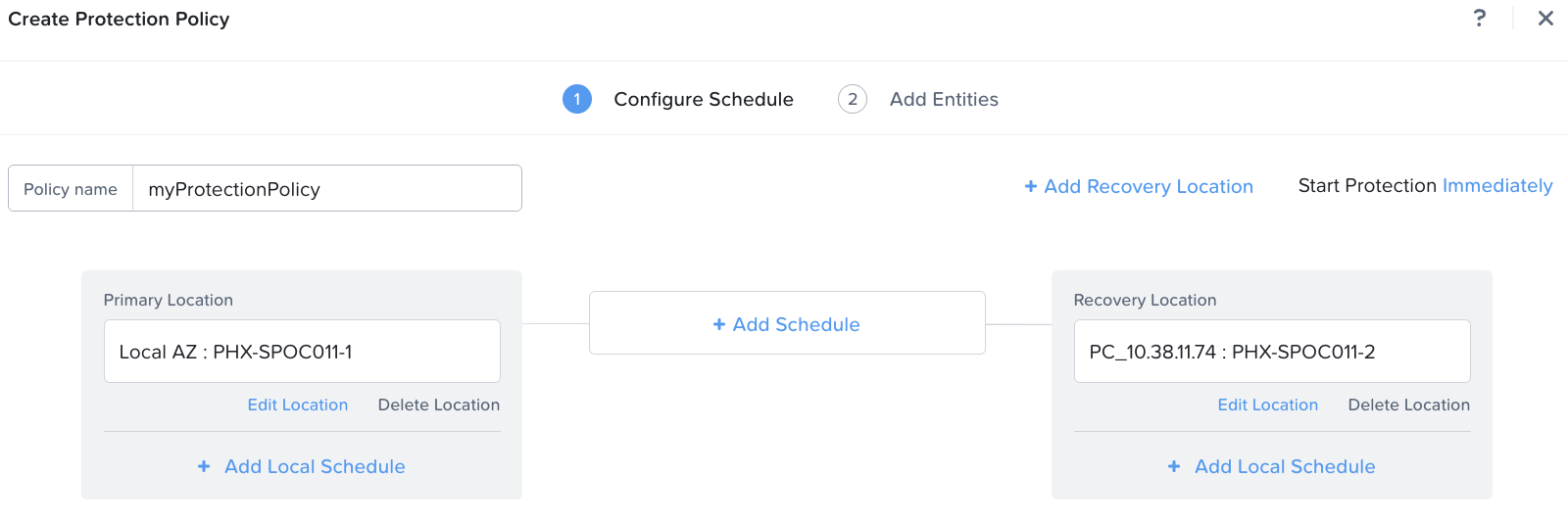

設定したい名前を入力し、ソースのAZとクラスタを選択して 「保存」をクリックします。 リカバリーロケーションのAZとクラスタを選択して、「保存」をクリックします。

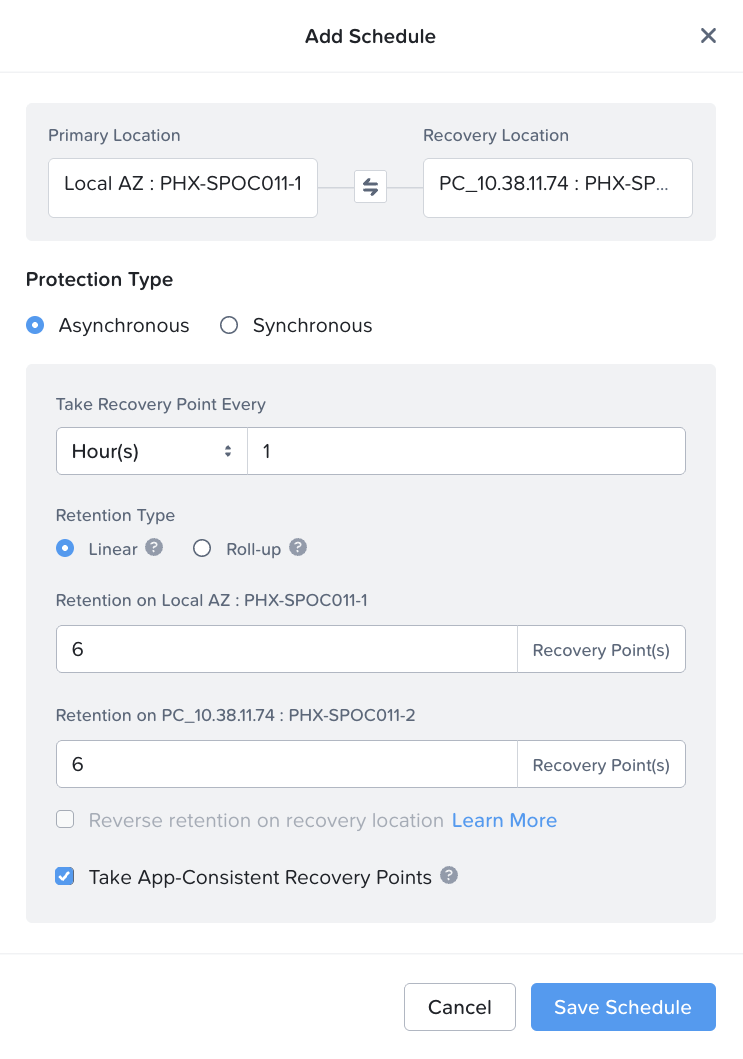

プライマリとリカバリーロケーションの間にある「Add Schedule」をクリックし、スナップショットやレプリケーションの頻度、保持期間、その他の詳細を追加します。

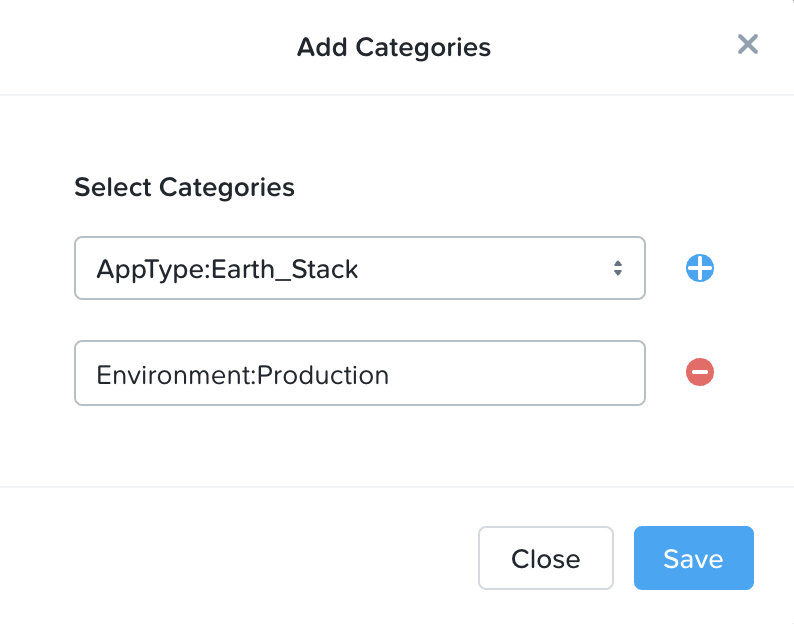

次に、ポリシーを適用するカテゴリを選択します。

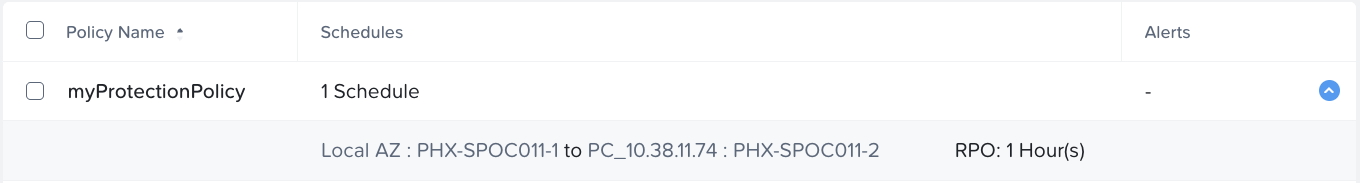

「作成」をクリックすると、新しく作成された保護ポリシーが表示されます。

リカバリープランの構成

PCで「リカバリー プラン」を検索するか、「Data Protection」→「Recovery Plans」に移動します。

最初の起動時に、最初のリカバリープランを作成するための画面が表示されます。

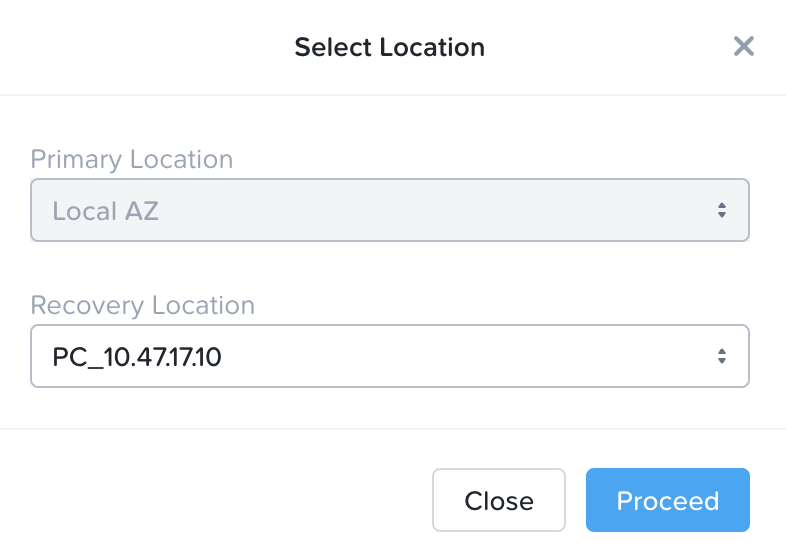

ドロップダウンを使用して「リカバリーロケーション」を選択します:

注:これは、DRaaS DomainのAZまたはPhysical AZ(対応する管理対象クラスタを持つPC)のいずれかです。

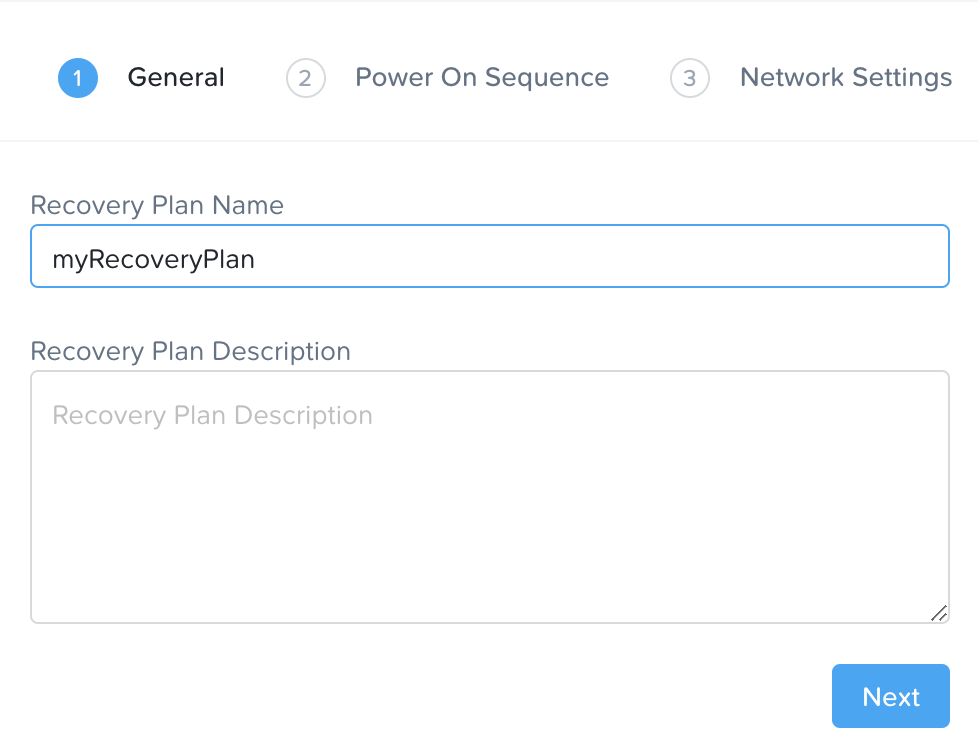

リカバリープランの名前と説明を入力し、「次へ」をクリックします。

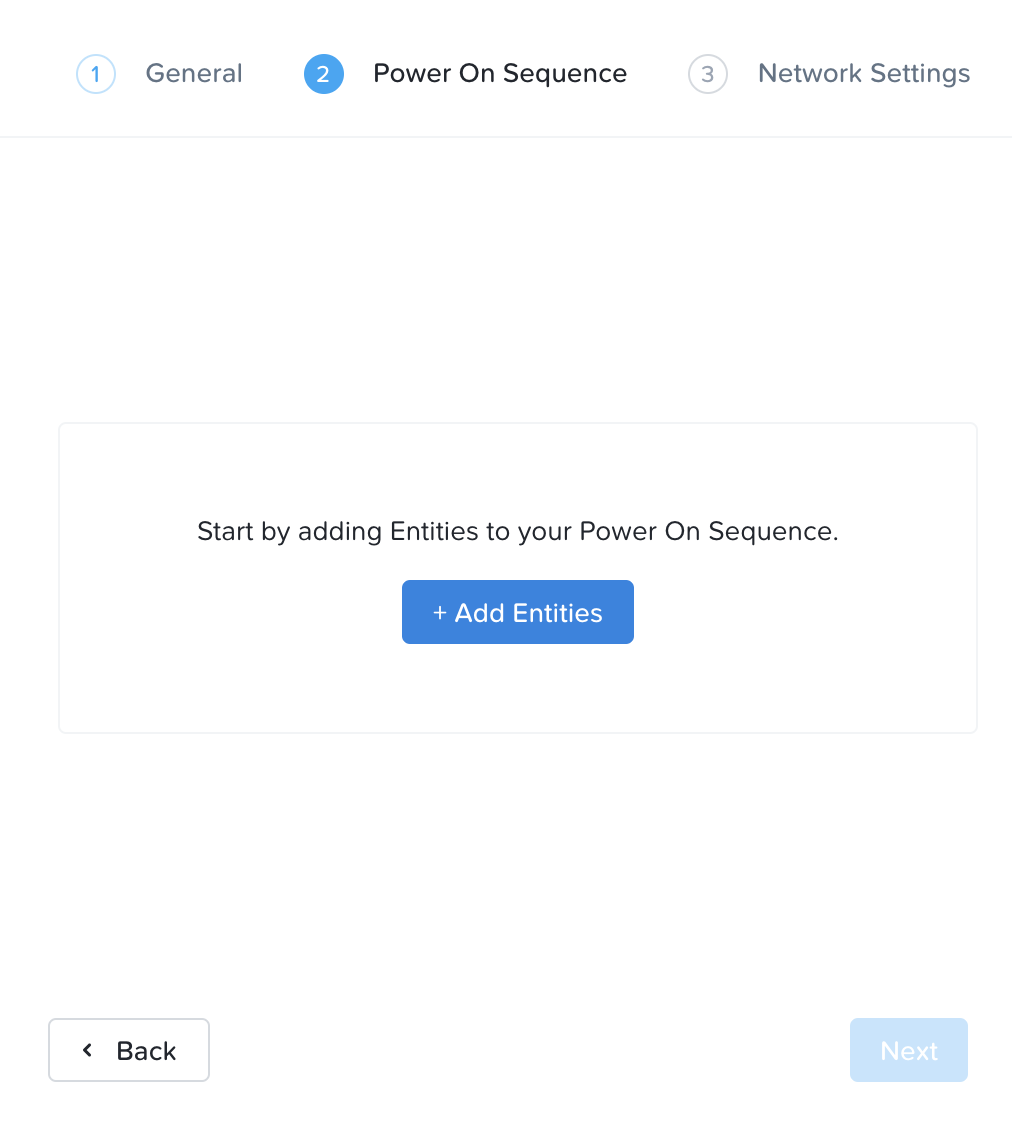

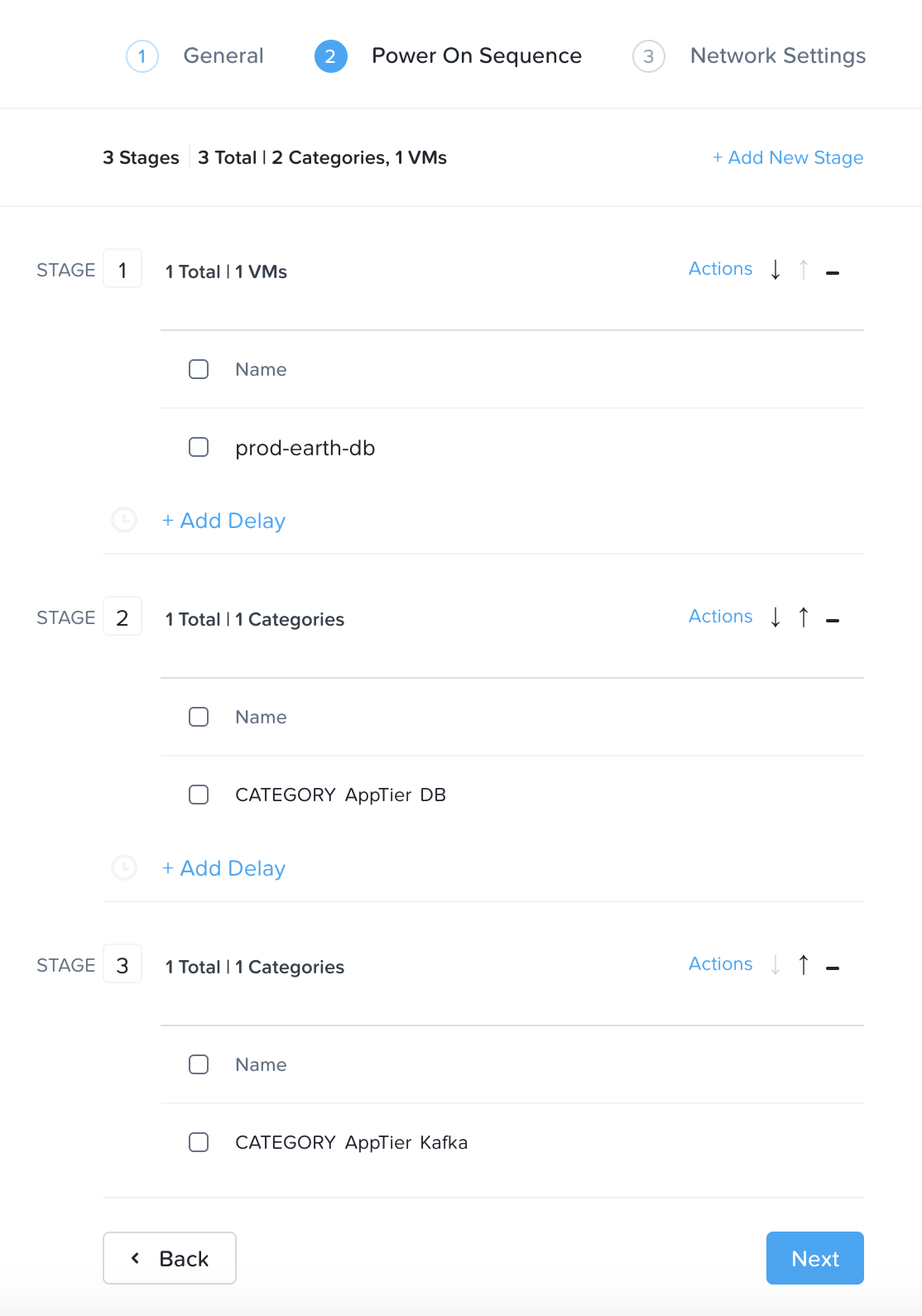

次に「+ VM(s)」をクリックして、パワーオンのシーケンスを指定します。

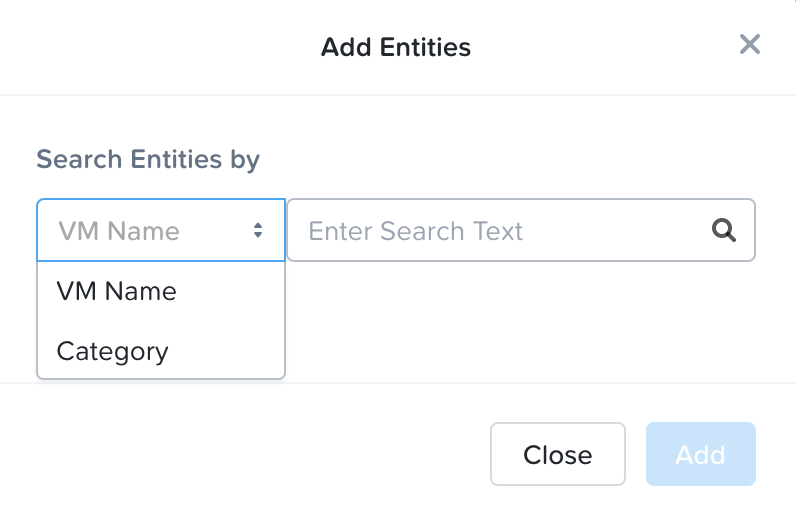

仮想マシン名またはカテゴリを検索して、各ステージに追加します。

各ステージのPower On Sequenceが適切になったら、「次へ」をクリックします。

パワーオンのシーケンス

Power On Sequenceを決定するときは、次のようにステージ設定する必要があります:

- Stage 0: Core サービス (AD、DNSなど)

- ステージ1: ステージ0サービスに依存し、ステージ2サービスに必要なサービス(例えばDB層)

- ステージ2: ステージ1サービスに依存し、ステージ3サービスに必要なサービス(例えばApp層)

- ステージ3: ステージ2サービスに依存し、ステージ4サービスに必要なサービス(例えばWeb層)

- ステージ4-N: 依存関係に基づいて繰り返す

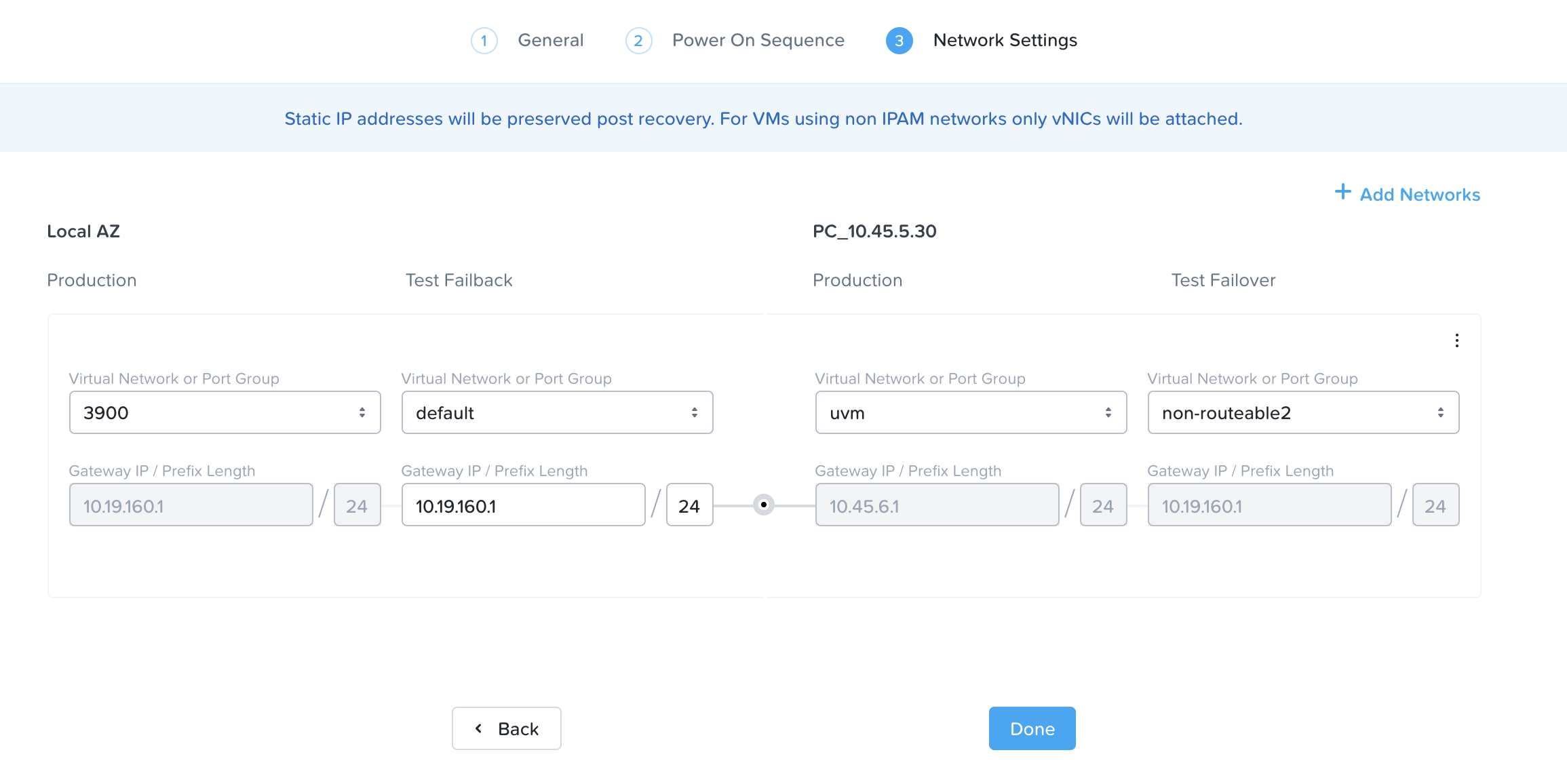

次に、ソースとターゲットの環境の間でネットワークをマッピングします。

フェイルオーバーおよびフェイルバックのネットワーク

ほとんどの場合で、テストネットワークには、ルーティング不可能な、または分離されたネットワークを使用します。 これにより、SIDの重複、ARPエントリーなどの問題が発生しなくなります。

Nutanixへの移行

Nutanix Move

Nutanix Move(または単にMove)は、仮想マシン(VM)やファイル サーバーを最小限のダウンタイムで移行する、クロス ハイパーバイザー モビリティ ソリューションです。 MoveはNutanixの顧客に無料で提供されており、Nutanix Support Portal からダウンロードできます。

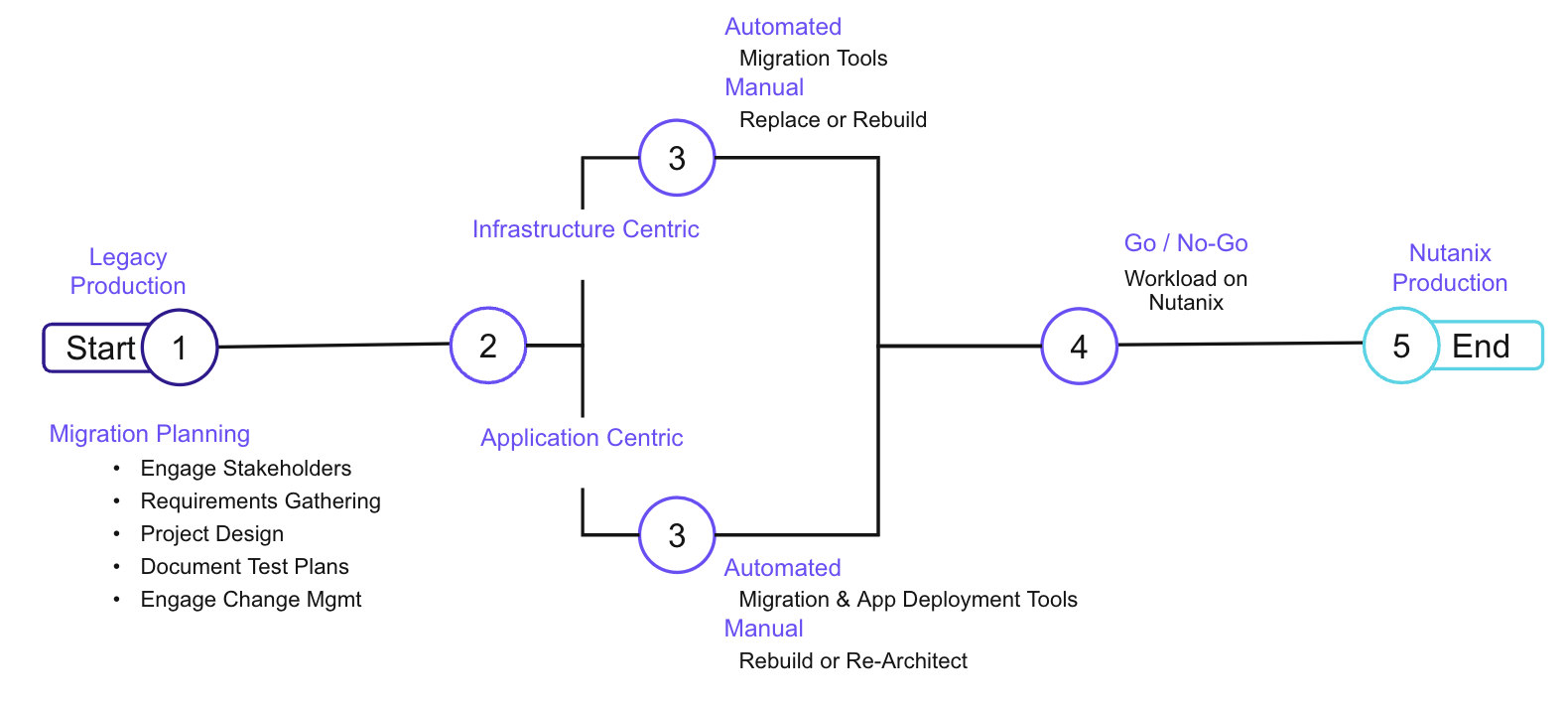

仮想マシン移行の手法

Moveを使用することで、インフラストラクチャー中心(Infrastructure Centric)の移行とアプリケーション中心(Application Centric)の移行を選択できます。

- インフラストラクチャー中心の移行は、従来のインフラストラクチャーとNutanix Cloud Platformが同じVLANにアクセスできる場合に適しています。

- アプリケーション中心の移行は、アプリケーションや、そのアプリケーションをサポートするすべてのサーバー(ファイル サーバーやデータベースなど)を移行したい場合に適しています。

Nutanix Moveに関する詳細は、以下のリソースをご覧ください:

- Nutanix.com の、アプリケーションのクラウド移行 ソリューション ページ

- デモ: Nutanix Move Overview

本書では、以下のチャプターでNutanix Moveのアーキテクチャーと移行について解説します。

チャプター

- 仮想マシンの移行

- 仮想マシン移行のアーキテクチャー

- ファイル サーバーのマイグレーション

仮想マシンの移行

Note

Nutanix Moveを使用した仮想マシン移行のハンズオンに興味がありますか? Nutanix Test Driveで試してみましょう!

https://www.nutanix.com/test-drive-migrate-applicationsNutanix Moveは、ESXiやHyper-Vなどのさまざまなハイパーバイザーから、またはAWS EC2、VMware Cloud(VMC)on AWS、Microsoft Azureから、Nutanix Cloud Platformに仮想マシンを移行できます。 サポートされている移行の最新リストについては、Move User Guide をご確認ください。

Moveでは、仮想マシンの移行にむけて、さまざまな移行プランを作成できます。 以下は、仮想マシン移行プランのベスト プラクティスです。

仮想マシン移行のベスト プラクティス

- 移行対象となる仮想マシンのグループ化

- 複数のホストから並列で移行

- 移行プランごとに最大50台の仮想マシン

- ESXiの移行では、最大100台の仮想マシンをサポート

- スケジュールの最適化

- カットオーバー前に仮想マシンのデータを事前にシードする

- カットオーバーは初回の事前シードから1週間以内に実行する

- シード期間が長くなると、ソース仮想マシンでのディスク使用量が増加する可能性がある

- ゲストOSでの準備

- 仮想マシンの準備が失敗する2つの主な理由:UACとWinRM

- 仮想マシンの準備に関する問題をトラブルシュートするために、マニュアルモードに切り替える

- データベースサーバーの移行

- Moveは、同等(Like-for-Like)の移行をサポートしている

- データベース サーバーの移行はベスト プラクティスに従う必要があり、リプラットフォームが必要になる場合があります。

- Moveはデータベースの移行が可能ですが、移行後にベスト プラクティスを適用する必要があります。

仮想マシン移行のアーキテクチャー

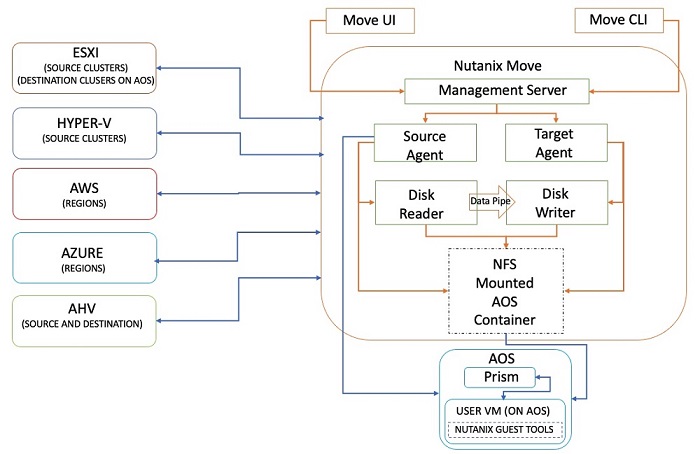

Moveのアーキテクチャー

Nutanix Moveは、通常はターゲットとなるAHVクラスタにホストされる、仮想マシン アプライアンスです。 Nutanix Moveは複数のソフトウェア サービスによって構成されており、次の主要なソフトウェア コンポーネントに分類できます。

- 管理サーバー

- 管理サーバーは、ソースおよびターゲットクラスタの情報、移行プランの詳細、および現在のステータスを保持します。 また、APIやUIを使用して移行プランを作成および管理できます。

- ソースおよびターゲットのエージェント

- ソース エージェントは、プラットフォーム固有(ESXi、Hyper-V、AHV、またはクラウド)のソフトウェア コンポーネントであり、ディスク リーダーを通じて移行のコピー リクエストをスケジュールします。 これはソース クラスタと仮想マシンの詳細を収集しており、管理サーバーのUIを使用して移行する仮想マシンを選択する際に役立ちます。

- ディスクのリーダーとライター

- ディスク リーダー プロセスは、ソース固有のAPIを使用してデータを読み取り、ディスク ライター プロセスと連携して未完のコピー操作を完了します。 ディスク リーダーは、コピー操作のチェックポイントを作成して障害を処理し、必要に応じて操作を再開します。

Moveが使用する各ソース環境のアーキテクチャーはわずかに異なりますが、Nutanixはその実装の違いをユーザーから見えないようにしています。

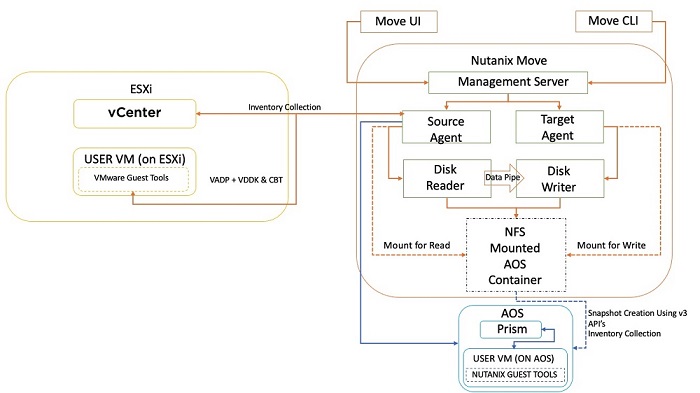

Nutanix Move for ESXi

Nutanix Move for ESXiのアーキテクチャーでは、インベントリの収集にvCenterを使用し、データ移行にはvSphere Storage API for Data Protection(VADP)、Virtual Disk Development Kit(VDDK)、Changed Block Tracking(CBT)を使用します。

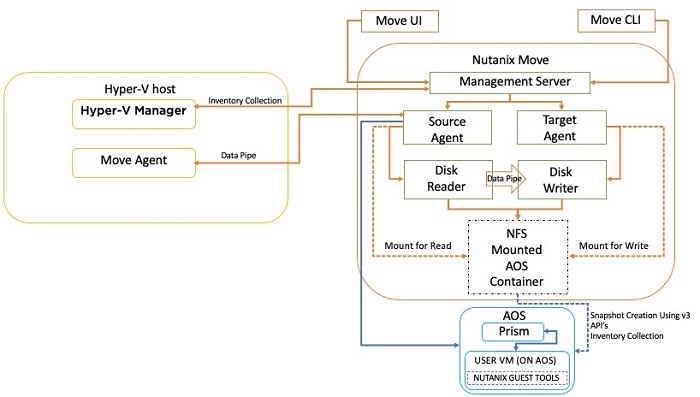

Nutanix Move for Hyper-V

Nutanix Move for Hyper-Vのアーキテクチャーでは、Hyper-Vクラスタを構成する各Hyper-Vサーバーにエージェントが配置されています。 そして、エージェントを使用してデータを移動し、インベントリの収集にはHyper-V Managerを使用します。

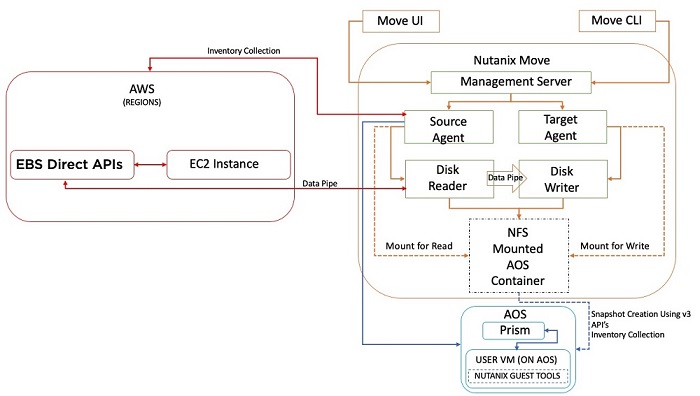

Nutanix Move for AWS

Nutanix Move for AWSのアーキテクチャは、他の環境でのMoveとは多少異なります。 AWSを環境として追加すると、Moveアプライアンスはインベントリ収集のためにAWSに接続し、データ移行にはElastic Block Store (EBS) direct APIを使用します。 Moveは、以前のバージョンで行っていたようにエージェント仮想マシンを作成しなくなりました。

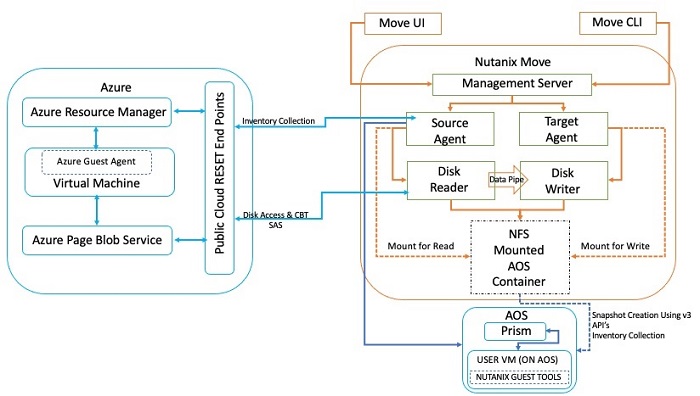

Nutanix Move for Azure

Nutanix Move for Azureのアーキテクチャは、インベントリの収集やストレージへのアクセスにAzure REST APIを使用する点で、Move for AWSのアーキテクチャと類似しています。

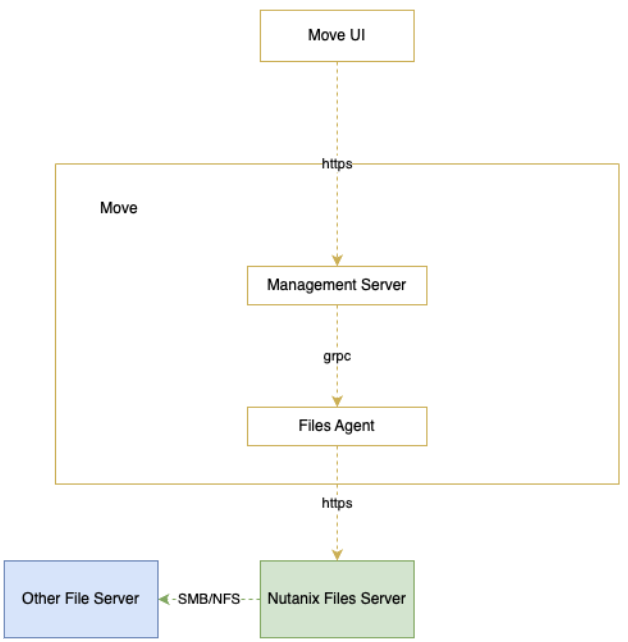

ファイル サーバーの移行

ファイル サーバー移行のアーキテクチャー

- Move はコントロールプレーンです。

- Nutanix Filesはデータプレーンです。

- MoveはNutanix Files v4 APIを使用してファイルの移行をオーケストレーションし、Nutanix FilesはSMBまたはNFSを使用してソースからデータをコピーします

- 同じMoveアプライアンスで、ファイルと仮想マシンの両方の移行を実行できます。

前提要件

Moveによるファイル移行の前提要件

- Moveバージョン5.0以降が、ファイル移行をサポートしています。

- Moveから移行先のNutanix Filesサーバーに、TCPポート9440を介して接続できる必要があります。

移行先Nutanix Filesサーバーの前提要件

- Nutanix Files 4.4以降(Migration APIのサポートはFiles 4.4で追加されました)

- ユーザー名とパスワードが設定されているAPIユーザーを作成します。

- ソースとなるサーバーへのNFS/SMBによるネットワーク アクセスは、ターゲットのNutanix Filesサーバーから行います。

- Target share should not have MaxSize (storage limit) configured ターゲット共有には、maxSizeGib(ストレージ制限)が構成されていない必要があります

SMBソース(ファイル サーバーから)の前提要件

- Backup Operatorsグループ ユーザーのユーザ名とパスワードが必要。

- SMBバージョン2以降であること。

NFSソースの前提要件

- 移行対象の共有でroot squashが無効であること。

- 移行対象の共有でAUTH_SYSがサポートされていること。

- NFS V3がサポートされていること。

ベスト プラクティス

- 現在、5つの同時移行が許可されています。 そのため、並行して移行できる共有/共有パスは5つまでです。

- 少数の移行を実行し、それらを完了してから他の移行を開始してください。 これにより、カットオーバー時間が最短になります。

- Moveは、24時間ごとに増分同期を実行します。

- カットオーバーを開始する前に、ソースの共有を読み取り専用モードにする必要があります。 カットオーバー中に、Moveは最終の同期を実行して移行を完了します。

- 移行プランを一時停止しても、進行中の同期がある場合は、他の移行のために並列パイプを解放しません。 進行中の同期が完了してから、移行を一時停止することをお勧めします。

トラブルシュート

サポート バンドルの収集

UIからMoveサポート バンドルをダウンロードする。

UIからリアルタイム ログをダウンロードする。

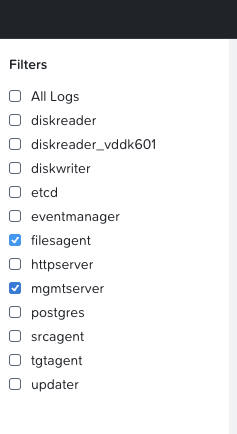

filtersで、filesagentとmgmtserverを選択する。

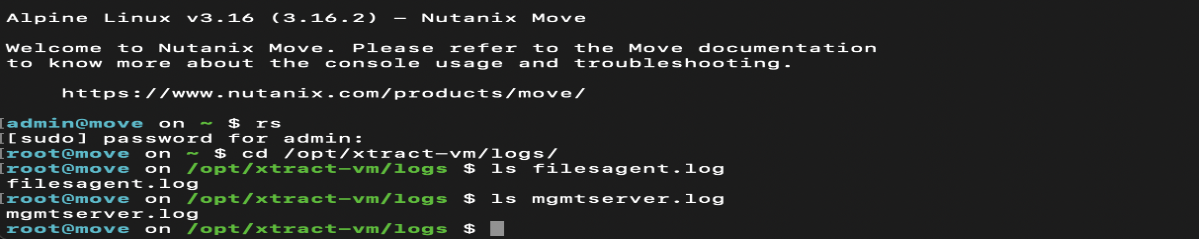

ログ ファイルの場所

- /opt/xtract-vm/logs

ファイル移行のためのMoveサービスは、filesagentです。

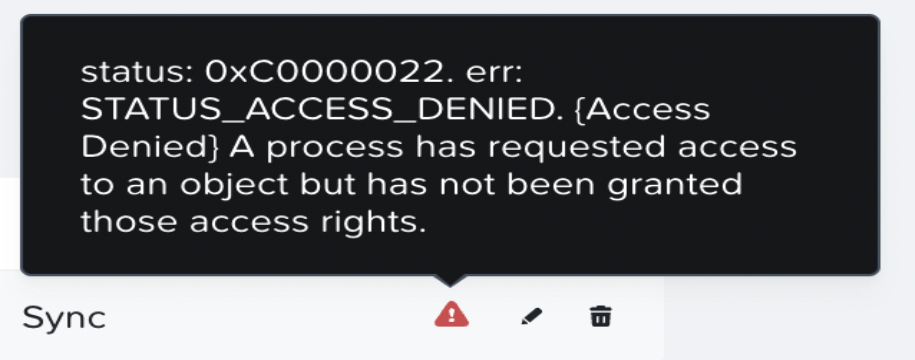

ユーザー権限が原因でSMB共有の移行が失敗した場合、次のようなメッセージが表示されます。

- 解決策: ユーザーをBackup Operatorsグループに追加する。

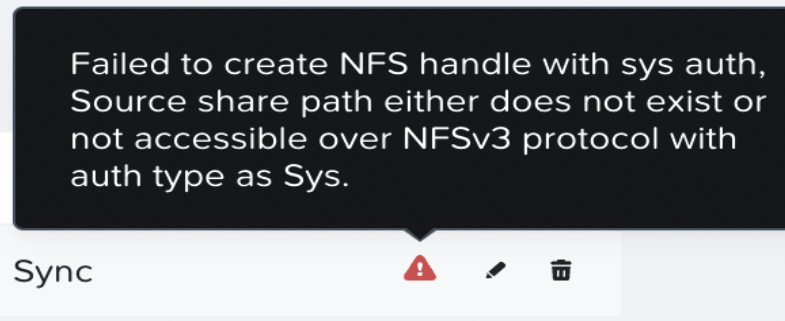

NFS移行が、認証タイプsysが構成されていないために失敗します。

- 解決策: 認証をSYSTEMに変更する。

Storage

Unified Storage Services

当初、Nutanixは仮想マシン データのための最適化されたストレージ サービスを提供することに焦点を当てていました。 その後、Nutanix Volumesの導入によって、任意のオペレーティン グシステムがストレージ システムにアクセスできるように拡張し、これにより共有ディスクや、ベアメタル環境からの接続(あるいはゲストOSのiSCSIイニシエーター接続)のようなユースケースで使用できます。 さらにNutanix Filesの導入で、プラットフォームを高可用性のファイルサーバーとして使用する機能を提供できるように拡張しました。 最後に、Nutanix Objectsでは、S3準拠のAPIで使用できる、非常にスケーラブルなオブジェクトストレージを提供します。

本書では、これらのストレージ サービスの各機能について詳しく解説します。

チャプター

- Volumes (ブロックサービス)

- Files (ファイルサービス)

- Objects(オブジェクトサービス)

Volumes (ブロックサービス)

Nutanix Volumesは、バックエンドにあるDSFストレージを、iSCSI経由で外部ユーザー(ゲストOS、物理ホスト、コンテナなど)に提供する機能です。

本機能によって、オペレーティングシステムは、DSFにアクセスしてストレージ機能を利用できるようになります。この導入シナリオにおいて該当OSは、ハイパーバイザーを経由することなく、Nutanixに直接アクセスすることになります。

Volumesの主要なユースケース:

- 共有ディスク

- Oracle RAC、Microsoft Failover Clusteringなど

- ファーストクラスのエンティティとしてのディスク

- 実行コンテキストが短命かつデータが重要な場合

- コンテナなど

- ゲスト内iSCSIイニシエータ

- ベアメタルのコンシューマ

- vSphere上のExchange(Microsoftのサポートのため)

資格要件を満たしたオペレーティングシステム

本ソリューションは、iSCSI仕様に準拠しており、QAによって以下のオペレーティングシステムが検証済みとなっています。

- Microsoft Windows Server 2008 R2, 2012 R2

- Red Hat Enterprise Linux 6.0+

Volumesの構成

Volumesは、以下のエンティティで構成されています:

- データサービスIP: iSCSIログイン リクエストで使用されるクラスタ全体のIPアドレス (4.7で導入)

- ボリュームグループ: iSCSIのターゲットで、集中管理、スナップショット、ポリシーアプリケーションの対象となるディスクデバイスのグループ

- ディスク: ボリュームグループ内のディスク(iSCSIターゲットのLUNとして見える)

- アタッチメント: ボリュームグループに対する特定のイニシエータIQNアクセスを許可

- シークレット: CHAP/Mutal CHAPの認証情報に使用するシークレット

注意: バックエンドでは、VGのディスクは単にDSF上のvDiskとなります。

前提

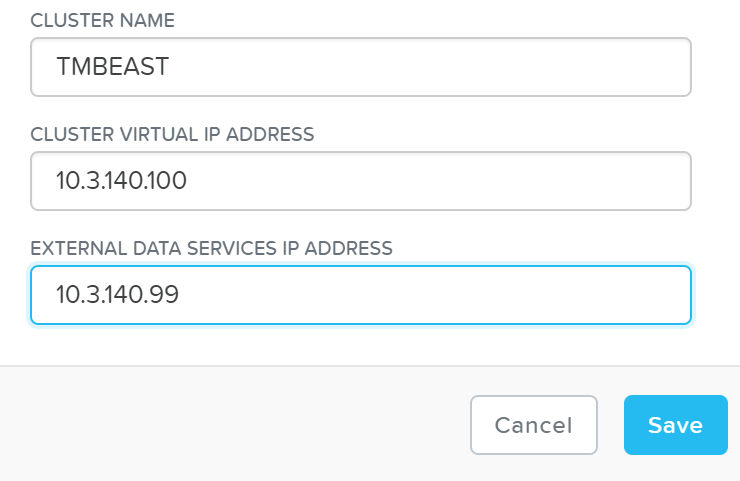

設定を行う前に、セントラルディスカバリ / ログインポータルとして機能するデータサービスIPを設定する必要があります。

設定は「Cluster Details(クラスタ詳細)」ページから行います。(歯車アイコン -> Cluster Details)

nCLI / API経由でも設定が可能です:

ncli cluster edit-params external-data-services-ip-address=<DATA SERVICES IP ADDRESS>

ターゲットの作成

Volumesを使用するためには、まずiSCSIのターゲットとなる「Volume Group(ボリュームグループ)」を作成する必要があります

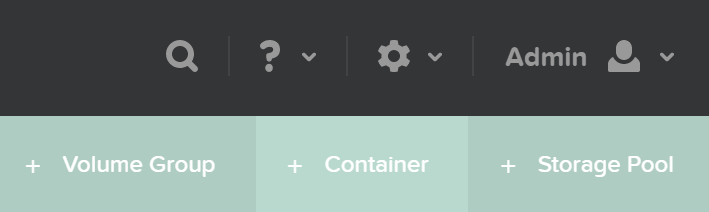

「Storage(ストレージ)」ページの右側にある「+ Volume Group(ボリュームグループの追加)」をクリックします:

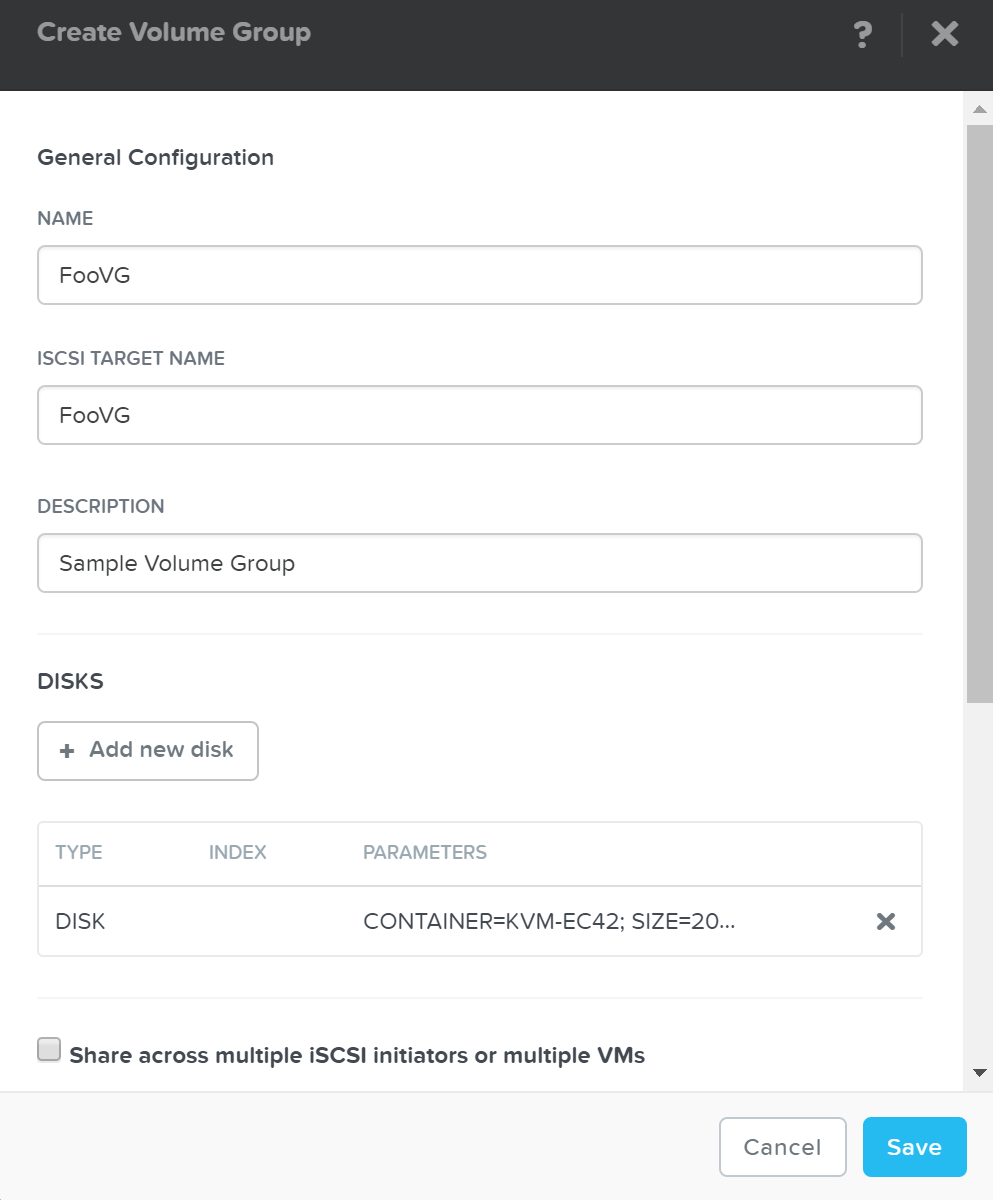

VG詳細を設定するメニューが表示されます:

次に「+ Add new disk(ディスクの追加)」をクリックして、ターゲット(LUNとして見える)にディスクを追加します。

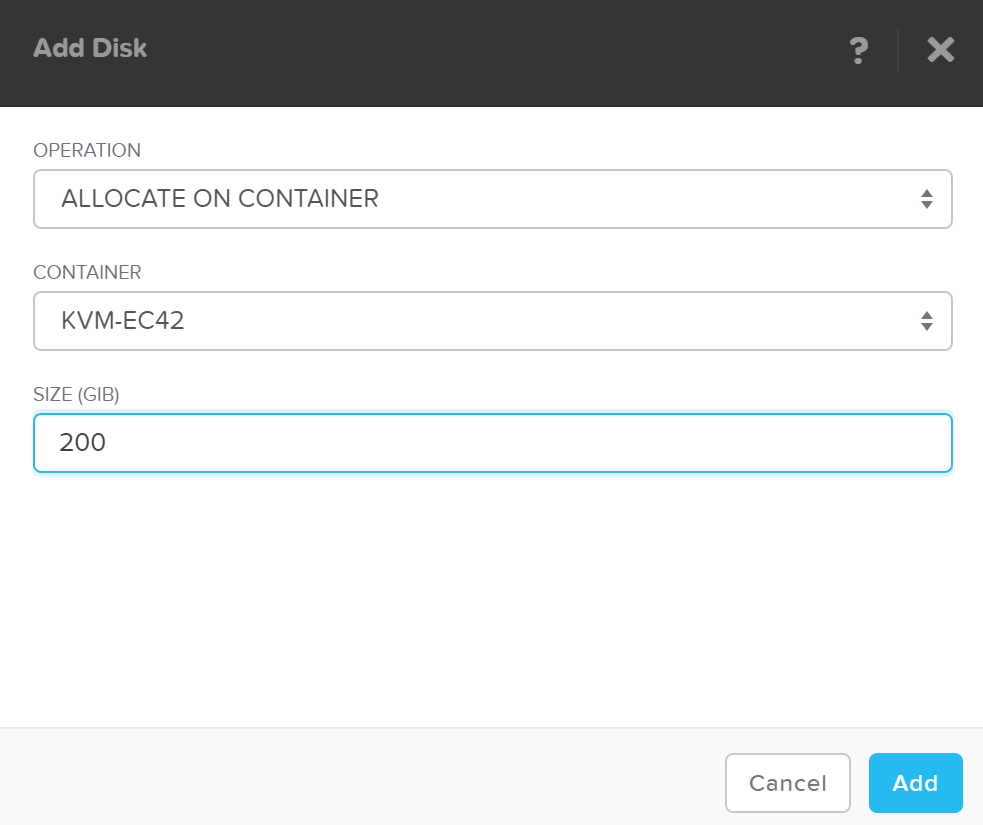

メニューが表示されたら、ターゲットとなるコンテナとディスクサイズを選択します:

「Add(追加)」をクリックし、必要に応じて繰り返しディスクを追加します。

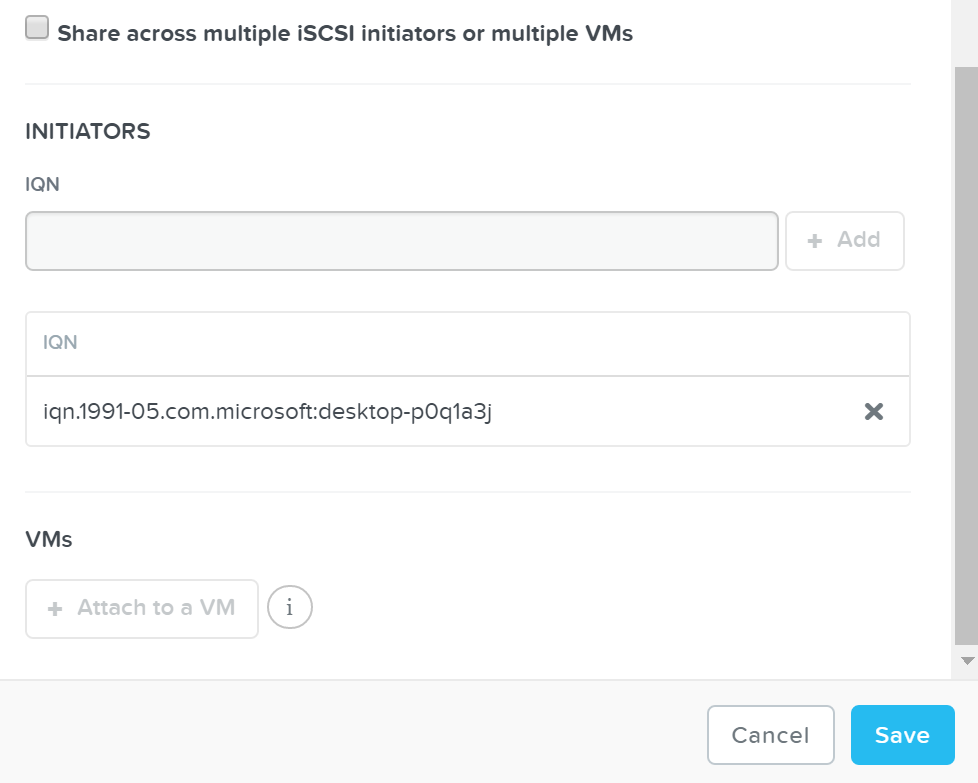

詳細を設定し、ディスクを追加したら、ボリュームグループをVMまたはイニシエータIQNにアタッチします。これによって、VMがiSCSIターゲットにアクセスできるようになります(未知のイニシエータからのリクエストは拒否されます):

「Save(保存)」をクリックします。これでボリュームグループの設定は完了です!

aCLI / API経由でも、同様の対応が可能です:

VGの作成

vg.create <VG Name>

VGにディスクを追加

vg.disk_create <VG Name> container=<CTR Name> create_size=<Disk size, e.g. 500G>

イニシエータIQNをVGにアタッチ

vg.attach_external <VG Name> <Initiator IQN>

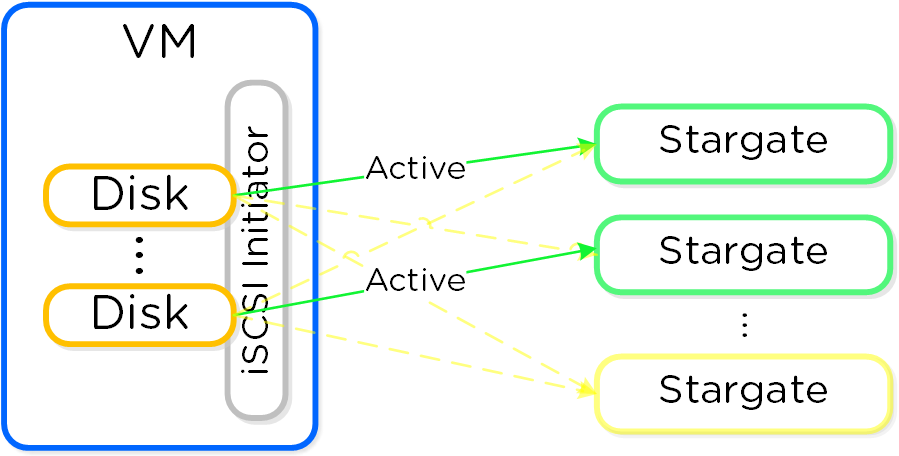

パスの高可用性 (HA)

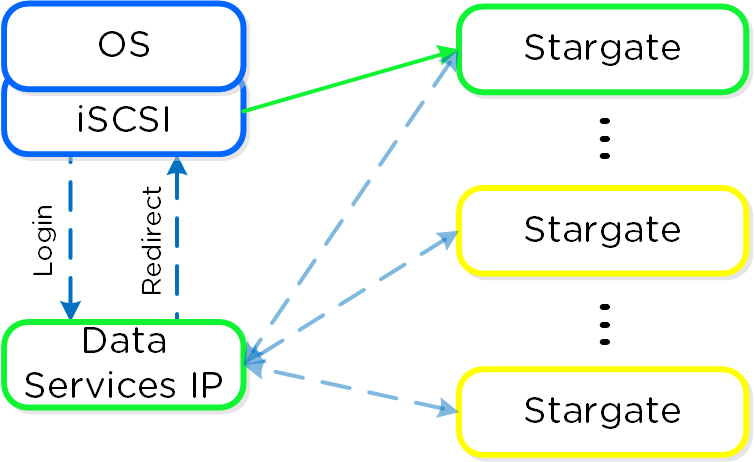

前述の通り、データサービスIPはディスカバリに使用されます。 これによって、個々のCVM IPアドレスを知る必要なく、1つのアドレスのみを使用できます。

データサービスIPは、現状のiSCSIリーダーに割り当てられます。 障害が発生すると、新しいiSCSIリーダーが選択され、データサービスIPが割り当てられます。 これにより、ディスカバリポータルは常時使用可能な状態になります。

iSCSIイニシエータは、データサービスIPによりiSCSIターゲットポータルとして設定されます。ログインリクエストが発生すると、プラットフォームはiSCSIログインを正常なStargateにリダイレクトします。

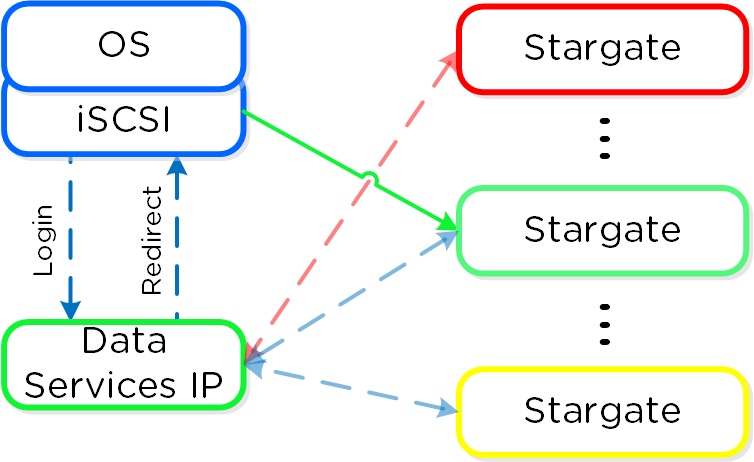

アクティブの(アフィニティがある) Stargateに障害が発生すると、イニシエータはデータサービスIPデータサービスIPへのiSCSIログインをリトライし、別の健全なStargateにリダイレクトされます。

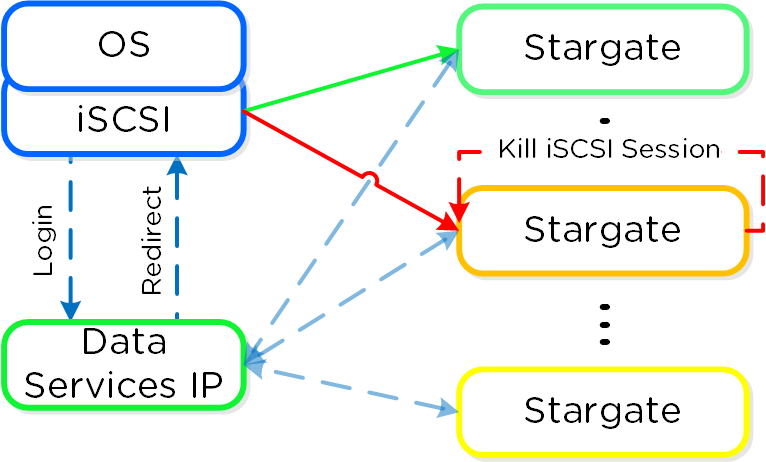

アフィニティがあるStargateが復旧して安定すると、現状アクティブとなっているStargateはI/Oを休止し、アクティブなiSCSIセッションを切断します。イニシエータが再度iSCSIログインを試みると、データサービスIPはそれをアフィニティがあるStargateにリダイレクトします。

ヘルス監視とデフォルト

DSFに対するメカニズムと同様に、VolumesにZookeeperを使用して、Stargateのヘルス状態を監視します。

フェイルバックのデフォルト間隔は120秒となっています。つまり、元々接続していたStargateが2分間以上健全な状態を保てば、セッションを休止して切断するということです。他のログインも、接続中のStargateに戻されます。

この仕組みによって、パスのHAのためのクライアント側マルチパス(MPIO)設定はもはや必要ありません。 ターゲットに接続する場合、MPIOを有効化するために「Enable multi-path(マルチパスを有効化)」にチェックを入れる必要はありません。

マルチパス

iSCSIプロトコルに準拠するためには、イニシエータとターゲット間で1つターゲットに1つのiSCSIセッション(TCP接続)となる必要があります。つまり、Stargateとターゲットが、1:1の関係になるということです。

4.7では、1つのアタッチイニシエータに対して32(デフォルト)の仮想ターゲットが自動生成され、ボリュームグループ (VG) に追加された各ディスクデバイスに割り当てられます。これにより、1つのディスクデバイスに対して、1つのiSCSIターゲットが提供されます。以前は、複数のVGをそれぞれのディスクに対して作成することで実装を行っていました。

aCLIやAPIでVGの詳細を見てみると、各アタッチメントに対して、32の仮想ターゲットが作成されていることが分かります:

attachment_list { external_initiator_name: "iqn.1991-05.com.microsoft:desktop-foo" target_params { num_virtual_targets: 32 } }

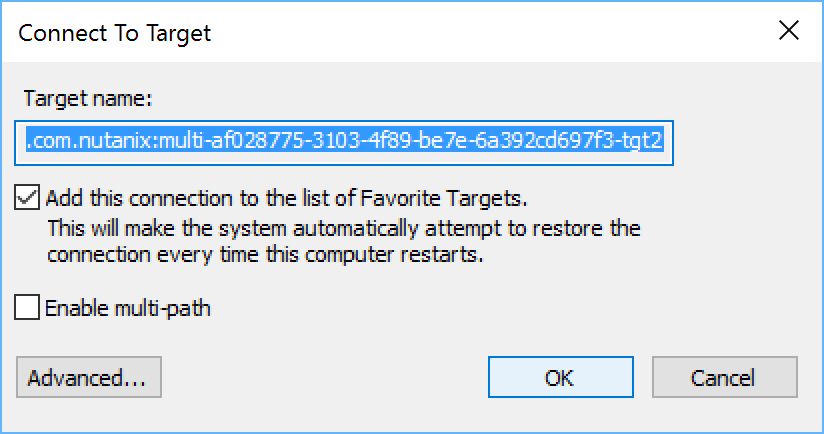

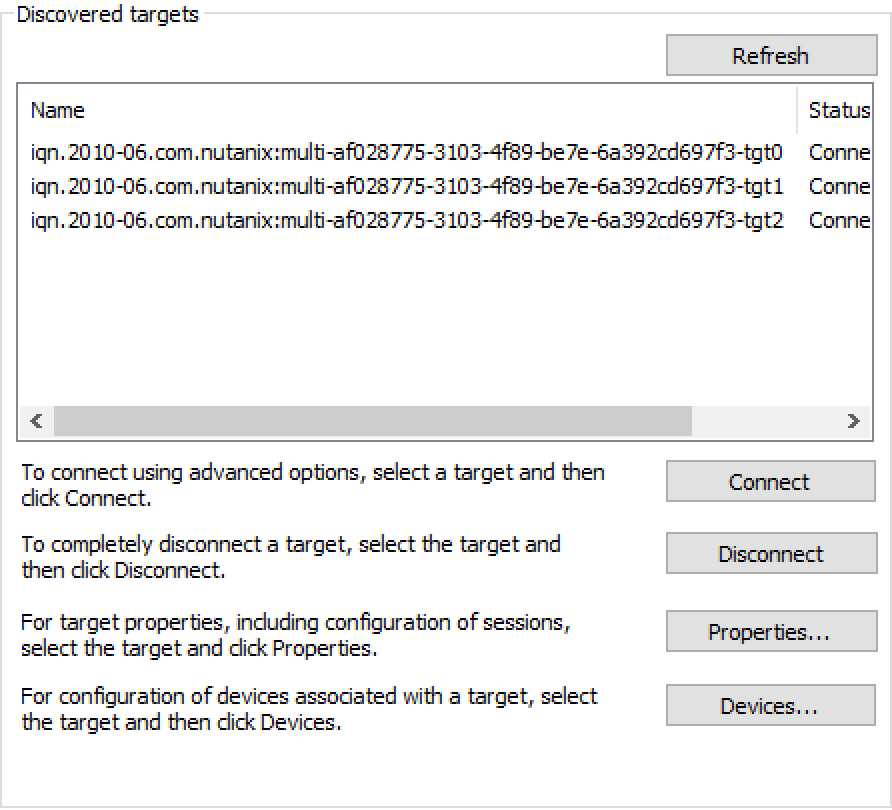

例として、3つのディスクデバイスを追加したVGを作成しました。クライアントでディスカバリを実行すると、それぞれのディスクデバイスに対する個々のターゲットが確認できます。(サフィックスは -tgt[int])

これでディスクデバイスは、自身のiSCSIセッションを持つことになり、これらのセッションは複数のStargateでホストすることが可能であるため、拡張性やパフォーマンスの向上につながります:

iSCSIセッションが確立されている間(iSCSIログイン)、各ターゲットに対するロードバランシングが発生します。

アクティブパス

以下のコマンドを使って、仮想ターゲットをホストしている、有効なStargateを確認することができます(ホストしているStargateのCVM IPを表示):

Windows

Get-NetTCPConnection -State Established -RemotePort 3205

Linux

iscsiadm -m session -P 1

AOS 4.7では、簡単なハッシュ関数を使用してクラスタノード全体にターゲットを分散しています。 AOS 5.0では、これがDynamic Schedulerに統合され、必要に応じて再バランスを取るようになっています。 また、どのノードを使用するかについては、該当ノードが正常である限り自由に設定を行うことができます。

SCSI UNMAP (TRIM)

Volumesでは、SCSI T10仕様にあるSCSI UNMAP (TRIM) コマンドをサポートしています。 このコマンドを使用することで、削除済みブロックのスペース再利用が可能となります。

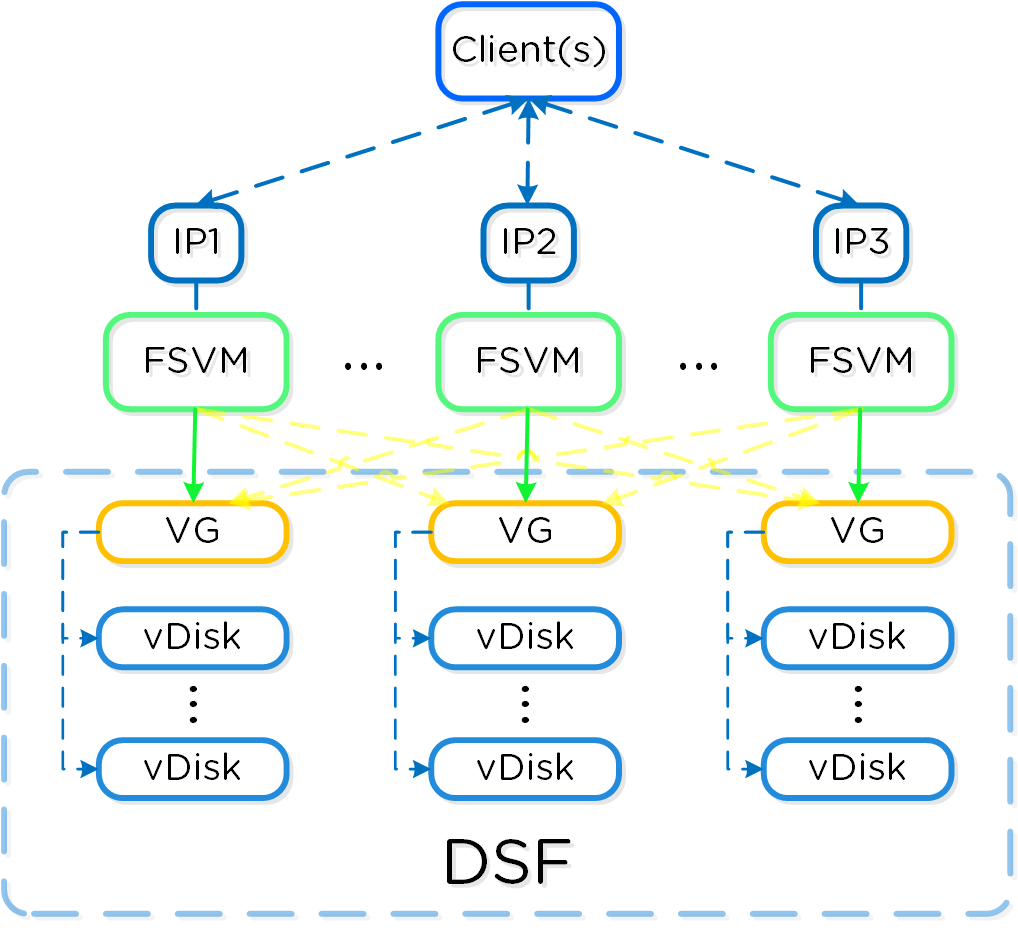

Files (ファイルサービス)

Nutanix Filesによって、Nutanixプラットフォームを高可用性ファイルサーバーとして利用することができます。 ユーザーは、単一のネームスペースにホームディレクトリやファイルをストアできます。

サポート対象構成

本ソリューションでは、以下の構成をサポートしています(一部のみを掲載しています。完全なリストについてはドキュメントをご覧ください):

-

主なユースケース:

- ホームフォルダー / ユーザープロファイル

- ファイル ストレージ

- メディア リポジトリ

- 永続コンテナ ストレージ

-

管理インターフェイス:

- Prism Element (PE)

- Prism Central (PC)

-

ハイパーバイザー:

- AHV

- ESXi

-

アップグレード:

- Prism

-

互換性のある機能:

- Nutanix スナップショットとDR

- ファイル共有レベルのレプリケーションとDR(Smart DR)

- S3準拠ストレージへのファイル階層化(Smart Tier)

- Windowsの「以前のバージョン」 (WPV:Windows Previous Versions)を含む、ファイルレベルスナップショット

- セルフサービスリストア

- CFTバックアップ

-

ファイルプロトコル:

- SMB 2

- SMB 3

- NFS v4

- NFS v3

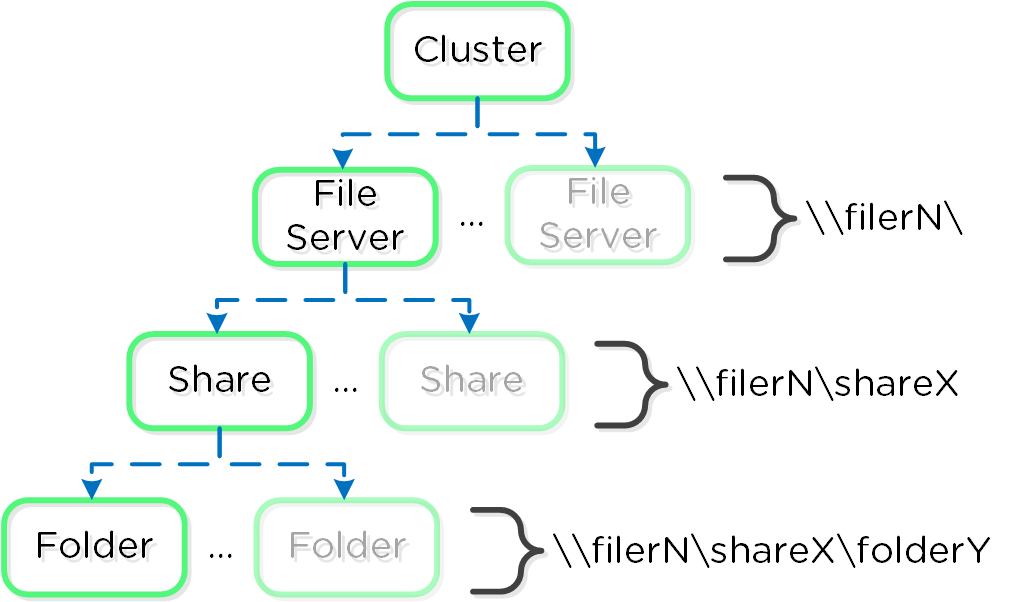

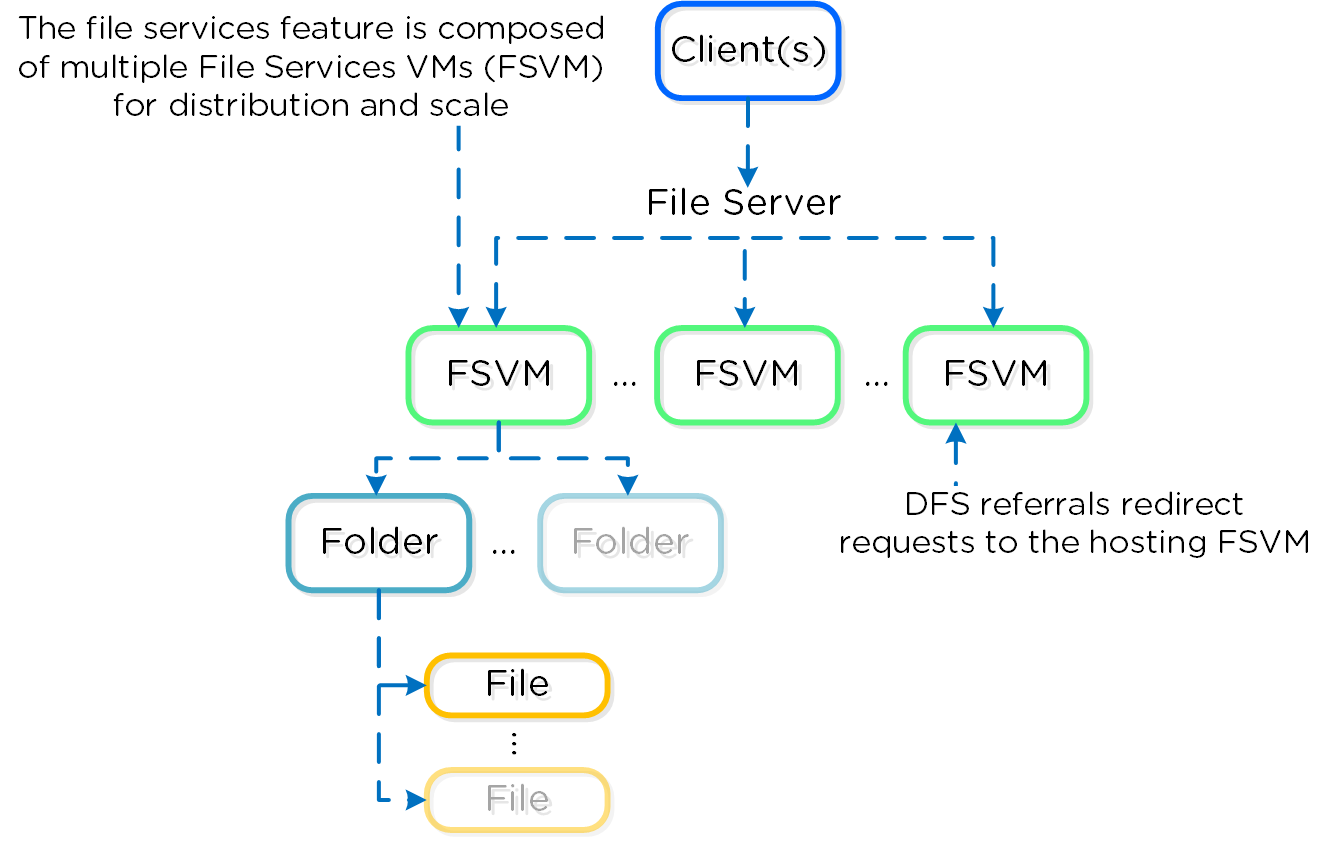

Files の構成要素

本機能は、いくつかのハイレベルな要素から構成されています:

-

ファイルサーバー

- ハイレベルな名前空間(namespace)。 各ファイルサーバーは、それぞれのFiles VM(FSVM)を持っています

-

シェア

- シェア (Share) には、ユーザーがアクセスできます。ファイルサーバーは、複数のシェアを持つことができます(部門別シェアなど)

-

フォルダー

- ファイルストレージのためのフォルダー。フォルダーは、FSVM全体で共有されます

下図は、構成要素の連関についての概要を示したものです:

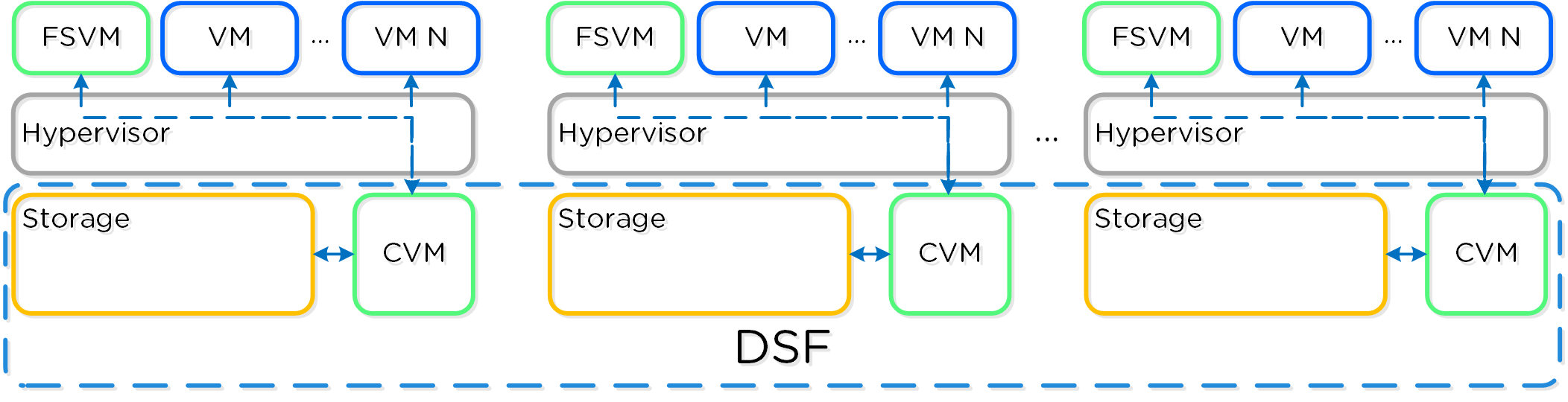

Nutanix Filesでは、Nutanixプラットフォームと同じ分散メソドロジーを踏襲することで、可用性と拡張性を保証しています。ファイルサーバーには、少なくても3つのFSVMが設定されます。

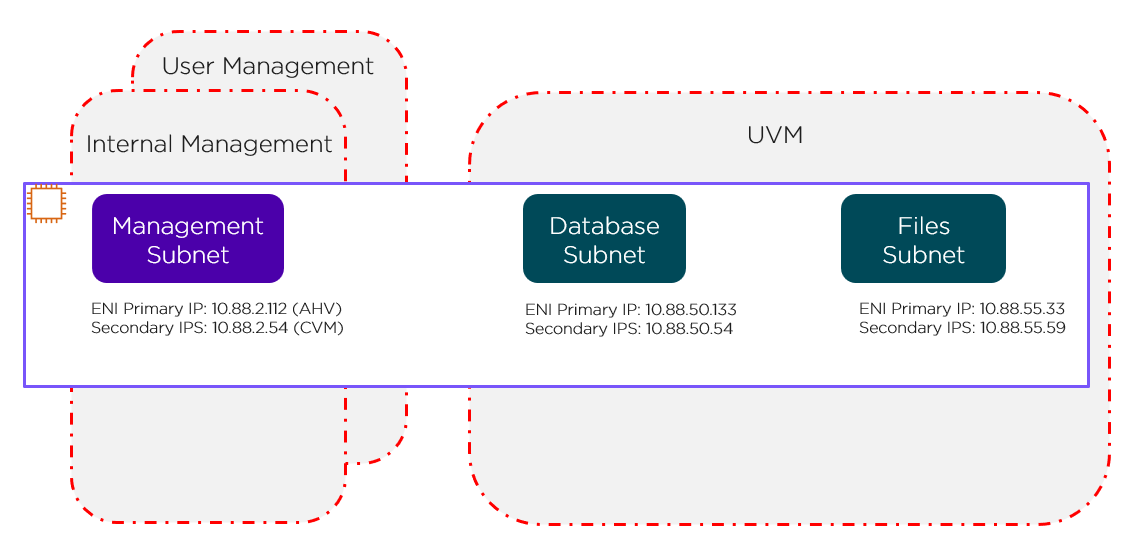

以下にコンポーネントの詳細を示します:

FSVMは、論理的なファイルサーバー インスタンスとして統合され、Filesクラスタと呼ばれることもあります。 ひとつのNutanixクラスタには、複数のFilesクラスタを作成できます。 FSVMは、設定プロセスの途中で透過的にデプロイされます。

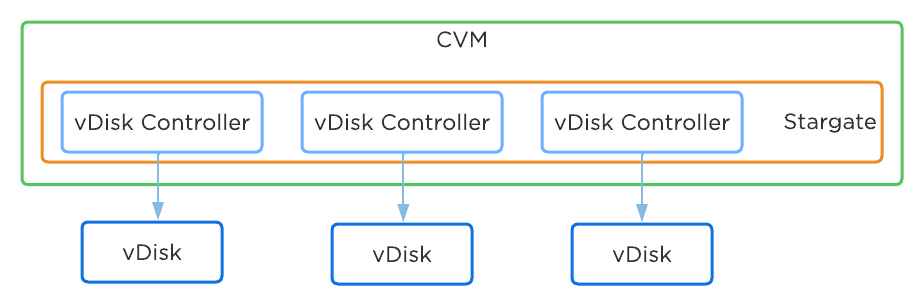

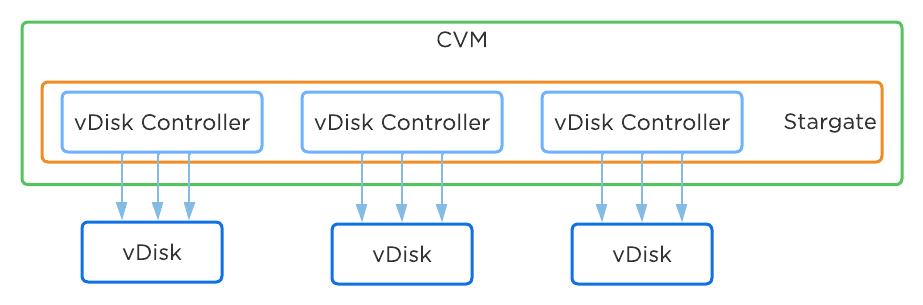

下図は、AOSプラットフォームにおけるFSVMの詳細を示したものです:

認証と権限

Nutanix Files機能は、Microsoft Active Directory(AD)およびDNSと完全に連携を取ることができます。 このため、ADに関する全てのセキュアな認証と権限管理機能の活用が可能となります。 共有許可、ユーザーやグループの管理については、従来のWindows MMCを使用して実施されます。

インストレーションプロセスの途中で、以下のAD / DNSオブジェクトが生成されます:

- ファイルサーバーのためのADコンピューターアカウント

- ファイルサーバーと各FSVMのためのADサービスプリンシパル名 (SPN)

- ファイルサーバーが全てのFSVMを示すDNSエントリー

- 各FSVMのためのDNSエントリー

ファイルサーバー生成のためのADの権限

ファイルサービスを導入し、ADおよびDNSオブジェクトを生成するためには、ドメイン管理者または同等の権限を持ったユーザーアカウントを使用する必要があります。

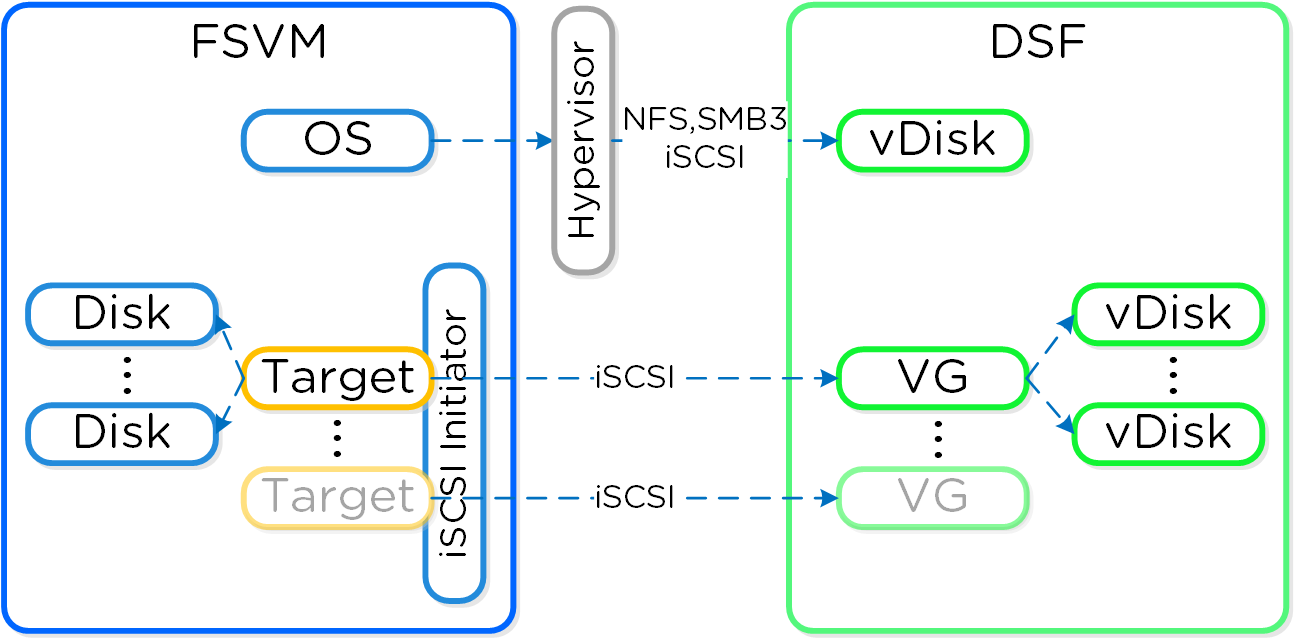

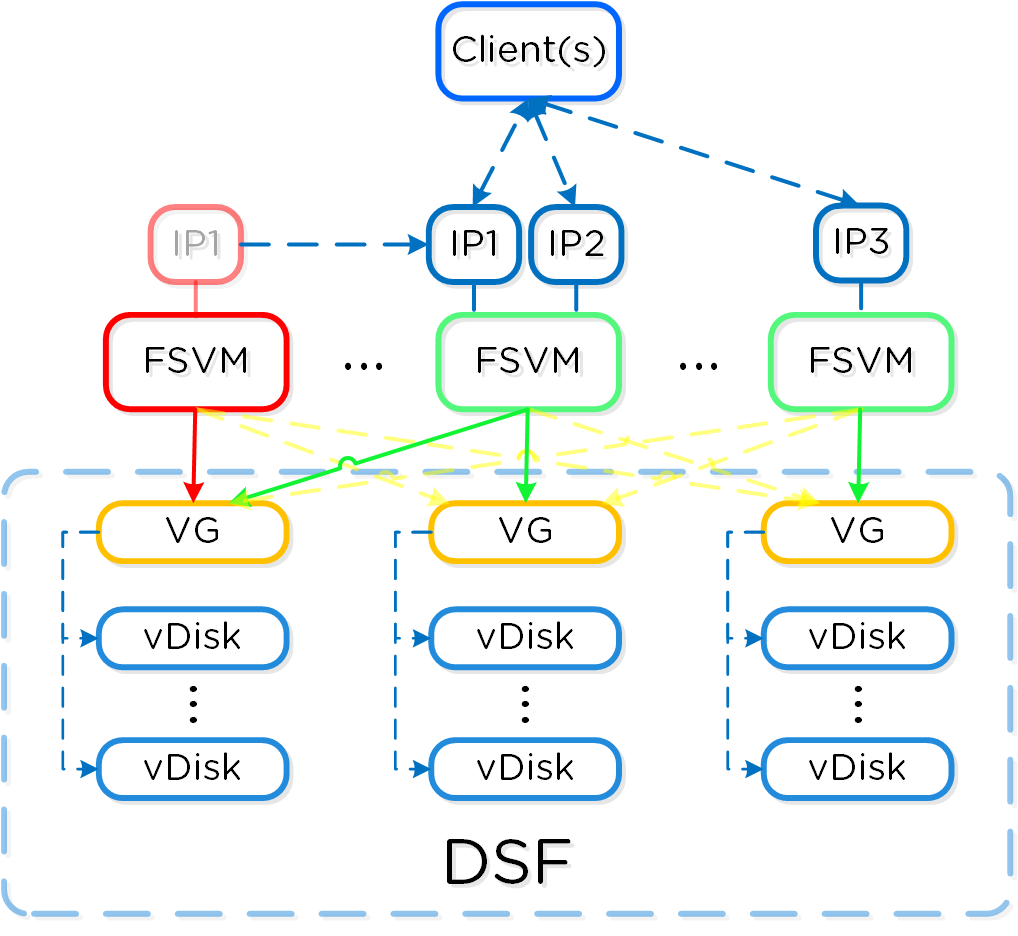

高可用性 (HA)

各FSVMは、Volumes APIを使って、ゲスト内からのiSCSI経由でデータ ストレージにアクセスします。 これにより、FSVMに障害が発生した場合でも、iSCSIターゲットへの接続が可能となります。

以下にFSVMストレージの概要を示します:

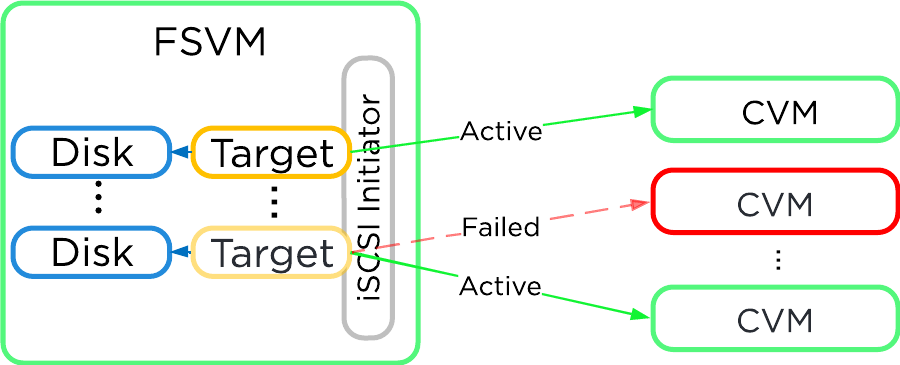

CVM が使用できなくなった場合 (アクティブ パスのダウンなど)、iSCSIリダイレクションを使用してターゲットを別のCVMにフェイルオーバーしてI/O処理を引き継ぎます。

ローカルCVMが復旧して正常稼動すると、こちらがアクティブパスであると認識され、ローカルI/Oを提供するようになります。

通常の運用環境では、各FSVMのパッシブ接続されたデータストレージとの通信は、それぞれのVGとの通信によって実現されます。 それぞれのFSVMは、クライアントがDFS Referral(分散ファイルシステム紹介)プロセスの一部としてFSVMと通信するためのIPを持ちます。 DFS Referralプロセスが共有フォルダーをホストしている正しいIPに接続するため、クライアントが個別のFSVMのIPを認識する必要がありません。

FSVMに「障害」(メンテナンスや電源断など)が発生すると、該当FSVMのVGとIPは、他のFSVMに引き継がれて高可用性を維持します。

以下に、障害FSVMのIPとVMに関する引き継ぎの流れを示します:

障害のあったFSVMが復旧し安定すると、再度IPとVGを取得してクライアントI/Oの処理を継続します。

Objects(オブジェクトサービス)

Nutanix Objectsは、S3準拠のAPIを介して非常にスケーラブルで耐久性のあるオブジェクトサービスを提供します(S3の補足情報: LINK)。 Nutanix ObjectsがNutanixプラットフォーム上にデプロイされると、圧縮、消失訂正符号 (Erasure Coding)、レプリケーションなどのAOS機能を利用できます。 ObjectsはAOS 5.11で導入されました。

サポートされる構成

ソリューションは以下の構成に適用できます(以下のリストは一部です。全てを確認する際には、ドキュメントをご覧ください):

-

主なユースケース:

- コンプライアンスレベルのWORM機能を持つバックアップターゲット

- 医療画像保管伝送システム(PACS/VNA)のためのアーカイブターゲット、Eメール、長期間バックアップ

- データレイクを含むビッグデータ、AI/MLワークロード、分析、機械からのログ記録、SIEM、Pub/Sub

- DevOps、クラウドネイティブ、コンテンツのリポジトリ、Kubernetes

-

管理インターフェイス:

- Prism Central (PC)

-

ハイパーバイザー:

- N/A - Nutanix MSPで実行(MSPがサポートするハイパーバイザーに依存)

-

アップグレード:

- LCM

-

主な機能:

- WORM

- バージョニング

- 訴訟ホールド(Legal Hold)

- マルチプロトコル

- ストリーミングレプリケーション

- マルチパートアップロード

- 高速なコピー

- S3 Select

-

サポートされているプロトコル:

- S3 (version 4)

- NFSv3

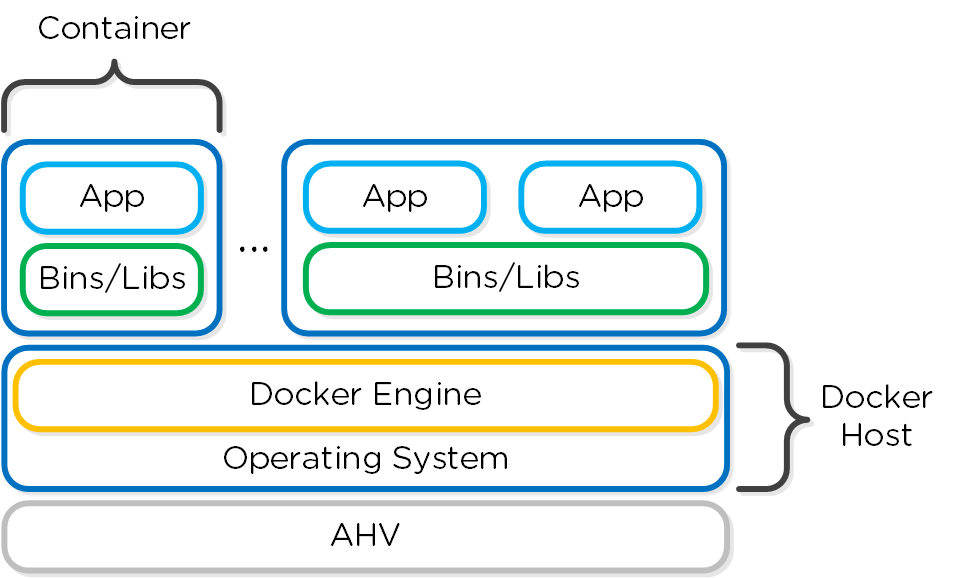

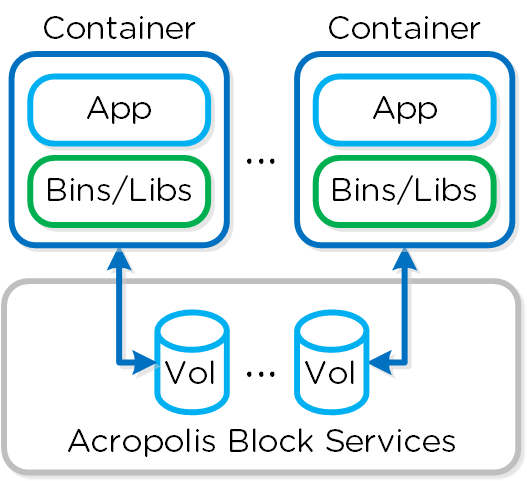

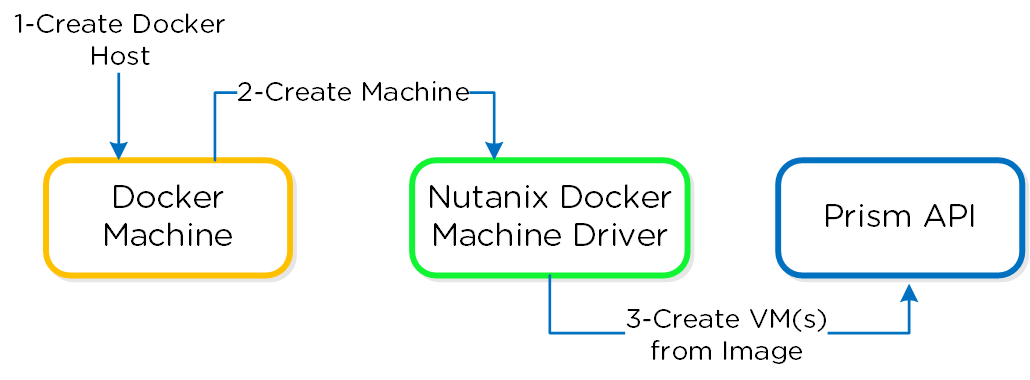

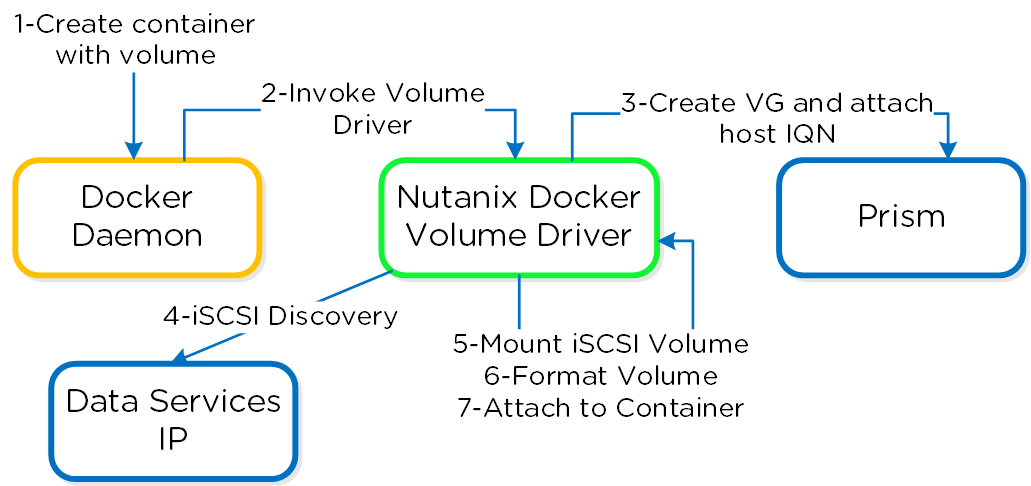

Nutanix Microservices Platform (MSP)

Nutanix Objectsは、Nutanix Microservices Platform(MSP)を活用して実行される最初のコア サービスの1つです。

Nutanix MSPは、Identity and Access Management(IAM)やロードバランシング(LB)といった、Objectsのコンポーネントに関連付けられたコンテナとプラットフォームサービスをデプロイするための共通フレームワークとサービスを提供します。

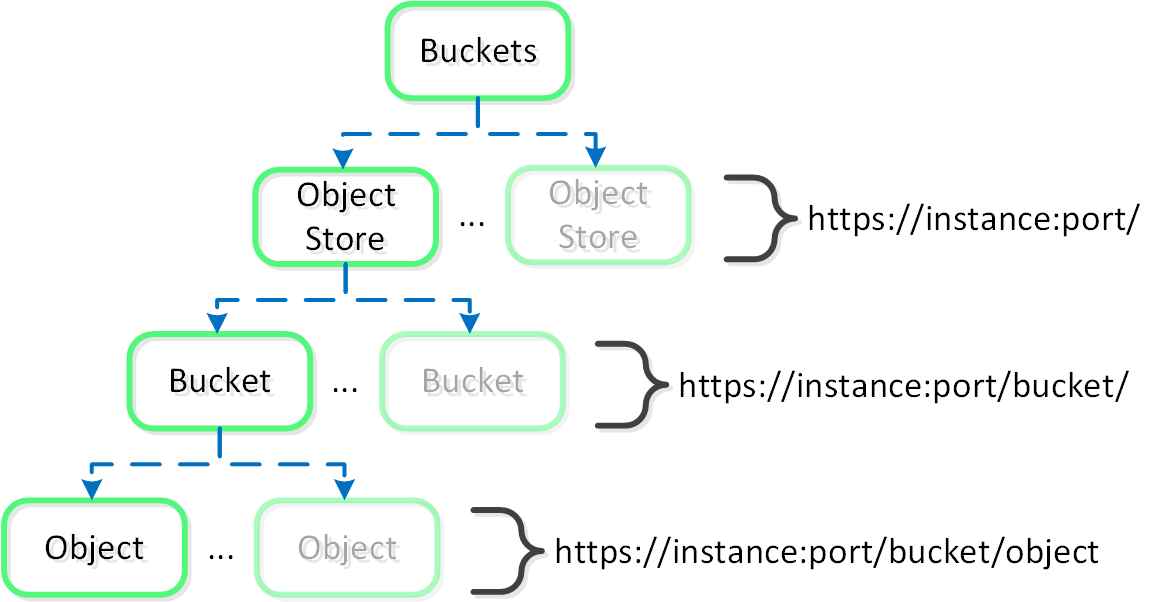

主な用語

次のこのセクション全体で使用される主要な用語は、以下のように定義されています:

-

バケット

- ユーザーに公開された組織単位であり、オブジェクトを含む。(ファイルサーバーでのファイルの共有とみなせる)。 デプロイメントには、複数のバケット(例えば、部門、区画など)を含めることができ、通常はそうなる。

-

Object

- API(GET / PUT)をインターフェイスとするストレージとアイテムの実際の単位(blob)。

-

S3

- アマゾン ウェブ サービス(AWS)で導入された、元のオブジェクトサービスを説明する用語であり、現在はオブジェクトサービスの同義語として使用されている。 S3は、プロジェクト全体で高度に活用されている、オブジェクトAPIの定義にも使用される。

- ワーカーVM

- さまざまなコンテナ化されたObjectsのサービスをホストする、オブジェクトストアの展開中に作成された仮想マシン。 これらは、Objectsノードとも呼ばれる。

- Objectsブラウザー

- ユーザーがWebブラウザーでオブジェクトストアのインスタンスを直接起動し、バケットおよびオブジェクトレベルの操作を実行できるようにするユーザーインターフェイス(UI)。

この図は、概念構造のマッピングを示します:

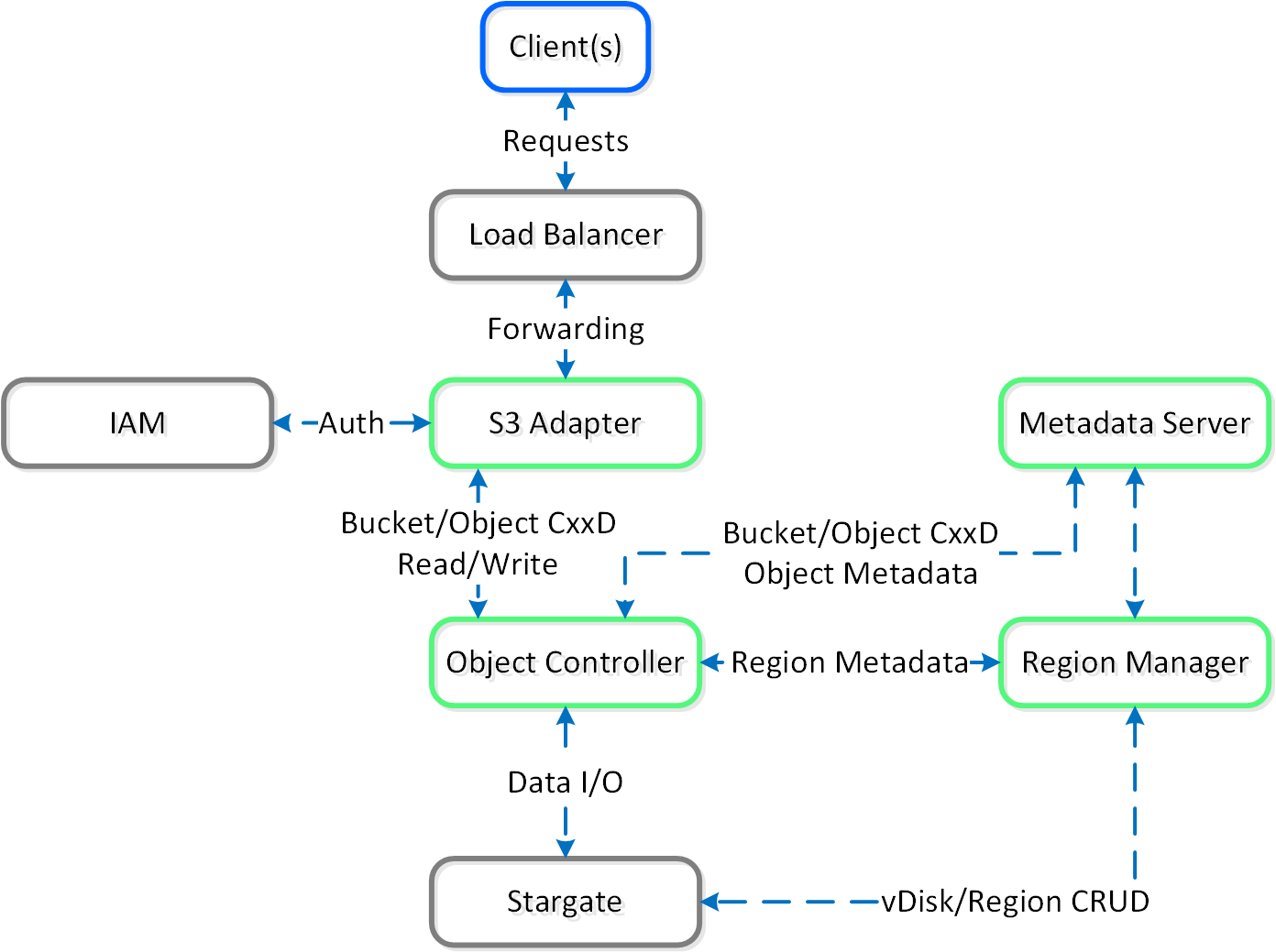

Objectsの構成

この機能は、いくつかの大まかな構成要素で構成されています:

-

ロードバランサー

- ロードバランサーはNutanix MSPの一部であり、サービスおよびデータ リクエストのプロキシとして働きます。 これによりサービスの高可用性が確保され、オブジェクトコンテナ間の負荷分散が行われます。

-

サービスマネージャー

- サービスマネージャーは、すべてのUIリクエストのエンドポイントとして機能し、オブジェクトストアのインスタンスを管理します。 また、インスタンスから統計を収集する役割もあります。

-

メタデータサーバー

- メタデータサーバーは、Nutanix Objectsのデプロイに関する、すべてのメタデータ(例えば、バケット、オブジェクトなど)を格納します。 メタデータサーバーのパフォーマンスを強化するため、NutanixはChakrDBを開発しましたが、これはRocksDBを活用したKey-Valueストアであり、ストレージにNutanix Volumesを使用します。

-

オブジェクトコントローラー

- 自社で構築したデータパスエンジンであり、オブジェクトデータを管理し、メタデータの更新をメタデータサーバーと調整します。 Storage Proxy APIを介してStargateとのインターフェイスになります。

-

リージョンマネージャー

- リージョンマネージャーは、DSF上にあるすべてのオブジェクトストレージ情報(リージョンなど)を管理します。

-

リージョン

- リージョンは、オブジェクトと、それに対応するNutanix vDiskでの場所の高レベルでのマッピングを提供します。 vDisk ID、オフセット、および長さと同様のものです。

-

Atlasサービス

- Atlasサービスは、MapReduceフレームワークをベースにしており、オブジェクトへのライフサイクルポリシーの適用とガベージコレクション、階層化などを担当します。

- S3アダプター

- Objects 3.2は自社で構築されてすべてが新しくなっており、S3アダプターはS3 APIを提供し、S3クライアントからの認可だけでなくAPIリクエストも処理します。 これらはオブジェクトコントローラー向けに変換され、処理されます。

この図は、Objectsのサービス アーキテクチャーの詳細を示します:

Objects固有のコンポーネントは、Nutanix Greenで強調されています。 オブジェクトには「上書き」の概念がないため、CRUD(Create/Replace/Update/Delete)ではなくCxxD(Create/x/x/Delete)です。 一般的なオブジェクトの「上書き」の方法は、新しいリビジョンを作成するか、新しいオブジェクトを作成してそのオブジェクトをポイントすることです。

オープンソースコンポーネント

Nutanix Objectsは、オープンソースコンポーネントを活用しつつ、有機的なイノベーションの連携により構築されています。 これにより当社の製品がより堅牢で効率的になり、お客様のビジネスに最適なソリューションを提供できると確信しています。

オープンソースライセンスの開示に関する詳細についてはこちらをご覧ください: LINK

オブジェクトストレージとI/O

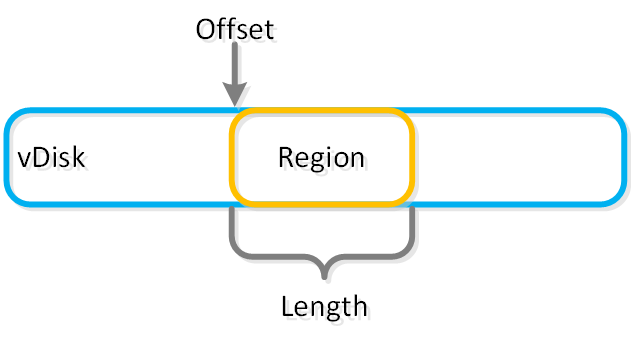

オブジェクトは、リージョンと呼ばれる論理構造に格納されます。 リージョンは、vDisk上の固定長セグメントの領域です。

この図は、vDiskとリージョンの関係についての例を示します:

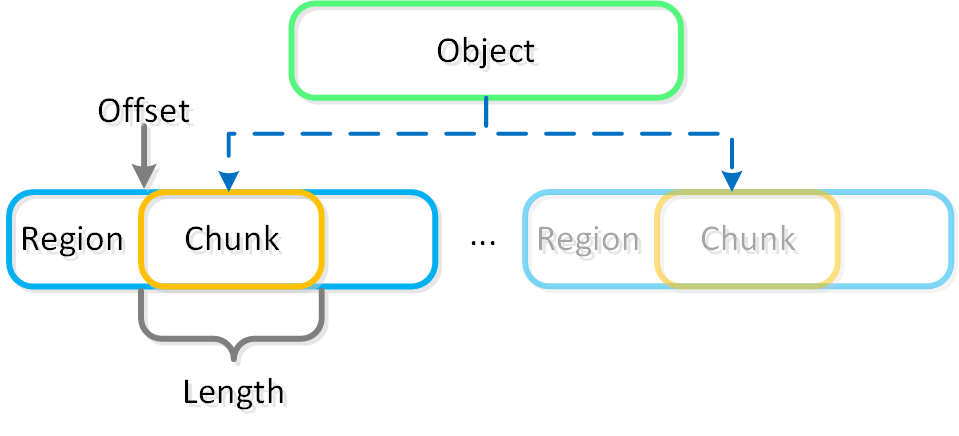

小さいオブジェクトは単一のリージョンのチャンク(リージョンID、オフセット、長さ)に収まる場合がありますが、大きいオブジェクトはリージョンをまたいでストライプ化されることがあります。 ラージオブジェクトが複数のリージョンにストライプ化されている場合、それらのリージョンを複数のvDiskでホストして、複数のStargateにて同時に利用できます。

この図は、オブジェクト、チャンク、リージョンの関係についての例を示します:

オブジェクトサービス機能は、Nutanixプラットフォームと同じ分散方式によって、可用性と拡張性を保証します。 Objectsのデプロイでは、最低3台のオブジェクトVMがデプロイされます。

AOS (Storage for Compute VMs)

Acropolis - アクロポリス - 名詞 - データプレーン

ストレージ、サーバー、仮想化プラットフォーム

Acropolis Operating System(AOS)はコア ソフトウェア スタックであり、ハイパーバイザー(オンプレミスまたはクラウド上で動作する)とワークロードの間に抽象化レイヤーを提供します。 これは、ストレージサービス、セキュリティ、バックアップおよび災害復旧、他にも多くの機能を提供します。

本書では、これらの機能とAOSのアーキテクチャーについて説明します。

チャプター

- AOSのアーキテクチャー

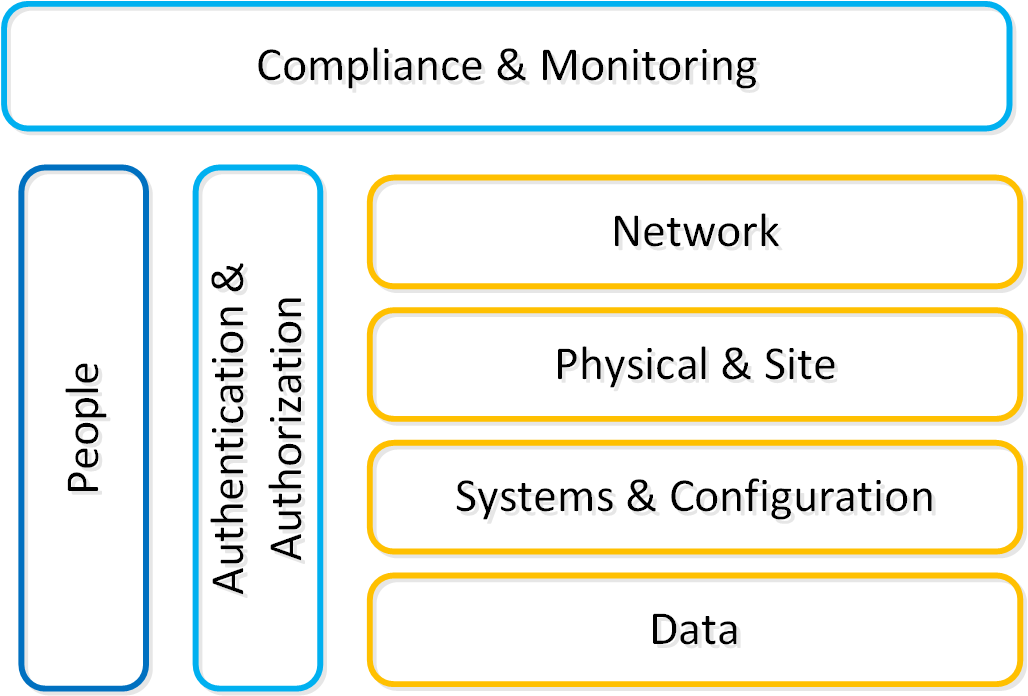

- セキュリティ

- ストレージ

- サービス

- バックアップとディザスタリカバリ

- AOSのアドミニストレーション

AOSのアーキテクチャー

Acropolis Operating System(AOS)は、プラットフォーム上で実行されているワークロードやサービスによって利用される中核的な機能を提供します。 これには、ストレージサービス、アップグレードといったものが含まれますが、これらに限定されません。

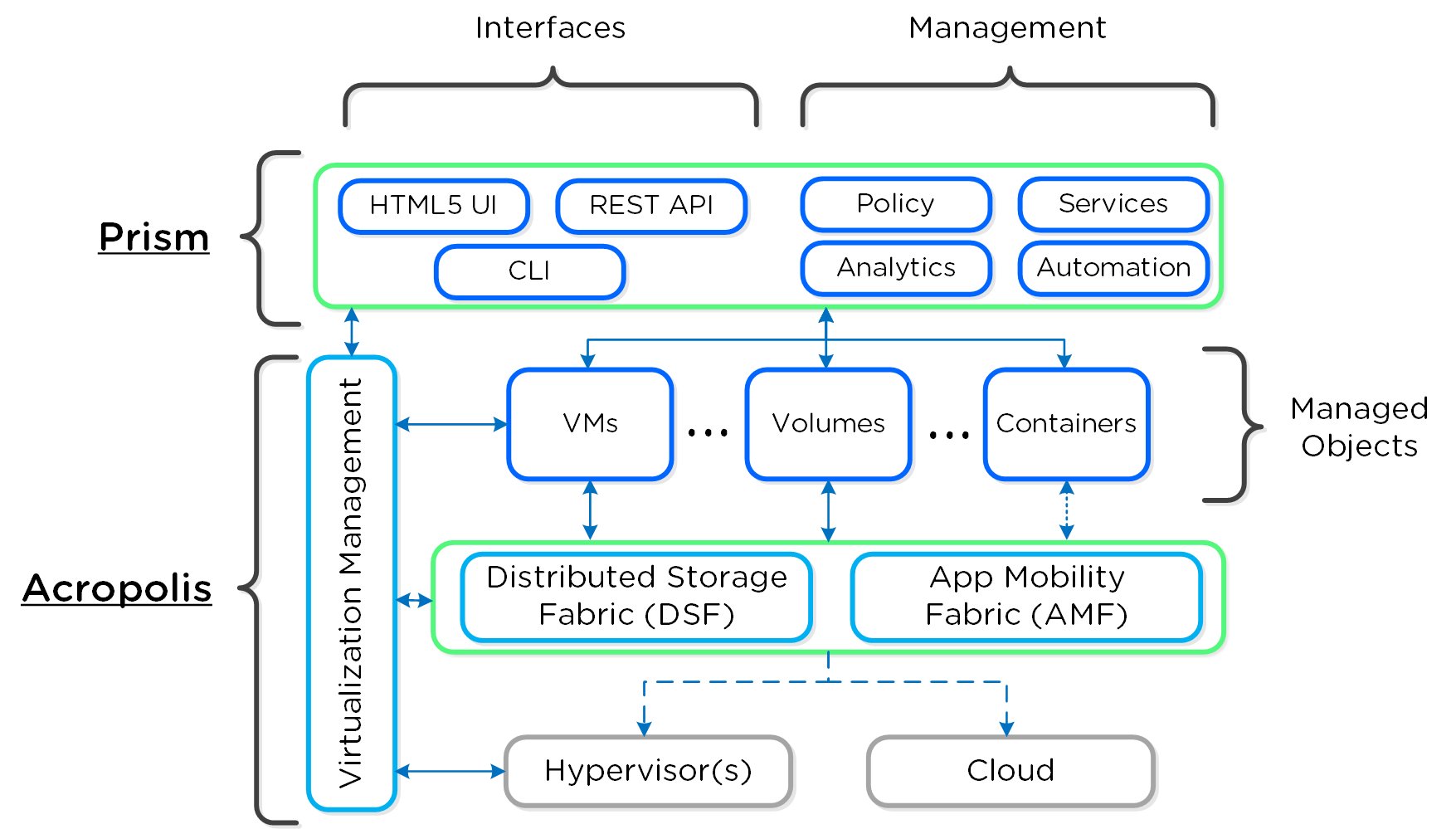

この図は、様々なレイヤーにおけるAOSの概念的性質のイメージを示しています:

Nutanixでは、全てを分散するという設計方針に基づき、この考え方を仮想化とリソース管理の分野にまで拡張しました。 AOSは、ワークロードやリソースを管理、プロビジョニング、運用するためのバックエンド サービスです。 目的は、稼動しているワークロードをNutanixがサポートするリソース(ハイパーバイザー、オンプレミスやクラウドなど)から分離して抽象化し、運用する1つの「プラットフォーム」を提供しようというものです。

これによって、ワークロードをハイパーバイザー、クラウド プロバイダーやプラットフォーム間でシームレスに移動させることが可能となります。

VM管理の対象となるハイパーバイザー

AOS 4.7現在、VM管理機能がサポートするハイパーバイザーは、AHVとESXiに限定されていますが、将来的には拡大される予定です。 但し、Volumes APIとREADオンリーの操作は、現在でも全てがサポートされています。

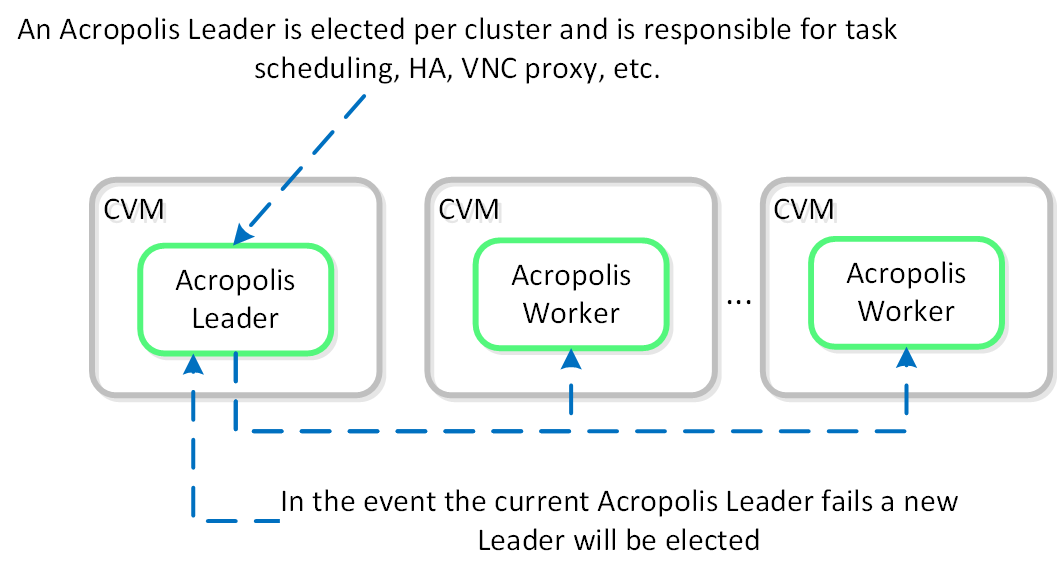

Acropolisサービス

Acropolisワーカーは、全てのCVM上で、タスクのスケジューリング、実行、IPAMなどを行う選出されたAcropolisリーダーと共に稼動します。 他のリーダーを持つコンポーネントと同様、Acropolisリーダーに障害が発生した場合は、新しいリーダーが選出されます。

各機能の役割を以下に示します:

- Acropolisリーダー

- タスクのスケジューリングと実行

- 統計の収集とパブリッシング

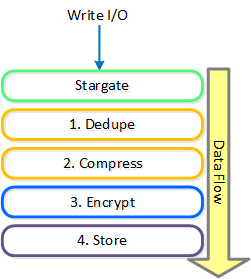

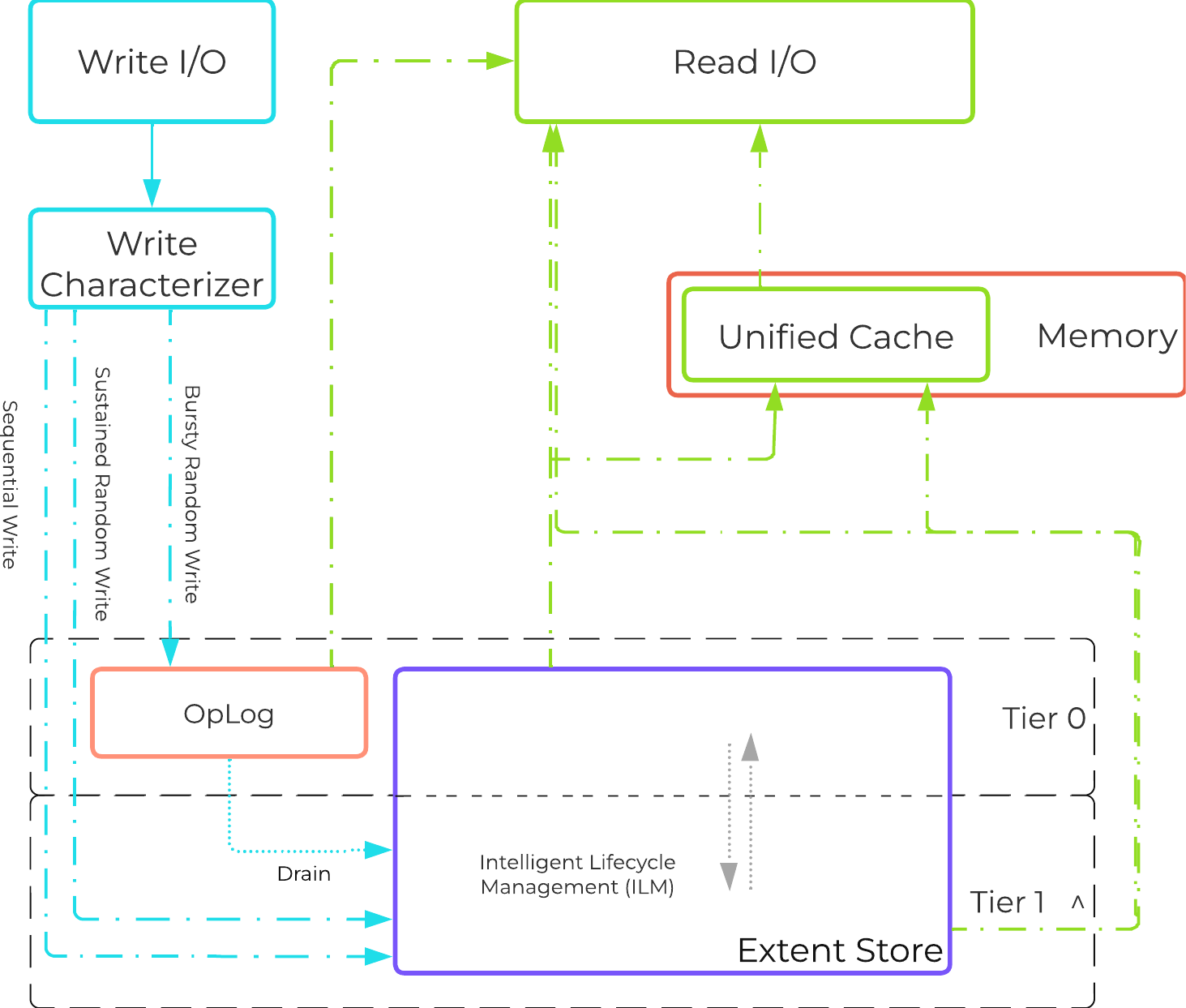

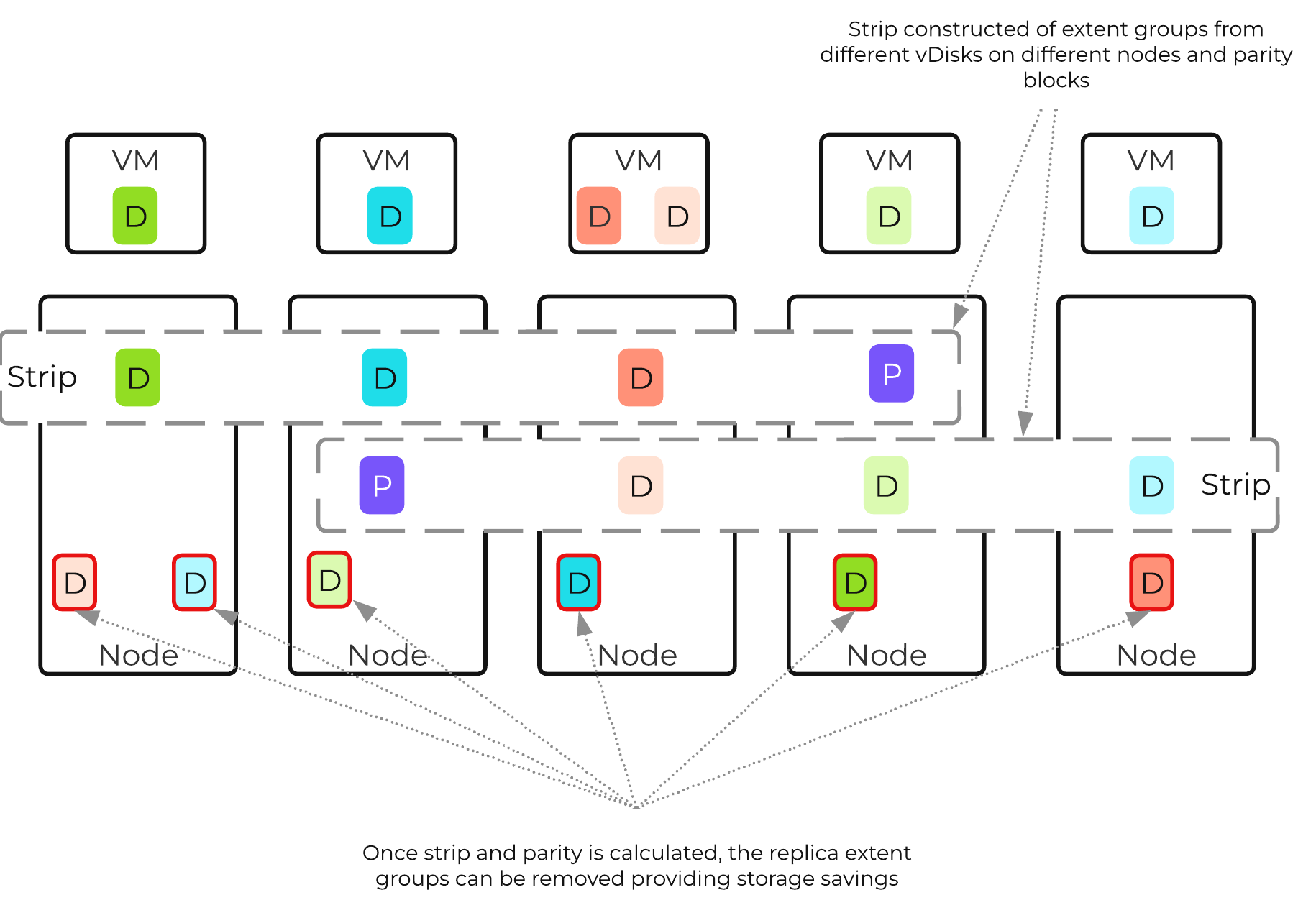

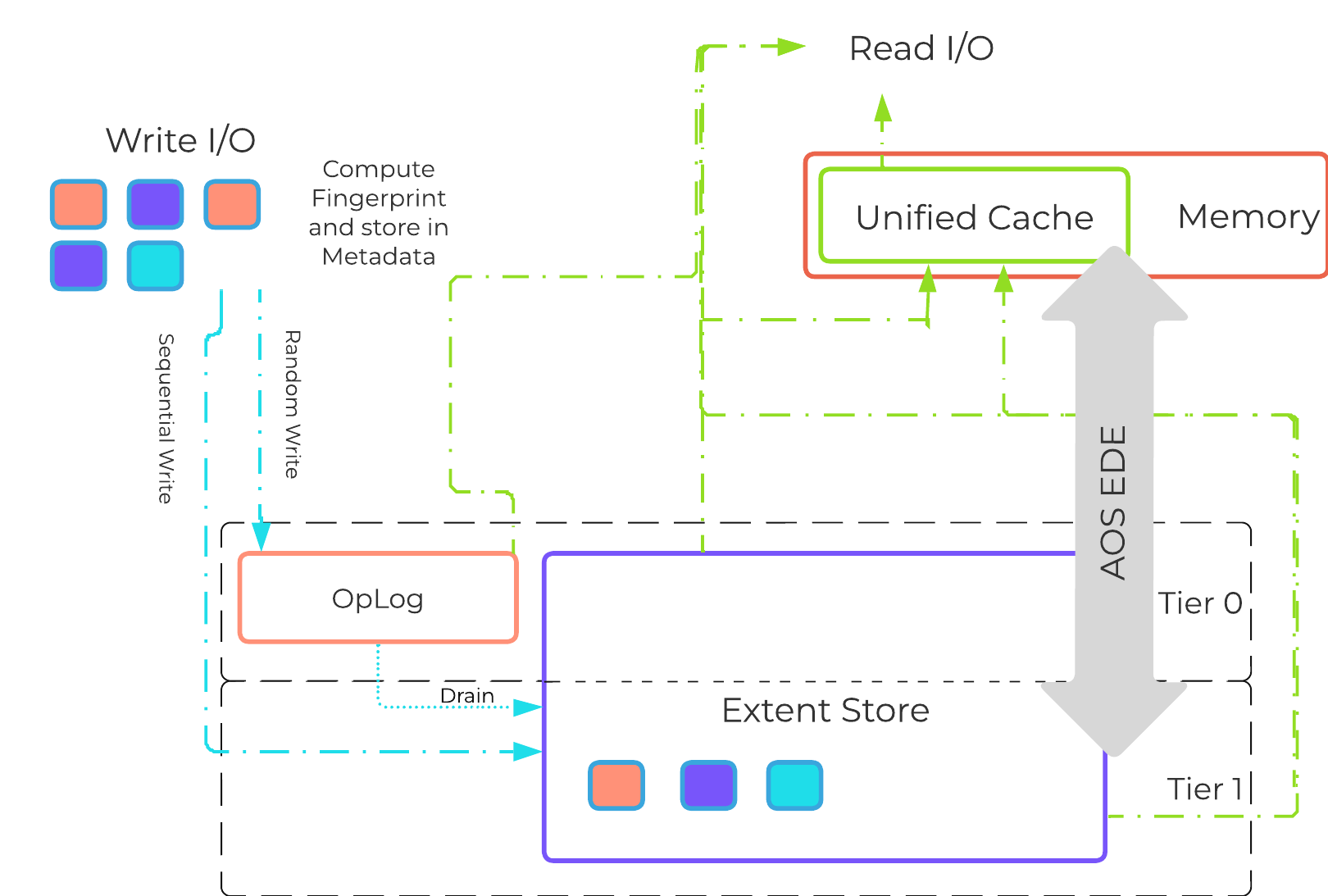

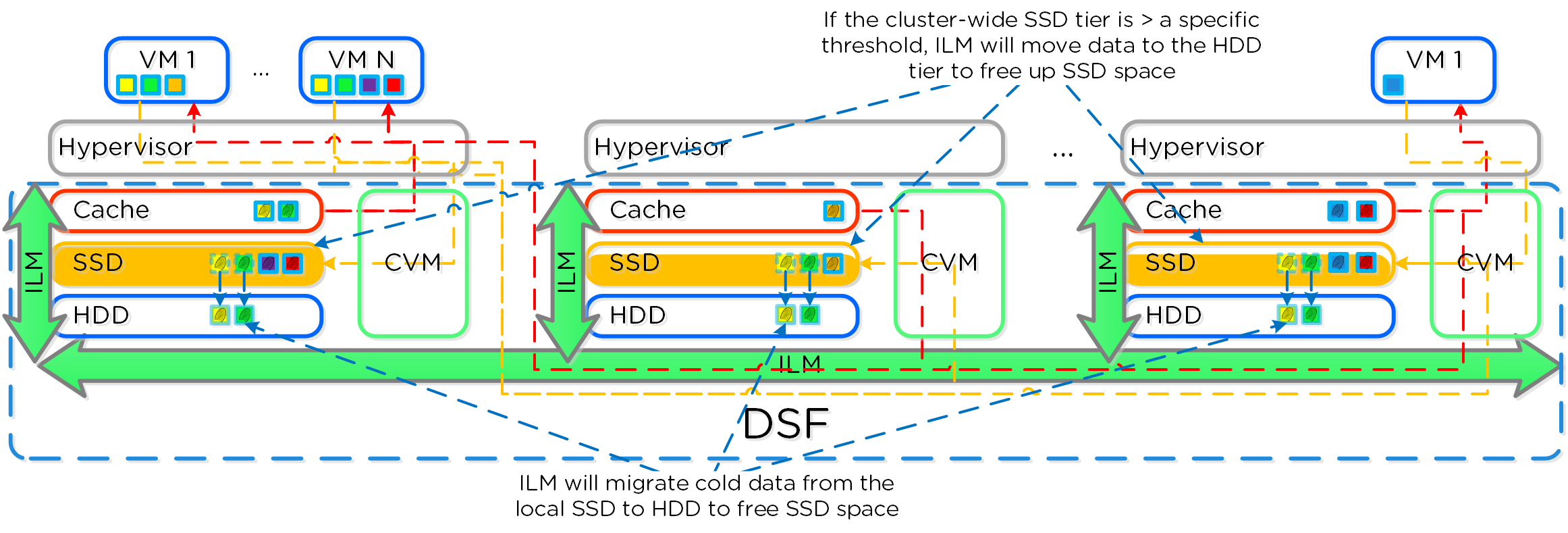

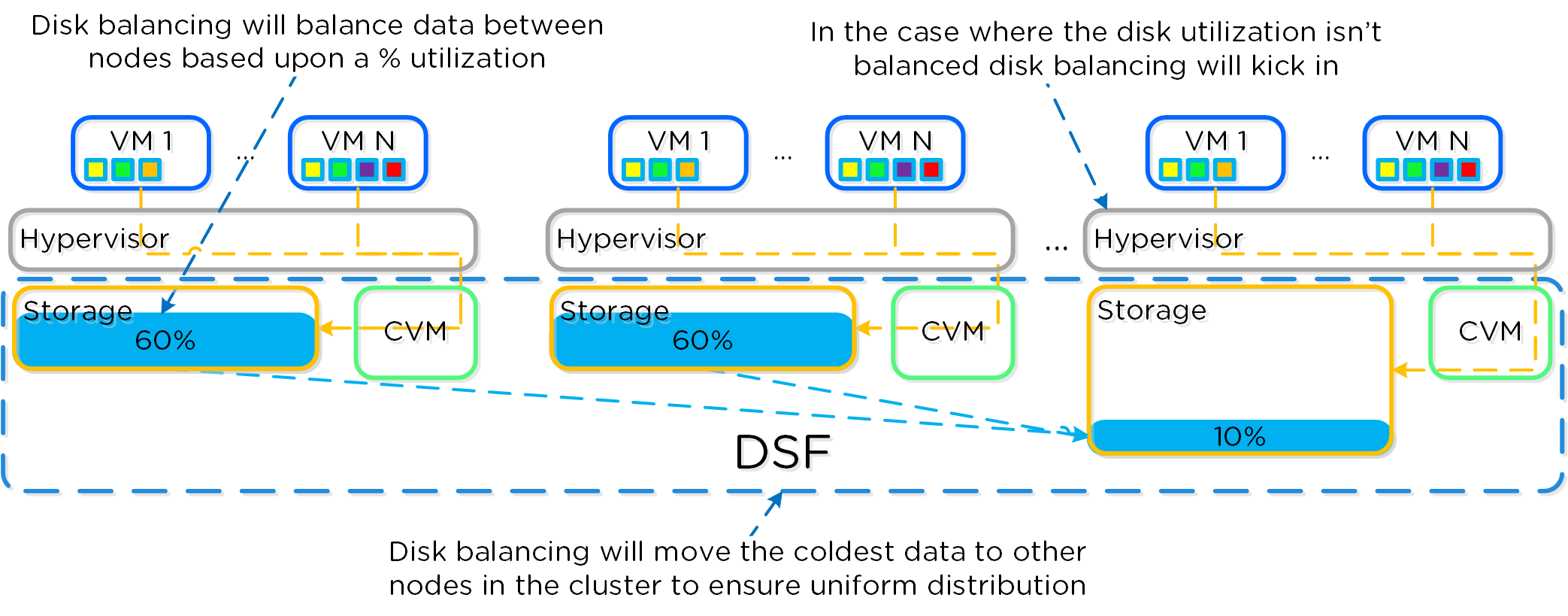

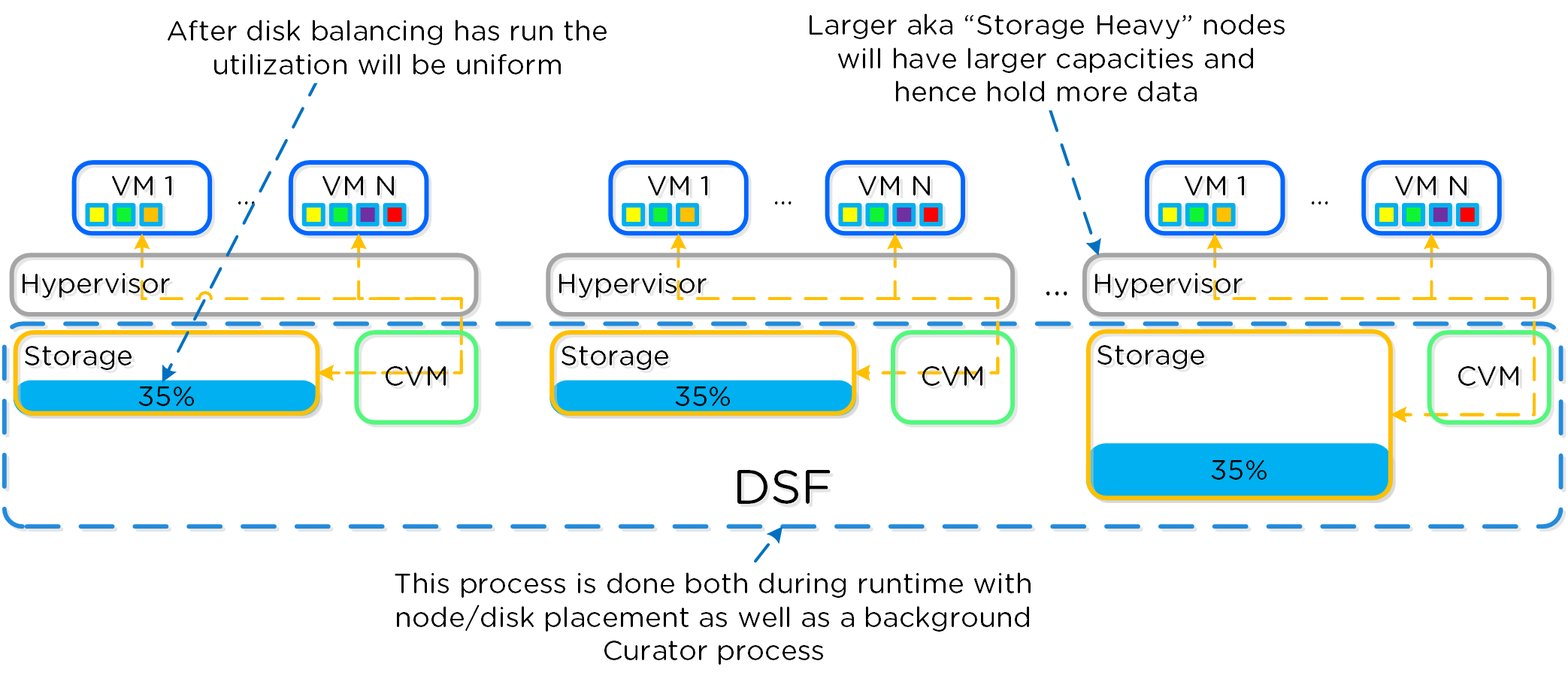

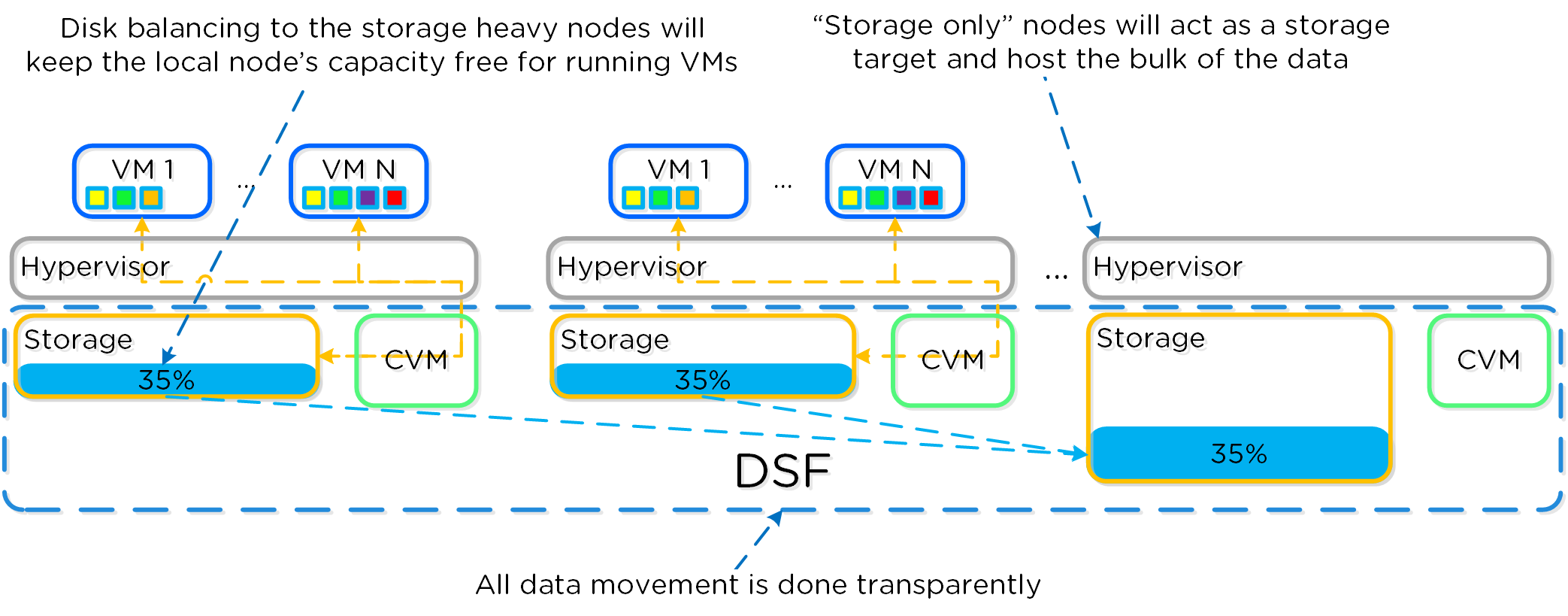

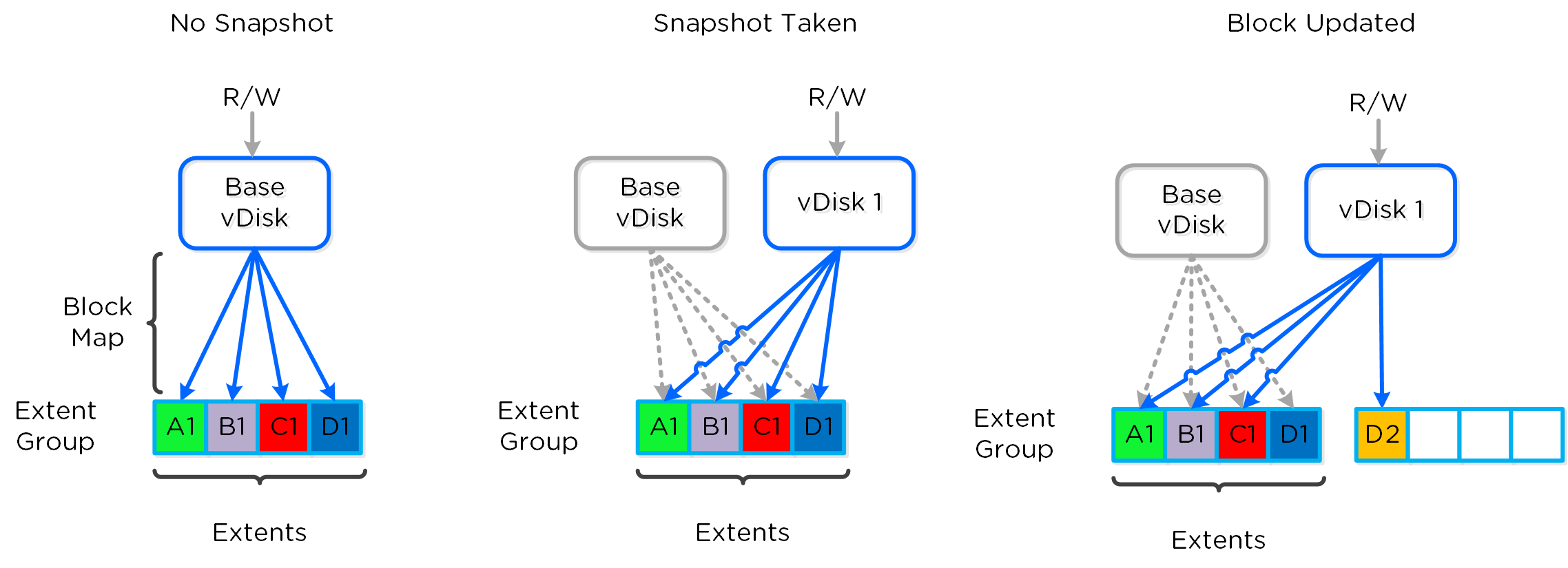

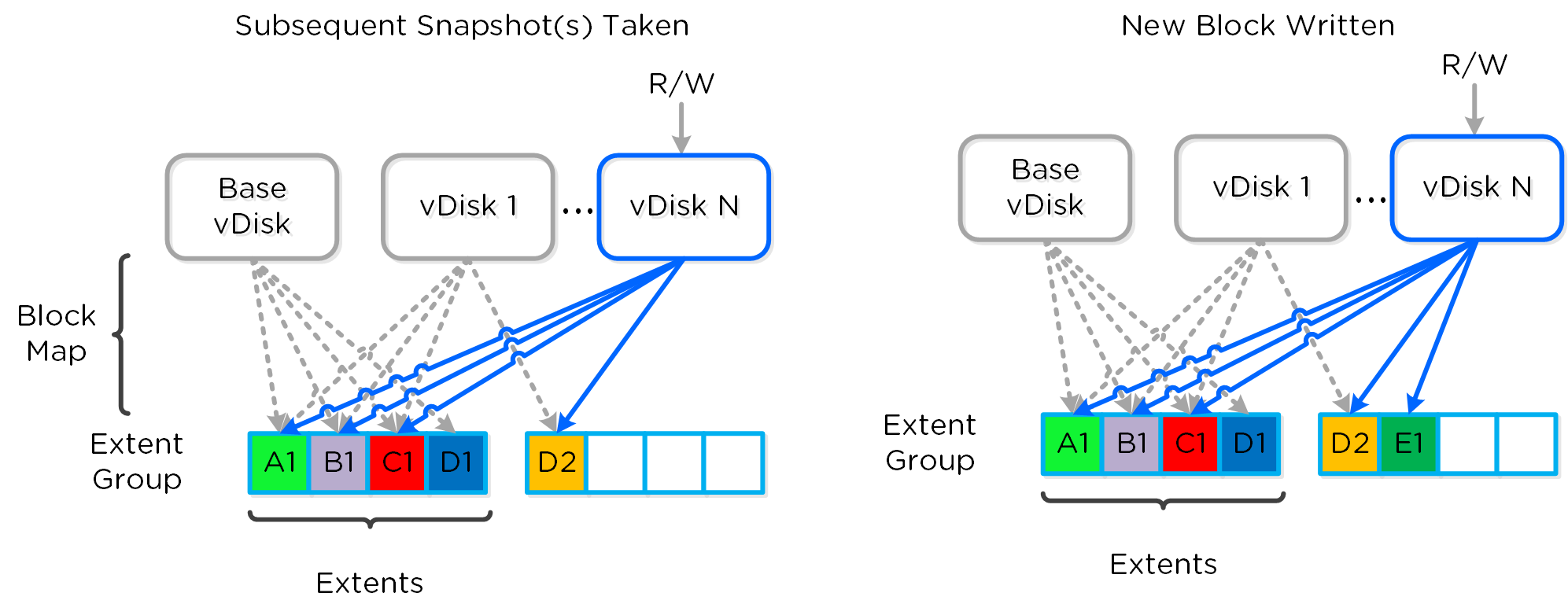

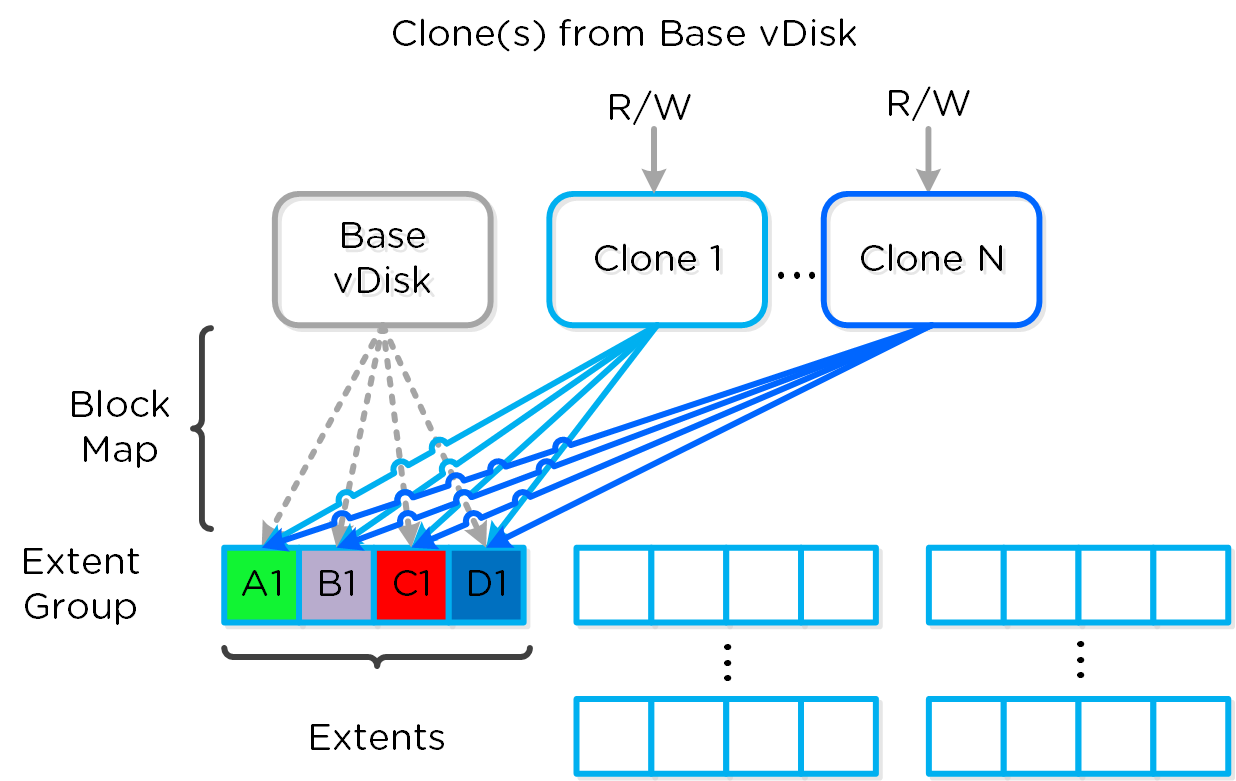

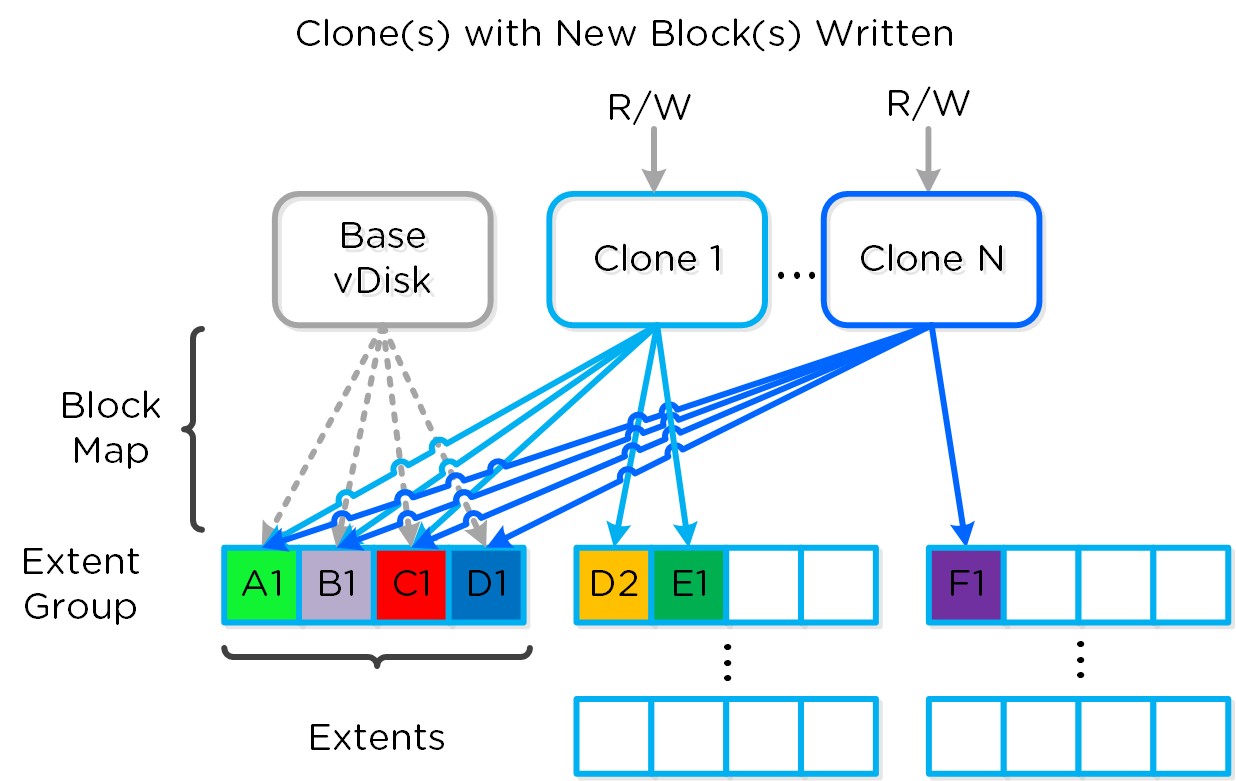

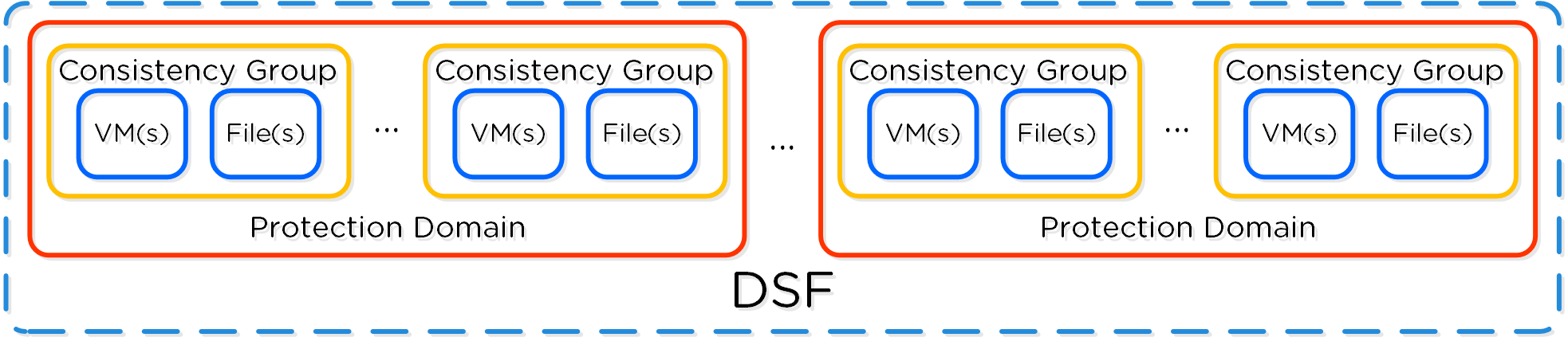

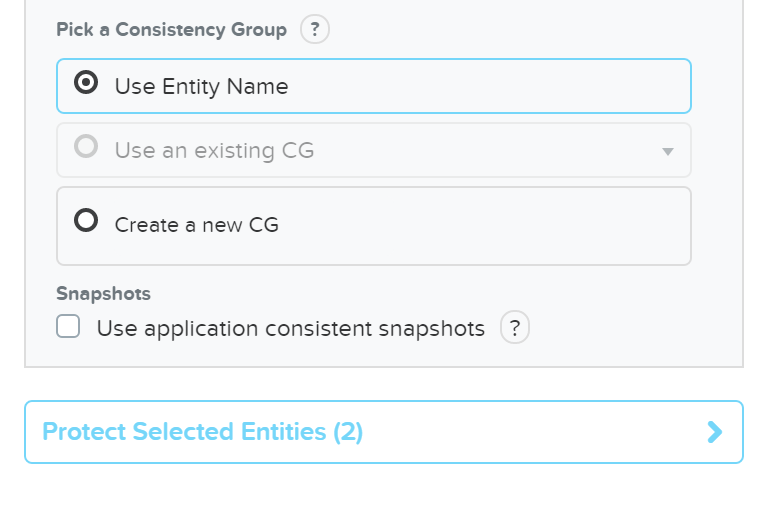

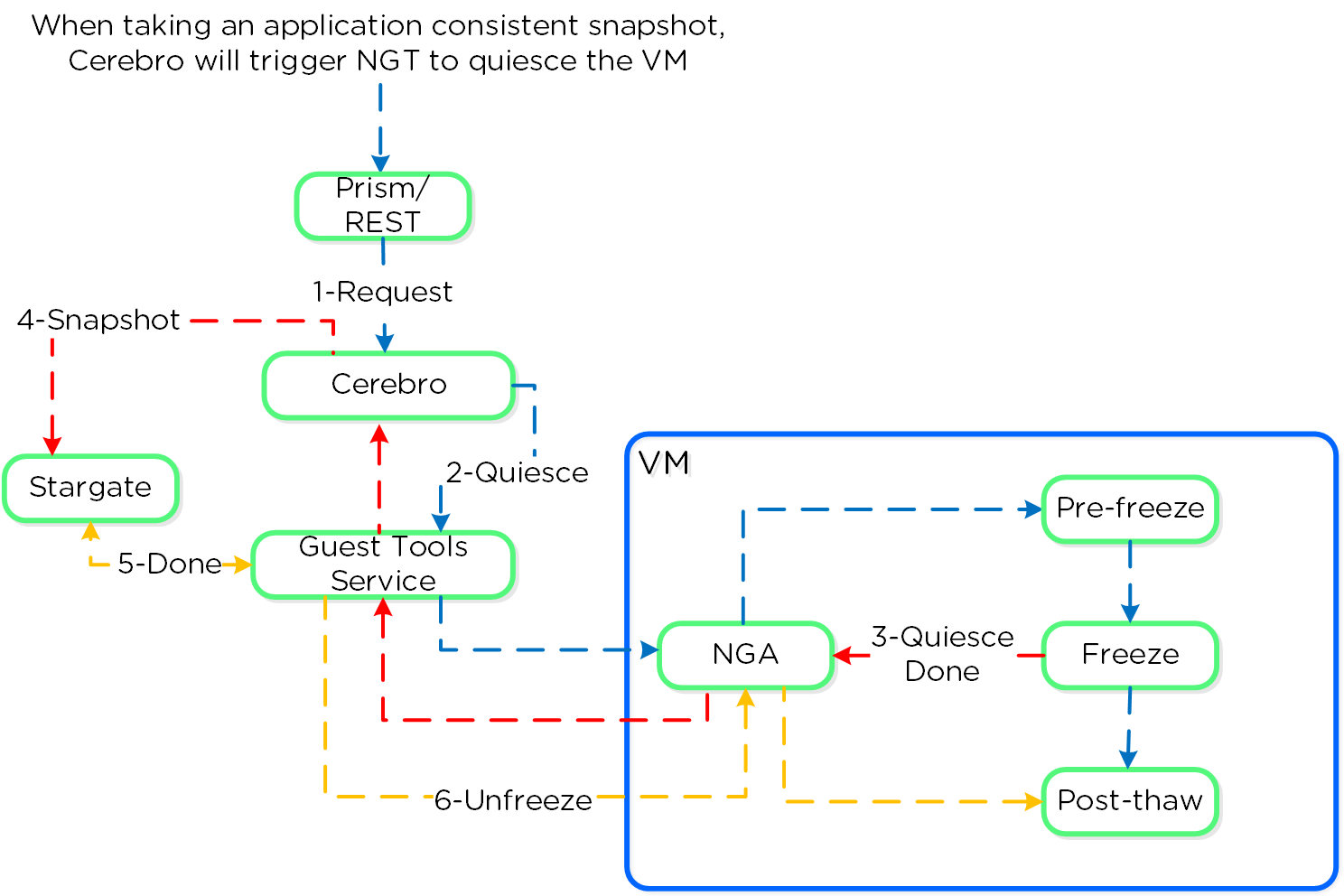

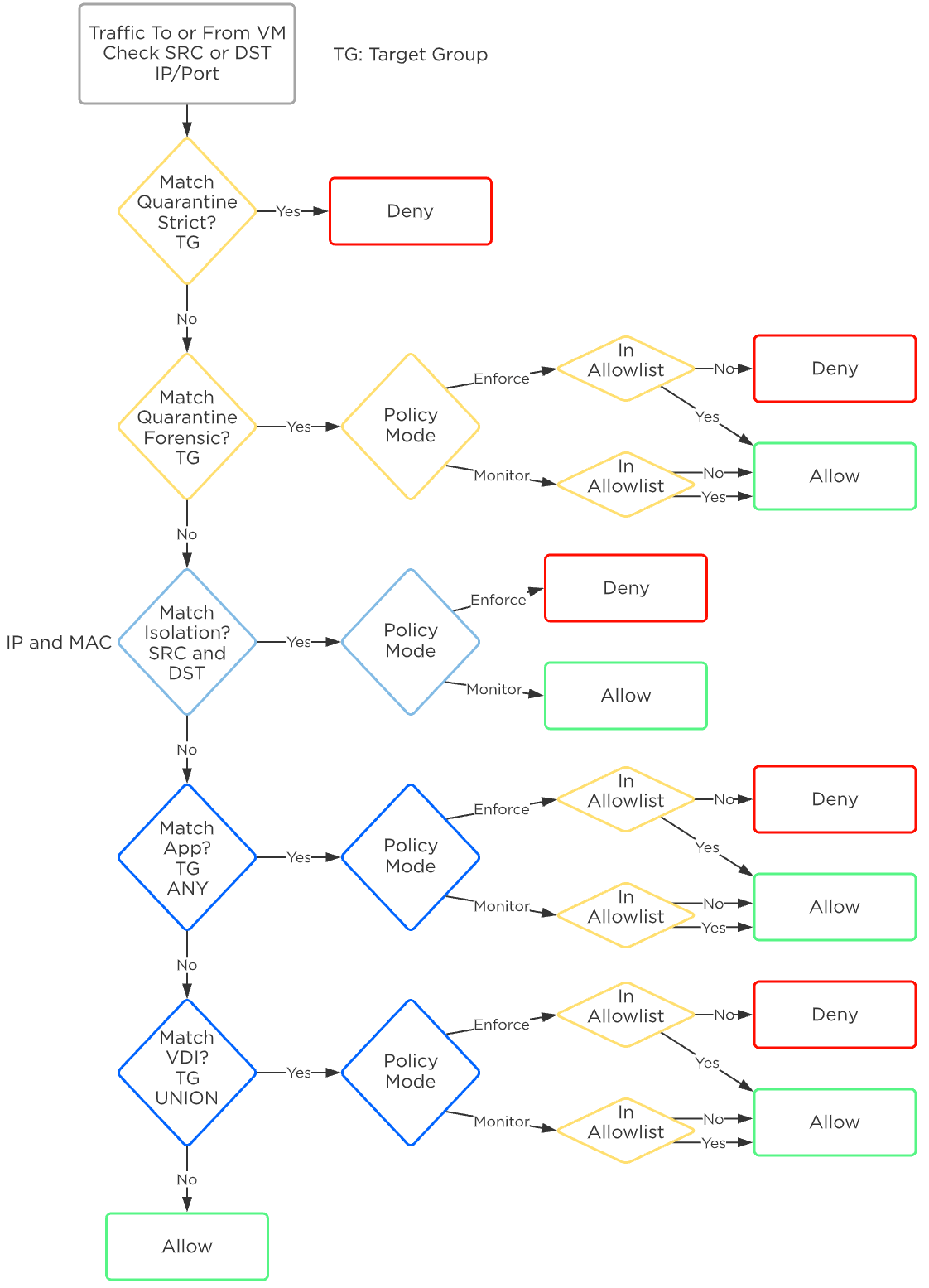

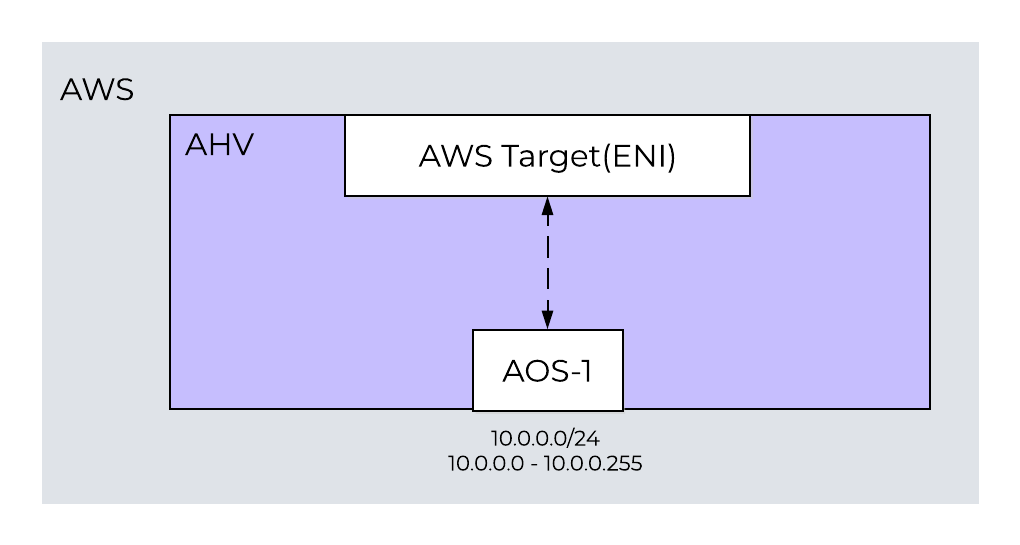

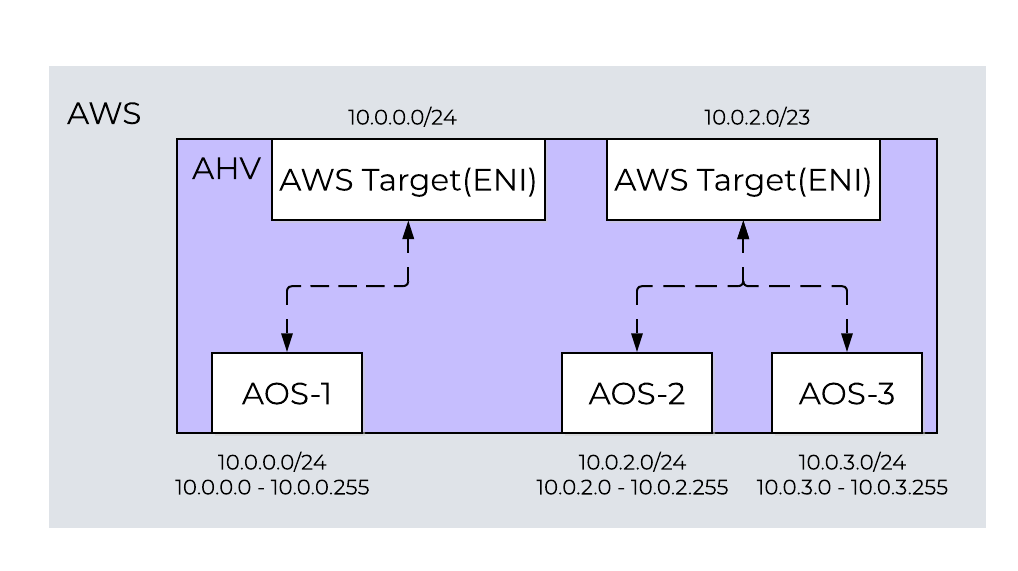

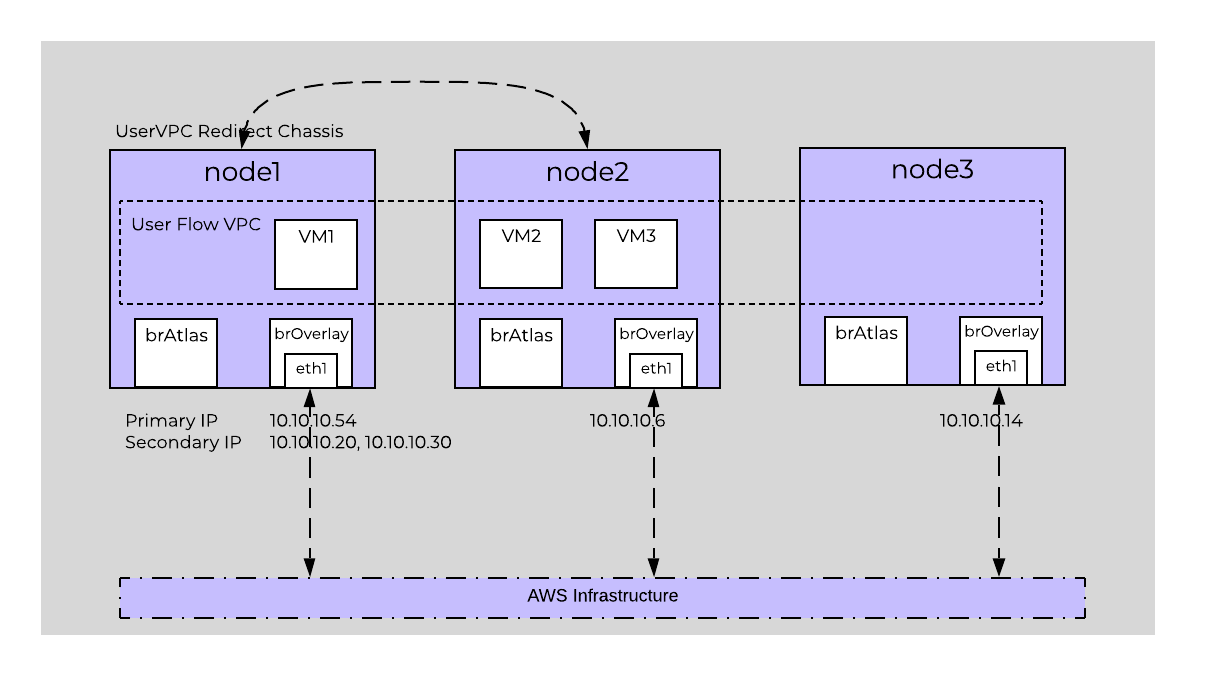

- ネットワーク コントローラー(ハイパーバイザー用)